【CVPR2020-北京大学】自适应间隔损失的提升小样本学习

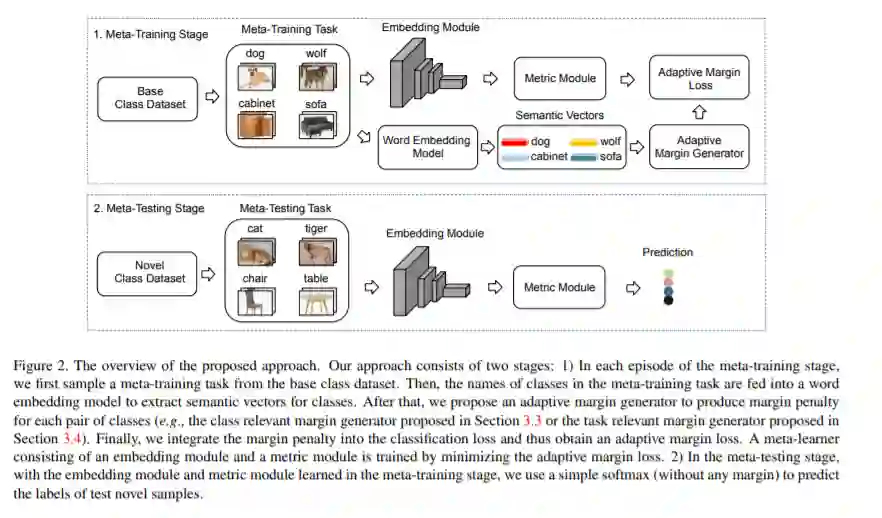

小样本学习(FSL)近年来引起了越来越多的关注,但仍然具有挑战性,因为学习从少数例子中归纳的固有困难。本文提出了一种自适应间隔原则,以提高基于度量的元学习方法在小样本学习问题中的泛化能力。具体地说,我们首先开发了一个与类相关的加性边缘损失算法,该算法考虑了每对类之间的语义相似性,从而将特征嵌入空间中的样本从相似的类中分离出来。此外,我们在抽样训练任务中加入所有类别之间的语义上下文,并开发了与任务相关的附加间隔损失,以更好地区分不同类别的样本。我们的自适应间隔方法可以很容易地推广到更现实的广义FSL设置。大量的实验表明,在标准FSL和通用FSL设置下,所提出的方法可以提高现有基于度量的元学习方法的性能。

https://arxiv.org/abs/2005.13826

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“FSAML” 可以获取《CVPR2020-北京大学-自适应间隔损失的提升小样本学习》专知下载链接索引

登录查看更多

相关内容

专知会员服务

38+阅读 · 2020年3月23日