[每周ArXiv] 最新几篇GNN论文

最近看到的几篇GNN论文,感觉还比较有意思~分享给大家~

On Explainability of Graph Neural Networks via Subgraph Explorations

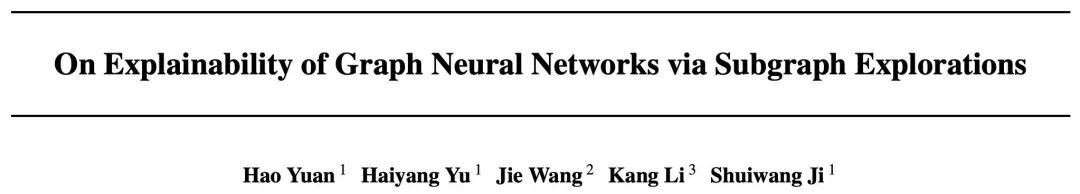

现有的图解释性方法往往只关注于解释图的节点或边的重要性,而忽略了图的子结构。事实上,这些子结构更直观,更易于理解。本文提出了一种新的GNN解释性方法,称为SubgraphX,通过识别重要的子图来解释GNNs。给定一个训练好的GNN模型和一个输入图,SubgraphX通过蒙特卡罗树搜索有效地探索不同的子图来解释它的预测。为了使树搜索更有效,本文提出使用Shapley值作为子图重要度的度量。它还可以捕获不同子图之间的交互作用。为了加快计算速度,本文也提出了一种有效的近似方案来计算图的Shapley值。

We consider the problem of explaining the predictions of graph neural networks (GNNs), which otherwise are considered as black boxes. Existing methods invariably focus on explaining the importance of graph nodes or edges but ignore the substructures of graphs, which are more intuitive and human-intelligible. In this work, we propose a novel method, known as SubgraphX, to explain GNNs by identifying important subgraphs. Given a trained GNN model and an input graph, our SubgraphX explains its predictions by efficiently exploring different subgraphs with Monte Carlo tree search. To make the tree search more effective, we propose to use Shapley values as a measure of subgraph importance, which can also capture the interactions among different subgraphs. To expedite computations, we propose efficient approximation schemes to compute Shapley values for graph data. Our work represents the first attempt to explain GNNs via identifying subgraphs explicitly. Experimental results show that our SubgraphX achieves significantly improved explanations, while keeping computations at a reasonable level.

论文链接:https://arxiv.org/abs/2102.05152

代码链接:https://github.com/divelab/DIG

GraphDF: A Discrete Flow Model for Molecular Graph Generation

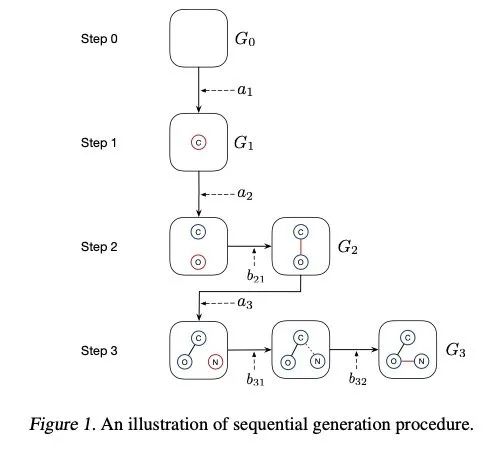

由于图是离散的,现有的方法大多使用连续的潜变量,导致离散图结构的建模不准确。本文提出了GraphDF,一种新的基于归一化流方法的离散潜变量分子图生成模型。GraphDF使用可逆模移位变换将离散的潜在变量映射到图的节点和边。本文也证明了使用离散潜变量可以减少计算量并消除去量化的负面影响。

We consider the problem of molecular graph generation using deep models. While graphs are discrete, most existing methods use continuous latent variables, resulting in inaccurate modeling of discrete graph structures. In this work, we propose GraphDF, a novel discrete latent variable model for molecular graph generation based on normalizing flow methods. GraphDF uses invertible modulo shift transforms to map discrete latent variables to graph nodes and edges. We show that the use of discrete latent variables reduces computational costs and eliminates the negative effect of dequantization. Comprehensive experimental results show that GraphDF outperforms prior methods on random generation, property optimization, and constrained optimization tasks.

论文链接:https://arxiv.org/abs/2102.01189

代码链接:https://github.com/divelab/DIG

Optimization of Graph Neural Networks: Implicit Acceleration by Skip Connections and More Depth

https://arxiv.org/pdf/2105.04550.pdf

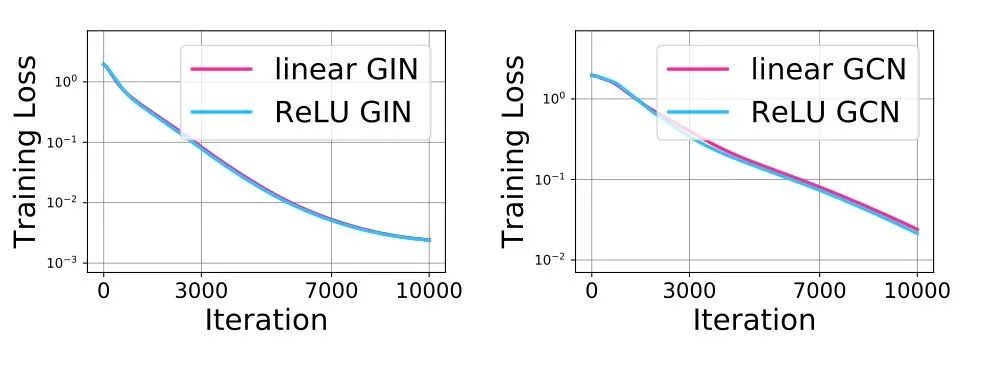

本文从表达能力和泛化的角度研究了图神经网络。目前,GNN的优化特性还不太清楚。通过研究GNNs的梯度动力学,本文迈出了分析GNN训练的第一步。首先,我们分析了线性化GNN,并证明了尽管训练具有非凸性,但在温和的假设下,以线性速率收敛到全局最小值是可以保证的。我们在实际图上验证了这一点。其次,研究了影响GNNs训练速度的因素。我们的结果表明,通过跳转连接、更深入和/或良好的标签分布,GNNs的训练被隐式地加速。实验结果证实了我们的线性化GNNs的理论结果与非线性GNNs的训练行为是一致的。我们的结果为跳转连接的GNNs在优化方面的成功提供了第一个理论支持,同时也表明跳转连接的深层GNNs在实际应用中是很有前景的。

Graph Attention Networks with Positional Embeddings

https://arxiv.org/pdf/2105.04037.pdf

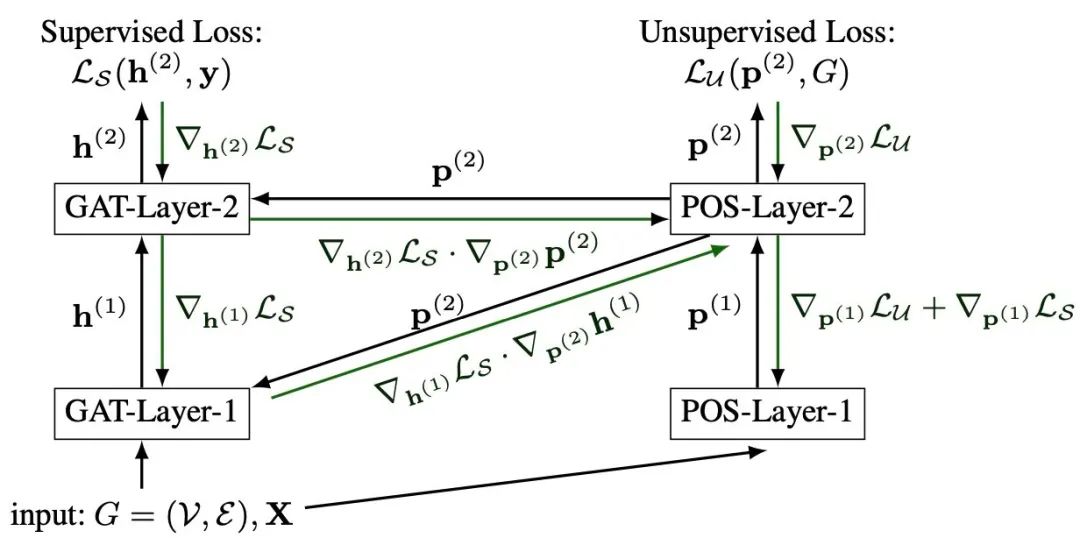

图神经网络(GNNs)是一种深度学习方法,它在节点分类任务中提供了最先进的性能。GNN通常假设同态性(相邻节点具有相似的特征和标签),因此在处理非同态图时可能无法充分发挥其潜力。在这项工作中,我们致力于解决这一局限性,并使图注意力网络(GAT)能够探索每个图形局部中的结构信息。受Transformer中位置编码的启发,我们提出了一个称为**带位置编码的图注意力网络(GAT-POS)**的框架,用位置编码来增强GAT。在这个框架中,位置编码是通过图的上下文的预测模型学习的,再插入到增强的GAT架构中,该架构能够利用每个节点的位置和内容信息。

Robust Graph Learning Under Wasserstein Uncertainty

https://arxiv.org/pdf/2105.04210.pdf

图是揭示信号间内在关系的有力工具,在不同领域发挥着重要作用。在许多情况下,表示信号的精确图形结构根本不可用,这促使人们直接从观察到的信号中学习可靠的图形结构。然而,在现实生活中,由于噪声测量或有限的可观测性,观测信号不可避免地存在不确定性,从而导致学习图的可靠性降低。为此,我们提出了一个基于Wasserstein分布鲁棒优化(WDRO)的图学习框架,该框架通过定义观测数据分布上的不确定性集来处理数据中的不确定性。具体地说,建立了两个模型,一个假设不确定性集中的所有分布都是高斯分布,另一个没有先验分布假设。我们提出了两种算法来求解相应的模型,而不是直接使用内点法,并且证明了我们的算法更节省时间。

Graph Feature Gating Networks

https://arxiv.org/pdf/2105.04493.pdf

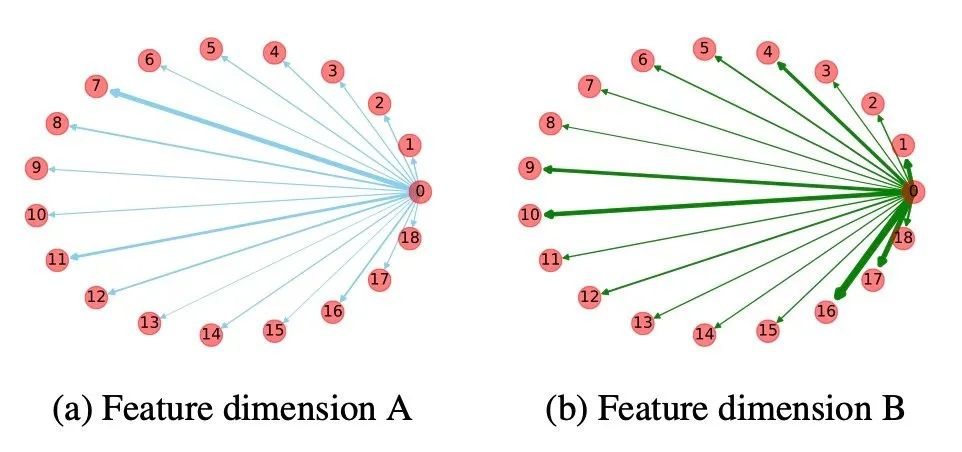

大多数GNN遵循一种消息传递方案,其中通过聚集和转换来自邻域的信息来更新节点表示。同时,它们采用相同的策略对不同特征维度的信息进行聚合。然而,根据社会维度理论和谱嵌入理论,在聚合过程中对维度进行不同的处理有潜在的好处。在这项工作中,我们研究了如何在GNNs中实现特征维度的异构贡献。特别地,我们提出了一种基于图信号去噪问题的通用图特征选通网络(GFGN),并相应地在GFGN下引入了三种图滤波器,以允许特征维数的不同贡献。在各种真实数据集上的大量实验证明了该框架的有效性和鲁棒性。