【导读】ICML(International Conference on Machine Learning),即国际机器学习大会, 是机器学习领域全球最具影响力的学术会议之一,因此在该会议上发表论文的研究者也会备受关注。据官方统计,ICML 2021共有5513篇论文投稿,共有1184篇接受(包括1018篇短论文和166篇长论文),接受率21.48%。

为此,专知小编提前为大家整理了五篇ICML 2021图神经网络(Graph Neural Network)最新进展,这块这几年一直比较受关注,大家先睹为快——图正则化、分子式图神经网络、时间序列预测、有向图网络、GNN泛化

CVPR2021DA、CVPR2021IVC、CVPR2021PID、CVPR2021IC、CVPR2021VU、CVPR2021OD、CVPR2021OT、CVPR2021AR

1. GraphNorm: A Principled Approach to Accelerating Graph Neural Network Training

作者:Tianle Cai, Shengjie Luo, Keyulu Xu, Di He, Tie-Yan Liu, Liwei Wang

摘要:众所周知,Normalization有助于深度神经网络的优化。不同的体系结构需要专门的规范化方法。本文研究哪种归一化对图神经网络(GNN)有效。首先,本文采用其他领域GNN的现有方法并评估。与BatchNorm和LayerNorm相比,InstanceNorm可以实现更快的收敛。我们通过将InstanceNorm作为GNN的前提条件来提供解释,但是由于图数据集中的大量批处理噪声,BatchNorm的这种预处理效果较弱。其次,我们证明InstanceNorm中的移位操作会导致GNN的表达性下降,从而影响高度规则的图。我们提出GraphNorm以可学习的方式解决此问题。根据经验,与使用其他规范化的GNN相比,具有GraphNorm的GNN收敛更快。GraphNorm还改善了GNN的泛化,在图分类基准上实现了更好的性能。

论文: https://arxiv.org/abs/2009.03294

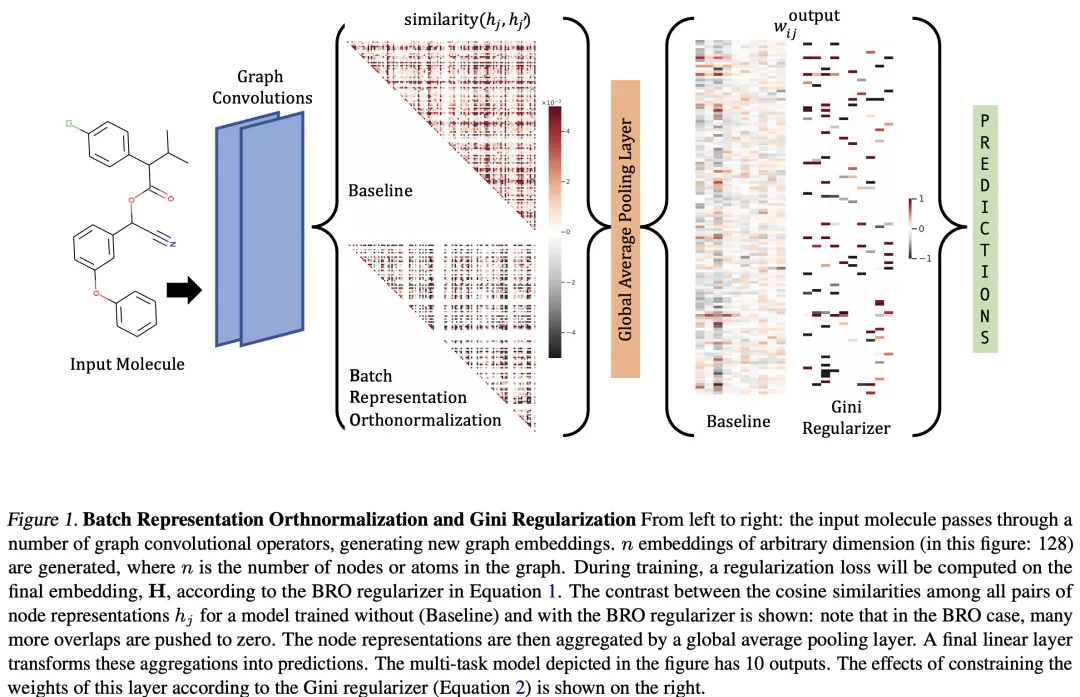

2. Improving Molecular Graph Neural Network Explainability with Orthonormalization and Induced Sparsity

作者:Ryan Henderson, Djork-Arné Clevert, Floriane Montanari

摘要:对于分子的哪些部分可能会影响分子图卷积神经网络(GCNN)的预测,这部分探索相对很困难。为了帮助解决这个问题,本文提出了两种简单的正则化方法,在GCNN的训练过程中应用:批处理表示正态化(Batch Representation Orthonormalization,BRO)和基尼正则化(Gini regularization)。BRO受分子轨道理论的启发,使图卷积运算生成正交节点嵌入表示。Gini正则化应用于输出层的权重,限制模型可用于进行预测的维数。本文表明,Gini和BRO正则化可以提高人工基准数据集上最新的GCNN方法的准确性。在现实世界中,本文证明了药物化学家非常喜欢从正规化模型中提取解释。虽然我们仅在GCNN的背景下研究这些正则化,但两者都可以应用于其他类型的神经网络。

论文: https://arxiv.org/abs/2105.04854

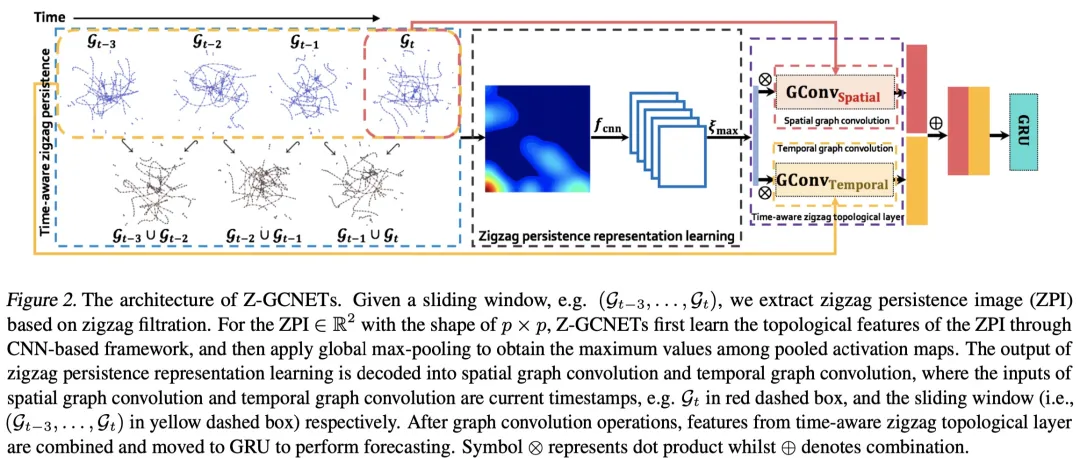

3. Z-GCNETs: Time Zigzags at Graph Convolutional Networks for Time Series Forecasting

作者:Yuzhou Chen, Ignacio Segovia-Dominguez, Yulia R. Gel

摘要:最近,一种新的深度学习(DL)架构的变得很火,该架构将明确的时间维度集成为学习和表示机制的基本构建块。与之相反,许多最新结果表明,观测数据的拓扑描述符(即数据的持久同源性)可能包含重要的补充信息从而改善DL的性能和鲁棒性,这种拓扑描述符以不同比例对拓扑空间中数据集形状信息进行编码。随着这两个新思想的融合,我们提出使用数据的最显着的时间条件拓扑信息来增强DL体系结构,并将zigzag持久性的概念引入时间感知图卷积网络(GCN)中。zigzag持续性提供了一个系统的、数学上严格的框架来跟踪观察数据的最重要的拓扑特征,这些特征随着时间的推移会逐渐显现。为了将提取的时间条件拓扑描述符集成到DL中,本文开发了一个新的拓扑方法,zigzag持久性图像,并得出其理论上的稳定性保证。我们使用时间感知zigzag拓扑层(Z-GCNET)验证了新的GCN,并将其应用于流量预测和以太坊区块链价格预测。结果表明,Z-GCNET在4个时间序列数据集上的表现优于13种最新方法。

论文: https://arxiv.org/abs/2105.04100

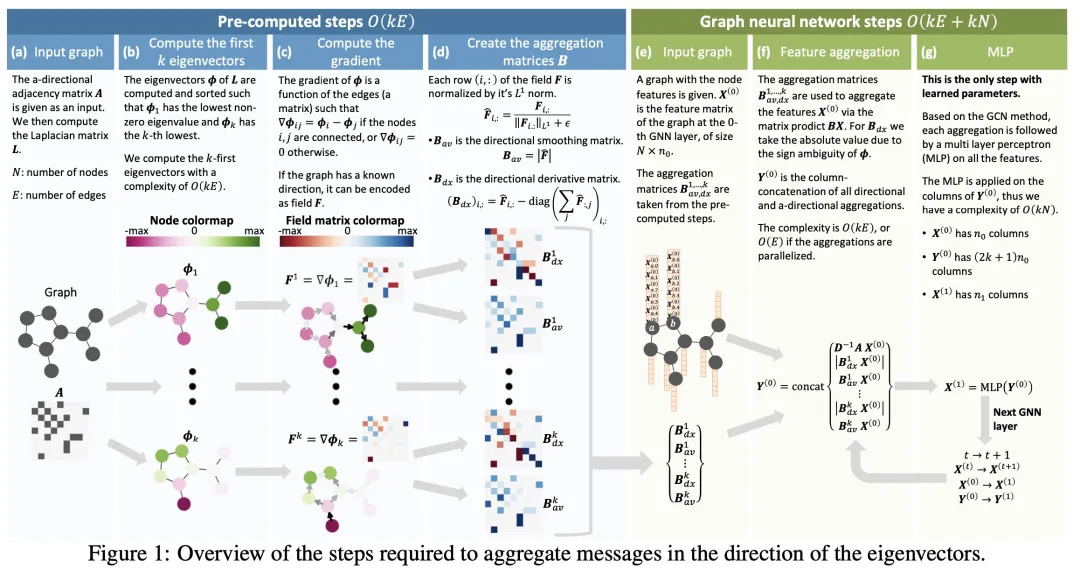

4. Directional Graph Networks

作者:Dominique Beaini, Saro Passaro, Vincent Létourneau, William L. Hamilton, Gabriele Corso, Pietro Liò

摘要:图神经网络(GNN)中缺乏各向异性核极大地限制了其表达能力,导致了一些众所周知的问题,如过度平滑。为了克服这个限制,作者提出了第一个全局一致的各向异性核,允许根据拓扑导出的方向流定义图卷积。首先,通过在图中定义矢量场,将具体节点信息投影到场,提出了一种方向导数和平滑的方法。然后,用拉普拉斯特征向量作为这种向量场。在Weisfeiler-Lehman 1-WL检验方面,证明了该方法可以在n维网格上泛化CNN,并证明比标准的GNN更有分辨力。在不同的标准基准上评估了本文方法,发现在CIFAR10图数据集上相对误差减少了8%,在分子锌数据集上相对误差减少了11%到32%,在MolPCBA数据集上相对精度提高了1.6%。这项工作的重要成果是,它使图网络能够以一种无监督的方式嵌入方向,从而能够更好地表示不同物理或生物问题中的各向异性特征。

论文: https://arxiv.org/abs/2010.02863

5. Optimization of Graph Neural Networks: Implicit Acceleration by Skip Connections and More Depth

作者:Keyulu Xu, Mozhi Zhang, Stefanie Jegelka, Kenji Kawaguchi

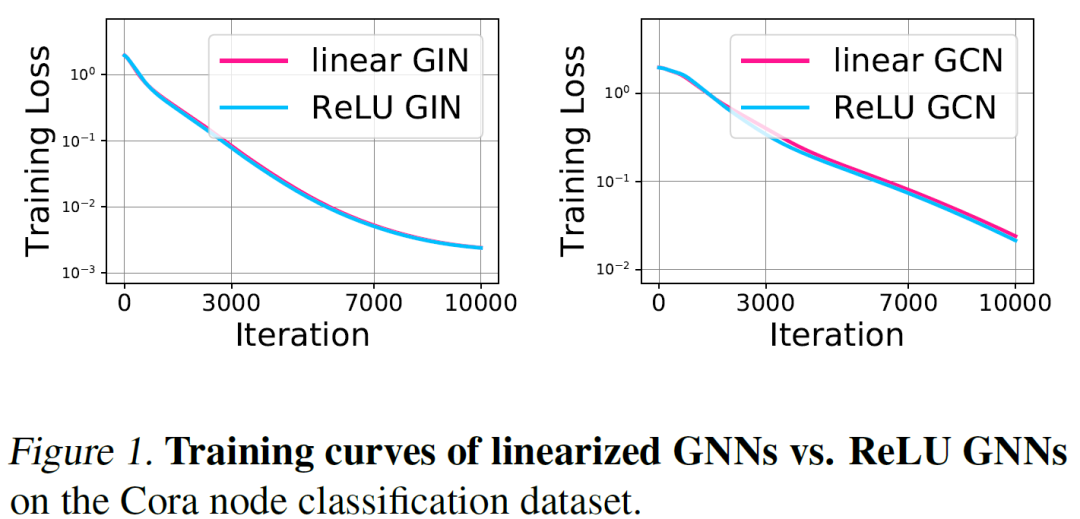

摘要:GNN的表示能力和泛化能力得到了广泛的研究。但是,它们的优化其实研究的很少。通过研究GNN的梯度动力学,本文迈出分析GNN训练的第一步。具体来说,首先,本文分析线性化(linearized)的GNN,并证明了:尽管它的训练不具有凸性,但在我们通过真实图验证的温和假设下,可以保证以线性速率收敛到全局最小值。其次,我们研究什么会影响GNN的训练速度。结果表明,通过跳过(skip)连接,可以的到更深的深度、良好的标签分布,可以隐式地加速GNN的训练。实验结果证实,我们针对线性GNN的理论结果与非线性GNN的训练行为一致。我们的结果在优化方面为具有跳过连接的GNN的成功提供了第一个理论支持,并表明具有跳过连接的深层GNN在实践中将很有希望对。