【导读】IJCAI(国际人工智能联合会议,International Joint Conferences on Artificial Intelligence)作为人工智能领域最顶级的国际学术会议之一,IJCAI 的举办自然备受瞩目。第29届国际人工智能联合会议和第17届环太平洋国际人工智能会议原定于2020年7月11日在日本横滨召开,但由于疫情影响,将延期半年,至 2021年1月召开。近期,IJCAI 2020 论文集已经放出来。在 4717 份有效投稿中,最终仅有 592 篇被接收,接收率为 12.6%,这也是 IJCAI 史上最低的接收率。我们发现在今年的IJCAI 2020会议上图神经网络相关的论文非常多,所以今天小编专门整理最新6篇图神经网络(GNN)应用在计算机视觉上的相关论文——直推式关系传播网络、3D姿态估计、跨模态Hash、时空图序列学习、关系推理网络、图交互推理

IJCAI 2020 Accepted Paper: https://www.ijcai.org/Proceedings/2020/

ICML2020GNN_Part1、KDD2020GNN_Part1、CVPR2020SGNN、CVPR2020GNN_Part2、CVPR2020GNN_Part1、WWW2020GNN_Part1、AAAI2020GNN、ACMMM2019GNN、CIKM2019GNN、ICLR2020GNN、

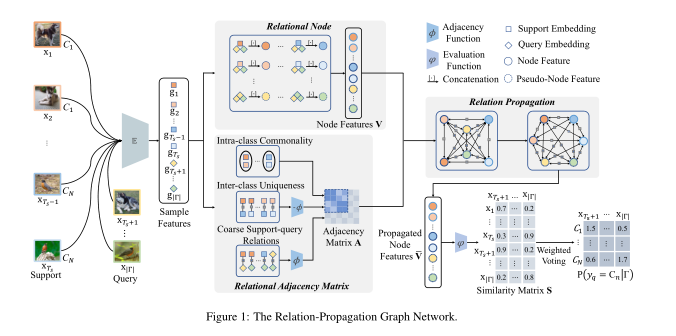

1、Transductive Relation-Propagation Network for Few-shot Learning

作者:Yuqing Ma, Shihao Bai, Shan An, Wei Liu, Aishan Liu, Xiantong Zhen, Xianglong Liu

摘要:少样本学习(Few-shot learning)是一个有趣且极具挑战性的问题,其目的是从较少的标注样本中学习新的概念,具有许多实用的优点。要完成这一任务,应该集中精力揭示支撑-查询(support-query)对之间的准确关系。我们提出了一个直推式关系(transductive relation)-传播图神经网络(TRPN),以在支撑-查询对之间显式建模和传播这种关系。我们的TRPN将每个支撑-查询对之间的关系视为一个图节点,称为关系节点,并利用支撑样本之间的已知关系(包括类内共性和类间唯一性)来指导关系在图中的传播,生成支撑-查询对的判别关系嵌入。在此基础上引入伪关系节点来传播查询特征,并设计了一种快速有效的传导学习策略来充分利用不同查询之间的关系信息。据我们所知,这是首次在少样本学习中明确考虑支撑-查询对之间的关系,为解决少样本学习问题提供了一条新的途径。在几个基准数据集上进行的广泛实验表明,我们的方法可以明显优于各种最先进的小样本学习方法。

网址:

https://www.ijcai.org/Proceedings/2020/0112.pdf

2、Semi-Dynamic Hypergraph Neural Network for 3D Pose Estimation

作者:Shengyuan Liu, Pei Lv, Yuzhen Zhang, Jie Fu, Junjin Cheng, Wanqing Li, Bing Zhou, Mingliang Xu

摘要:本文提出了一种新颖的半动态超图神经网络(SD-HNN),可以从单个图像估计3D人体姿态。SD-HNN采用超图来表示人体,以有效利用相邻关节和非相邻关节之间的运动学约束。具体而言,SD-HNN中的姿态超图具有两个组成部分。一种是根据常规树体结构构造的静态超图。另一个是半动态超图,表示不同关节之间的动态运动约束。将这两个超图组合在一起,以端到端的方式进行训练。与基于固定树结构的传统图卷积网络(GCN)不同,SD-HNN可以处理人体姿态估计中的歧义。实验结果表明,所提方法在Human3.6M和MPI-INF-3DHP数据集上均达到了最先进的性能。

网址:

https://www.ijcai.org/Proceedings/2020/0109.pdf

3、Set and Rebase: Determining the Semantic Graph Connectivity for Unsupervised Cross-Modal Hashing

作者:Weiwei Wang, Yuming Shen, Haofeng Zhang, Yazhou Yao, Li Liu

摘要:无监督的跨模态哈希的无标签性质阻碍了模型利用精确的语义数据相似性。现有研究通常在原始特征空间中通过启发式几何先验来模拟语义。但是,由于原始特征不能完全代表基础的多视图数据关系,因此这会给模型带来严重偏差。为了解决上述问题,在本文中,我们提出了一种新的无监督哈希方法,称为基于语义的跨模态哈希(SRCH)。我们定义了一种新颖的“Set-and Rebase”过程来初始化和更新训练数据的跨模态相似度图。特别是,我们根据模态内特征的几何基础设置图形,然后根据哈希结果交替对其rebase以更新其中的边。我们开发了一种交替优化,以对图进行基础化,并使用封闭形式(closed-form )解决方案训练哈希自动编码器从而有效地训练了整个框架。我们在基准数据集上的实验结果证明了我们的模型相对于最新算法的优越性。

网址:

https://www.ijcai.org/Proceedings/2020/0119.pdf

4、Hierarchical Attention Based Spatial-Temporal Graph-to-Sequence Learning for Grounded Video Description

作者:Kai Shen, Lingfei Wu, Fangli Xu, Siliang Tang, Jun Xiao, Yueting Zhuang

摘要:Grounded Video Description(GVD)的任务是生成句子,这些对象可以通过视频帧中的边界框进行grounded。现有的工作在建模候选区域之间的关系以及参与文本生成时常常无法利用结构信息。为了解决这些问题,我们将GVD任务转换为时空图到序列学习问题,其中将视频帧建模为时空序列图,以便更好地捕获隐式结构关系。特别是,我们采用两种方式来构建一个序列图,该序列图捕获每个帧中不同对象之间的空间时间相关性,并进一步提出一种新颖的图拓扑细化技术以发现最佳的基础图结构。此外,我们还提出了分层注意力机制,以不同分辨率级别(resolution levels)参与序列图,以更好地生成句子。与最先进的方法相比,我们广泛的实验证明了我们提出的方法的有效性。

网址:

https://www.ijcai.org/Proceedings/2020/0131.pdf

5、Action-Guided Attention Mining and Relation Reasoning Network for Human-Object Interaction Detection

作者:Xue Lin, Qi Zou, Xixia Xu

摘要:人与物体之间的交互(HOI)检测对于理解以人为中心的场景非常重要,并且由于细粒度动作与多个同时发生的交互之间的细微差异,因此具有挑战性。大多数方法通过考虑多流信息甚至引入额外的知识来解决这些问题,这些问题遭受着巨大的组合空间和非交互式对控制问题。在本文中,我们提出了一种行动导向的注意力挖掘和关系推理(Action-Guided attention mining and Relation Reasoning ,AGRR)网络来解决该问题。对人-对象对的关系推理是通过利用对之间的上下文兼容一致性来过滤掉非交互式组合而进行的。为了更好地区分细粒度动作之间的细微差别,我们提出了一种基于类激活图(class activation map )的动作感知注意力,以挖掘最相关的特征来识别HOI。在V-COCO和HICO-DET数据集上进行的大量实验表明,与最新方法相比该模型十分有效。

网址:

https://www.ijcai.org/Proceedings/2020/0154.pdf

6、A Graph-based Interactive Reasoning for Human-Object Interaction Detection

作者:Dongming Yang, Yuexian Zou

摘要:人与物体交互(HOI)检测致力于通过推断三元组(人类,动词,物体)来学习人类与周围物体的交互方式。然而,最近的HOI检测方法主要依赖于附加注释(例如,人的姿势),并且忽略了卷积之外的强大的交互推理。在本文中,我们提出了一种新颖的基于图的交互式推理模型,称为交互式图(in-Graph)来推断HOI,其有效地利用了视觉目标之间的交互语义。所提出的模型包括如下三方面:1)将相关目标从卷积空间映射到基于图的语义空间的项目函数(project function); 2)在所有节点之间传播语义的消息传递过程; 3)将推理节点转换回卷积空间的更新函数。此外,我们构建了一个新的框架来组装用于检测HOI的In-Graph模型,即In-GraphNet。除了分别使用实例特征来推断HOI之外,该框架还通过集成两级in-Graphs(即场景范围和实例范围in-Graphs)来动态解析视觉目标之间的成对交互语义。我们的框架是端到端可训练的,并且没有像人体姿态这样的昂贵注释。大量实验表明,我们提出的框架在V-COCO和HICO-DET基准上均优于现有的HOI检测方法,并且相对提高了基准线约9.4%和15%,从而验证了其检测HOI的有效性。

网址: