解决自然语言歧义问题,斯坦福教授、IJCAI 卓越研究奖得主提出 SenseBERT 模型

机器之心原创

作者:Tony Peng

参与:魔王

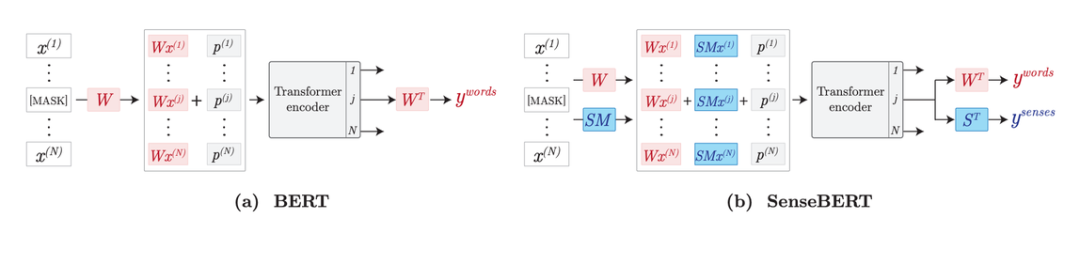

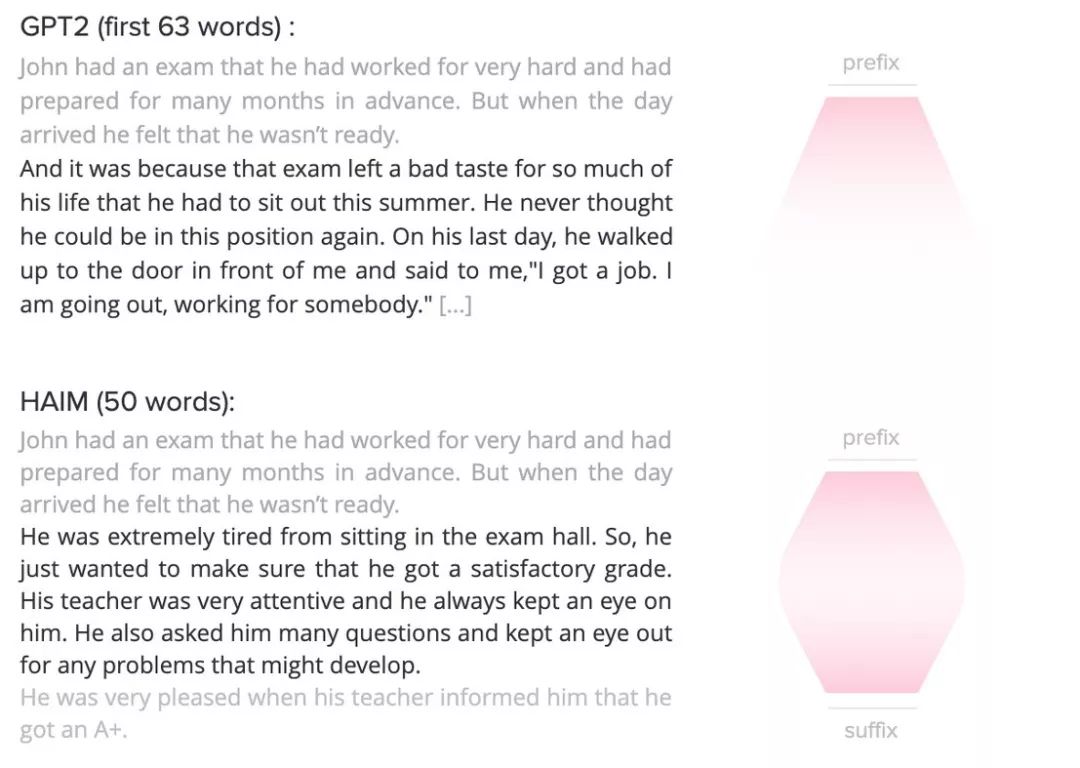

自然语言理解和生成对于 AI 系统来说是一大难题,语言的复杂性和模糊性对 AI 系统提出了很大挑战。今天,斯坦福教授、IJCAI 卓越研究奖得主 Yoav Shoham 创办的公司 AI21 Labs 提出一种能够显著提升词汇消歧能力的新模型,并发布了可控性优于其他前沿文本生成系统的「HAIM」。AI21 Labs 的愿景是构建「具备前所未有的优秀自然语言理解和生成能力」的 AI 系统。

GPT-2 和 HAIM 的可控性对比。

登录查看更多