ACL20 如何使用选择机制提升自注意力网路能力?

论文名称:How Does Selective Mechanism Improve Self-Attention Networks?

论文作者:耿昕伟,王龙跃,王星,秦兵,刘挺,涂兆鹏

原创作者:耿昕伟

论文链接:https://www.aclweb.org/anthology/2020.acl-main.269.pdf

1. 简介

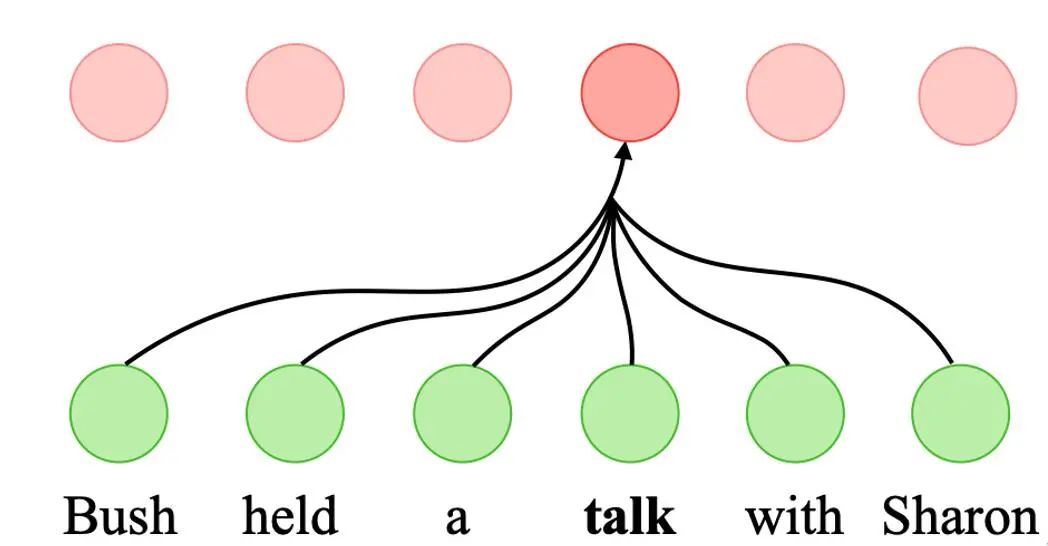

自注意力网络(SANs)在许多自然语言处理任务中取得显著的成功,其中包括机器翻译、自然语言推理以及语义角色标注任务。相比传统的循环神经网络以及卷积神经网络,自注意力网络优势在于其高度的运算并行性以及更加灵活的建模输入元素的依存关系能力。传统的自注意力网络模型在计算每个元素的表示的时候,将所有的输入的元素考虑在内,而不管其对于当前元素的相关性。本问题提出通用的基于选择机制的自注意力网络模型(SSANs),其可以针对每个计算表示的元素,动态地选择其相关性的子集,以此作为输入进行后续的自注意力网络的计算。实验结果显示,SSANs模型在多个典型的自然语言处理任务上相比传统的自注意力网络模型获得提升。通过多个探测任务进行分析,SSANs相比传统的SANs模型有更强的词序信息编码能力以及结构信息建模能力。

2. 模型结构

2.1 传统的自注意力网络

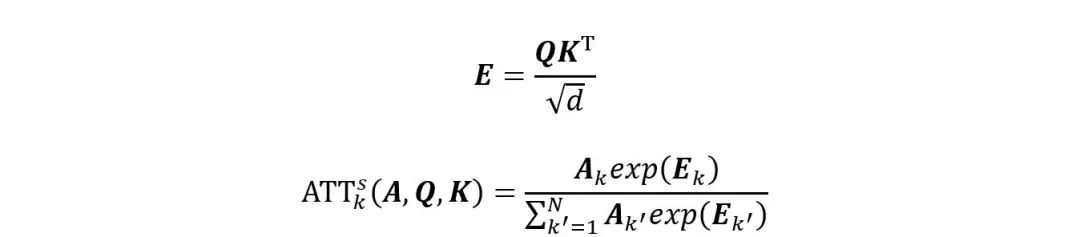

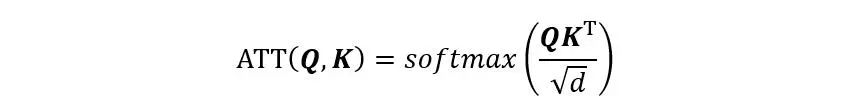

现在的自注意力网络是传统的注意力网路的特例,其计算注意力权重的两个元素来源同样的输入序列。给定输入隐层表示

,自注意力网络SANs首先将H分别线性变换成

、

以及

。自注意力网络的输出O计算过程如下:

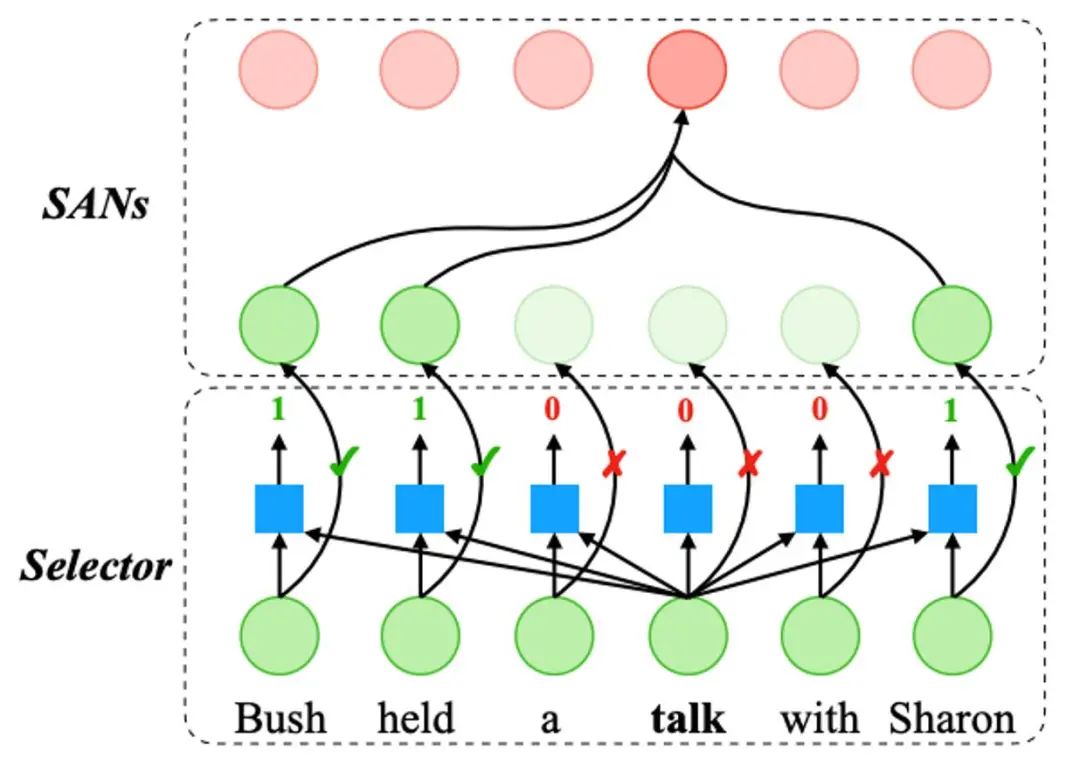

2.2 基于选择机制的自注意力网络

相比传统的自注意力网络,本文引入一个选择器模块(Selector),其主要针对每个待计算表示的元素,动态地选择输入元素的集合中的一个子集作为其相关元素集合,基于此集合进行后续的常规的自注意力网络的计算,其整体的框架如图 2所示。

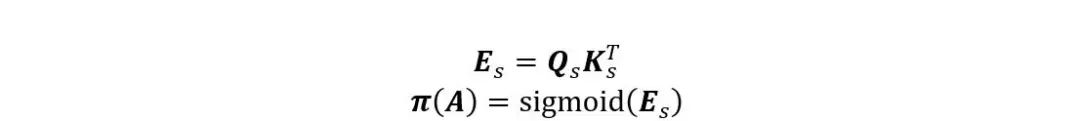

选择器模块 本文使用额外的策略网络参数化选择动作 ,其中

表示其对应的元素被选择进行后续的常规的自注意力网路的计算,而

则代表相应的元素未被选中。其输出动作序列计算过程如下:

其中

以及

是

线性变换的结果。本文使用sigmoid作为激活函数计算策略分布。通过使用额外的选择器模块,SSANs的注意力权重

计算过程如下:

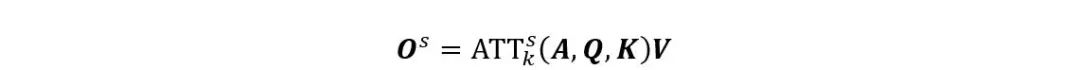

最终基于选择机制的自注意力网络的输出

计算过程如下:

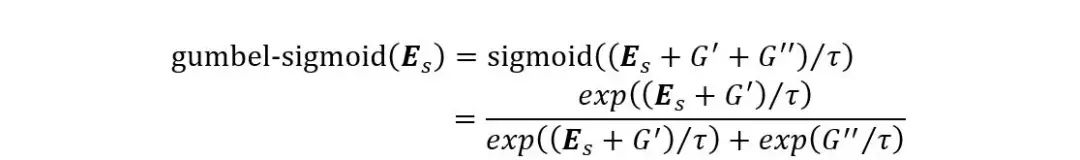

Gumbel-Sigmoid 本文使用gumbel-softmax对隐含变量A的梯度进行评估,其主要将离散的采样过程连续化,这样使用正常的BP算法就可以实现对其梯度评估。相比REINFORCE算法,其稳定性更高。本文策略网络使用sigmoid作为激活函数,其可以看作是softmax的特例,从而依据gumbel-softmax函数计算方法,可以推导出gumbel-sigmoid形式如下:

3 实验结果

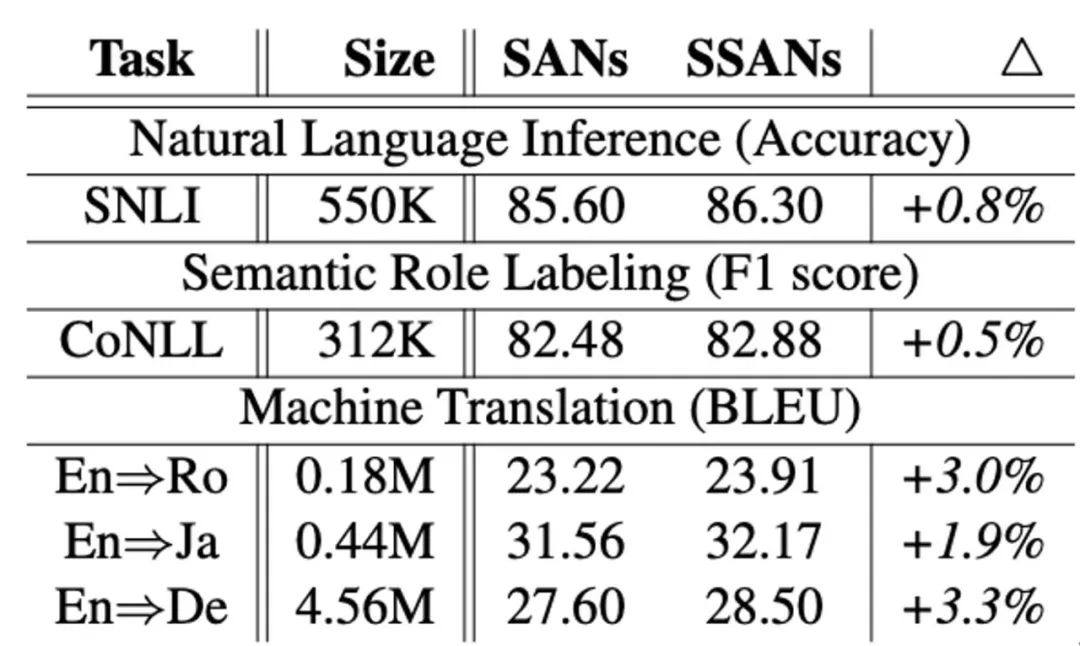

基于选择机制的自注意力网络模型在三个典型的NLP任务上取得一致的提升。特别的,在机器翻译任务上,SSANs在三个英语到其他语言的翻译上超过传统的SANs模型。在英语=>罗马尼亚以及英语=>日语的翻译任务上,SSANs分别获得+0.69和+0.61 BLEU提升。此外,在相对规模比较大的英=>德翻译任务上,SSANs也获得一致的提升(+0.90 BLEU)。

4 实验分析

4.1 词序信息编码能力评价

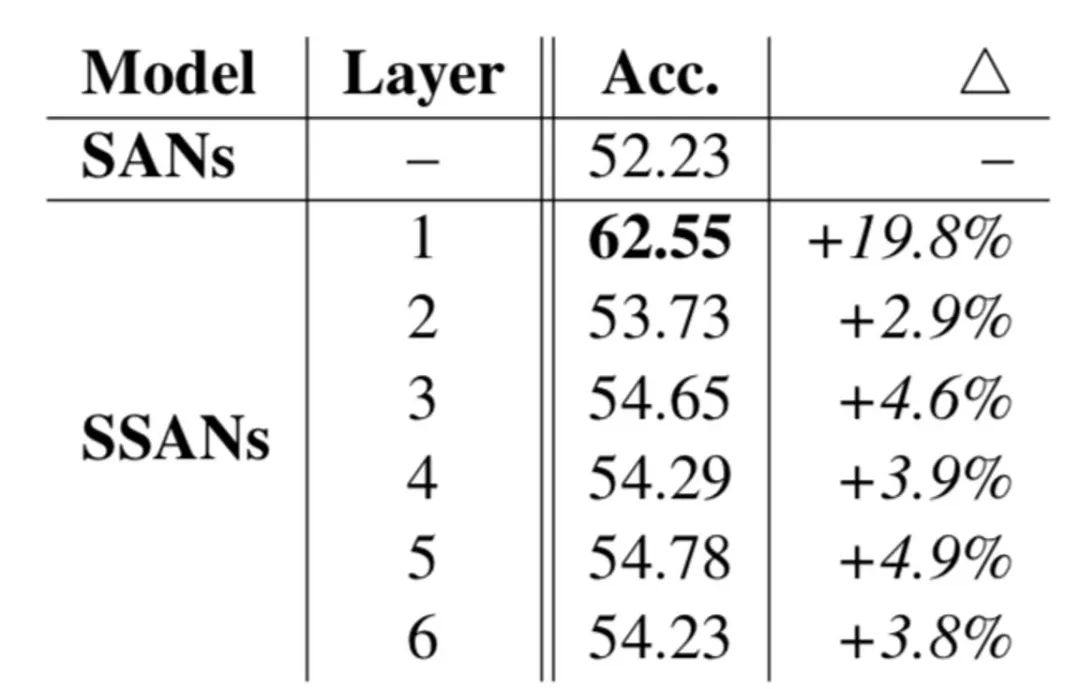

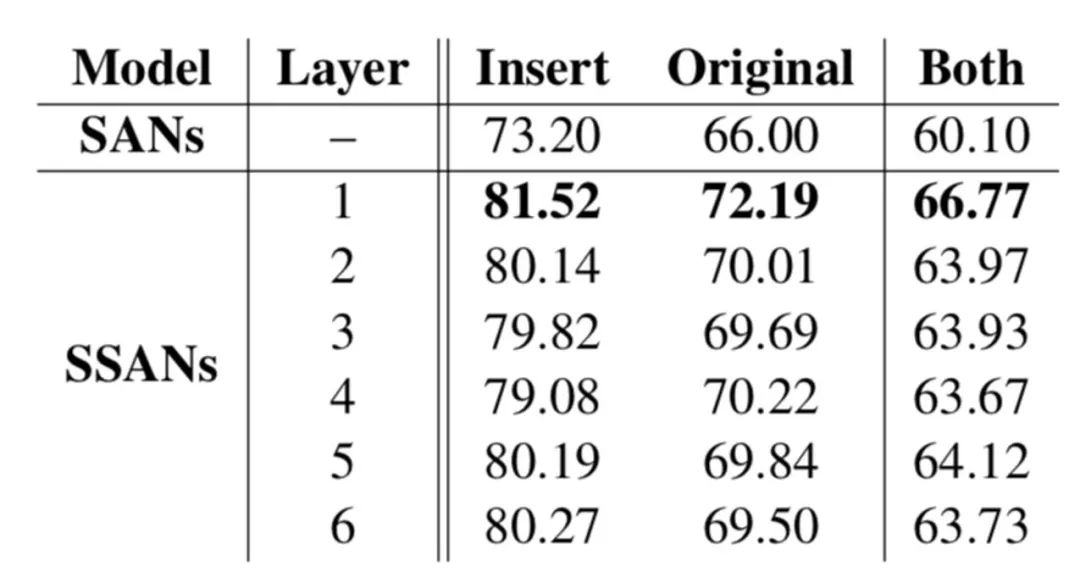

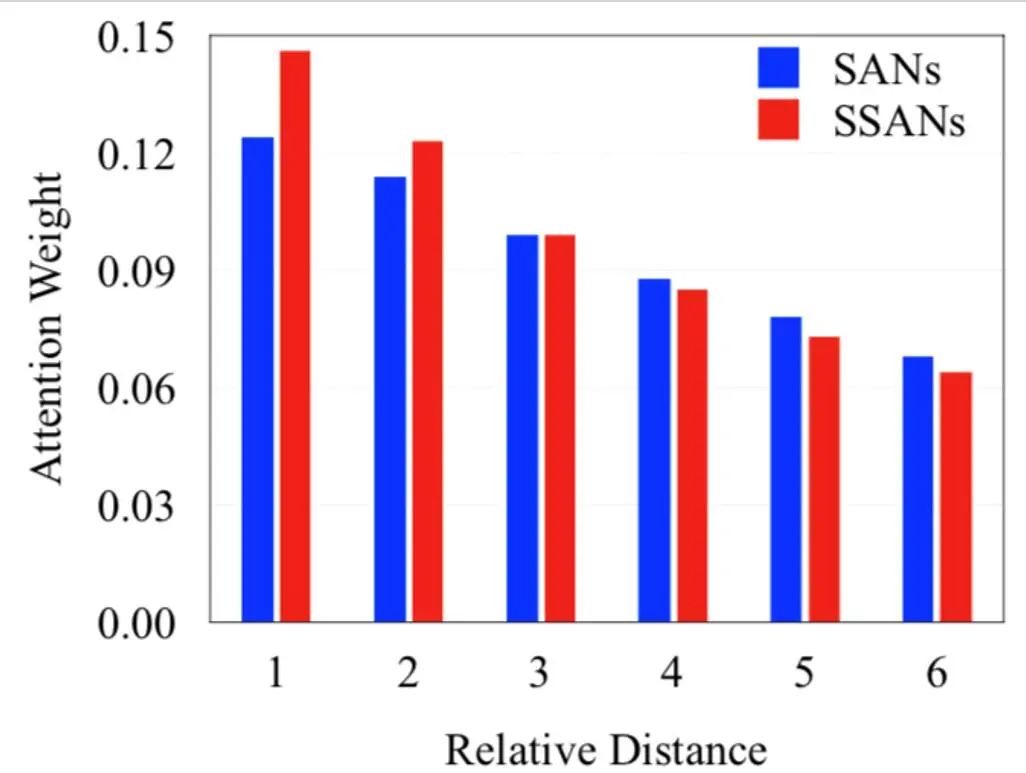

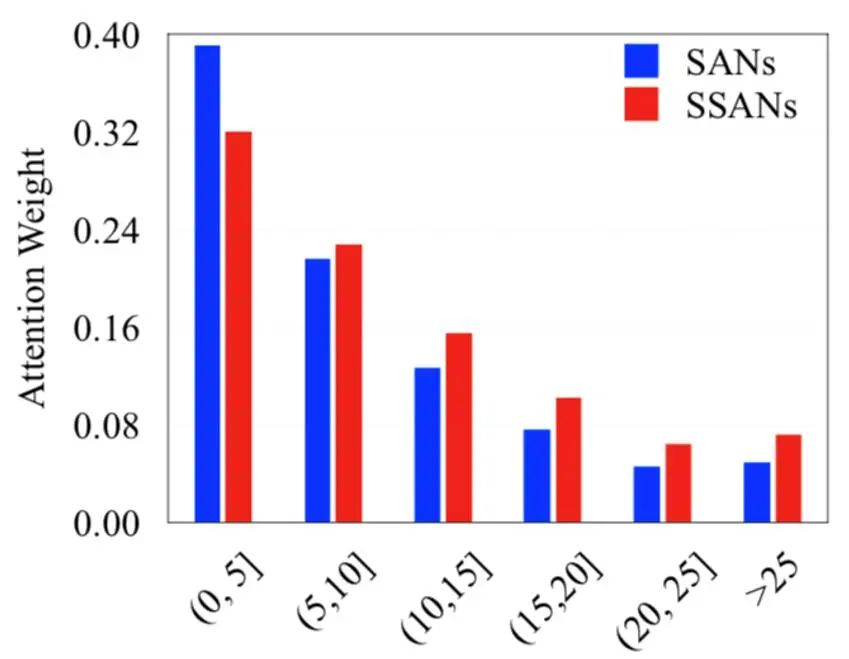

为了评价SSANs的对于局部词序信息以及全局词序信息编码的能力,本文引入两个特定的检测任务分别评价模型对于两种类型信息编码的能力。其中,局部词序信息检测任务目标是分类是否句子中存在两个相邻词的进行交换,而全局词序信息检测任务随机选择句子中的某个词语,并将其插入到另一个位置,而任务的目标就是通过分类找到被插入的词汇以及其原来所在的位置。实验结果显示,SSANs在两个任务上,相比传统的SANs,均取得较大的提升。通过分析其相应的自注意力网络权重发现,SSANs能够根据任务将更多的注意力权重分配到重要的信息建模上。

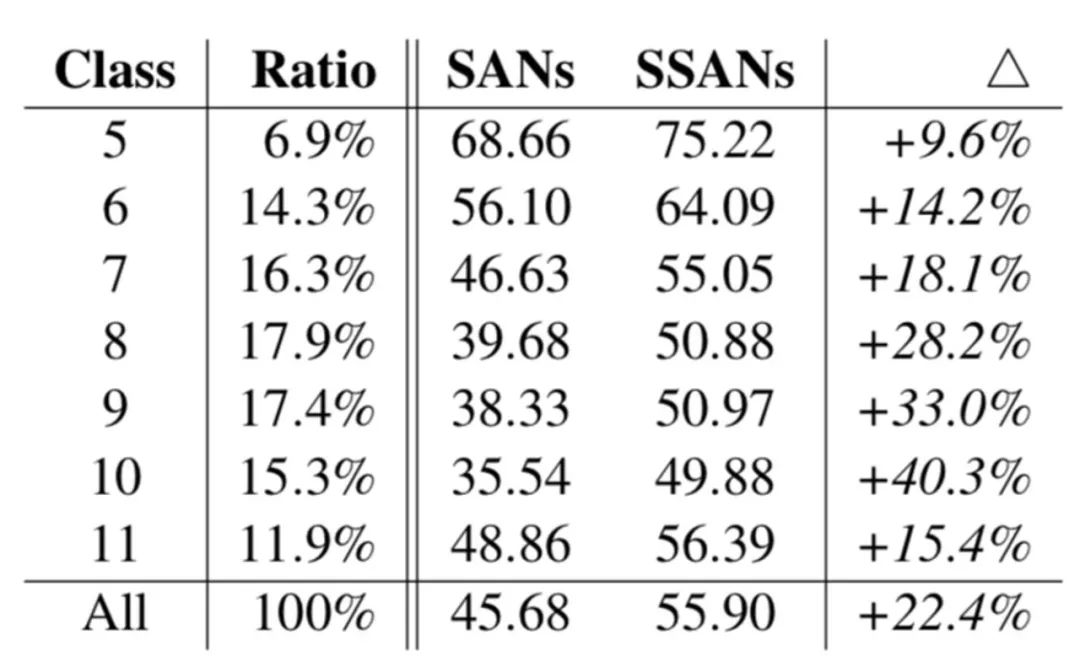

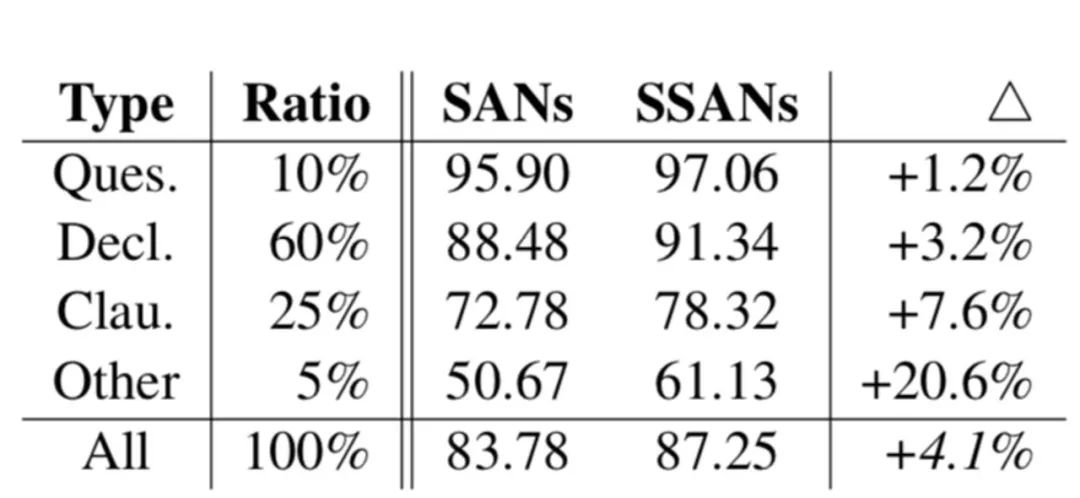

4.2 结构信息建模能力评价

为了评价SSANs对于结构信息的建模能力,本文首先引入两个检测任务评价模型对于结构信息的捕捉能力。其中一个任务目标是测试模型是否可以根据组合语法树的深度对于输入的句子进行分类,而另一个任务的目标是对输入句子按照其组合语法树根节点之下的成分类型进行分类。实验结果发现,SSANs在两种类型的任务上均取得提升,并且对于复杂的问题有更好处理能力。此外,模型根据注意力网络的权重构建组合语法树,SSANs构建的语法树质量好于SANs模型的结果。

5 结论

本文提出一种通用的基于选择机制的自注意力网络模型,其可以针对每个计算表示的元素,动态地选择其相关性的子集,以此作为输入进行后续的自注意力网络的计算。其在多个自然语言任务上,与传统的自注意力网络相比,取得一致提升。通过实验分析发现,基于选择机制的自注意力网络可以在一定程度上缓解注意力网络存在的词序信息编码和结构信息建模能力不足的问题。

赛尔原创 | ACL20 基于对话图谱的开放域多轮对话策略学习

赛尔原创 | ACL20 基于图注意力网络的多粒度机器阅读理解文档建模

赛尔原创 | ACL20 用于多领域端到端任务型对话系统的动态融合网络

赛尔原创 | ACL20 让模型“事半功倍”,探究少样本序列标注方法

本期编辑:王若珂

『哈工大SCIR』公众号