文章名

Machine Learning Interviews - Machine Learning Systems Design

文章简介

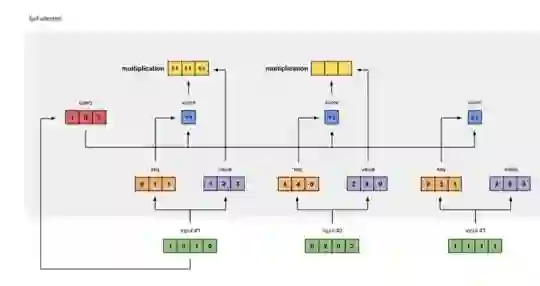

作者长期从事人工智能领域中的自然语言处理工作,最近google人工智能团队结合自然语言预处理,创造了许多自然语言模型,如最近火热的BERT模型。这该文章中作者不仅仅介绍了BERT模型,而且还介绍其最近比较火热的变种,如 RoBERTa, ALBERT, SpanBERT, DistilBERT, SesameBERT, SemBERT, MobileBERT, TinyBERT and CamemBERT。 注意力机制引入深度学习模型。作者讨论的不仅是名为“BERT”的体系结构,而是更正确的基于变压器的体系结构。基于Transformer的架构主要用于语言理解任务的建模,它避免了神经网络中递归的使用,而是完全依赖于自我注意机制来绘制输入和输出之间的全局依赖关系。但背后的数学原理是什么?这就是今天要讨论的。这篇文章的主要内容是让你了解自我关注模块中涉及的数学运算。在本文结束时,您应该能够从头开始编写或编写自我关注模块。本文的目的并不是在自我注意模块中提供不同数值表示和数学运算背后的直观和解释。它也不旨在证明为什么和如何在变形金刚的自我关注(我相信已经有很多)。注意,注意和自我注意之间的区别在本文中也没有详细说明。

文章作者

Raimi Karim,长期从事人工智能研究,是机器学习领域专家级人物,擅长自然语言处理,在研究过程中,主张机器学习要面向实践,面向实际,立志解决当前问题,AI必须要有商业驱动,方能足够长远的发展。

成为VIP会员查看完整内容

相关内容

专知会员服务

152+阅读 · 2019年1月1日