【Google】监督对比学习,Supervised Contrastive Learning

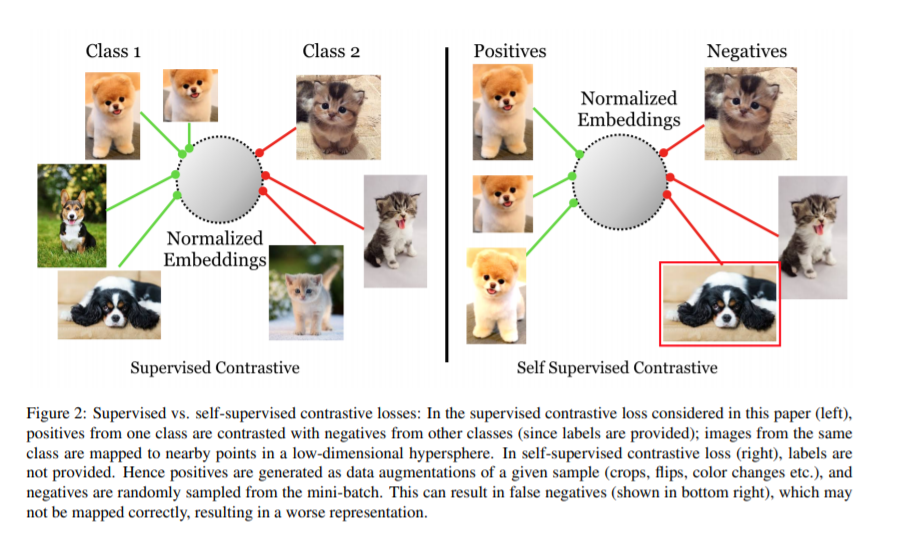

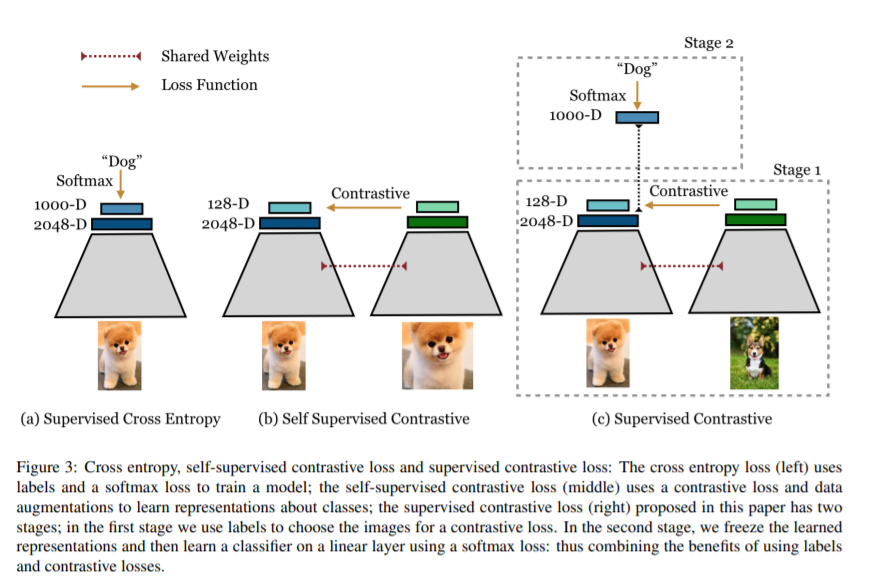

交叉熵是图像分类模型监督训练中应用最广泛的损失函数。在这篇论文中,我们提出了一种新的训练方法,在不同架构和数据扩充的监督学习任务中,它的表现始终优于交叉熵。我们修改了批量对比损失,这是最近被证明在自监督学习强大表示是非常有效的。我们能够比交叉熵更有效地利用标签信息。在嵌入空间中,将同一类的点聚在一起,同时将不同类的样本聚在一起。除此之外,我们还利用了关键的成分,如大批量和标准化嵌入,这些已经被证明有利于自监督学习。在ResNet-50和ResNet-200上,我们的交叉熵性能都超过了1%,在使用自动增广数据增强的方法中,我们设置了78.8%的最新水平。这一损失也清楚地表明,在校准和准确性方面,对标准基准的自然损坏具有鲁棒性。与交叉熵相比,我们的监督对比损失更稳定的超参数设置,如优化或数据扩充。

https://arxiv.org/abs/2004.11362

https://arxiv.org/pdf/2004.11362.pdf

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SCL” 就可以获取《监督对比学习,Supervised Contrastive Learning》专知下载链接

登录查看更多

相关内容

专知会员服务

41+阅读 · 2020年4月11日

专知会员服务

27+阅读 · 2020年4月5日

Arxiv

5+阅读 · 2018年4月5日