【CVPR2020-亚马逊】后向兼容表示学习,BackwardCompatible RepresentationLearning

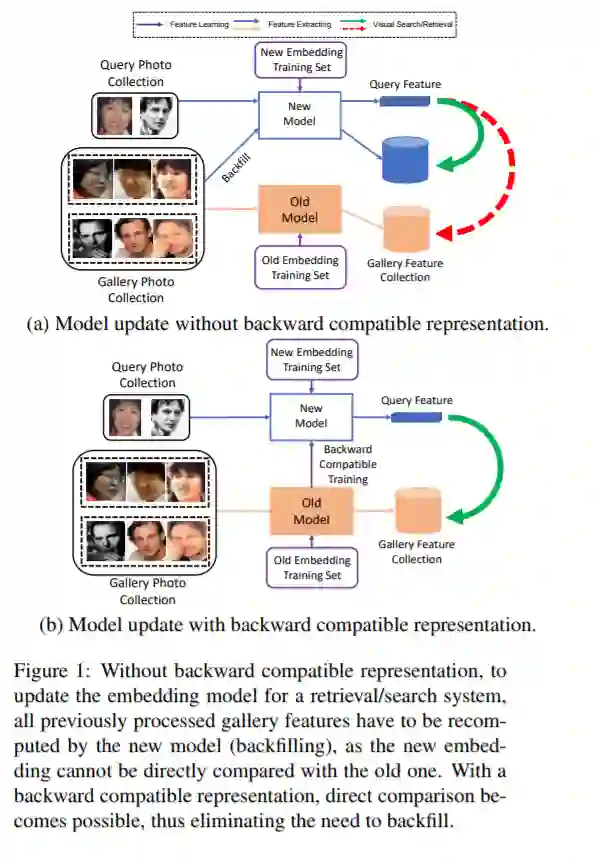

我们提出了一种学习视觉特征的方法,即使这些特征具有不同的维数,并且是通过不同的神经网络结构和损失函数来学习的,也能与之前的计算结果相兼容。兼容意味着,如果这些特性用于比较图像,那么“新”特性可以直接与“旧”特性进行比较,因此它们可以互换使用。这使得视觉搜索系统在更新嵌入模型时,可以绕过计算所有以前看到的图像的新特性,这个过程称为回填。向后兼容性对于快速部署新的嵌入模型至关重要,这些模型利用了不断增长的大规模训练数据集和深度学习体系结构和训练方法的改进。我们提出一个框架来训练嵌入模型,称为向后兼容训练(BCT),作为向后兼容表示学习的第一步。在人脸识别的嵌入学习实验中,使用BCT训练的模型在不牺牲精度的前提下,成功实现了向后兼容,实现了可视化嵌入的无填充模型更新。

https://www.zhuanzhi.ai/paper/66fa3dfd933112fcba51e122668028a3

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“BCRL” 就可以获取《【CVPR2020-亚马逊】后向兼容表示学习,BackwardCompatible RepresentationLearning》专知下载链接

登录查看更多