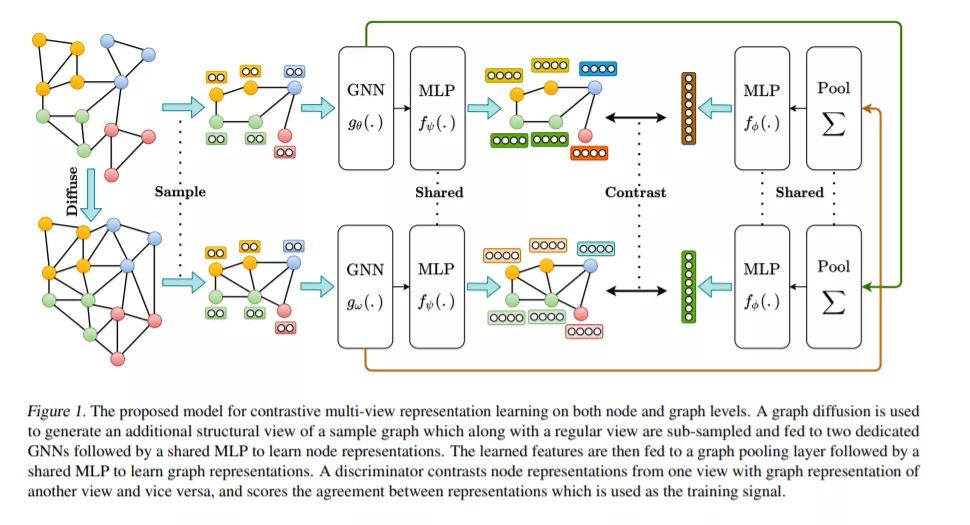

我们介绍了一种通过对比图的结构视图来学习节点和图级表示的自监督方法。我们表明,与视觉表示学习不同,增加视图数量到两个以上或对比多尺度编码不会提高性能,而最佳性能是通过对比一阶邻居编码和图扩散来实现的。在线性评估协议下,我们在8个节点中的8个和图分类基准上实现了新的最先进的自监督学习结果。例如,在Cora(节点)和reddy - binary(图形)分类基准上,我们实现了86.8%和84.5%的准确率,相对于之前的最先进水平分别提高了5.5%和2.4%。与监督基准相比,我们的方法在8个基准中有4个优于监督基准。

成为VIP会员查看完整内容

相关内容

专知会员服务

59+阅读 · 2020年6月30日

专知会员服务

69+阅读 · 2020年6月19日