7 Papers | 清华黄民烈、朱小燕等新论文;Quoc Le等提出新型硬注意力图像分类算法

机器之心整理

参与:一鸣

本周有针对文本生成任务 GAN 的神经架构搜索方法,作者包括清华大学黄民烈、朱小燕等,Quoc V. Le 则提出了一种基于硬注意力机制的图像分类方法。 此外还有梯度提升机、强化学习应用等方面的论文综述,以及基于神经架构搜索的图神经网络等。

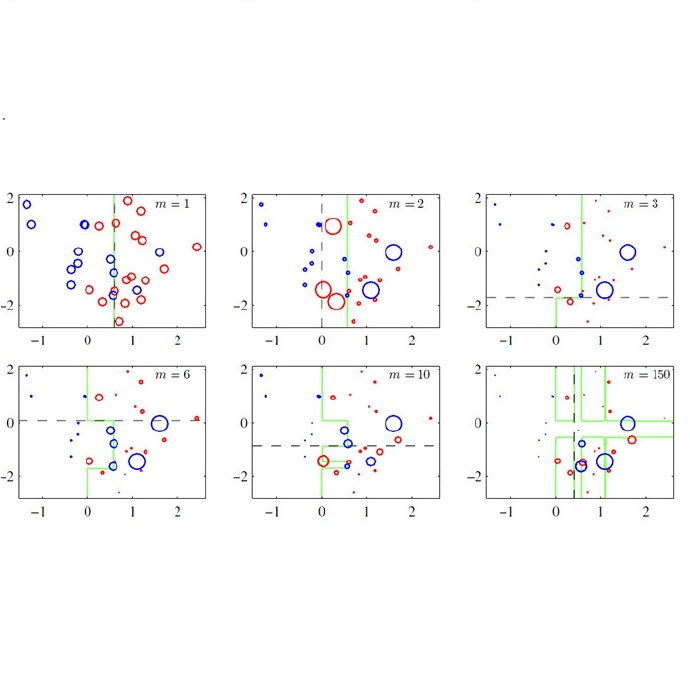

Gradient Boosting Machine: A Survey

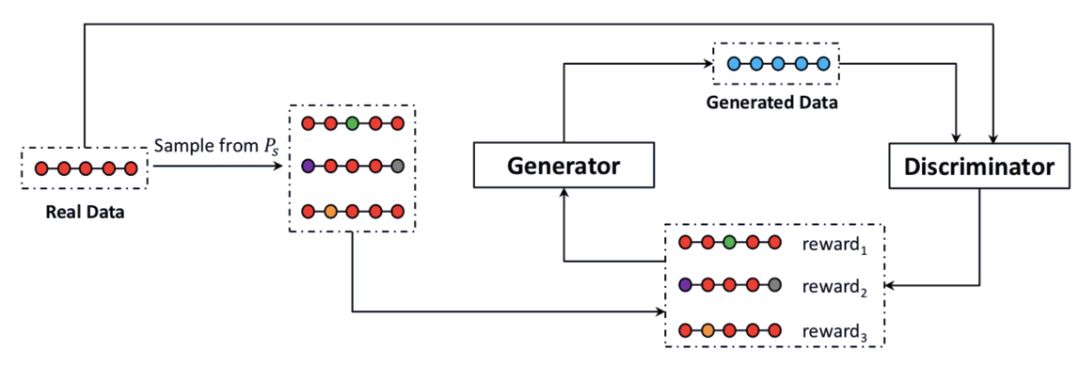

ARAML: A Stable Adversarial Training Framework for Text Generation

Implicit Deep Learning

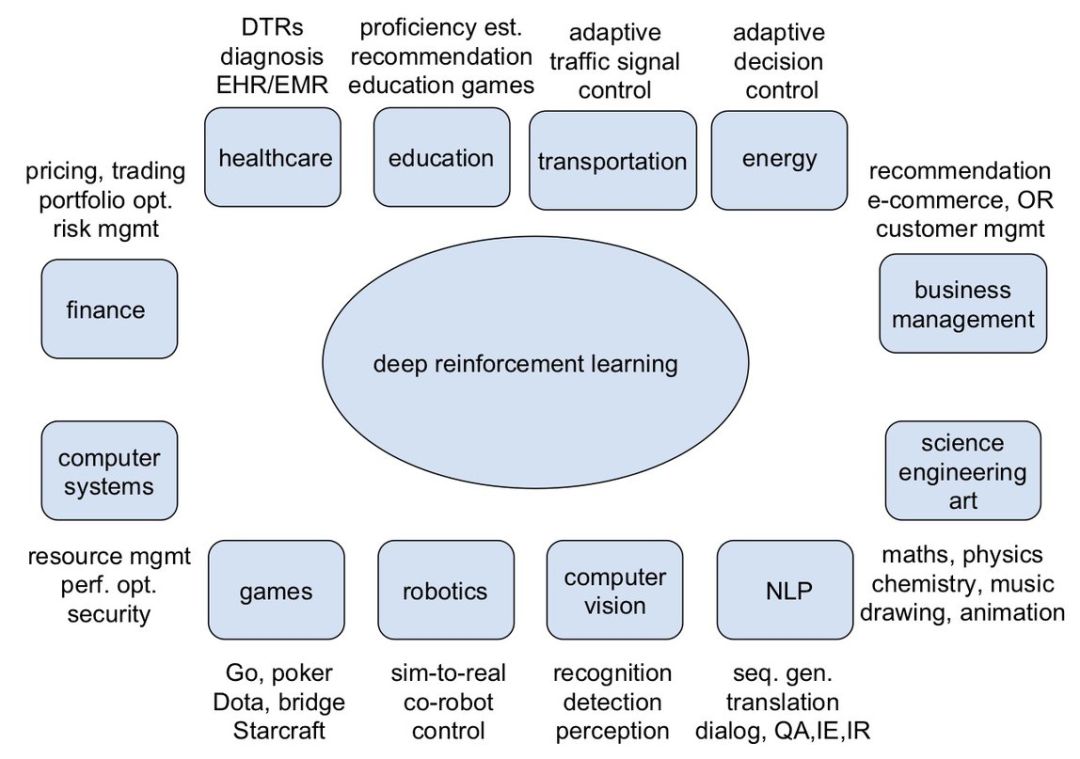

Reinforcement Learning Applications

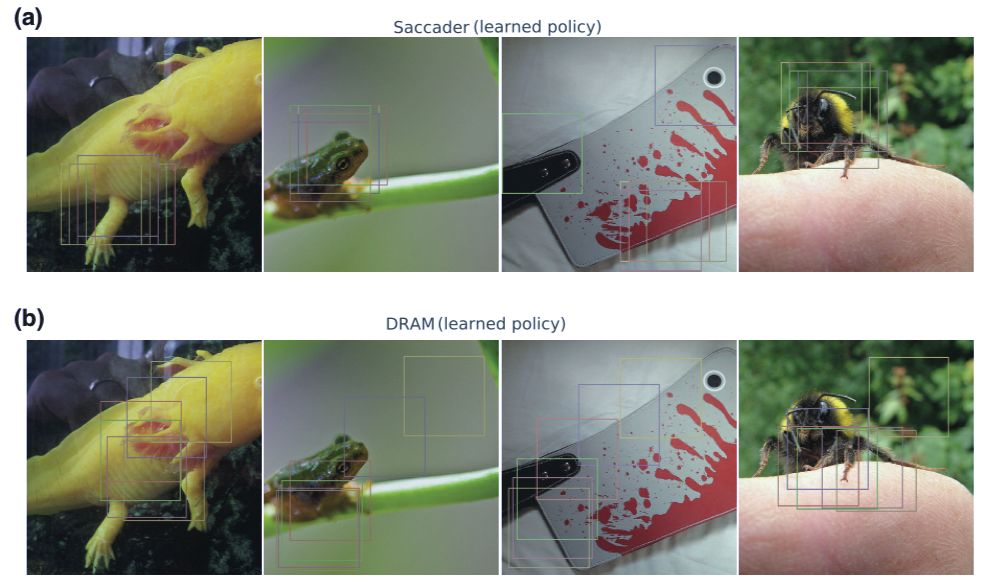

Saccader: Improving Accuracy of Hard Attention Models for Vision

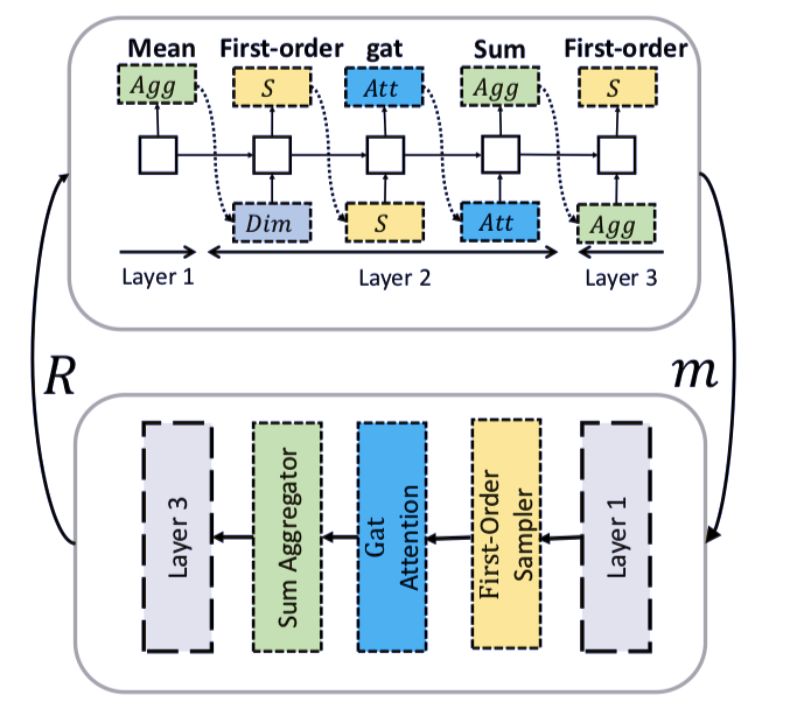

GraphNAS: Graph Neural Architecture Search with Reinforcement Learning

More unlabelled data or label more data? A study on semi-supervised laparoscopic image segmentation

作者:Zhiyuan He、Danchen Lin、Thomas Lau、Mike Wu

论文链接:https://arxiv.org/pdf/1908.06951v1.pdf

作者:Pei Ke、Fei Huang、黄民烈、朱小燕

论文链接:https://arxiv.org/pdf/1908.07195v1.pdf

作者:Laurent El Ghaoui、Fangda Gu、Bertrand Travacca、Armin Askari

论文链接:https://arxiv.org/pdf/1908.06315.pdf

作者:Yuxi Li

论文链接:https://arxiv.org/pdf/1908.06973v1.pdf

作者:Gamaleldin F. Elsayed、Simon Kornblith、Quoc V. Le

论文链接:https://arxiv.org/pdf/1908.07644.pdf

作者:Yang Gao、 Hong Yang、 Peng Zhang、 Chuan Zhou、Yue Hu

论文链接:https://arxiv.org/pdf/1904.09981v2.pdf

作者:Yunguan Fu、Maria R. Robu、Bongjin Koo、Crispin Schneider、Stijn van Laarhoven、Danail Stoyanov、Brian Davidson、Matthew J. Clarkson、Yipeng Hu

论文链接:https://arxiv.org/pdf/1908.08035