ACL 2019论文分享:ARNOR增强模型注意力,降低远监督学习中的噪声

ACL 2019 收录论文分享:《ARNOR:Attention Regularization based Noise Reduction for Distant Supervision Relation Classification》。

简介:基于知识库的远监督学习,通常会面临大量噪声数据的挑战。这篇论文提出的方法通过对模型注意力的控制,显著降低远监督学习中的噪声,进而在NYT关系分类任务上实现当前最好(SOTA)的效果。

本文分为4个部分:

· 背景介绍:信息抽取及关系分类

· 研究动机:远监督方法及其挑战

· ARNOR:基于注意力正则化的降噪

· 实验及分析

一、背景介绍:信息抽取及关系分类

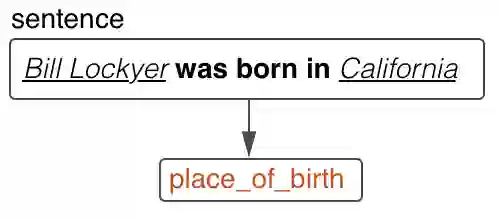

信息抽取- Information Extraction(IE)是一种自动从无结构或半结构化文本中提取结构化信息的技术,是自然语言处理中的经典任务。其中关系分类是信息抽取任务中的主要任务之一。给出两个实体和描述他们的一句话,预测两个实体之间关系的任务就是关系分类。 关系分类在知识库构建、问答系统中都发挥着重要作用。下图就是一个关系分类的例子:

二、研究动机:远监督方法及其挑战

远监督方法[1]可以利用知识库自动获取大量训练数据,一定程度上解决了人工标注成本高昂的问题。如下图所示,这种方法是利用知识库中的三元组,把所有出现对应实体对的句子,全部标注成对应关系。

这种自动标注在带来大量训练数据的同时,也引入了大量的噪声数据。这主要是因为远监督方法,没有考虑关系是否确实被句子表达出来,也就是说没有考虑其他表达关系的词语。这种表达关系的的词语,我们称其为pattern,比如上图中的第一句的“was born in”。

根据方法提出者的描述[1],在基于远监督方法构造的训练数据中,有高达30%的数据是噪声,也就是错误的训练数据。而据我们观察,实际情况更加糟糕。更进一步地说,由于远监督学习中的训练语料只依赖实体进行标注,这导致基于远监督的分类模型只会关注到实体本身。

在最近的研究中,为了充分使用远监督数据,减小噪音问题,大多数学者基于Bag的Multi-instance方法展开研究[2][3][4][5][6][7][8][9][10]。但是这些方法均没有利用好关系pattern。但在更早的研究中,pattern已经用于关系分类[11][12][13]。

基于前面的分析,关系pattern是远监督中鉴别噪声数据的关键。为此我们在此篇论文中,提出了基于注意力正则化的ANROR框架,旨在通过指导模型关注关系pattern,降低训练数据噪声,从而得到更好的关系分类效果。

三、ARNOR:基于注意力正则化的降噪

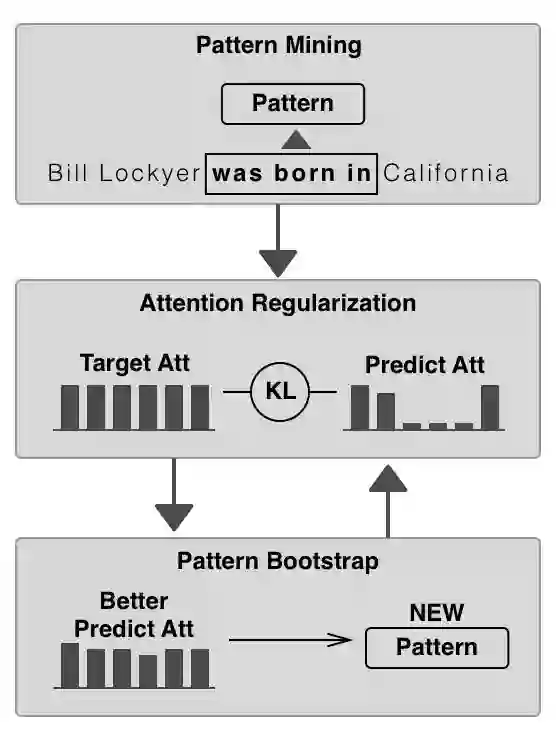

我们开创性地提出了注意力指导模型ARNOR,模型直接关注并充分利用更重要的关系指示词,从而提高模型在远监督数据上的分类效果。方法主要包含3个部分。

第一步,关系pattern挖掘。收集训练集中的高频pattern,作为之后注意力指导的目标。

第二步,基于注意力指导的训练。这一步希望模型可以关注到高频pattern,使用KL来进行注意力的优化指导,并在训练过程中与原来的分类loss一起训练。

第三步,Pattern迭代。召回之前没有收集的低频pattern,根据pattern关注度的KL打分挖掘高置信的新pattern。之后,再反复指导训练模型,使模型的分类效果进一步提升。

四、实验及分析

数据集:以前的远监督测试数据集,要么是远监督数据,要么是人工标注的数据(数据量少,质量不高)。所以,我们基于前人的一份NYT数据集重新标注了一份更大的数据集进行评测。

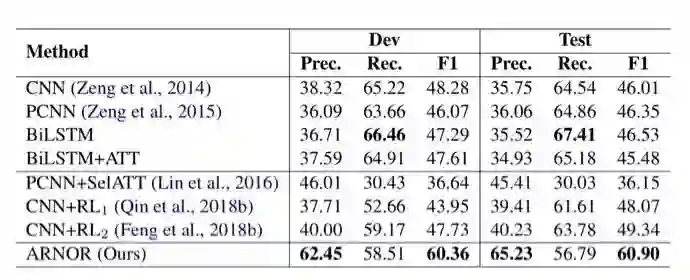

新模型在分类效果上十分突出。其中CNN、PCNN、BiLSTM、BiLSTM+ATT都是直接在噪音数据上训练的基础分类模型,可以看到效果并不好。之前效果最好的两个RL降噪模型,提升效果也相对有限。而我们的模型比之前最好的方法F1还要高10个点,获得了远监督数据上的分类State-Of-The-Art,效果遥遥领先。

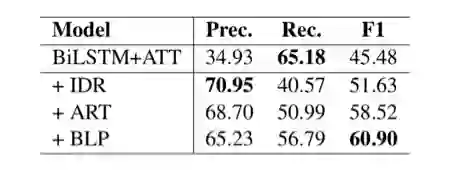

此外,对模型的每个模块都做了实验,注意力正则化的效果提升很明显。

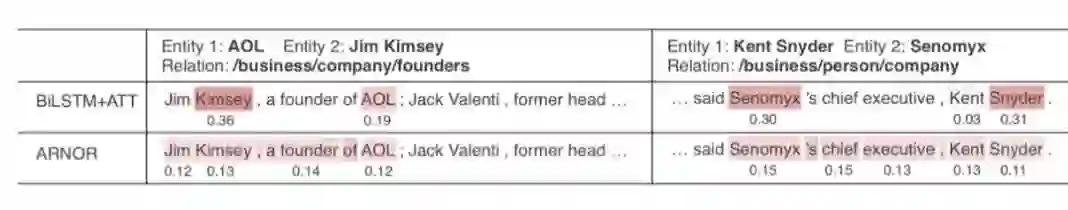

同时我们做了一些case分析,证明了模型通过注意力指导,正确关注了pattern。

结束语

我们提出了ARNOR方法,让模型关注并理解表达关系的pattern,十分显著地提高了远监督数据上的关系分类效果。这样一直以来不能实际应用的远监督数据就有了新的应用机会,可以帮助节省大量的标注时间。同时新测试数据集会更新到GitHub的PaddleNLP页面中,分享给所有从事相关工作的伙伴们。

GitHub地址:

https://github.com/PaddlePaddle/models/tree/develop/PaddleNLP/Research/ACL2019-ARNOR

至此,《ARNOR:Attention Regularization based Noise Reduction for Distant Supervision Relation Classification》论文的分享到此结束,敬请期待更多百度NLP最新前沿进展分享。

参考文献

[1] Mike Mintz, Steven Bills, Rion Snow, and Dan Jurafsky. 2009. Distant supervision for relation extraction without labeled data.

[2] Sebastian Riedel, Limin Yao, and Andrew McCallum. 2010. Modeling relations and their mentions without labeled text. In Joint European Conference on Machine Learning and Knowledge Discovery in Databases, pages 148–163. Springer.

[3] Yankai Lin, Shiqi Shen, Zhiyuan Liu, Huanbo Luan, and Maosong Sun. 2016. Neural relation extraction with selective attention over instances. In Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), volume 1, pages 2124–2133.

[4] Mihai Surdeanu, Julie Tibshirani, Ramesh Nallapati, and Christopher D Manning. 2012. Multi-instance multi-label learning for relation extraction. In Proceedings of the 2012 joint conference on empirical methods in natural language processing and computational natural language learning, pages 455–465. Association for Computational Linguistics.

[5] Daojian Zeng, Kang Liu, Yubo Chen, and Jun Zhao. 2015. Distant supervision for relation extraction via piecewise convolutional neural networks. In Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing, pages 1753–1762.

[6] Jun Feng, Minlie Huang, Li Zhao, Yang Yang, and Xiaoyan Zhu. 2018b. Reinforcement learning for rela- tion classification from noisy data. In Proceedings of AAAI.

[7] Pengda Qin, Weiran Xu, and William Yang Wang. 2018a. Dsgan: Generative adversarial training for distant supervision relation extraction. arXiv preprint arXiv:1805.09929.

[8] Xu Han, Zhiyuan Liu, and Maosong Sun. 2018. Denoising distant supervision for relation extraction via instance-level adversarial training. arXiv preprint arXiv: 1805.10959.

[9] Zeng Xiangrong, Liu Kang, He Shizhu, Zhao Jun, et al. 2018. Large scaled relation extraction with rein- forcement learning.

[10] Pengda Qin, Weiran Xu, and William Yang Wang. 2018b. Robust distant supervision relation extraction via deep reinforcement learning. arXiv preprint arXiv:1805.09927.

[11] Marti A. Hearst. 1992. Automatic acquisition of hyponyms from large text corpora. In COLING 1992 Volume 2: The 15th International Conference on Computational Linguistics.

[12] Thierry Hamon and Adeline Nazarenko. 2001. Detection of synonymy links between terms: experiment and results. Recent advances in computational terminology, 2:185–208.

[13] Shingo Takamatsu, Issei Sato, and Hiroshi Nakagawa. 2012. Reducing wrong labels in distant supervision for relation extraction. In Proceedings of the 50th Annual Meeting of the Association for Compu- tational Linguistics: Long Papers-Volume 1, pages 721–729. Association for Computational Linguistics.

本文转自"百度NLP",点击阅读原文可直达原文链接。