题目: Attention Models in Graphs: A Survey

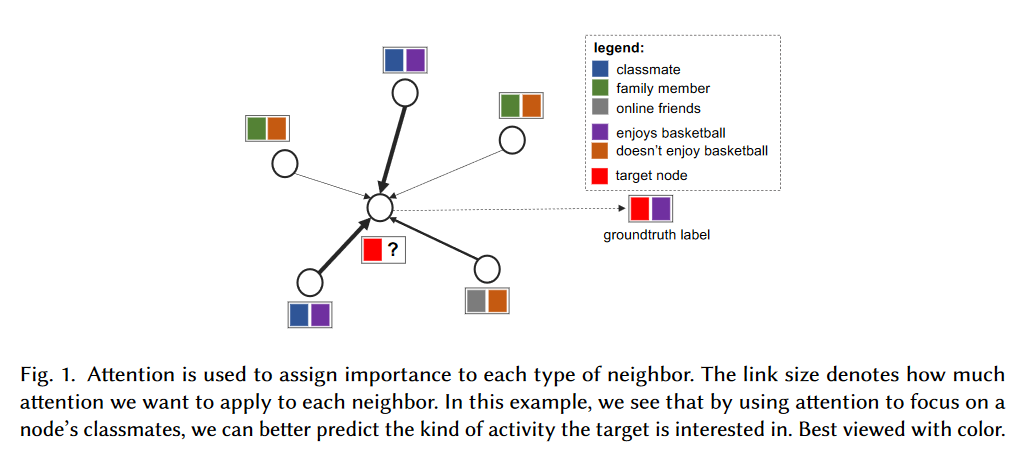

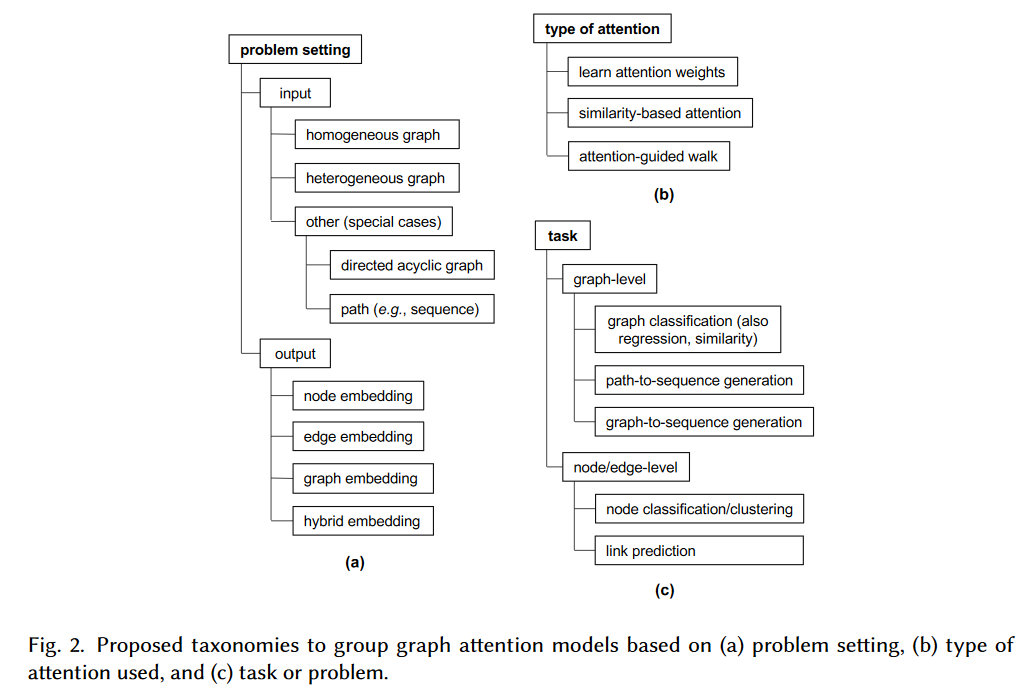

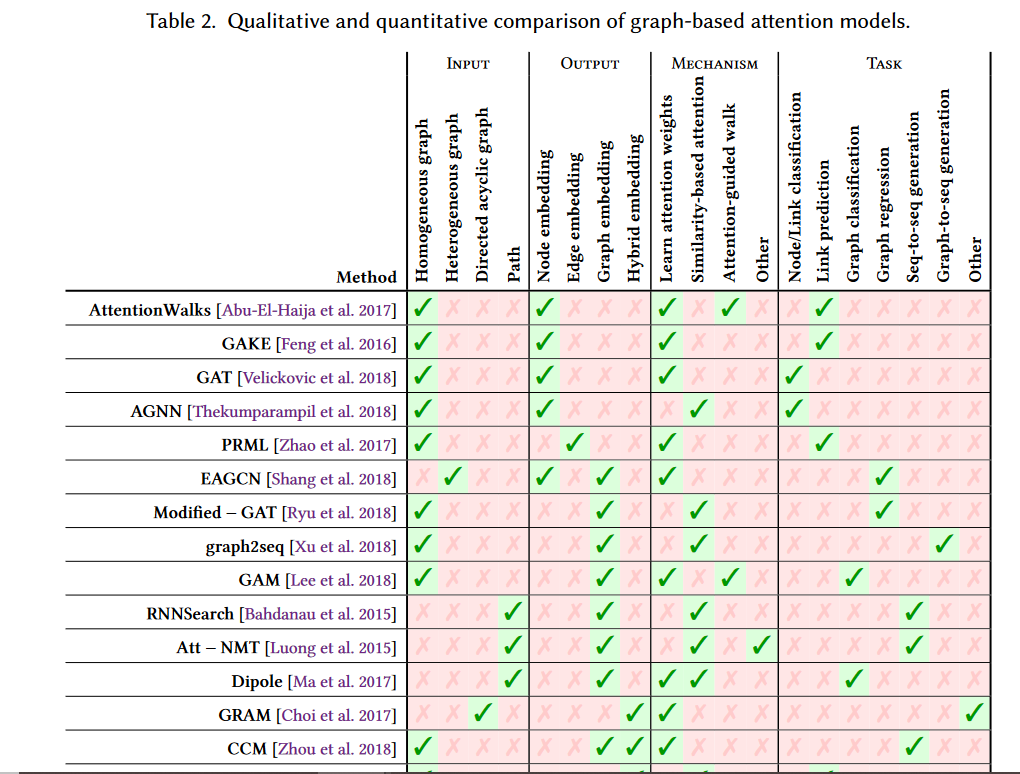

摘要: 图结构数据自然地出现在许多不同的应用领域。通过将数据表示为图形,我们可以捕获实体(即节点)以及它们之间的关系(即边)。许多有用的见解可以从图形结构的数据中得到,这一点已被越来越多的关注于图形挖掘的工作所证明。然而,在现实世界中,图可以是大的-有许多复杂的模式-和噪声,这可能会给有效的图挖掘带来问题。解决这一问题的一个有效方法是将“注意力”融入到图挖掘解决方案中。注意机制允许一个方法关注图中与任务相关的部分,帮助它做出更好的决策。在这项工作中,我们对图形注意模型这一新兴领域的文献进行了全面而集中的调查。我们介绍了三个直观的分类组现有的工作。它们基于问题设置(输入和输出类型)、使用的注意机制类型和任务(例如,图形分类、链接预测等)。我们通过详细的例子来激励我们的分类法,并使用每种方法从一个独特的角度来调查竞争方法。最后,我们强调了该领域的几个挑战,并讨论了未来工作的前景。

作者简介: Ryan A. Rossi,目前在Adobe Research工作,研究领域是机器学习;涉及社会和物理现象中的大型复杂关系(网络/图形)数据的理论、算法和应用。在普渡大学获得了计算机科学博士和硕士学位。

Nesreen K. Ahmed,英特尔实验室的高级研究员。她在普渡大学计算机科学系获得博士学位,在普渡大学获得统计学和计算机科学硕士学位。研究方向是机器学习和数据挖掘,涵盖了大规模图挖掘、统计机器学习的理论和算法,以及它们在社会和信息网络中的应用。

成为VIP会员查看完整内容

相关内容

人工智能(Artificial Intelligence, AI )是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。 人工智能是计算机科学的一个分支。

专知会员服务

147+阅读 · 2019年12月16日

专知会员服务

42+阅读 · 2019年12月16日

专知会员服务

73+阅读 · 2019年12月16日

专知会员服务

52+阅读 · 2019年12月16日

专知会员服务

140+阅读 · 2019年12月16日

专知会员服务

74+阅读 · 2019年11月20日

Arxiv

6+阅读 · 2019年8月17日