【MIT韩松博士-ICLR2020】端上自动机器学习-一劳永逸网络的NAS: Once-for-All Network

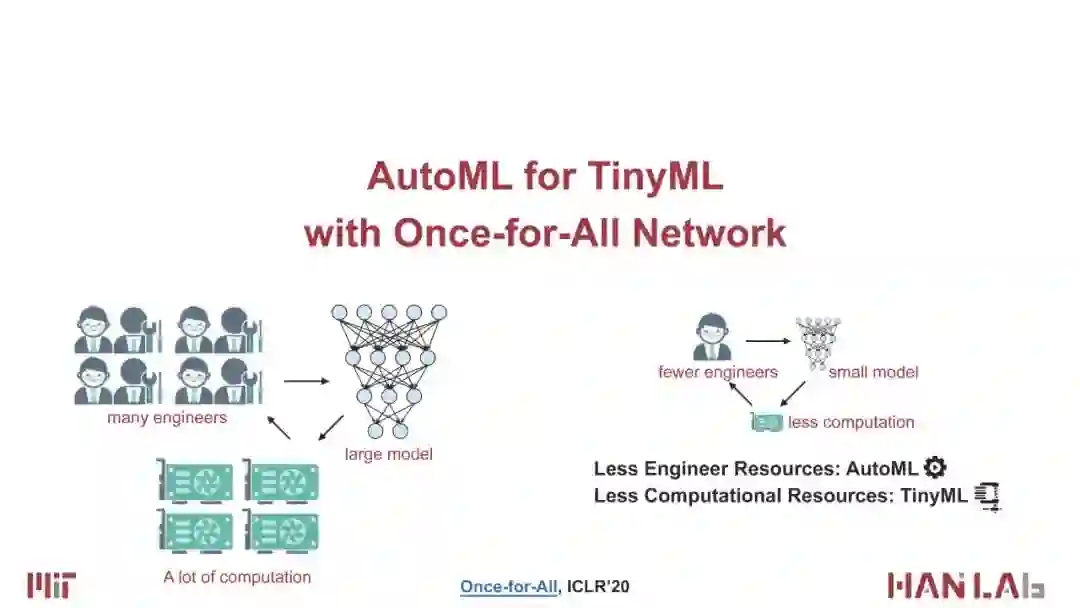

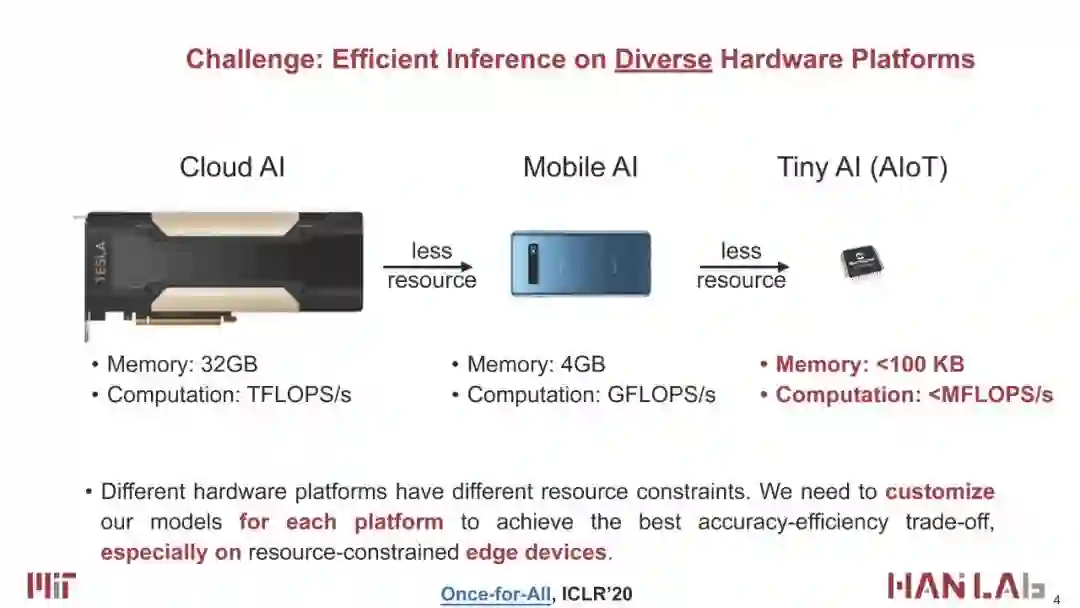

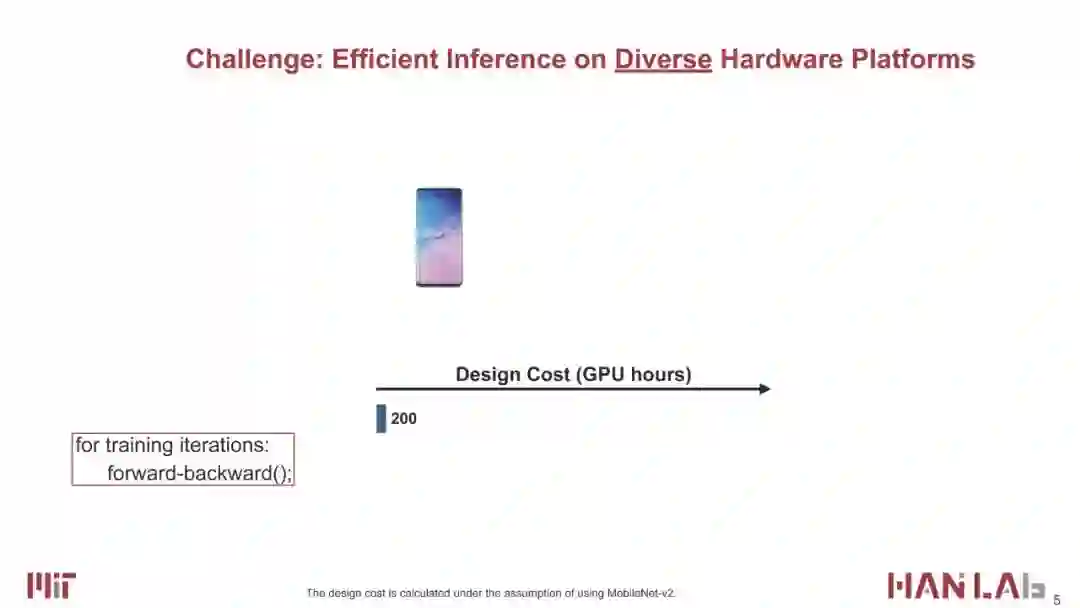

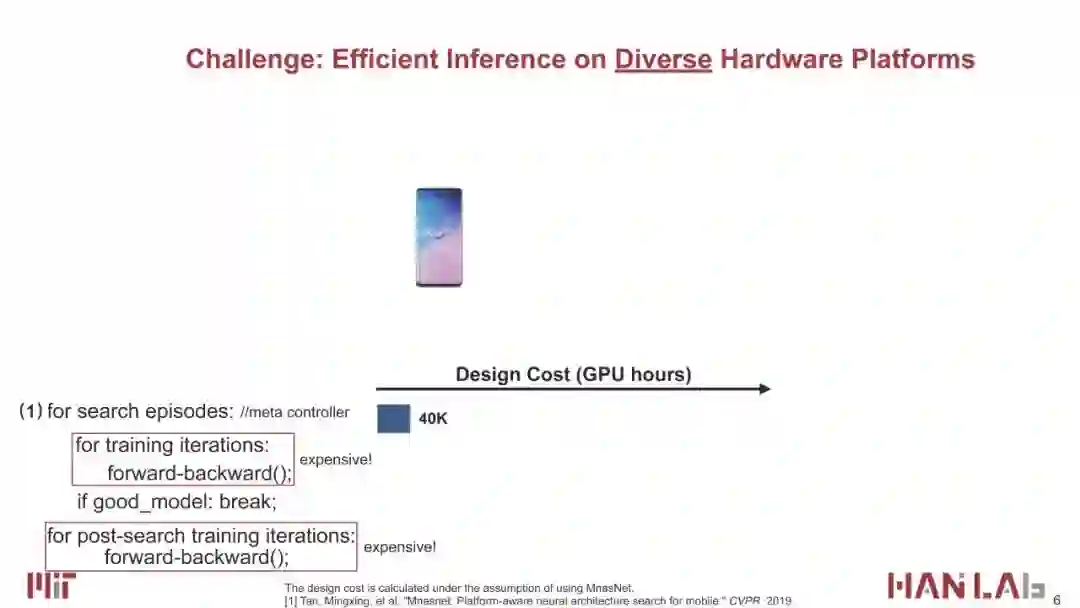

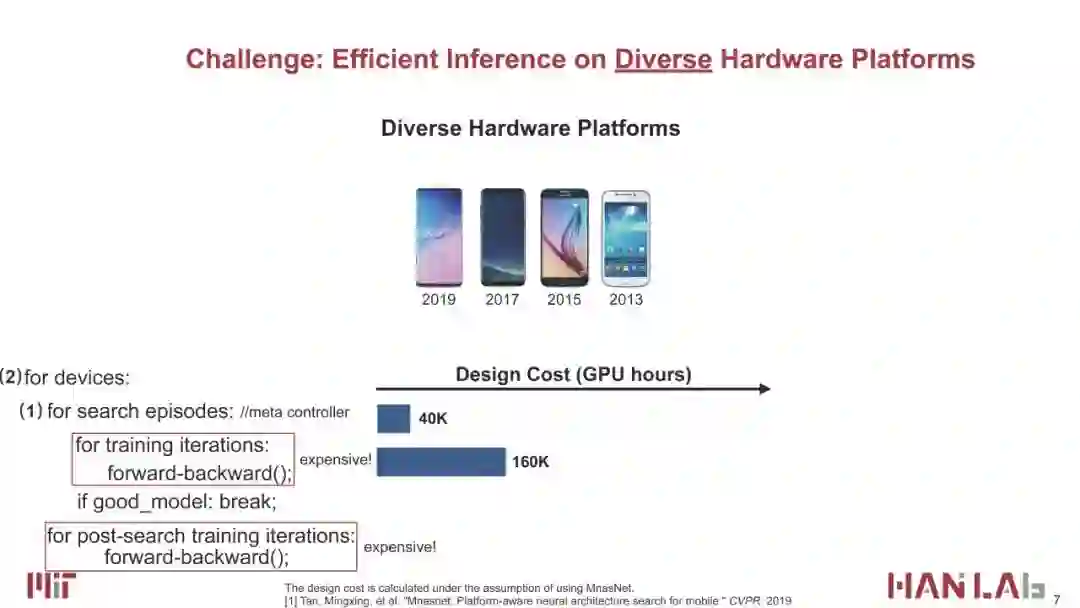

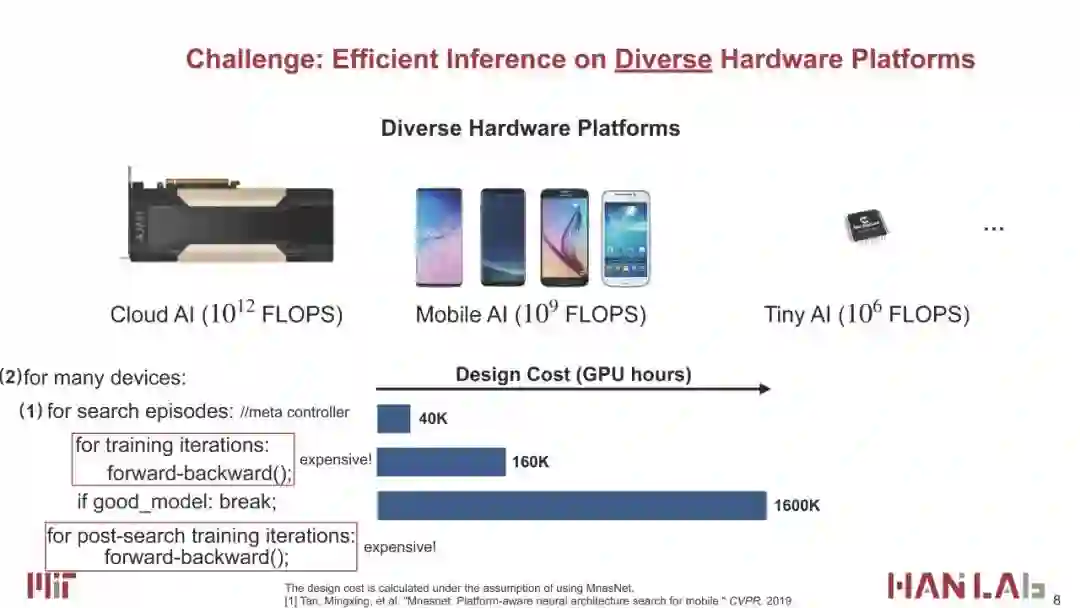

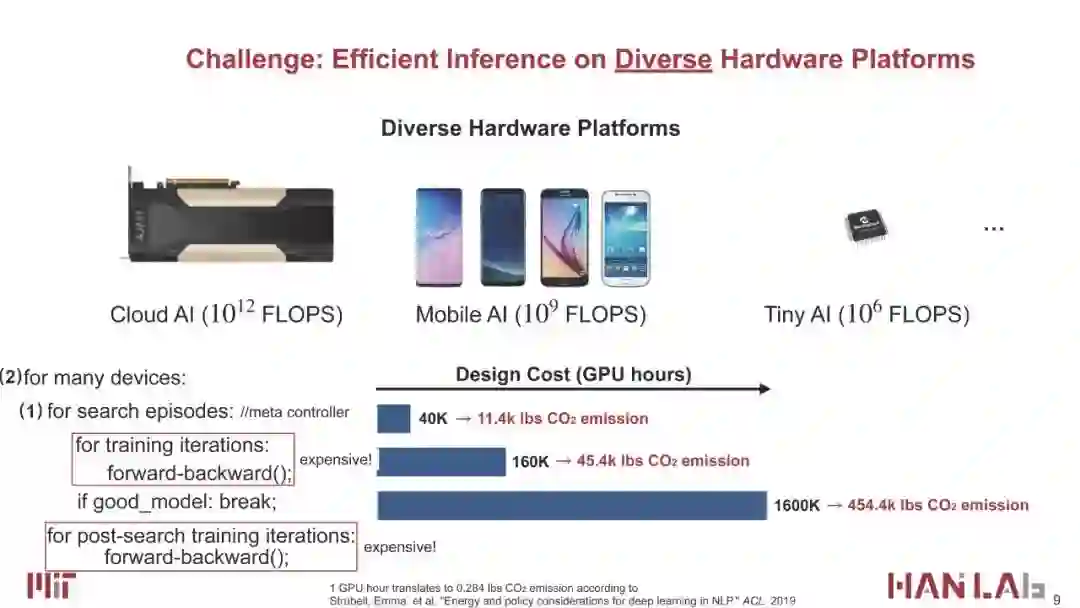

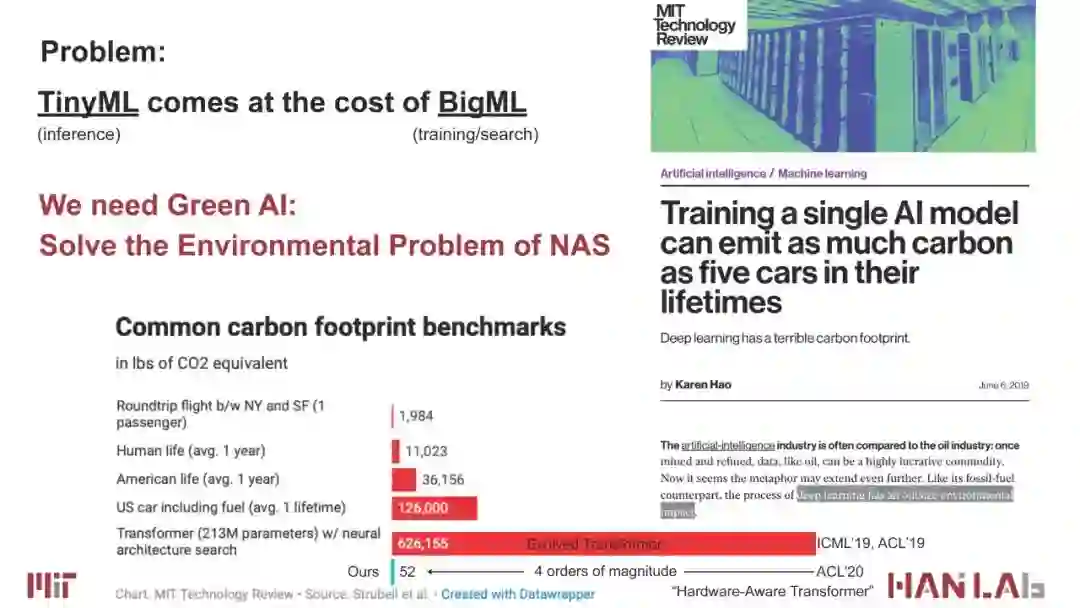

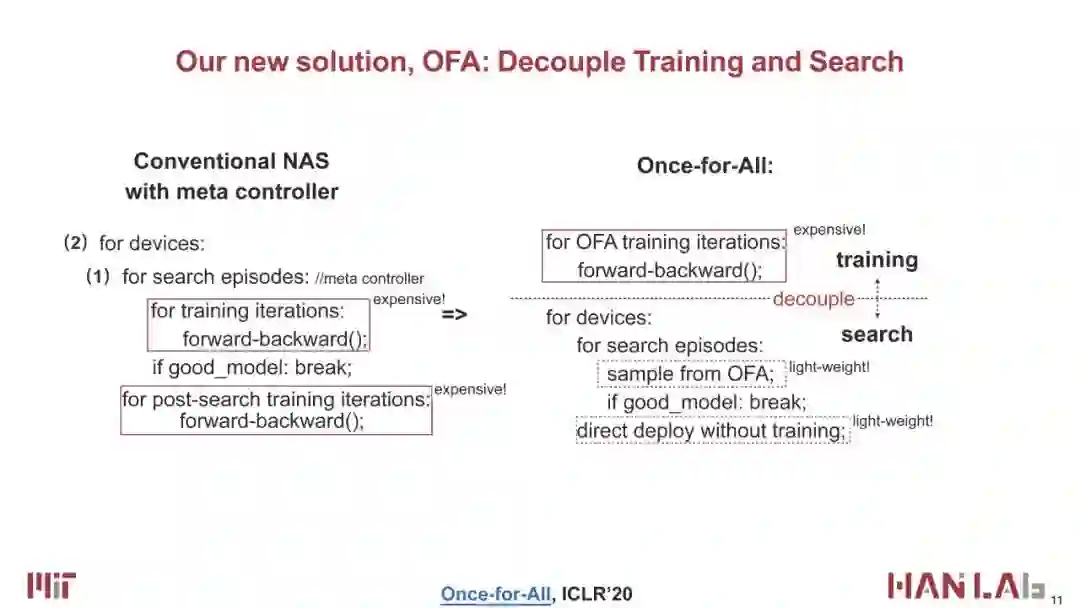

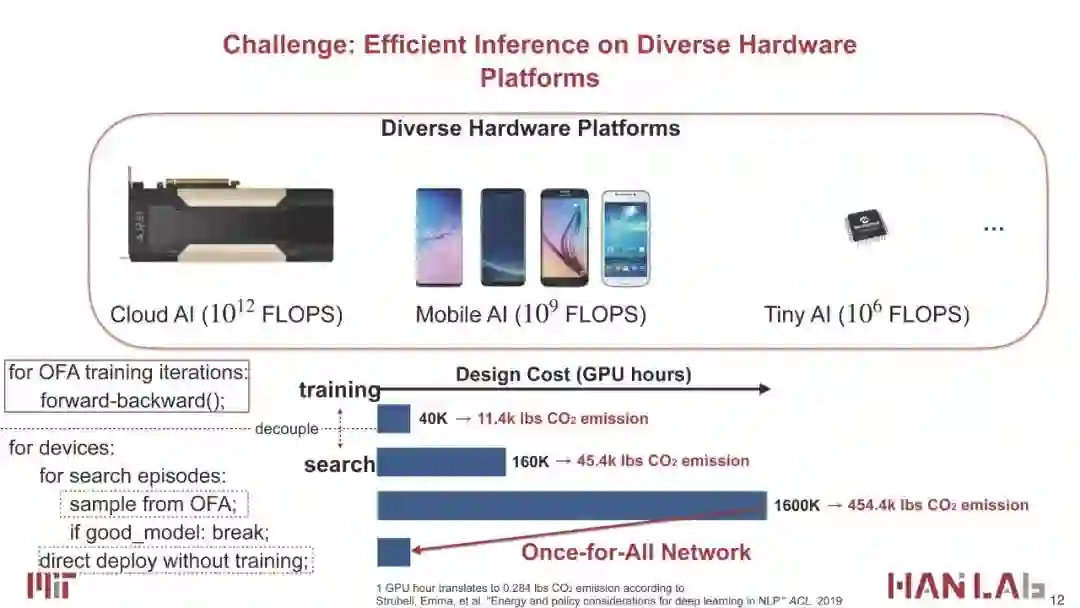

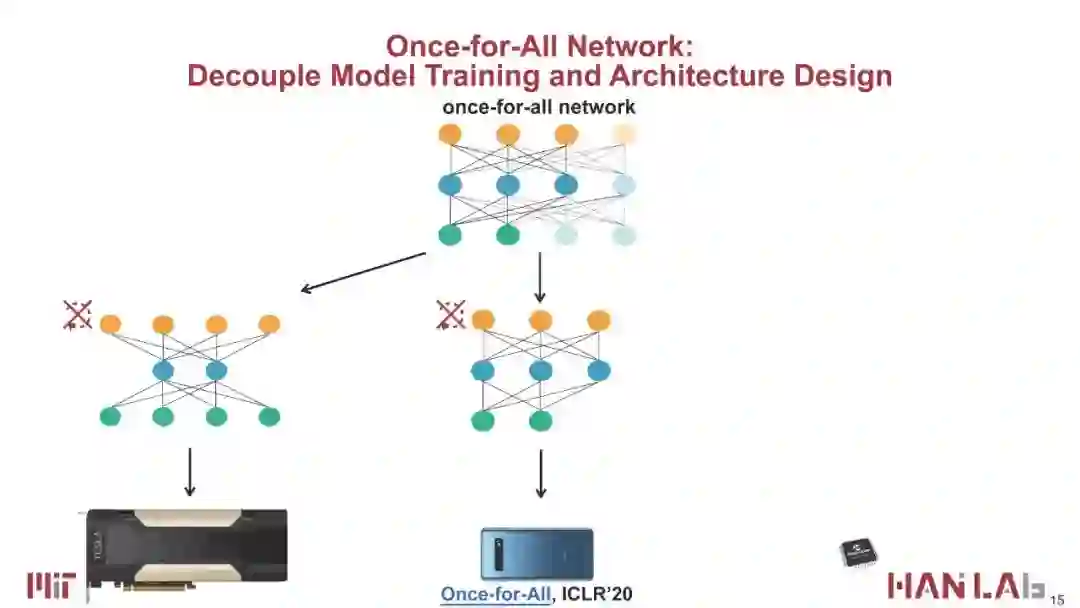

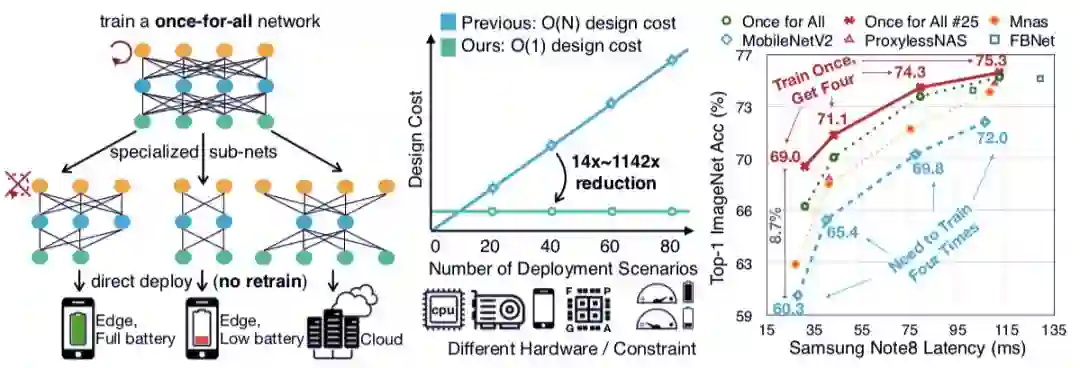

【导读】现实应用中,不同硬件很多,对于IoT设备、以及FPGA、GPU和CPU的搜索结果的是不一样的。如果对于每一个硬件都需要重新训练并且重新搜索的话,是非常昂贵的,所以为了降低搜索成本,MIT韩松博士等学者提出一次训练一个Once for All(一劳永逸)的网络,可以从这个网络中抽取不同的子网络,定制到不同的硬件上,这样就做到了只需要训练一次,极大降低NAS的搜索成本。对很多IoT设备以及不同的手机,包括LG的手机、三星的手机、Google的手机,都定制了不同的网络,定制的开销是非常低的,无论是延迟还是准确率都全面超越了EfficientNet和MobileNetV3。

韩松博士在ICLR-NAS论坛做了报告,64页PPT详细讲述了Once-for-All Network.

地址:

https://sites.google.com/view/nas2020

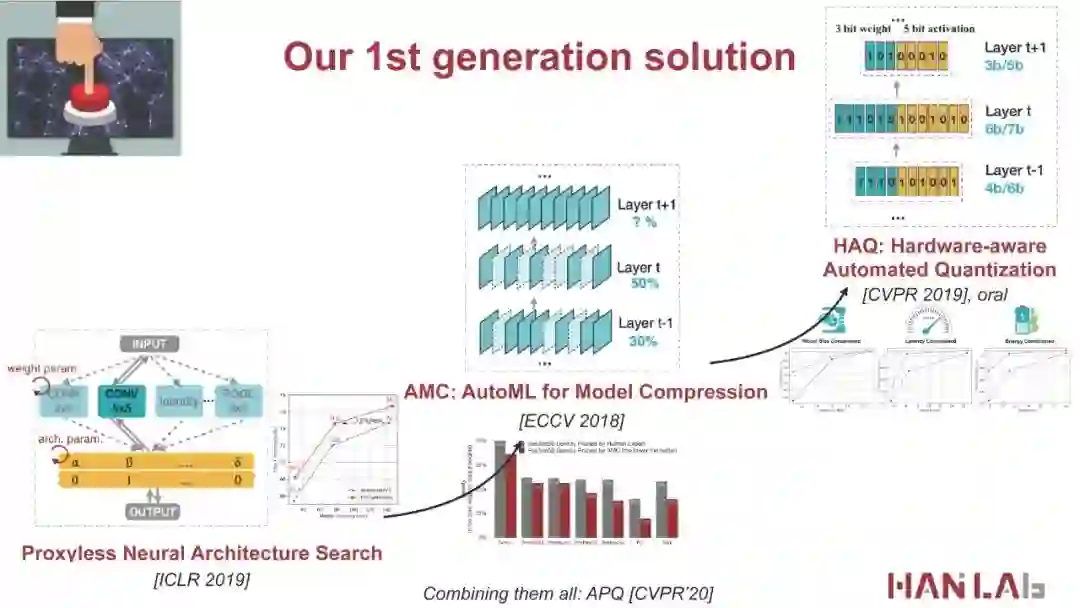

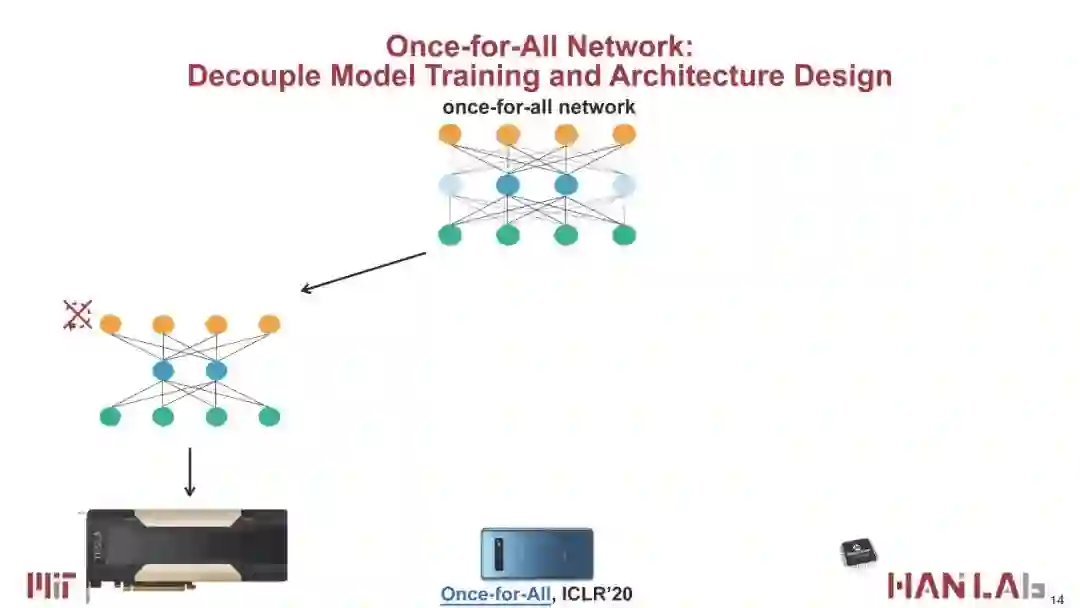

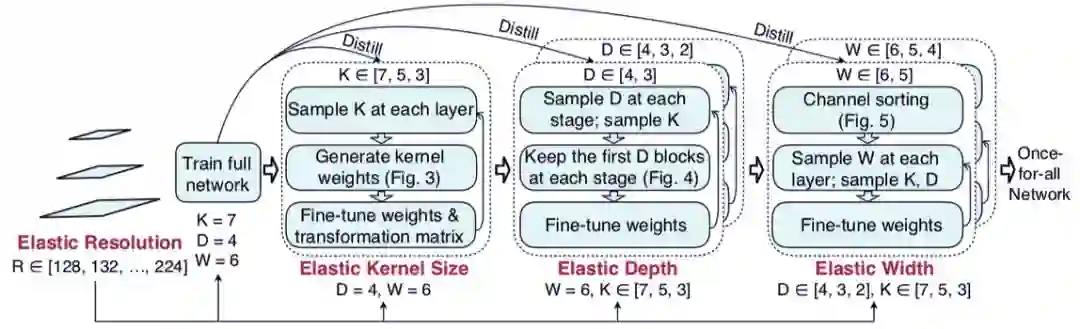

训练和搜索来训练一个支持多种架构设置的一次性网络(OFA)。通过从OFA网络中进行选择,不需要额外的训练,就可以快速地得到一个专门的子网络。我们还提出了一种新的渐进式缩减算法,一种广义剪枝方法,它比剪枝方法(深度、宽度、内核大小和分辨率)在更多的维度上减少模型大小,从而可以获得数量惊人的子网络(> 1019),这些子网络可以适应不同的延迟约束。在边缘设备上,OFA始终优于SOTA NAS方法(与MobileNetV3相比,ImageNet top1精度提高了4.0%,或与MobileNetV3相同的精度,但比MobileNetV3快1.5倍,比有效净w.r快2.6倍)。减少了许多数量级的GPU时间和二氧化碳排放。特别是,OFA在移动设置(<600M MACs)下实现了新的SOTA 80.0% ImageNet top1精度。OFA是第四届低功耗计算机视觉挑战的获奖方案,包括分类跟踪和检测跟踪。

韩松 本科毕业于清华大学,博士毕业于斯坦福大学,师从 NVIDIA 首席科学家 Bill Dally 教授。他的研究也广泛涉足深度学习和计算机体系结构,他提出的 Deep Compression 模型压缩技术曾获得 ICLR'16 最佳论文,ESE 稀疏神经网络推理引擎获得 FPGA'17 最佳论文,对AI算法在移动端的高效部署影响深远。他的研究成果在 Xilinx、NVIDIA、Facebook、Samsung 得到广泛应用。韩松在博士期间与同为清华大学毕业的汪玉、姚颂联合创立了深鉴科技(DeePhi Tech),其核心技术之一为神经网络压缩算法,随后深鉴科技被美国半导体公司赛灵思收购。2018 年,韩松加入MIT担任助理教授,入选2019年度麻省理工科技评论35 Innovators under 35,并在2020年获得NSF CAREER Award。

https://songhan.mit.edu/

ICLR 2020论文

作者:Han Cai、Chuang Gan、Song Han

论文链接:https://arxiv.org/pdf/1908.09791.pdf

报告

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“OAN” 可以获取《AutoML for TinyML with Once-for-All Network,64页ppt》专知下载链接索引