题目: EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks

摘要:

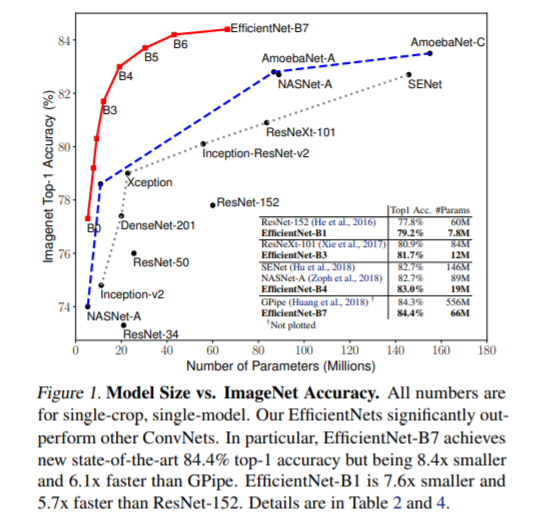

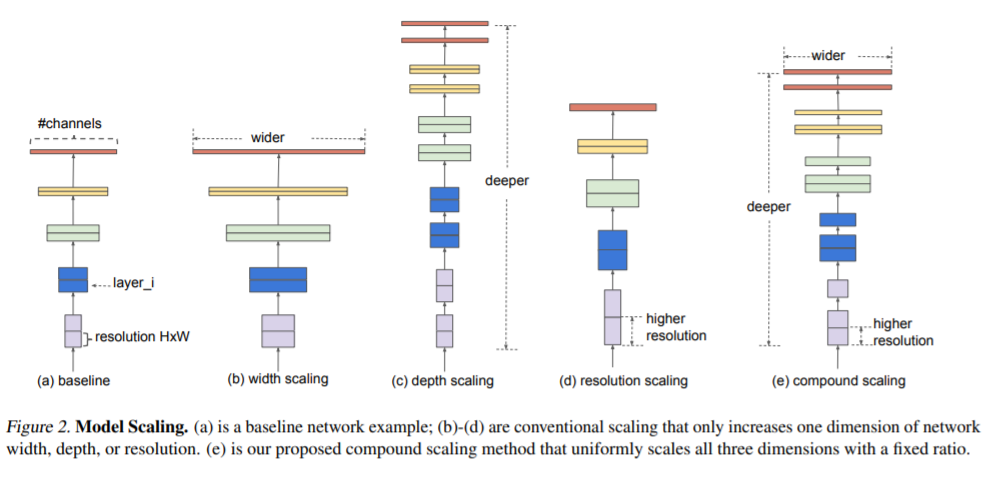

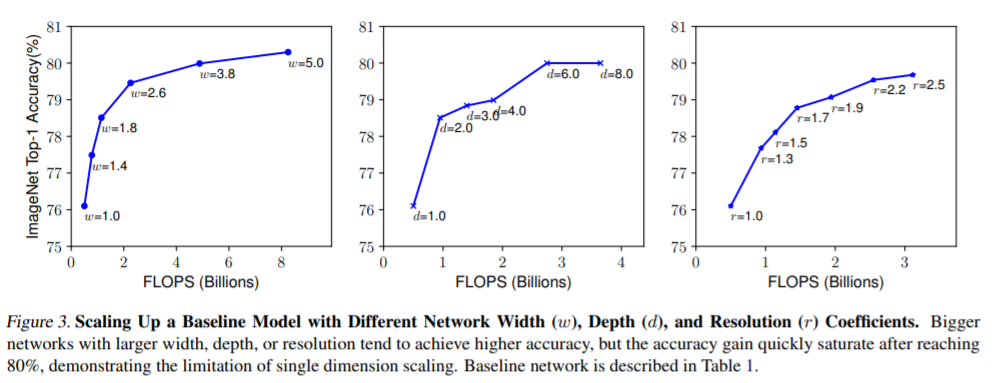

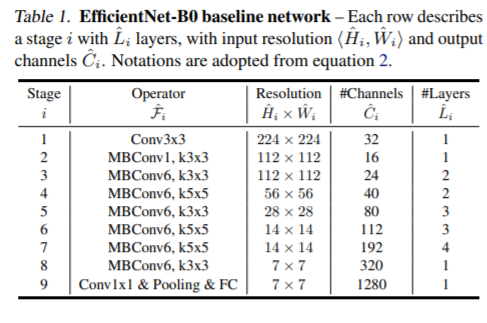

卷积神经网络(ConvNets)通常是在固定的资源预算下开发的,如果有更多的资源可用,则会进行扩展以获得更高的精度。在这篇论文中,我们系统地研究了模型缩放,并发现仔细平衡网络的深度、宽度和分辨率可以获得更好的性能。基于这一观察结果,我们提出了一种新的标度方法,使用简单而高效的复合系数来均匀地标度深度/宽度/分辨率的所有维度。我们证明了该方法在扩展MobileNets和ResNet方面的有效性。为了更进一步,我们使用神经结构搜索来设计一个新的基线网络,并将其扩展以获得一系列被称为EfficientNets的模型,这些模型比以前的ConvNets获得了更好的准确性和效率。特别是,我们的EfficientNet-B7在ImageNet上达到了最先进的84.4% top-1 / 97.1% top-5的精度,同时比现有最好的ConvNet小8.4倍,推理速度快6.1倍。我们的效率网在CIFAR-100(91.7%)、Flowers(98.8%)和其他3个传输学习数据集上传输良好,并且达到了最先进的精度,参数少了一个数量级。

作者:

Quoc V. Le目前是谷歌研究科学家,斯坦福大学计算机科学系人工智能实验室博士生。研究领域是机器学习和人工智能。个人官网:https://cs.stanford.edu/~quocle/

成为VIP会员查看完整内容

相关内容

专知会员服务

14+阅读 · 2020年1月1日

专知会员服务

27+阅读 · 2019年11月24日

专知会员服务

17+阅读 · 2019年11月17日

Arxiv

8+阅读 · 2019年2月11日

Arxiv

3+阅读 · 2018年9月6日

Arxiv

3+阅读 · 2018年4月18日

Arxiv

3+阅读 · 2018年3月9日