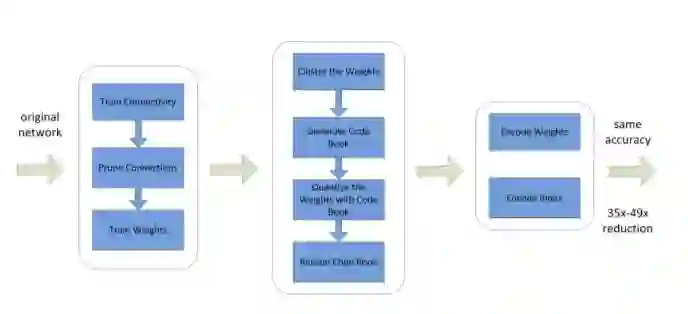

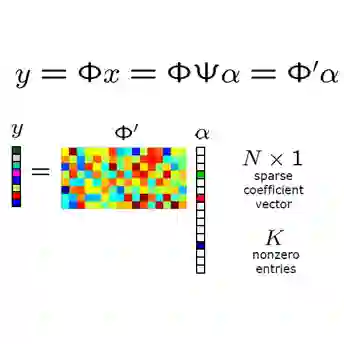

A Survey of Model Compression and Acceleration for Deep Neural Networks 深度卷积神经网络(CNNs)最近在许多视觉识别任务中取得了巨大的成功。然而,现有的深度神经网络模型在计算上是昂贵的和内存密集型的,这阻碍了它们在低内存资源的设备或有严格时间延迟要求的应用程序中的部署。因此,在不显著降低模型性能的情况下,在深度网络中进行模型压缩和加速是一种自然的思路。在过去几年中,这方面取得了巨大的进展。本文综述了近年来发展起来的压缩和加速CNNs模型的先进技术。这些技术大致分为四种方案: 参数剪枝和共享、低秩因子分解、传输/紧凑卷积过滤器和知识蒸馏。首先介绍参数修剪和共享的方法,然后介绍其他技术。对于每种方案,我们都提供了关于性能、相关应用程序、优点和缺点等方面的详细分析。然后我们将讨论一些最近比较成功的方法,例如,动态容量网络和随机深度网络。然后,我们调查评估矩阵、用于评估模型性能的主要数据集和最近的基准测试工作。最后,对全文进行总结,并对今后的研究方向进行了展望。

成为VIP会员查看完整内容