长久以来,自然语言生成任务性能评价方法只针对某一个特定意图设计,不能很好的全面评价生成文本质量优劣。

最近,来自卡内基梅隆大学(Carnegie Mellon University,CMU)和加利福尼亚大学圣迭戈分校(University of California, San Diego,UCSD)的研究人员,提出一个统一的自然语言生成评价方法。

该方法可以考察语言信息的变化程度,变化包括压缩、转写和创作等。作者认为,输入文本、上下文和输出文本之间的信息对齐能很好地刻画自然语言生成过程。

随着自然语言自动对齐算法的发展,这一系列可解释的指标,用于评价各类 NLG 任务的不同方面,并且不需要参考标签。

自然语言生成及评价方法

自然语言生成(Natural Language Generation,NLG)是指一系列根据输入数据和其他上下文信息生成流利的文本的任务。自然语言生成包括多种不同任务,例如自然语言摘要任务(summarization)要求将输入文本压缩为一小段包含其关键信息的文本;翻译任务(translation)将一种语言的文本转写为另一种语言;聊天任务(chatbot)生成有趣的回复以推进聊天的进行。

近年来,NLG 算法方面的研究取得了显着的进展。然而,长期以来,NLG 的评价一直是困难的,人工评价通常非常昂贵且缓慢,而鉴于文本建模的复杂性和多样性,准确的自动评价具有挑战性,需要兼顾不同 NLG 任务侧重的方向。

![]()

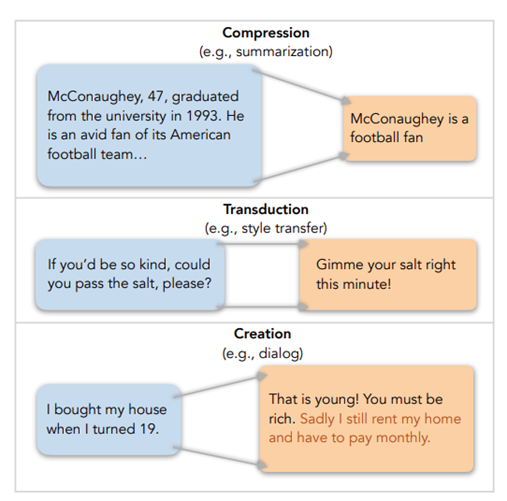

图 1. 自然语言生成的三种类型:压缩、转写和创作

该研究从信息变化的角度提出了一个更统一的 NLG 评价视角,为测量 NLG 任务的许多关键方面提供了一个通用框架。

具体来说,根据 NLG 的实际应用,每个任务都可以看作是:

(1)压缩,以简洁的文本表达突出的信息,如摘要和图像字幕;

(2)转写,即在准确保留内容的同时进行文本转换,如翻译和风格转换;

(3)创作,通过输入情境创造新内容,如对话和故事生成。这三个主要类别背后的一个共同概念是信息对齐,因此,团队将其定义为一个信息从一种文本描述转移到另一种文本描述的保留。

对于压缩任务(

例如,摘要),目标是简洁地描述输入中最重要的信息。即输出只包含输入的内容,即一致性,所包含的内容必须是突出的,即相关性。直观地,通过评估生成的输出中的信息如何与输入中的信息重叠(以及提供显著性线索的参考)的信息对齐度量,可以很容易地评估两个关键方面。同样的直觉也适用于转换任务(例如,样式转换),其中输出必须精确地保存输入内容。

因此,评估也可归结为测量输入和输出之间的信息对齐。创建任务(例如,对话框)生成在输入(例如,对话历史)之上添加新信息(例如,来自外部的知识)的输出。因此,输出、输入和外部来源之间的信息对齐对于评估创建的内容如何与上下文结合非常重要以及通过与外部来源的联系有多大意义。

从上面的角度来看,信息对齐是连接各个任务的评估的公共中心组件。一个准确的对齐预测模型将使人们能够可靠地评估各种应用中的许多相关方面。

在 NLG 任务中,令 x 为输入,c 是额外的上下文信息,y 是输出文本。例如,在基于知识的对话任务中,x 是历史的对话,c 是外部知识如维基百科文章,y 是响应。在目前的工作中,我们假设 x 和 c 都是文本,但当 x 和 c 为其他形式(例如,图像,表格)时,一般框架也适用,只要我们可以测量它们的信息与下面定义的y的一致性(例如,使用跨模态模型)。在某些任务中,可以使用人工编写的标准输出,我们将其表示为 r。

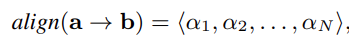

如上所述,信息对齐是 NLG 评价的核心模块。将从任意文本 a 到 b 的对齐视为标记级的软对齐。设 a 是长度为 N 的文本,b 是任意数据,a 与 b 之间的对齐分数记作

an 表示 a 的第 n 个 token 出现在 b 中的可信度。注意从 a 到 b 的对齐是单向的:它并不度量 b 如何对齐到a。

接下来,来看如何使用对齐得分来为各种任务定义直观的指标(细粒度的对齐得分还为结果度量提供了一定程度的可解释性)。

评价压缩任务

该任务旨在从文件 x 中提取最重要的信息,并将其表达在摘要 y 中。如上所述,一致性和相关性被广泛认为是表征生成摘要内容质量的关键方面。我们在下面提出我们的度量标准。

规定总结 y 应该只包含来自 x 的信息(而不是其他来源),在以前的工作中也被称为事实的正确性或忠实度。为了使 y 完全一致,y 中的所有标记都应该与 x 对齐。将一致性定义为:

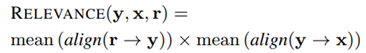

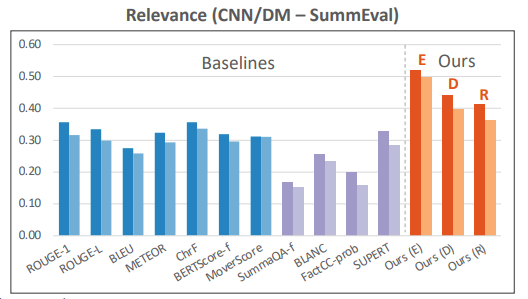

作为摘要研究得最多的方面之一,相关性涉及到摘要 y 如何保留 x 中的重要信息。在之前的工作中,信息的重要性可以通过参考摘要 r 来确定。也就是说,如果一项信息在参考中被提到,它就被认为是重要的。相关性度量定义为:

传统的摘要评价指标仅考虑第一项,没有考虑第二项。例如,ROUGE 只度量了 r 和 y 的对齐关系。新的指标结合了参考文本和输入信息,考虑更加全面。

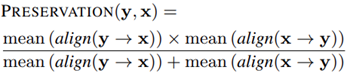

评价转写任务

以风格转换为例,在此讨论了转换任务的语义保存问题。风格转移的目的是生成文本 y,改变源文本 x 的一个或多个风格属性(例如,形式),并完全保留其风格无关的信息。内容保存的度量是评价的核心问题,也是一个具有挑战性的问题。

一个转写结果 y 必须包含来自 x 的全部信息且仅包含x中的信息。换句话说,y 中的所有标记都应该与 x 对齐,反之亦然。由此提出类似于F1的的保留度度量的定义:

![]()

这是两个对齐分数的调和平均数。注意,双向对齐不同于压缩中的一致性和相关性度量,在压缩中,我们只需要输出 y 与输入 x 对齐。我们的实验表明,对于转写来说,解释双向对齐是至关重要的。

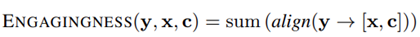

评价创作任务

这里使用基于知识的对话生成的例子,来阐述创建任务的各个方面。在这个任务中,代理生成文本 y 作为会话历史 x 的响应,同时展示来自知识上下文 c 的信息,例如一个外部文档或一组事实。对于代理来说,保持一段吸引人的对话被认为是一项必要的技能。此外,生成的响应必须以知识背景为基础,尽可能多地参考其信息。因此分别为这两个方面设计度量标准。

创作型任务的一个关键性质是要求代理创作出超越输入和上下文的新信息。因此,对于信息对齐向量的聚合,考虑总量比考虑密度更合适。也就是说,使用 sum(·) 而不是前面的 mean(·) 来聚合 token 级别的比对分数。

此处采用新颖性的一般定义,即回答不应该是泛泛的或枯燥的(例如,我不知道),而是让对方参与对话,比如提出一个有趣的事实。因此,一个有吸引力的回答 y 应该提供大量的信息,既承认x吸引合作伙伴的历史,也承认假设包含相关事实的上下文c。新颖性分数定义为:

![]()

作为以知识为基础的对话中被广泛研究的一个方面,“依据性”衡量的是回应在多大程度上反映了背景知识。依据性定义为:

![]()

对齐算法的实现

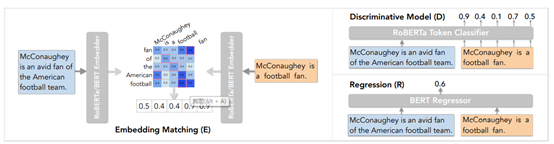

该研究在核心信息一致性度量的基础上,给出了不同任务中一系列关键方面的度量标准。接下来将讨论测量文本之间对齐得分的不同有效实现,包括嵌入匹配、判别模型和回归,所有这些都基于强大的预训练语言模型(图 2)。

![]()

图 2. 三种对齐算法

一种简单估计对齐的方式是直接匹配两个序列的嵌入向量。我们用 BERT 或 RoBERTa 来抽取 a、b 序列的嵌入向量,并将嵌入向量标准化到范数为 1,然后使用贪婪匹配进行配对。团队发现,当 a、b 具有等量信息时,该方法比较有效。

为了估计从任意文本 a 到 b 的信息对齐,将问题表述为序列标记,为此训练一个模型,如果 a 中的每个 token 与 b 对齐,则标记为 1,否则标记为 0。标签 1 对每个令牌的预测概率作为对齐分数。团队基于 RoBERTa 模型,使用自动构造的弱监督数据进行训练。例如,在一个 NLG 任务中,为了学习估计输出y与输入的对齐,使用该任务的训练语料库:对于每个输出y,随机掩盖 y 的一些 token,然后用 BART 模型填充这些 token。

与估计逐个 token 的对齐不同,聚合回归直接估计对齐分数的聚合值。因为所有 NLG 任务的性能度量都只以来对齐的聚合值,所以这种方法是可行的。以此为目的,直接训练一个模型回归最终的聚合分数。不过,当需要细粒度的 token 对齐时,聚合评估方法可能不适用于我们评估框架中的指标。

实验分析

团队对常用的、用于摘要、风格转换和对话的人工标注数据集评价提出了度量,并研究了信息对齐精度对度量性能的影响。

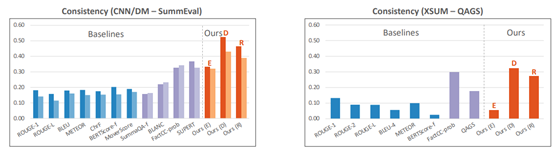

图 3 展示了一致性结果。在 CNN/DM 上,基于训练过的对齐模型(D 和 R)的指标都明显优于之前的指标。在 XSUM 上,基于 D 的指标也获得了最佳性能。基于嵌入匹配的相关性出现了灾难性的下降,这可能是由于 XSUM 摘要的较高抽象性导致嵌入匹配不充分。基于句子分类器的 FactCC 度量也在 XSUM 上获得了良好的相关性,该度量经过训练可以区分意译和人工干扰的句子。然而,它似乎无法有效地模拟 CNN/DM 上的总结,这些摘要往往更长,信息更丰富,从而产生较低的相关性。

![]()

图 4 展示了 CNN/DM 数据集上的相关性结果。这一指标完全超越了其他基线方法,这说明同时考虑一致性和相关性更能提高摘要任务的泛化性能。表 1 的消融研究进一步证实了这一点,它表明,与单个对齐或简单相加相比,两种对齐相乘(强调两者的联合和平衡成就)提高了相关性。图 4 还显示了基于 D 和 r 的实现比基于 D 和 r 的变体执行得更好,这可能是因为该指标涉及生成和引用之间的对齐,后者往往具有类似的信息量,因此更倾向于一对一的 token 映射。下面我们观察到类似的转写模式。

图 5 展示了保留性指标的结果。新的度量标准(E)比之前的所有度量标准都具有竞争力或更好的性能。MoverScore 作为一个强大的基线,计算输入 x 和输出 y 标记嵌入之间的字移动距离。相反,新的度量明确地说明了具有 F1 风格的调和平均聚合的双向输入-输出对齐。表 2 显示双向方法是有效的,与单向比对相比,具有更高的相关性,符合转导任务的性质。与它们在摘要中的相关性结果类似,基于 D 和 R 的实现落后于 E,这可能是因为 token 匹配更适合测量具有相似信息量的两个文本块之间的对齐。

![]()

![]()

图 6. 新颖性和依据性分数与人类标注的相关性

![]()

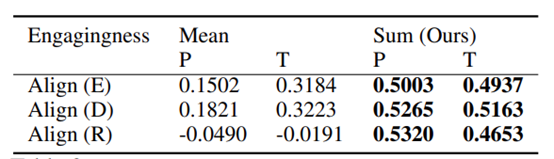

表 3. 消融实验:新颖性指标的皮尔逊相关系数

对于新颖性实验结果如上。值得注意的是,简单响应长度在两个数据集上的表现都很好,远远好于 PersonaChat 之前的指标。通过将所有令牌的对齐分数设置为 1,可以将基线视为一种特殊情况。基于模型的度量的更强相关性证明了精确对齐的效果。表 3 中的消融研究表明,测量对齐信息的体积(总和)而不是密度(平均值)对于我们的指标的卓越性能至关重要,这突出了创建任务的独特特征。

依据性的结果显示在图 6 的底部两个图中。新的度量实现了很强的人类相关性,基于回归对齐的度量始终优于其他实现,这可能是因为对基础信息量(总和)的估计受益于端到端模型的表达能力。这可以从基于判别模型堆区的指标的不佳性能看出,该指标是在相同的数据上训练,但用更多的结构来聚合 token 级别的预测。

特别的是,除了这两个核心方面之外,我们基于一致性的方法在其他对话方面(如响应的可理解性和自然性)也比现有的指标实现了更强的人类相关性。

![]()

图 7. 对齐估计正确性与 NLG 评价指标的关系

总而言之,针对 NLG 任务中的压缩、转写和创作三个文本生成类型,这项研究提出一个统一的通用 NLG 任务评价框架。基于输入、上下文和输出的信息对齐,我们为不同任务的关键方面(总结、风格转换和对话)设计了一系列可解释的度量标准。与现有的 NLG 度量相比,统一设计的度量方法实现了最好的人类相关性。统一的框架为新方面/任务的度量设计提供了结构化的指导,我们期待在未来有更多的探索。

【学术头条】与【数据实战派】是我们科学+科技内容联合体的主要成员。

【数据实战派】致力于打造一个不用感叹号的新兴 AI 内容自媒体,围绕“计算+智能(computing+intelligence)”技术,力求从种种杂音和噪声中,压缩出更纯粹且重要的知识,助力中国 AI 开发者的高速成长。

目前,【数据实战派】由一批具有 AI/CS 专业背景的作者及资深科技编辑共同运营,并已聚拢一大批有着深度阅读习惯、优质内容品位的读者。我们期待有志之士的加入,共同打造高规格的 AI 技术社区。

更多精彩视频,尽在学术头条视频号,欢迎关注~

添加学术君微信 xueshujun01

备注“昵称+视频号名称+兴趣领域”

加入「短视频爱好者2群」交流群

![]()