百度联合北京大学发布首篇《自然语言生成保真性》的综述论文,非常值得关注!

由于预训练语言模型等深度学习技术的发展,自然语言生成(NLG)近年来取得了很大的进展。这一进步导致了更流畅、连贯甚至属性可控(例如,文体、情感、长度等)的生成,自然地导致了下游任务的发展,如抽象摘要、对话生成、机器翻译和数据到文本的生成。然而,生成的文本通常包含不真实的信息,这一问题已经成为文本生成的最大挑战,使得文本生成的性能在许多现实场景的实际应用中不能令人满意。针对不同的任务提出了许多关于保真性问题的分析、评价和优化方法的研究,但并没有结合起来进行组织、比较和讨论。本文从问题分析、评价指标和优化方法三个方面,系统地综述了近年来NLG保真性问题的研究进展。我们将不同任务的评估和优化方法组织成一个统一的分类,以便于任务之间的比较和学习。并进一步讨论了今后的研究方向。

引言

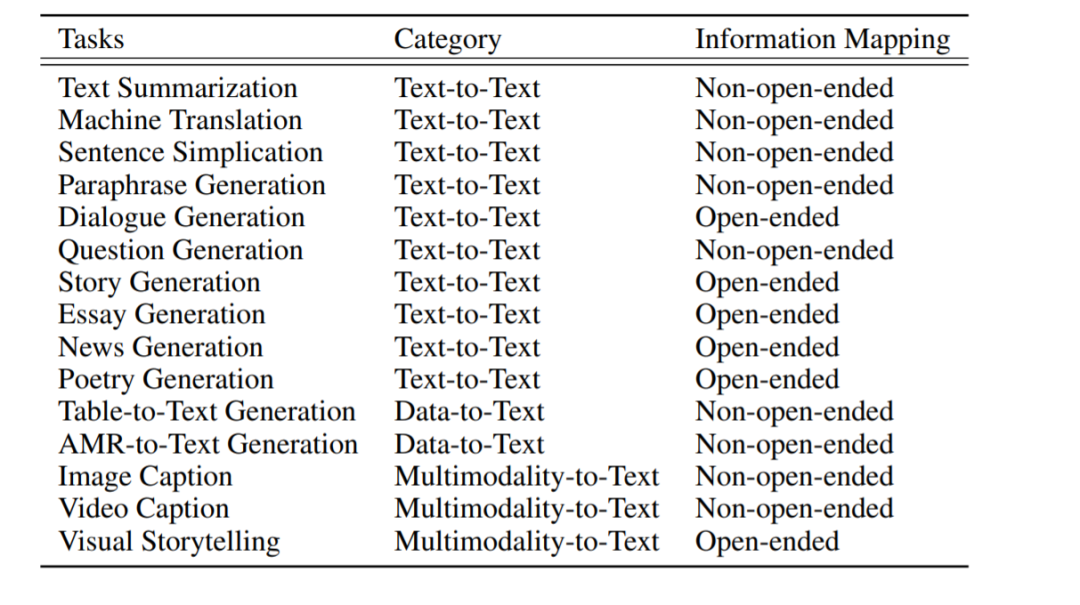

自然语言生成(NLG)是从文本或非文本输入中生成自然语言文本的过程,以满足特定的交流目标(Gatt和Krahmer, 2018)。NLG的输入随着任务设置的不同而不同,但是输出总是可读的自然语言文本。根据输入类型,NLG的任务主要可以分为: 文本到文本的生成、数据到文本的生成和多模态到文本的生成。文本到文本的生成任务将现有文本作为输入,并自动生成新的、连贯的文本作为输出。最常见的应用包括:文本摘要(Allahyari et al., 2017)、对话生成(Li et al., 2016b)、机器翻译(Koehn, 2009)、问题生成(Du et al., 2017)、释义生成(Li et al., 2017)等。数据到文本的生成任务从数字数据或结构化数据(如表、键值列表和元组)自动生成文本。示例应用包括:表格到文本的生成(Liuet al.,,2018b)、kg到文本的生成(Ke et al.,,2021)、意义到文本的生成(Song et al.,2018)等。多模态到文本的生成任务将多模态输入(如图像或视频)中的语义转换为自然语言文本。典型任务包括图像字幕(Vinyals等人,2015年)、视觉叙事(Huang et al.,2016年)和视频摘要(Ma et al.,2002年)。

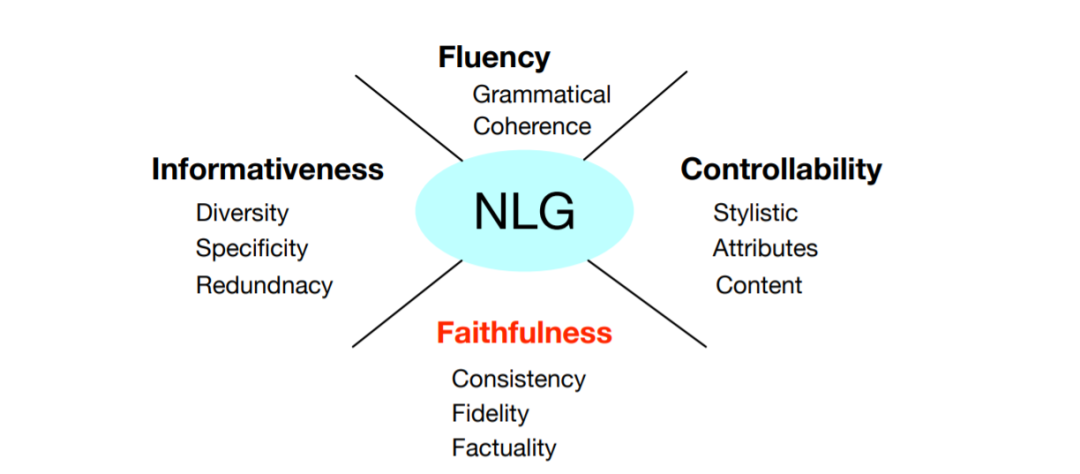

图1 NLG面临的挑战有四个方面。保真性已成为现代自然语言时代最大的挑战。

从输入-输出信息转换的角度来看,自然语言学习的任务可分为开放式语言生成和非开放式语言生成。开放式语言生成任务是指输入不完整且输入不包含输出语义的任务。例如,故事生成是一种经典的开放式语言生成任务,它倾向于基于一些引导句或关键词生成一个完整的故事。显然,模型需要创建新的信息来完成故事情节规划和生成有意义的故事。开放式语言生成任务的最大特征之一是输入和输出之间的信息映射通常是一对多的。相同的输入可以产生许多具有不同含义的输出。相比之下,对于非开放式语言生成任务,输入通常为输出提供完整甚至更多的信息。机器翻译是一种典型的非开放式语言生成任务,输入为输出提供完整的语义。释义生成可以看作是一种等价的信息转换,其中输入和输出语义完全相同,但语言表达不同。在文本摘要中,输入通常比输出提供更多的信息,因此摘要模型需要选择显著性信息来产生摘要输出。

自然语言生成发展

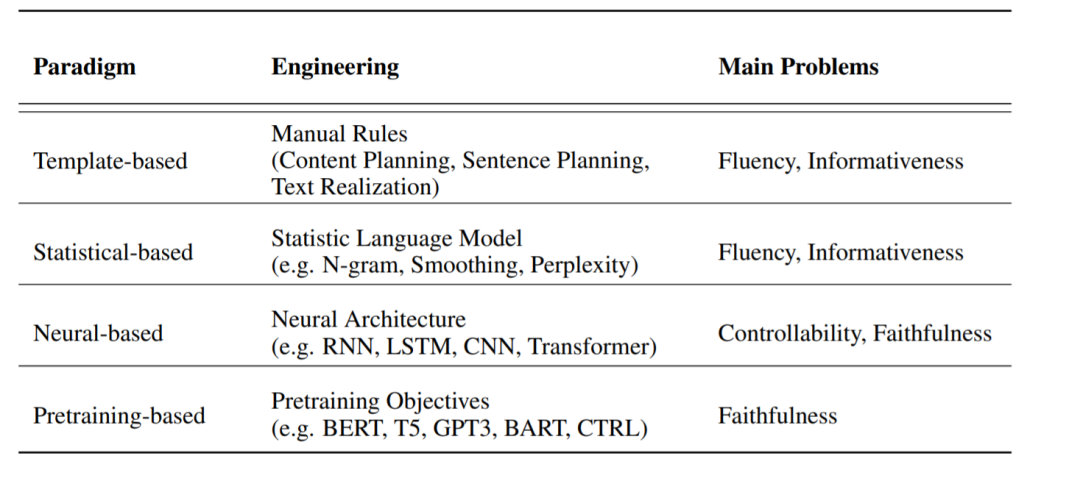

NLG的研究历史悠久,始于20世纪50年代。NLG方法的发展主要可分为基于模板、基于统计、基于神经网络和基于训练前的四个阶段,如表2所示。

-

基于模板的。最早的自然语言生成系统采用规则和模板的方法来设计不同的文本生成模块,反映了许多专家设计的词汇、语法、句法甚至语用方面的语言知识。它们通常由几个不同的组件组成,包括内容规划、句子规划和文本实现,每个组件都执行特定的功能。

-

Statistical-based。统计语言模型进一步从概率和统计的角度提出了一种新的语言建模思想,将词汇和上下文之间的依赖关系编码在条件概率中。N-gram语言模型是目前最流行的统计语言模型,通常会结合基于模板的方法对生成的流畅文本进行重新排序和选择。

-

Neural-based。 随着深度学习的发展,基于神经网络的端到端方法逐渐占据主导地位,通过端到端训练可以更好地建模词汇与上下文之间的统计共现关系,从而显著提高文本生成性能。NLG已经探索了各种神经结构,如循环神经网络(RNN) (Graves, 2013; Zaremba et al., 2014),卷积神经网络(CNN) (Kalchbrenner et al., 2014)和自注意力Transformer网络(Vaswani et al., 2017)。

-

Pretraining-based。 最近,基于Transformer架构的预训练语言生成模型能够更好地捕捉词汇、语法和语义等语言知识,极大地促进了自然语言生成的发展。预训练语言模型的兴起(Brown et al., 2020; Devlin et al., 2018; Liu et al., 2019c)已经导致了包括文本摘要在内的应用程序的强文本生成模型(Dong et al., 2019; Liu and Lapata, 2019; Zhang et al., 2020b),对话生成(Bao et al., 2020; Zhang et al., 2019)、数据到文本的生成(Chen et al 2020b)和机器翻译(Liu et al,2020)。然而,尽管这些模型生成了流畅的语法文本,但它们容易产生与输入文本相矛盾的事实错误(Cao et al., 2017)。

传统的基于模板的文本生成方法通常能够生成可靠、保真性的文本,但由于规则的多样性和通用性的限制,生成的文本往往存在流畅性和信息量大的问题。该方法通过对大型语料库的端到端训练,可以生成流畅、信息丰富的文本。但由于概率抽样机制的引入,他们每次都需要从模型估计的概率分布中进行抽样。考虑到词汇量非常大,一般在1000 ~ 50000个数量级,概率分布不可避免地包含大量出现概率低的长尾词,再加上概率抽样本身的随机性,基于神经网络的NLG模型的可控性和保真性尤为严重。在预训练时代,通过对大规模无标记语料库进行自监督训练,模型生成的文本在流畅性、信息量甚至可控性方面都表现突出,但仍不能解决保真性问题。

本文结构

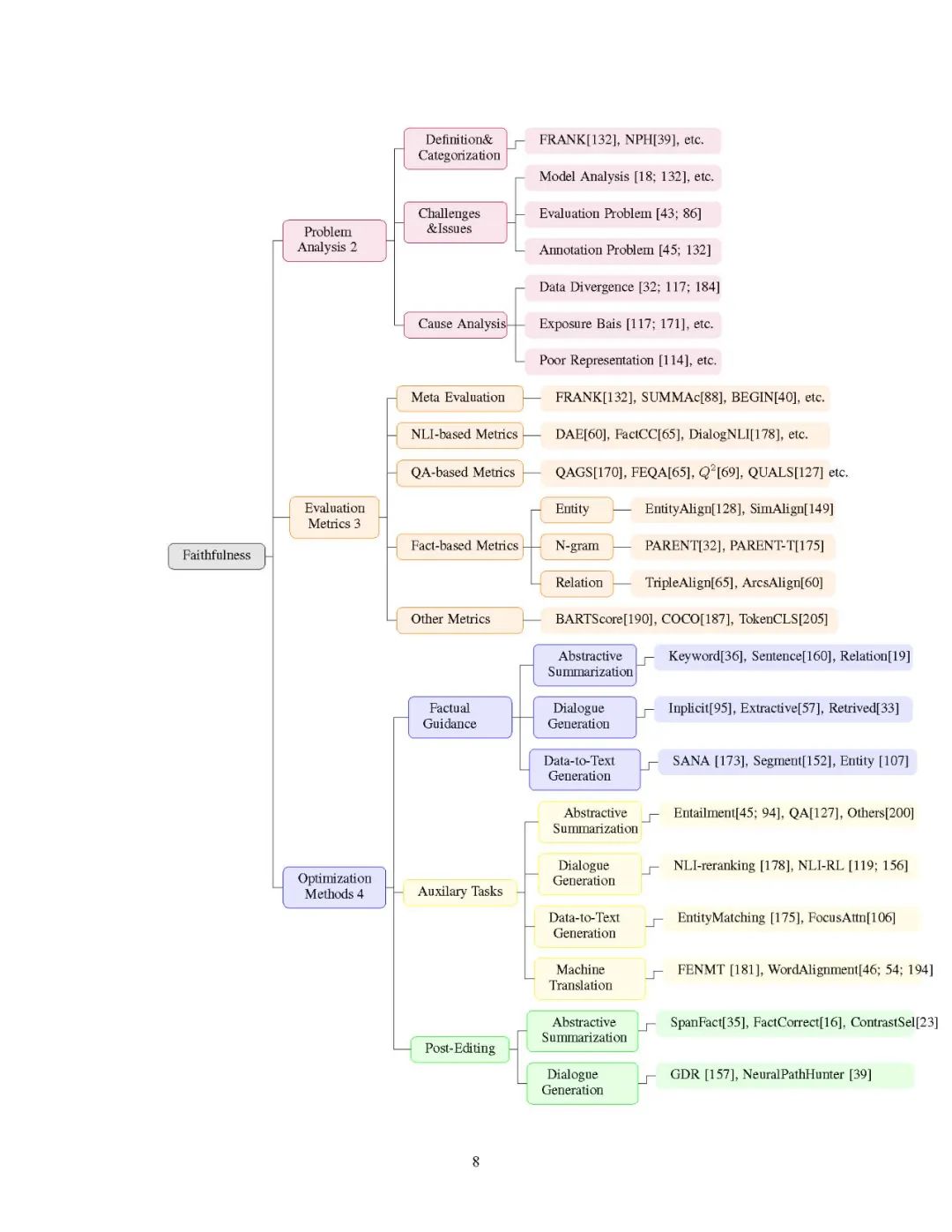

该综述的内容类型如图3所示。在第二节中,我们系统地分析了NLG中的保真性问题,包括不保真误的分类、人工标注、保真度评估和优化面临的挑战、原因分析以及与其他方面的关系。在第三节中,我们将提出的各种保真度评价指标进行组织,并将这些指标的元评价相结合,以促进未来保真度评价的研究。在第4节中,我们从任务和方法论的角度总结了不同的优化方法,并详细说明了它们的相对优势。