【泡泡一分钟】CReaM: 使用卷积网络估计深度的浓缩实时模型

每天一分钟,带你读遍机器人顶级会议文章

标题:CReaM: Condensed Real-time Models for Depth Prediction using Convolutional Neural Networks

作者:Andrew Spek, Thanuja Dharmasiri, and Tom Drummond

来源:2018 arXiv

编译:明煜航

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

自从CNN在机器人视觉领域重新受到关注以来,一系列使用神经网络进行分类,语义分割,结构(深度,法向,表面曲)估计的算法被开发了出来。虽然其中一些模型实现了最先进的水平,超越了人类能够达到的程度,但是要将这些模型运用在注重实时性的机器人环境中仍然是一个挑战。

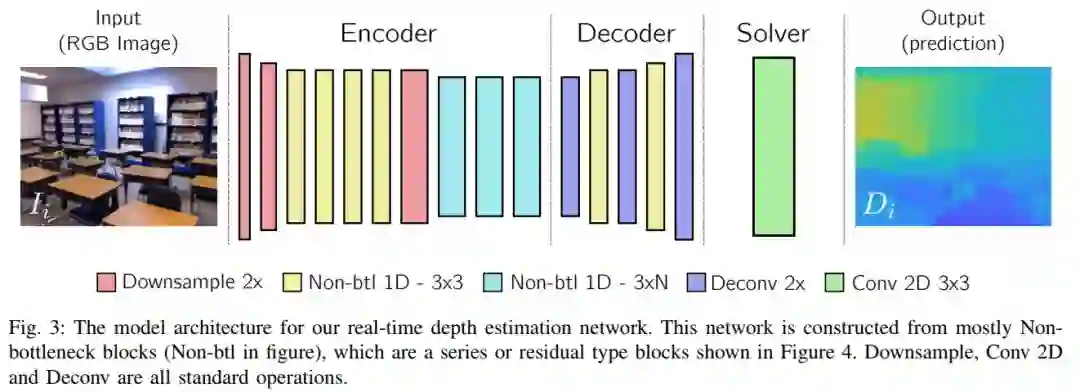

实时框架是搭建一个人类和机器人能够无缝衔接的社会的首要条件。出于这个考虑,作者提出了一种能够在NVIDIA-TX2显卡上以30帧每秒的速度估计深度信息的新颖的实时结构估计框架。

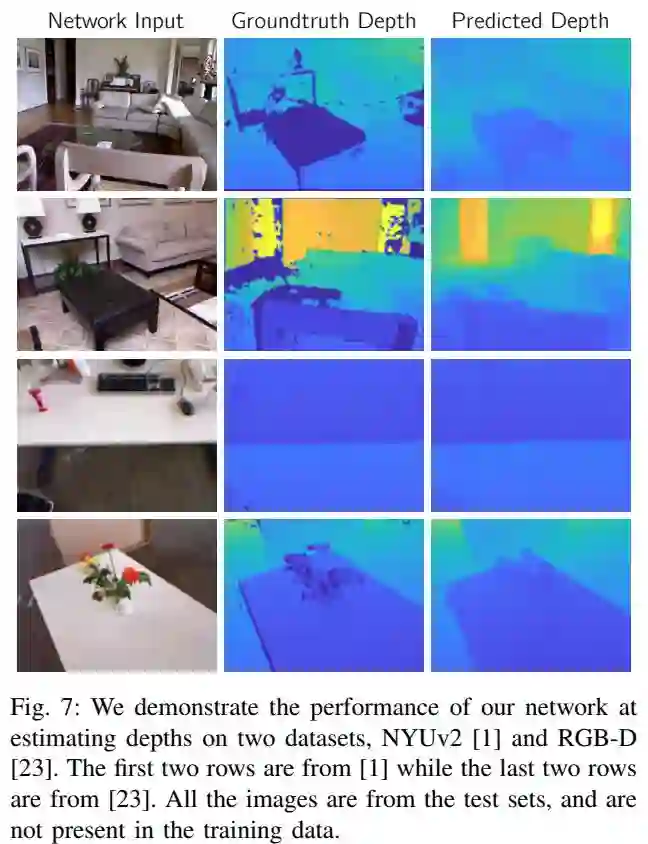

在作者著此论文时,仅完成了这个项目的第一步,实现在移动平台上运行的能力。作者同样通过额外的实验展示了使用大型模型的神经网络可以以“从老师到学生”的知识传输形式被用来训练精确的浓缩模型结构。

Abstract

Since the resurgence of CNNs the robotic vision community has developed a range of algorithms that perform classification, semantic segmentation and structure prediction (depths, normals, surface curvature) using neural networks. While some of these models achieve state-of-the-art results and super human level performance, deploying these models in a time critical robotic environment remains an ongoing challenge. Real-time frameworks are of paramount importance to build a robotic society where humans and robots integrate seamlessly. To this end, we present a novel real-time structure prediction framework that predicts depth at 30 frames per second on an NVIDIA-TX2. At the time of writing, this is the first piece of work to showcase such a capability on a mobile platform. We also demonstrate with extensive experiments that neural networks with very large model capacities can be leveraged in order to train accurate condensed model architectures in a “from teacher to student” style knowledge transfer.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com