【泡泡一分钟】FarSight:从户外图像中实现远距离深度估计

每天一分钟,带你读遍机器人顶级会议文章

标题:FarSight: Long-Range Depth Estimation from Outdoor Images

作者:Md. Alimoor Reza, Philip David and Jana Košecka

来源:2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

编译:明煜航

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

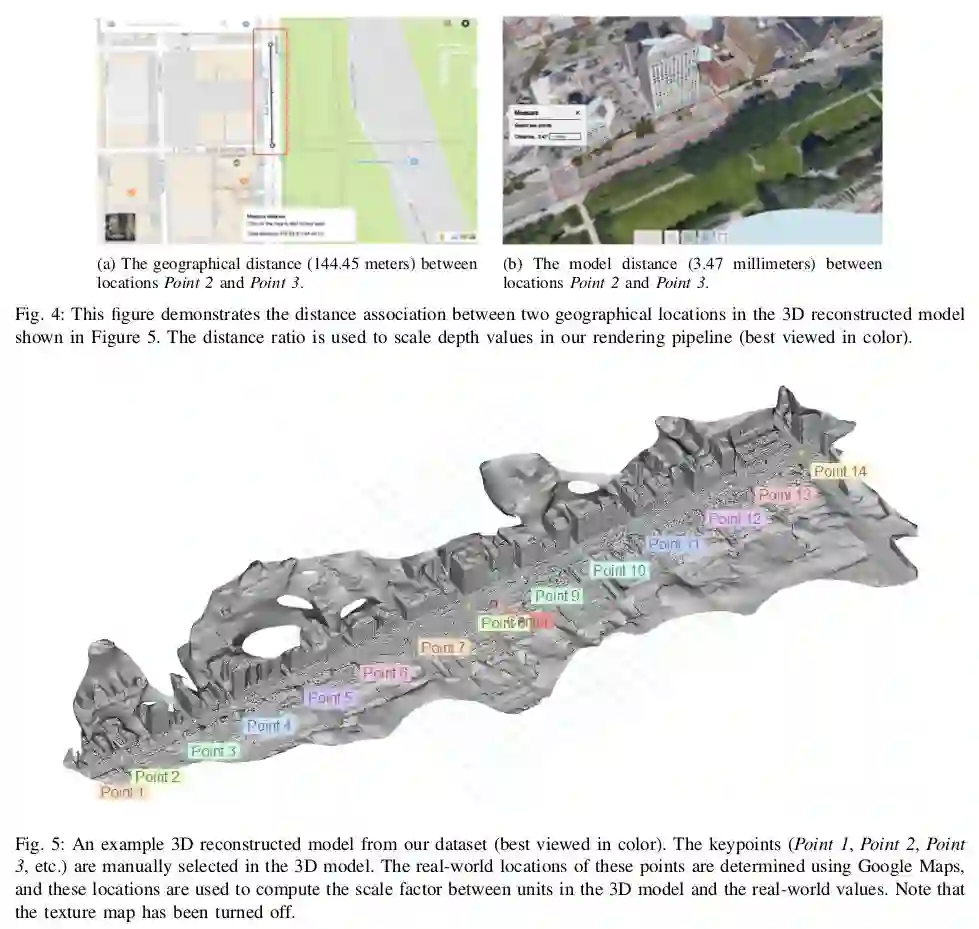

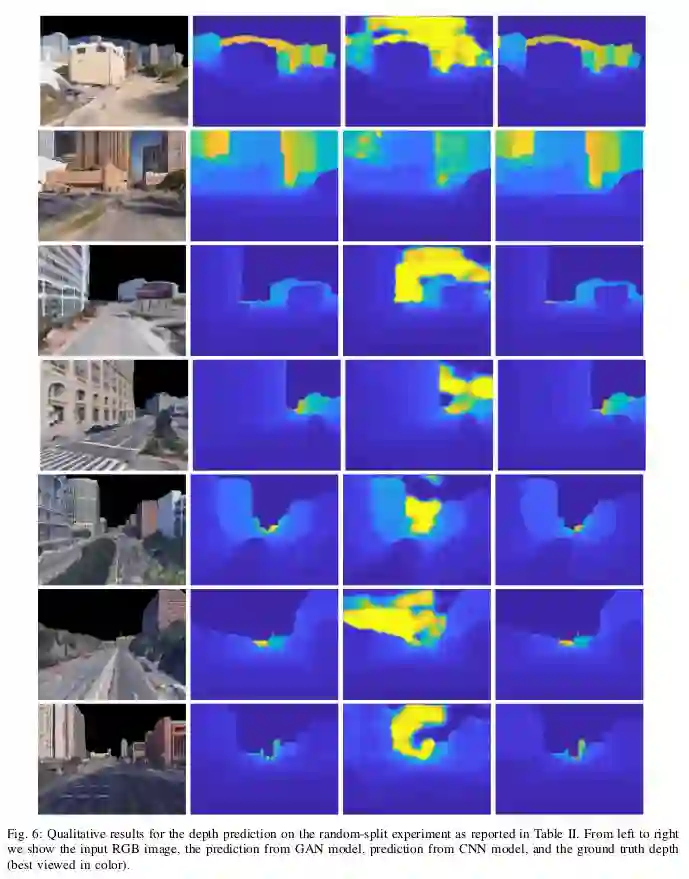

本文研究了远距离的室外城市环境中进行单目深度估计的问题。深度传感器,或传统的深度估计算法(无论双目还是单目)预测的深度范围都限制在室外100米以及室内10米的范围内。也正是由于传感器的限制,使得数据集中缺少远距离的真值,在某种程度上导致了使用基于学习的室外单目方法先天存在缺陷。为了克服这个缺陷,作者首先提出了一种新颖的方法来生成远距离的模拟深度真值数据。作者利用了谷歌地球图像来重建不同城市的大范围且具有合适比例的三维模型。得到的模型库和对应的RGB图像以及远距离的深度渲染一起用作深度估计的训练数据。

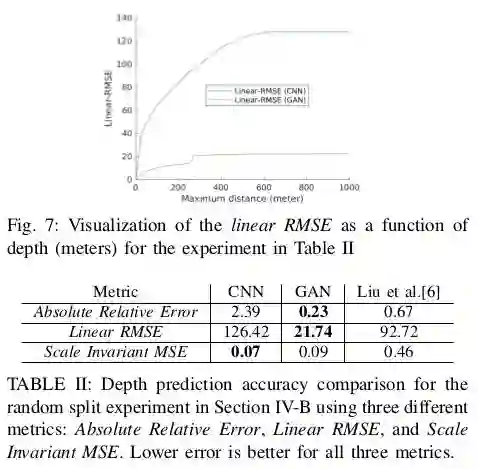

随后作者训练了两个深度神经网络模型来估计远距离的深度值:i) 一个卷积神经网络 (CNN)和 ii) 一个生成对抗网络 (GAN)。作者从他们的实验中发现GAN模型预测的深度值更加精确。作者计划开源特闷的数据可以及极限模型。

Abstract

This paper introduces the problem of long-range monocular depth estimation for outdoor urban environments. Range sensors and traditional depth estimation algorithms (both stereo and single view) predict depth for distances of less than 100 meters in outdoor settings and 10 meters in indoor settings. The shortcomings of outdoor single view methods that use learning approaches are, to some extent, due to the lack of long-range ground truth training data, which in turn is due to limitations of range sensors. To circumvent this, we first propose a novel strategy for generating synthetic long-range ground truth depth data. We utilize Google Earth images to reconstruct large-scale 3D models of different cities with proper scale. The acquired repository of 3D models and associated RGB views along with their long-range depth renderings are used as training data for depth prediction. We then train two deep neural network models for long-range depth estimation: i) a Convolutional Neural Network (CNN) and ii) a Generative Adversarial Network (GAN). We found in our experiments that the GAN model predicts depth more accurately. We plan to open-source the database and the baseline models for public use.

如果你对本文感兴趣,请点击点击阅读原文下载完整文章,如想查看更多文章请关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘提取码:bjy4

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com