【泡泡一分钟】使用双目相机的大尺度直接稀疏视觉里程计—双目DSO

每天一分钟,带你读遍机器人顶级会议文章

标题:Stereo DSO: Large-Scale Direct Sparse Visual Odometry with Stereo Cameras

作者:Rui Wang, Martin Schw¨orer, Daniel Cremers

来源:International Conference on Computer Vision (ICCV 2017)

编译:金顾敏

审核:颜青松 陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

本文基于双目相机提出了一种双目直接稀疏新方法(Stereo DSO)来实现大尺度、高精度实时视觉里程计,该方法在活动窗口内联合优化包括所有关键帧相机的内外参和所选像素的深度值在内的所有模型参数。特别的,我们所提的方法把固定双目的约束整合到多视角双目的BA中。通过从具有足够梯度的图像区域统一采样像素来实现实时优化。定基线双目解决了尺度漂移,同时减轻了常用直接法的光流敏感性和卷帘快门效应。最后,定量的评估显示了在跟踪精度和鲁棒性上,本文所提出的方法方法优于现有的最先进的视觉里程计,而且,该方法较传统的稠密/半稠密直接法相比能够提供更精准尺度的三维重建,较特征点法相比能提供更稠密的重建效果。

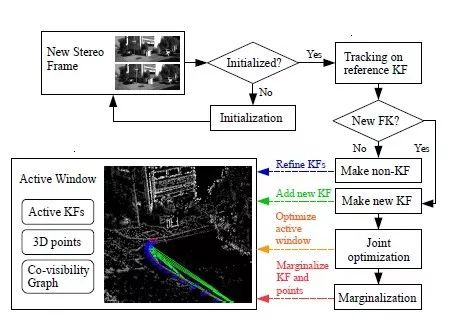

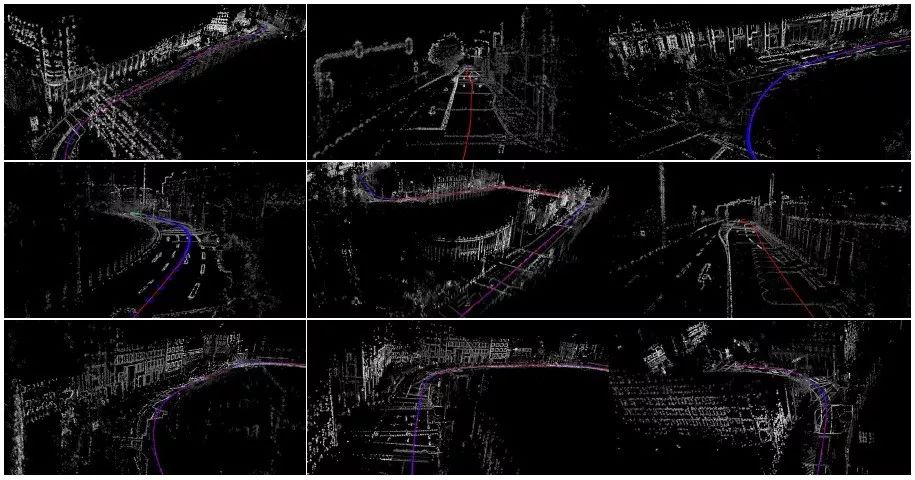

图1 本文算法的框架图

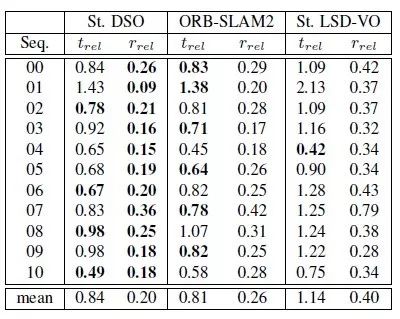

图2 KITTI上精度比较,trel为平移的均方根误差(%),rrel为旋转的均方根误差(degree per 100m).最好的结果由粗体标出。

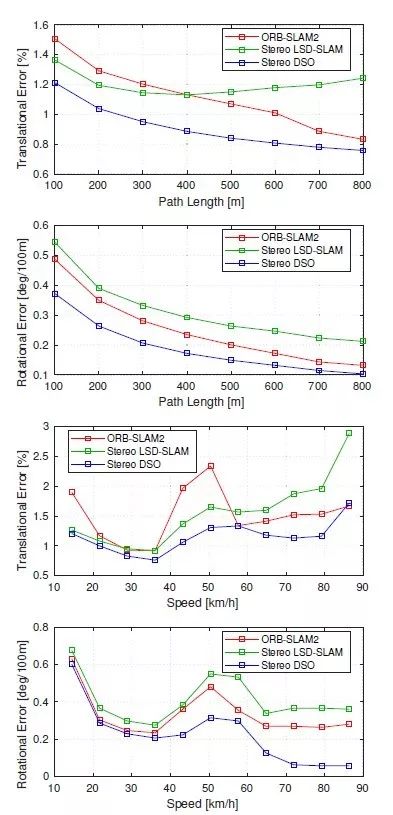

图3 针对KITTI数据集上行车间距(上两张)和行车速度(下两张)的平移和旋转误差。在所有情况中,本文没有回环检测的方法都要优于带回环检测的ORBSLAM2和LSD,令人惊讶的是在大间距下该方法也能取得更好结果,而这种情况下回环通常能明显减小误差。

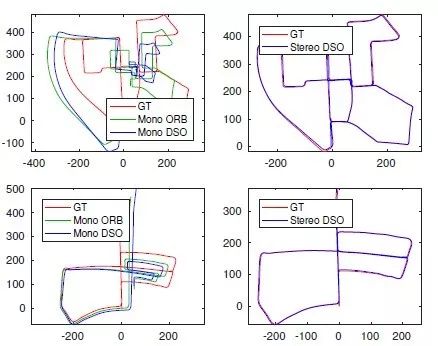

图4 上图为KITTI-00的结果,下图为KITTI-05的结果

图5 在Cityscapes数据集上的效果

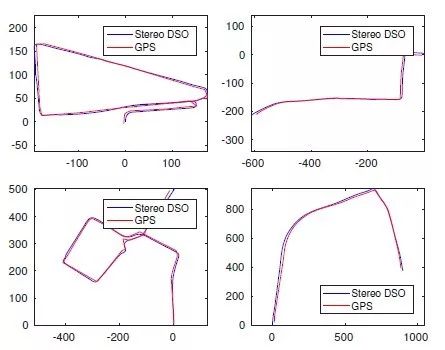

图6 在Cityscapes Frankfurt上的估计轨迹,这些序列是通过将长序列分成5000到6000帧的小的序列间隔。

Abstract

We propose Stereo Direct Sparse Odometry (Stereo DSO) as a novel method for highly accurate real-time visual odometry estimation of large-scale environments from stereo cameras.It jointly optimizes for all the model parameters within the active window, including the intrinsic/extrinsic camera parameters of all keyframes and the depth values of all selected pixels. In particular, we propose a novel approach to integrate constraints from static stereo into the bundle adjustment pipeline of temporal multi-view stereo. Real-time optimization is realized by sampling pixels uniformly from image regions with sufficient intensity gradient. Fixed-baseline stereo resolves scale drift. It also reduces the sensitivities to large optical flow and to rolling shutter effect which are known shortcomings of direct image alignment methods. Quantitative evaluation demonstrates that the proposed Stereo DSO outperforms existing state-of-the-art visual odometry methods both in terms of tracking accuracy and robustness. Moreover, our method delivers a more precise metric 3D reconstruction than previous dense/semi-dense direct approaches while providing a higher reconstruction density than feature-based methods.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com