用于知识跟踪的动态键值记忆网络

原文:Dynamic Key-Value Memory Networks for Knowledge Tracing (WWW2017)

链接:http://papers.www2017.com.au.s3-website-ap-southeast2.amazonaws.com/proceedings/p765.pdf

作者: Jiani Zhang, Xingjian Shi, Irwin King, Dit-Yan Yeung

问题:

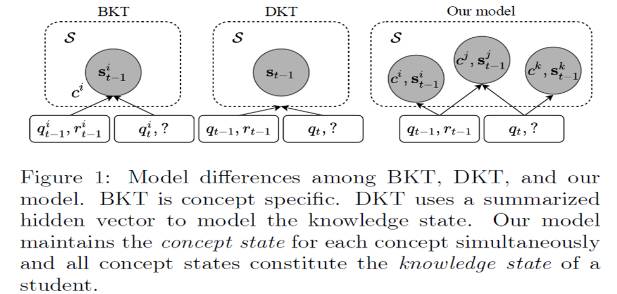

现有的知识跟踪(Knowledge Tracing)方法如Bayesian Knowledge Tracing(BKT)和Deep Knowledge Tracing(DKT)都存在不足;

BKT 对每个概念(技能)建模,无法抓住不同概念之间的联系;并且概念需要预定义,对复杂概念状态的建模能力差。

DKT有很强的表示能力,不需要预定义概念,但是不能指出学生对特定概念的掌握程度。

提出模型:

对现有的memory-augmented neural networks (MANNs)做出改进,提出Dynamic Key-Value Memory Networks (DKVMN)。

MANNs一般使用一个记忆矩阵或两个静态记忆矩阵,DKVMN使用一个Key矩阵和一个Value矩阵。

Key矩阵存放概念表示,Value矩阵存放学生对每个概念的理解掌握程度,并更新。

模型比较:

BKT对每个概念建模,DKT将学生知识状态建模成一个总的隐藏向量;

论文提出的DKVMN对每个概念维护一个概念状态,所有概念状态构成学生的知识状态,

当新练习qt到来时,模型发现qt需要概念ci和cj,于是可以根据概念状态si和sj预测学生对练习qt的答题情况, 然后更新涉及的两个概念状态。

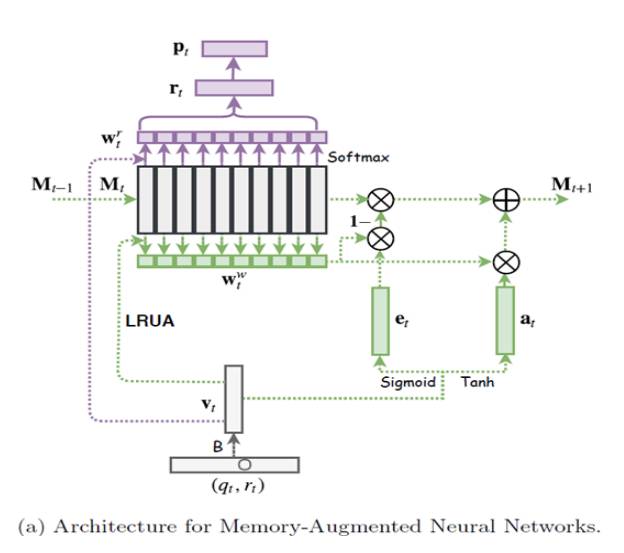

MANNS模型:

紫色部分是读过程,绿色部分是写过程。

由rt计算Pt,即下一时间戳,学生答对每个练习的概率。

擦除信号et和wwt来对记忆矩阵Mt的相关内容,然后用添加信号at将vt加入Mt。

不足:读写操作在同一区域Mt,不能显示地对潜在概念建模;无法跟踪每个概念的知识状态

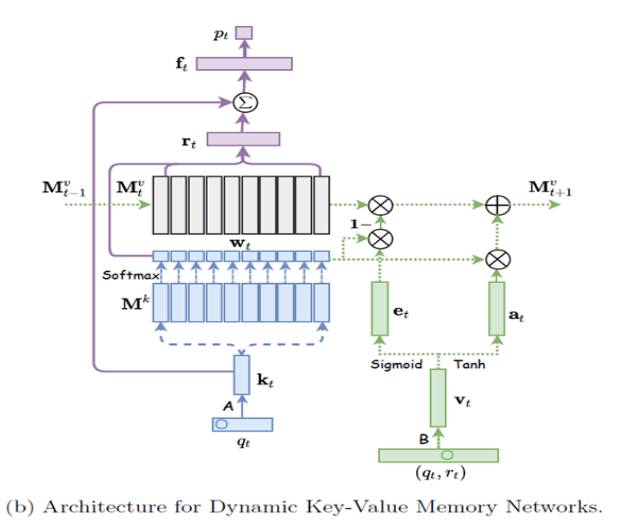

DKVMN模型:

Mk是key矩阵,存放概念表示,Mv是value矩阵,存放学生对每个概念的理解掌握程度,并更新.

wt表示练习和每个隐藏概念的相关程度,ft包含了学生的掌握程度和练习的先验难度。

计算ft时通过全连接层,计算pt时经过另一个全连接层.

同样,擦除信号et和wt来擦除value矩阵Mt的相关内容,然后用添加信号at将vt加入Mt。

先擦除再添加机制保证模拟概念的遗忘和加强过程

实验结果:

1.DKVMN在四个数据集上实验效果优于BKT,BKT+,DKT,MANNS。

2.DKVMN的参数比DKT少。

3.和DKT相比,DKVMN更好的解决了overfitting的问题。

4.能利用不同练习潜在概念间的关系。

5.直接输出学生每个概念的掌握程度。

6.自动发现练习的潜在概念。

7.能描述学生知识状态的变化。