论文 | 基于RNN的在线多目标跟踪

论文:OnLine Multi-Target Tracking Using Recurrent Neural Networks

原文链接:https://arxiv.org/pdf/1604.03635.pdf

无限制环境下的多目标跟踪仍然是一个具有挑战性的任务。即使经过几十年的研究,但跟踪的准确性远远达不到人类的标准。随着近些年来,深度学习的兴起,与多目标跟踪的有关的工作依然很少。这篇文章,我们在实际场景中对多个目标进行在线跟踪迈出了重要的一步。我们实现了一个基于深度学习的端到端的多目标跟踪系统。

2.1 符号约定

•

• D=4,D表示目标的位置信息种类,本文中用到的是目标的bounding box 坐标

• N , 表示跟踪的目标数

•

•

2.2 使用RNN实现多目标跟踪

我们将多目标跟踪问题分解为两个部分,单目标状态的预测和更新,与其他目标的关联。

2.2.1 Target Motion

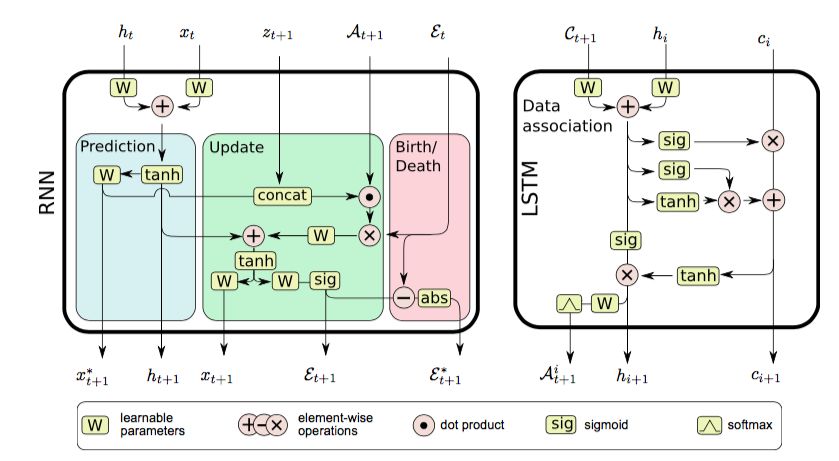

首先我们来看第一个部分,状态的更新与预测。我们使用了下图1所示的时序RNN模型来学习目标的时序动态模型,并依此来决定目标的出现与消失。

图1左边:基于RNN的用于状态预测,状态更新和目标存在概率估计的的模型。 右边:基于LSTM的数据关联模型。

在 t 时刻,RNN输出下个时间步的四个值。矩阵

Prediction 学习一个复杂的动态模型,在没有测量的情况下预测目标运动。

Update 给定目标测量状态的基础上,纠正目标状态分布。

Birth / death 给定目标状态,测量值,数据联系的基础上,学习识别跟踪的启动和终止。

下一帧的预测值

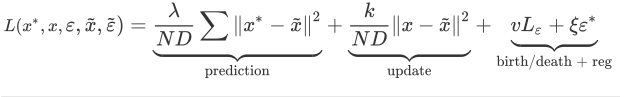

Loss 包含四个部分,首先我们来看前两个部分。假设目标的数量是固定的,我们的目标是学习出预测真实轨迹的模型。这个目标适用于这两种情况,没有测量值的情况下预测目标的运动,以及根据新的测量值来纠正模型。 为此,我们最小化的目标是,状态预测值和状态更新值与真实值之间的均方差(MSE)。

2.2.2 Initiation and Termination

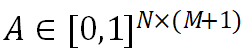

在现实世界中跟踪多个目标可能会出现目标的消失和重新出现。我们通过一个额外的变量来捕获时变的目标数量。这个变量

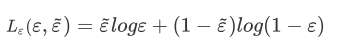

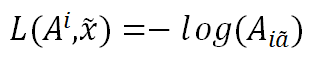

公式三种的后两部分用来学习预测每个目标在某个时刻是否存在。这里我们使用了binary cross entropy(BCE)loss:

单独使用BCE loss 时,RNN将很难做出预测。这将会在跟踪过程中丢失目标。因此,我们添加了一个平滑变量

2.2.3 Data Association with LSTMs

可以说,数据关联(即为每个目标唯一地分类相应测量的任务)是跟踪多个目标的最具挑战性的部分。在本节中,我们提出了一个基于LSTM的架构,能够从训练数据中学习,解决这个问题。我们的模型如图所示,主要思想是利用LSTM的时序功能,一步一步地预测每个目标。

3.1 训练

网络大小

• 状态预测和跟踪管理的RNN网络包含一层和300个隐藏单元。

• 数据关联模块更复杂一点。LSTM模块包含两层和500个隐藏单元。

优化方法

• RMSprop

• 学习率初始为0.0003,随后每20000次迭代降低5%

• 最大迭代次数为200000

• 训练时间单CPU为30个小时

数据

RNN用大约100K的20帧长的序列进行训练。 数据被分成每批10个样品的小批量, 并归一化到图像尺寸 [-0.5,0.5]的范围。 我们试验了更流行的零均值和单位方差数据的正态分布,但是发现基于图像尺寸的固定分辨率数据具有更好的性能。

3.2 实验结果

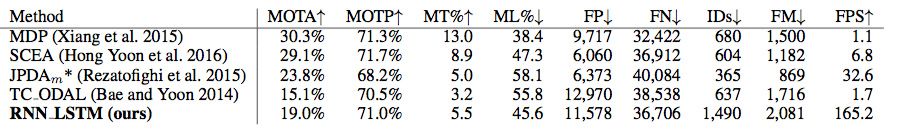

我们在MOT 2015数据集上测试了上述的方法。行人数据集是22个视频序列的集合(训练和测试各11个),这些数据在目标运动,相机运动,视角和人员密度方面都有明显的变化。测试结果如下:

图3 MOT 数据集上目标跟踪测试结果

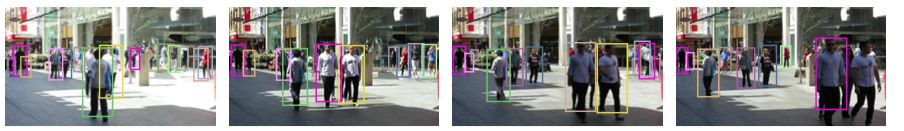

图4 行人跟踪测试结果,不同颜色的框代表不同的人

我们提出了一种基于神经网络的模型来解决现实环境中的数据关联和轨迹估计问题。目前来看,这是首次将递归神经网络应用在实时多目标跟踪中。实验显示,递归神经网络能够学习实际环境中复杂的工作模型。

版权声明:转载文章和图片均来自公开网络,版权归作者本人所有,推送文章除非无法确认,我们都会注明作者和来源。如果出处有误或侵犯到原作者权益,请与我们联系删除或授权事宜。