ICLR 2022:AI如何识别“没见过的东西”?

行早 发自 凹非寺

量子位 | 公众号 QbitAI

这回域外物体检测方向出了一个新模型VOS,合作团队来自威斯康星大学麦迪逊分校,论文已收录到ICLR 2022中。

这一模型在目标检测和图像分类上均达到目前最佳性能,FPR95指标比之前最好的效果还降低了7.87%之多。

要知道深度网络对未知情况的处理一直是个难题。

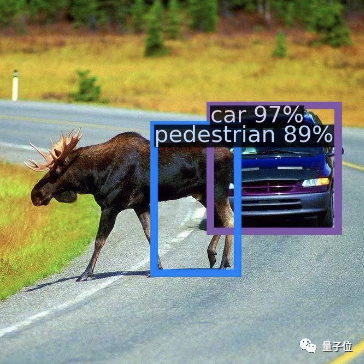

例如在自动驾驶中,识别已知物体(例如汽车、停车标志)的检测模型经常“指鹿为马”,对域外物体(OOD)会产生高置信度的预测。

就像下图中的一头驼鹿,在Faster-RCNN模型下被识别成了行人,还有89%的置信度。

因此域外物体的检测无疑成为了AI安全方面一个很重要的话题。

我们来看看这个模型是怎么对域外物体做出判断的。

VOS如何检测域外物体

在理解VOS之前,不得不提一下域外物体检测困难的原因。

其实也很好理解,毕竟神经网络只是学习训练和测试时的数据,遇到没见过的东西时自然不认识。

为了解决这个问题,得想办法让网络认识“未知”的事物。这怎么办?

VOS想到的办法是,给模型模拟一个域外物体用来学习。

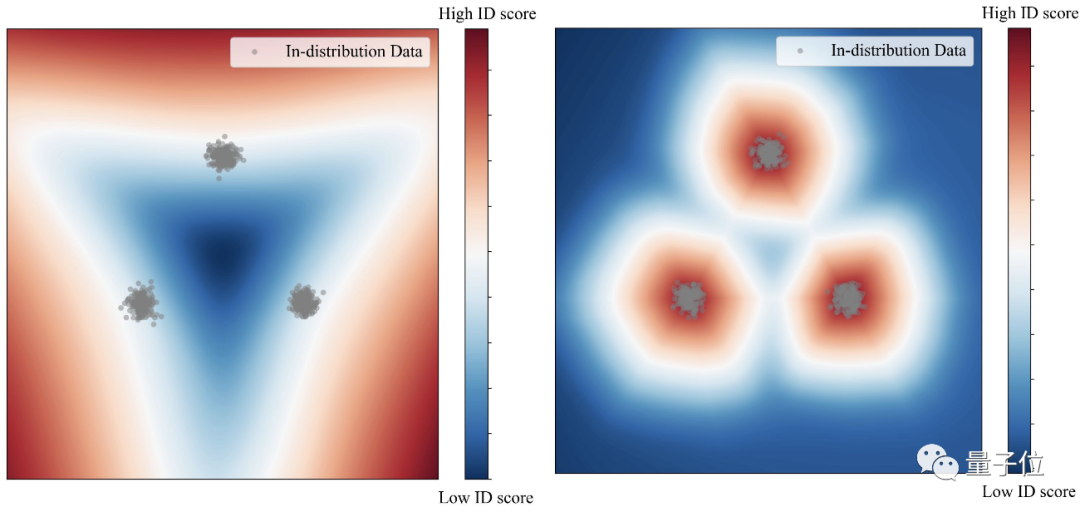

例如下图中的检测情况,其中三团灰点是我们的目标。在没有模拟域外物体时(左),模型只能在大范围内圈住目标。

而在用模拟域外物体训练后(右),模型可以紧凑准确的锁定目标,形成更合理的决策边界。

而一旦目标锁定更精确,只要在这个范围之外,其他物体就可以都判为域外物体。

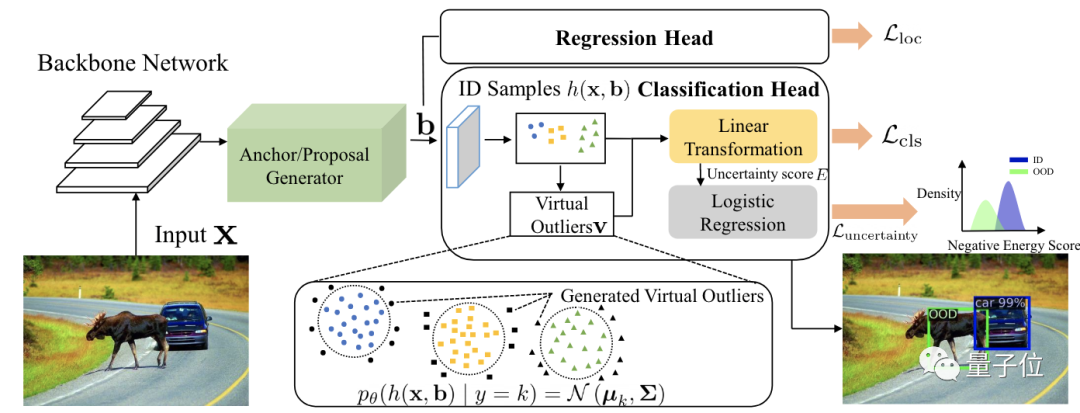

基于这个想法,VOS的团队构建了这样的框架:

以一个Faster-RCNN网络为基础,在分类头中加入一部分模拟域外物体的数据,和训练集中的数据放在一起,共同构建标准化的不确定性损失函数。

而这些模拟域外物体的数据从哪里来呢?在结构图中可以看出,这些点都来自目标区域(蓝色圆点、黄色方点和绿色三角点)周围,也就是低似然区域。

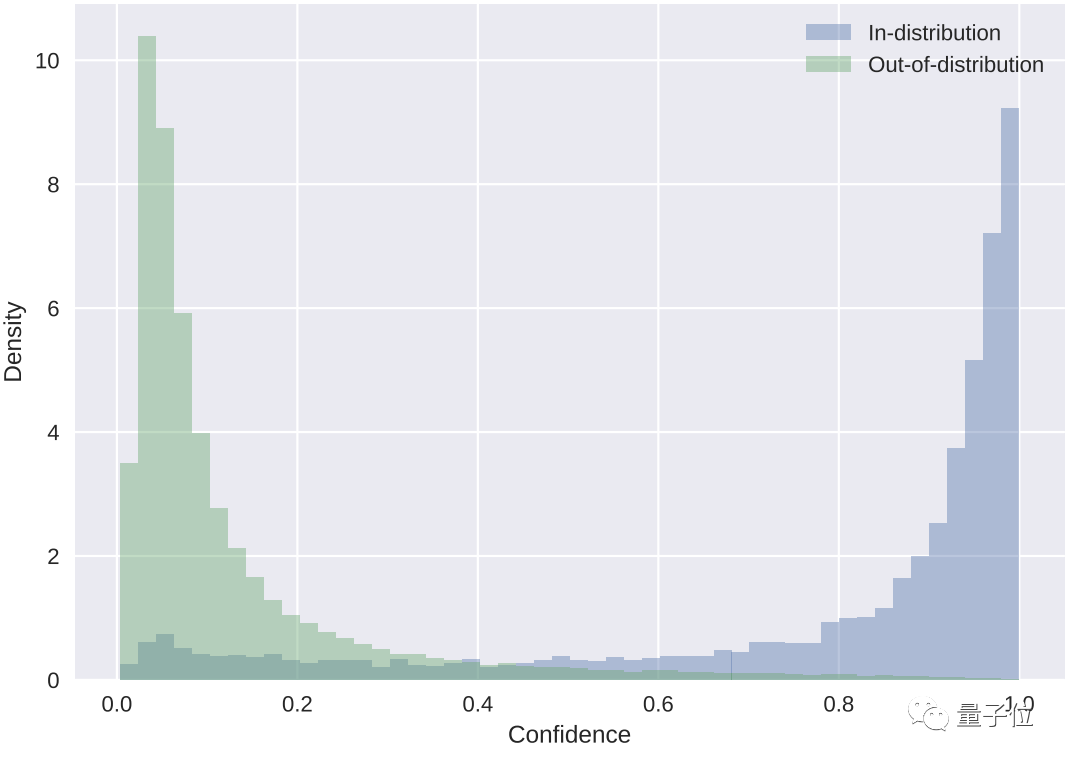

最后根据置信度的计算,蓝色代表目标检测数据,绿色代表域外物体。

以此判断出图像中的车和驼鹿。

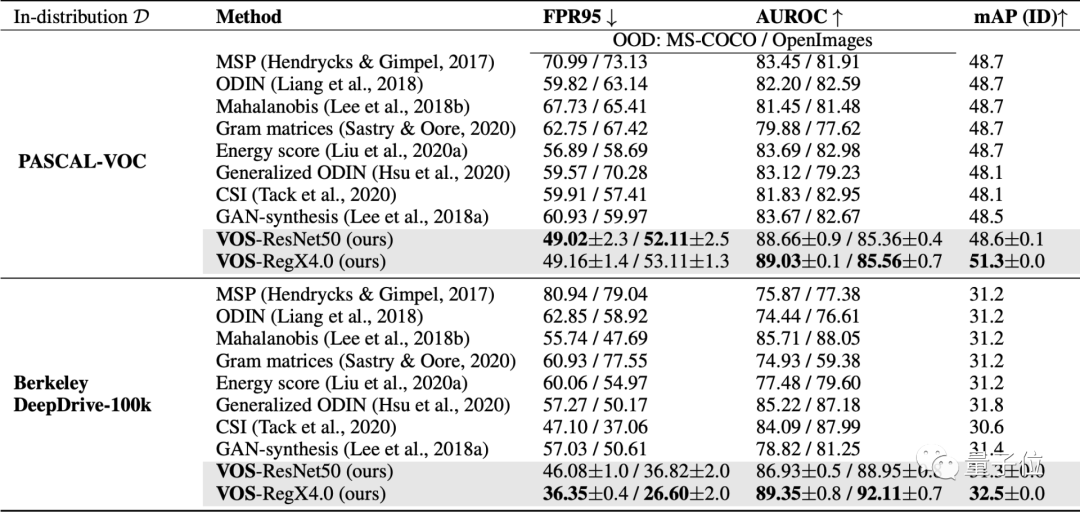

再和许多其他域外物体检测方法做一下比较,就可以看出VOS的优势。

各项指标中箭头向下代表该项数据越小越好,反之代表该项越大越好。

其中FPR95这项最为突出,描述的是OOD样本分类正确率在95%时,OOD样本被错分到ID样本中的概率。

这项成绩相较于之前最好的成绩降了7.87%。

与现有的其他方法相比,也展现出了VOS的优势。

它作为一个通用学习框架,可以适用于目标检测和图像分类两种任务。而之前的方法主要靠图像分类来驱动。

目前该模型已经在GitHub上开源。

作者简介

该模型主要由杜学峰、蔡沐等人提出。

杜学峰本科毕业于西安交通大学,目前在威斯康星大学麦迪逊分校攻读CS博士。

主要研究方向是可信机器学习,包括域外物体检测、对抗鲁棒性、噪声标签学习等。

蔡沐,本科也毕业于西安交通大学,目前为威斯康星大学麦迪逊分校CS博二学生。

研究兴趣集中在深度学习、计算机视觉,尤其是三维场景理解(点云检测)和自监督学习。

该篇论文的通讯作者是Sharon Yixuan Li,目前在威斯康星大学麦迪逊分校任计算机科学助理教授,之前还曾在Facebook AI任研究员。

参考链接:

[1]https://twitter.com/martin_gorner/status/1489671903727915008

[2]https://arxiv.org/abs/2202.01197

[3]https://sites.google.com/view/mucai

[4]https://www.linkedin.com/in/xuefeng-du-094723192/details/experience/

[5]https://github.com/deeplearning-wisc/vos

— 完 —

「智能汽车」交流群招募中!

欢迎关注智能汽车、自动驾驶的小伙伴们加入社群,与行业大咖交流、切磋,不错过智能汽车行业发展&技术进展。

ps.加好友请务必备注您的姓名-公司-职位哦~

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~