抵御「目标检测」的对抗攻击!中山大学HCP实验室提出RobustDet,性能直升17%|ECCV2022 Oral

![]()

新智元报道

新智元报道

【新智元导读】目标检测的对抗攻击怎么防?中山大学HCP实验室入选ECCV 2022 Oral的最新论文教你提升模型鲁棒性!

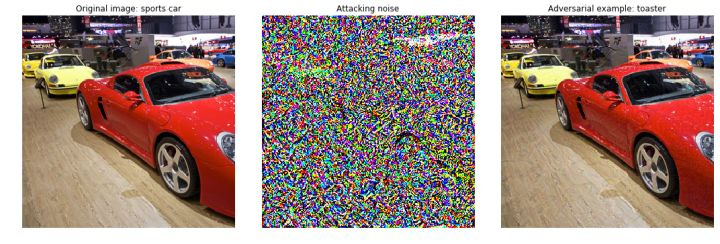

现有的深度学习模型容易受到恶意攻击或者噪声的影响,甚至对于人眼无法察觉的对抗噪声干扰,输出完全错误的结果,这就对基于深度学习的模型在实际中应用带来了严重的安全隐患。

因此提高神经网络的对抗鲁棒性,让模型具有更强的抵御对抗噪声的能力至关重要。

但现有相关对抗攻击和防御的视觉问题研究主要集中在分类任务,而对目标检测器的对抗鲁棒性相关研究工作非常少。

最近中山大学人机物智能融合实验室科研团队在ECCV 2022上发表了一篇论文,深入地探索目标检测器的检测鲁棒性瓶颈问题,分析目标检测对抗训练中正常样本和对抗样本的冲突问题。

论文地址:https://arxiv.org/abs/2207.06202

项目地址:https://github.com/7eu7d7/RobustDet

文中并提出RobustDet(adversarially-aware robust object detector)框架,极大地提升了检测器的对抗鲁棒性。

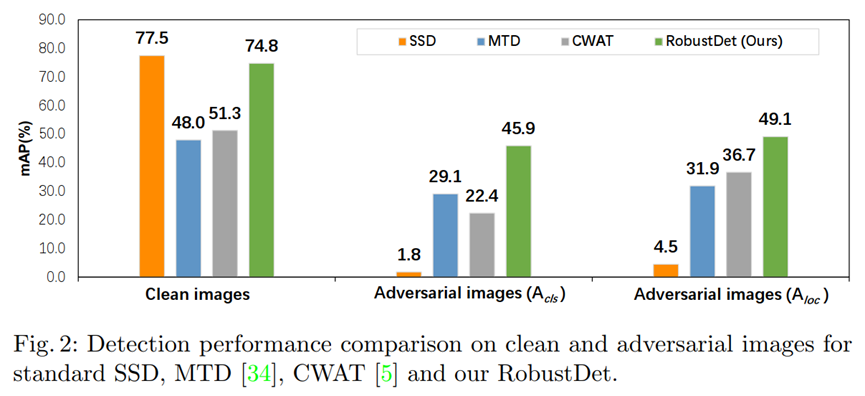

在几乎不损失正常样本检测性能的前提下,对抗样本mAP检测性能提升了17%(针对分类损失的攻击)和12%(针对定位损失的攻击)。

目前该工作已入选ECCV Oral论文(接收比例2.7%),相关代码已开源。

对抗鲁棒性瓶颈

对抗鲁棒性瓶颈

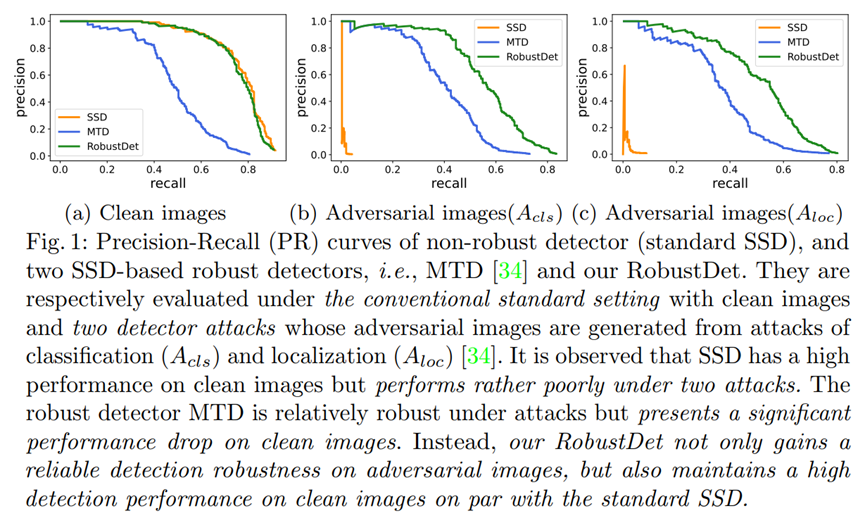

在基于现有目标检测器SSD的对抗鲁棒性研究中发现,检测任务中模型的对抗鲁棒性存在明显的瓶颈问题,这与分类任务有所不同。具体来讲,在分类任务中,常用的对抗训练几乎不会使模型对正常样本的识别能力下降太大,并且模型在对抗样本上的性能和正常样本的性能也只有10%左右的差距。

而典型的目标检测器存在对抗瓶颈问题:目标检测器在对抗训练后,不仅会较大程度损失识别正常样本的能力(接近30%),而且也只能获得有限的鲁棒性(对抗样本对比正常样本:模型检测性能相差近50%)。这意味着,在目标检测器对抗训练学习时,正常样本和对抗样本的学习可能存在冲突,模型难以同时学好两种样本。

为了验证这一假设,研究人员进行了相关实验和验证。

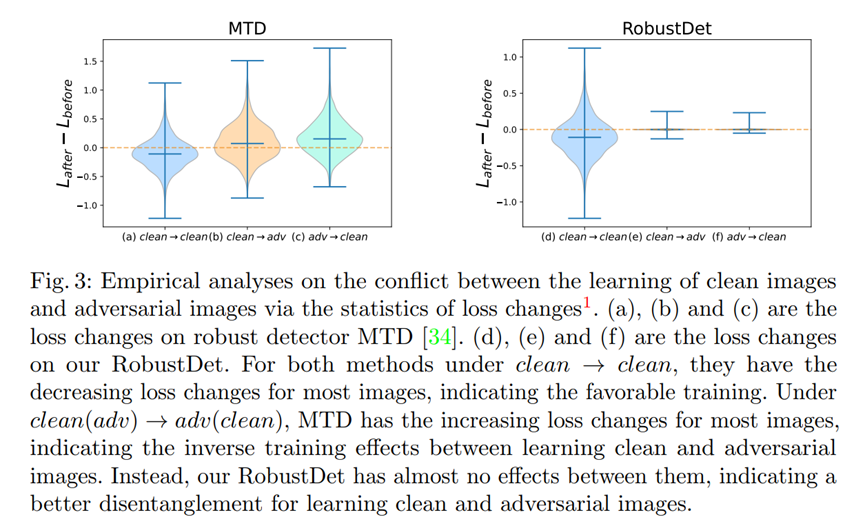

让一个对抗训练得到的鲁棒目标检测器继续学习m步的对抗样本或正常样本,大多数情况都会使另一种样本的loss增加;而学习m步正常样本则大多情况都会让其他的正常样本loss降低。

也就是说一个对抗训练得到的鲁棒模型,在进一步学习正常样本时,会使得检测对抗样本的性能下降,进一步学习对抗样本也会使检测正常样本的性能下降。这可以从loss变化的角度有效的证明目标检测器在学习正常和对抗样本时存在冲突。

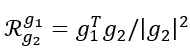

从loss变化的层面可以验证冲突的存在,而从梯度层面则可以进一步解释冲突。定义样本间梯度的纠缠度为

实验结果可以看到对抗样本和正常样本的梯度具有较高的纠缠度,这也就说明学习一种样本便会对另一种样本产生较强的干扰,从而导致冲突。

在一个理想的鲁棒模型中,模型应当同时学会了正常样本和对抗样本相同的特征以及独有的特征。两种图像的共享特征应该得到很好的学习,只有处理特定特征的部分仍然需要强化。

这样的模型继续学习两种样本时梯度都不应与另一种样本有较高纠缠度,因为共同的特征已经学好,进一步学习的主要是两种样本独有的特征。有较高的梯度纠缠度则说明模型没有足够的能力解耦两种样本独有的特征及其梯度。在学习一种图像时,不可避免地会对另一种图像产生影响,从而导致检测的鲁棒性瓶颈。

RobustDet

RobustDet

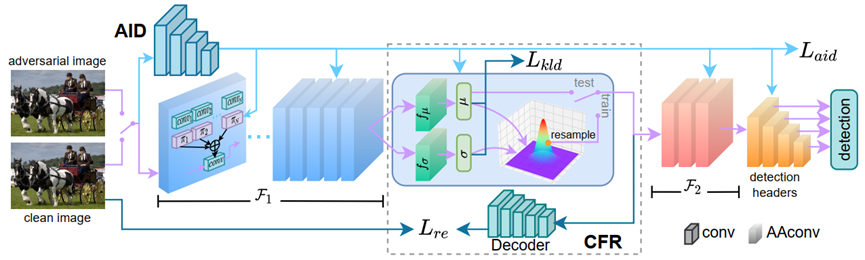

基于上一节中对于目标检测对抗鲁棒性瓶颈问题的分析,该论文提出RobustDet框架来缓解目标检测对抗训练中正常样本和对抗样本学习的冲突。

RobustDet通过对抗样本判别器(AID,Adversarial Image Discriminator)引导的对抗感知卷积(AAconv,Adversarially-Aware Convolution),来自适应的用不同权重处理不同的样本,其中AID根据图像上的对抗噪声来为AAconv生成权重。

同时受VAE启发,文章更进一步,为模型添加重建到正常样本的约束,来进一步促进模型学习更加鲁棒的特征。

Adversarially-Aware Convolution (AAconv)

正常样本和对抗样本的冲突客观存在,我们应当承认目标检测器的这一缺陷,并在此基础上思考解决方案,而不是让模型强行对齐两种样本。

为了缓解对抗样本和正常样本的冲突,文章提出了AAConv来自适应的为正常样本和对抗样本学习不同的动态卷积核。

借助动态卷积的思想,AAConv构建几组不同的卷积核并根据与输入图像相关的权重对这些卷积核加权,权重则由(AID)根据输入的图像得到。

Adversarial Image Discriminator (AID)

对抗样本和正常样本的权重应具有不同的分布,并且这两个分布要有一定间距,以保证不会因为对抗攻击而给出错误的权重。

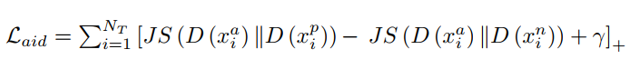

错误的权重会产生错误的卷积核,这对目标检测器是致命的。因此AID的鲁棒性便至关重要,还需要添加额外的监督约束,文章为AID添加Triplet Loss( )以使其显式的学习区分对抗样本和正常样本,为两种样本生成尽可能不同的权重。

其中,两个样本的距离度量采用JS散度,

Consistent Features with Reconstruction (CFR)

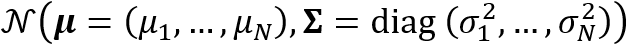

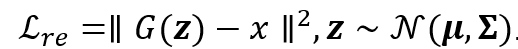

为了进一步减少对抗噪声的负面影响,文章借鉴VAE的思想为模型添加了重建约束。对模型中的某一个特定层,理想情况它在对抗样本上输出的特征图应处于以正常样本特征为中心的多元高斯分布中。假设这一高斯分布的协方差矩阵为对角阵:

则更好的做法不是直接预测这一特征图,而是预测它所处分布的均值

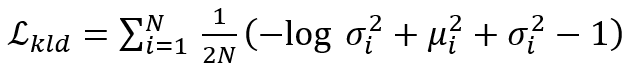

其中,同时G表示解码器模型。参考VAE的相关理论,为了防止预测的分布坍缩,还需要添加额外的约束:

实验结果

实验结果

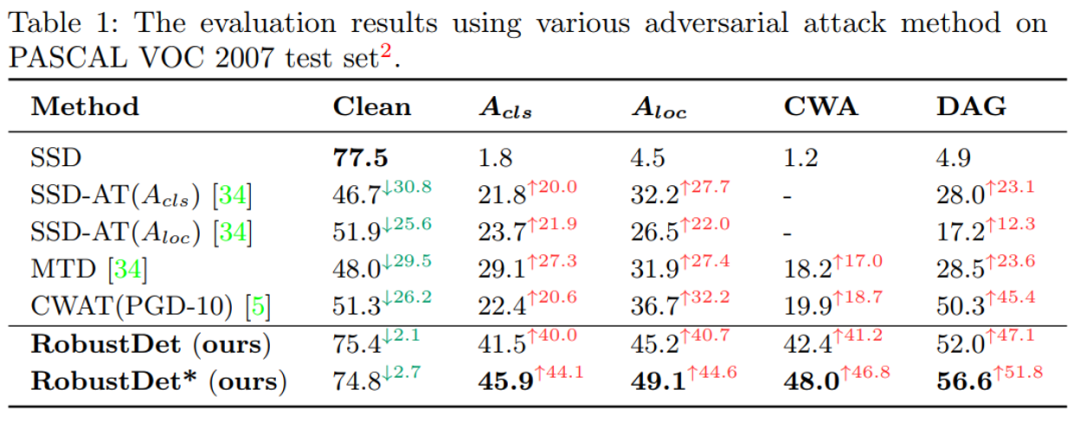

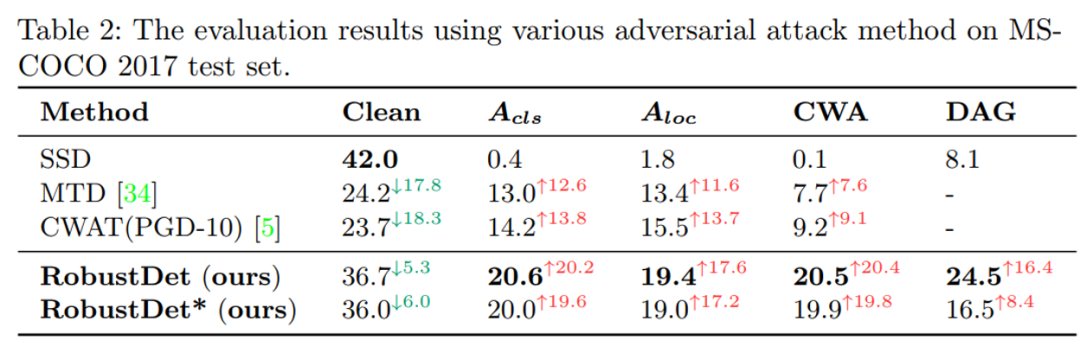

在实验中,文章将提出的RobustDet与现有方法在PASCAL VOC和MS-COCO两个数据集上分别进行了对比,并进行了消融实验证明

文章将所提方法与现有SOTA方法对比,在VOC和COCO上RobustDet相比于其他方法在正常上只会损失微小的性能。

在针对分类的攻击上,VOC提升了17%以上,COCO提升了6%以上。在针对定位的攻击上,VOC提升了12%以上,COCO提升了4%以上。在其他一些训练中没见过的攻击上也可以表现出较强的泛化能力。

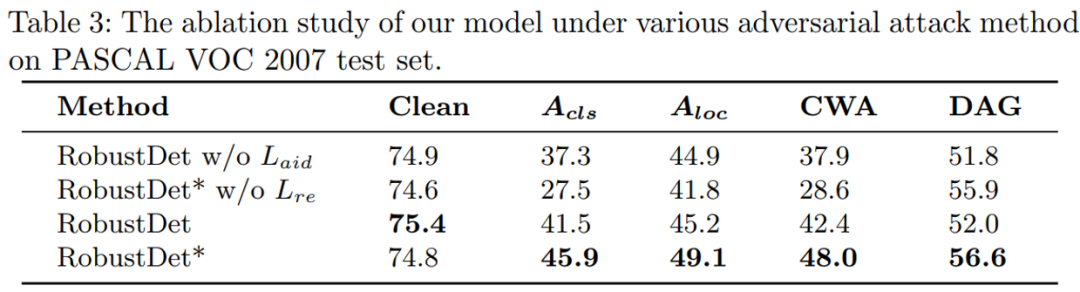

文章也同样分析了各模块的必要性。在去掉

结论

结论

文章围绕目标检测器的对抗鲁棒性深入探索了目标检测鲁棒性瓶颈,即目标检测器在对抗训练后不仅无法获得足够的鲁棒性,并且会损失大量识别正常样本的性能。

该工作通过损失值变化和梯度相关性来实验证明,正常样本和对抗样本在目标检测对抗训练中的冲突是导致鲁棒性瓶颈的重要原因之一。

为了缓解该冲突,文章提出RobustDet模型,通过AID根据图像的对抗扰动来针对不同类型的样本为AAconv生成不同的权重,以自适应地处理不同类型的图像。

在此基础上,RobustDet还提出添加重建约束,让动态模型对两种样本提取的特征通过一个静态的解码器,都能被尽可能解码为对应的正常样本,以促进AAconv学习更加鲁棒的特征。

最终的实验表明RobustDet可以非常有效的缓解目标检测鲁棒性瓶颈,在几乎不损失正常样本识别性能的前提下,提升模型的对抗鲁棒性。

实验室简介