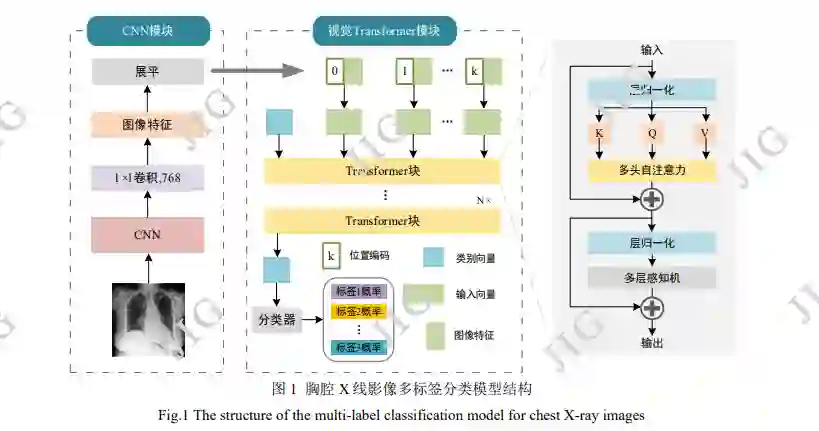

目的 基于计算机的胸腔X线影像疾病检测和分类目前存在误诊率高,准确率低的问题。拟在视觉Transformer(Vision Transformer,ViT)预训练模型的基础上,通过迁移学习方法,实现胸腔X线影像辅助诊断,提高诊断准确率和效率。方法 选用带有卷积神经网络(Convolutional Neural Networks,CNN)的ViT模型,其在超大规模自然图像数据集中进行了预训练;通过微调模型结构,使用预训练的ViT模型参数初始化主干网络,并迁移至胸腔X线影像数据集中再次训练,实现疾病多标签分类。结果 在IU X-Ray数据集中对ViT迁移学习前、后模型平均AUC(area under ROC curve)得分进行对比分析实验。结果表明,预训练ViT模型平均AUC得分为0.774,与不使用迁移学习相比提升0.208。并针对模型结构和数据预处理进行了消融实验,对ViT中的注意力机制进行了可视化,进一步验证了模型有效性。最后使用Chest X-Ray14和CheXpert数据集训练微调后的ViT模型,平均AUC得分为0.839和0.806,与目前其他方法相比分别有0.014至0.031的提升。结论 与前人的方法相比,ViT模型胸腔X线影像的多标签分类精确度更高,且迁移学习可以在降低训练成本的同时提升ViT模型的分类性能和泛化性。消融实验与模型可视化表明,包含CNN结构的ViT模型能重点关注有意义的区域,高效获取胸腔X线影像的视觉特征。

http://www.cjig.cn/jig/ch/reader/view_abstract.aspx?flag=2&file_no=202203170000002&journal_id=jig

胸腔X线影像作为放射科重要的筛查和诊断手 段,在临床医学中应用广泛。目前胸腔X线影像的 阅片大多依赖放射科医生人工观察,且胸部疾病 的种类繁多,病理特征多样,快速准确的阅片工 作对医生专业知识和临床经验具有一定要求(Shi 等,2020)。另外,医生的诊断存在主观性,长时 间高负荷工作又容易导致医生的疲劳,误诊和漏 诊的现象时有发生。

基于计算机的胸腔X线影像多标签分类方法可 以自动检测和识别潜在的一种或多种疾病,是辅 助医生临床诊断的有效手段。然而与自然图像相 比,不同影像间具有高度相似性,异常区域在占 比小、表征复杂(Pan等,2013),且单张影像中 可能存在多发性疾病,甚至多种疾病,给病灶的 准确筛查和判别造成了困难。近年来,随着人工 智能在医学领域的应用(Shiraishi等,2011),基于 卷积神经网络(Convolutional Neural Networks , CNN)的深度学习模型对局部细节信息尤为敏 感,能够提取丰富的图像特征,尤其是通过自然 图像的迁移学习,取得了很多有益成果。如:Abbas等人(2021)使用CNN模型,通过迁移学习 实现了基于胸腔X线影像的新冠肺炎、正常、 SARS三标签分类任务,分类准确率达98.23%。Rahman等人(2020)针对AlexNet(Krizhevsky等, 2012 )、ResNet18(He 等, 2016 )、DenseNet201 ( Huang 等 , 2017 ) 和 SqueezeNet ( Iandola 等 , 2016)四个在自然图像中预训练CNN模型使用迁 移学习,对胸腔X线影像正常、病毒性肺炎、细菌 性肺炎进行分类,四个模型准确率分别为88.4%、 88.7%、93.3%和86.1%。CheXNet(Rajpurkar等, 2017)通过迁移学习微调DenseNet121模型(Huang 等,2017),使用14种疾病标签标注的11万张胸腔 X线影像数据集ChestX-Ray14(Wang等,2017) 训练多标签分类模型,取得了0.845的AUC得分。然而CNN使用的卷积核存在感受视野受限的缺 陷,缺乏对影像整体信息的把握,且提取的图像 特征中包含了背景、肌肉、骨骼等冗余信息,对 多标签分类性能产生了一定影响。为 此 , 有 学 者 将 基 于 注 意 力 机 制 的 视 觉 Transformer ( Vision Transformer , ViT ) (Dosovitskiy等,2020)结构应用于医学影像任 务,辅助CNN提取图像特征,Transformer能够同 时捕捉整张影像中的全部信息,且注意力机制的 结构有助于模型重点 关注有意义区域。如, TransUNet(Chen等,2021)最先将Transformer与 U-Net(Ronneberger等,2015)编码器结合,用于 医学影像分割,使编码器能够获取上下文信息, 取得了良好的效果。CoTr3D(Xie等,2021)使用 基于CNN和Transformer的结构分割三维医学影 像,性能得到了实质性提升。TransMed模型(Dai 等,2021)首先利用CNN对核磁共振影像进行特征 提取,然后使用基于DeiT(Touvron等,2021)的 小型Transformer模型完成影像中肿块良恶性分 类,使模型能够同时捕捉低层次特征和跨通道的 高层次特征,最终达到88.9%的准确率。CNN与 Transformer相结合的模型在医学影像领域展现了 出色性能。然而Transformer摆脱了CNN依赖的局 部相关性和权值共享两个归纳偏置限制,在达到 更高精度的同时,也增加了模型训练难度。

由此可见,目前针对单一疾病分类任务的精 度已经接近甚至超过医生水平,而针对多种疾病 的多标签分类任务的研究相对较少,且受病人隐 私、人工标注成本高等因素影响,胸腔X影像数据 量有限(Chen等,2021),基于Transformer的模型 在胸腔X影像多标签分类性能还有较大提升空间。为此,拟开展针对ViT预训练模型的胸腔X线影像 多标签分类研究,通过自然图像数据集的预训练 和模型微调,使用训练好的参数初始化模型,在 胸腔X线影像数据集中再次训练。经对比分析迁移 学习前后的模型性能以及模型可视化,验证模型 的有效性以及ViT模型在医学影像领域的有效性。