【泡泡图灵智库】用于手持式SLAM系统的互补感知方法(ICRA-40)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Complementary Perception for Handheld SLAM

作者:Thomas Lowe, Soohwan Kim and Mark Cox

来源:ICRA2018

播音员:申影

编译:彭锐

审核:李建华

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——一种用于手持式SLAM系统的互补感知方法,该文章发表于ICRA 2018。

我们提出了一种构建一般3D环境地图的新方法,在这样的环境中,高效的几何或视觉信息不是任何地方都保证的,并且设备运动与手持式系统一样是无约束的。连续时间的SLAM算法以互补的方式集成了激光雷达、摄像头和惯性测量单元,所有的传感器均为优化提供约束。我们提出的算法旨在扩大可构图的环境区域,因而提高了通用移动构图的可靠性和实用性。该算法的一个关键组成部分是深度的不确定性与视觉特征的结合,这对于噪声表面是有效的,并且允许具有和不具有深度估计的特征以统一的方式建模。结果表明,在具有挑战性的环境中本文的方法比目前最好的基于激光或者视觉的SLAM方法有更大的构图范围。

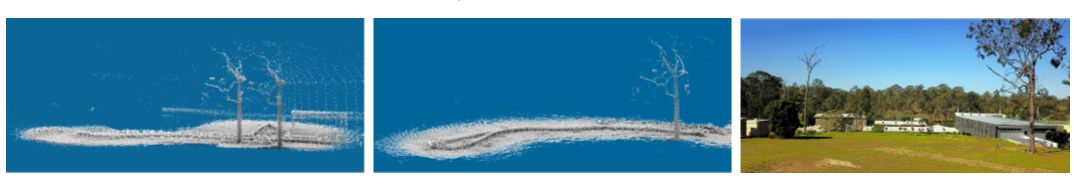

图1 本文方法的SLAM效果展示(中),左图为激光雷达和惯组SLAM结果。场景范围约60米,几何上比较稀疏,真实场景图(右)表明阳光很强。

主要贡献

本文的主要贡献是:

1、提出一种同时利用三种传感器测量值的连续时间轨迹估计公式。

2 、提出一类通过深度不确定性进行参数化的广义视觉特征对应的约束。

3 、提出一种新的估计特征深度和深度不确定性的方法。

4 、将本文方法在六个涵盖了较差几何信息或者视觉信息的数据集上与最先进的技术进行了对比。

算法流程

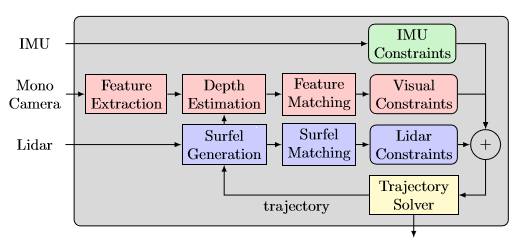

图2 本文算法流程图

本文算法流程:

1、提取视觉特征。

2 、估计特征深度。

3 、视觉特征匹配。

4 、更新视觉约束。

主要结果

本文的主要实验结果如下:

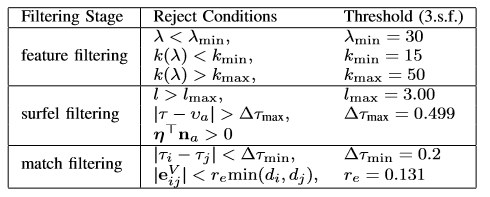

表1为用于视觉约束的滤波方法介绍。

表1 用于视觉约束的滤波方法

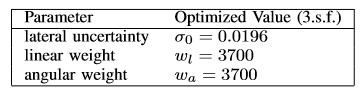

表2为本文方法视觉特征的参数。

表2 视觉特征参数

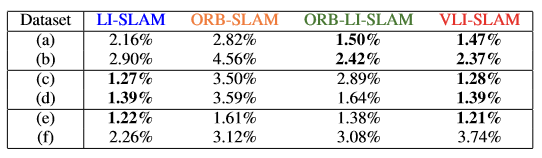

表3为不同方法在不同环境中性能的定量分析。

表3 不同方法在图3中不同环境下的收敛情况对比

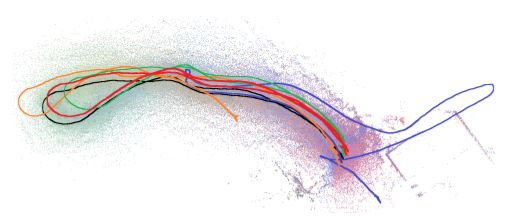

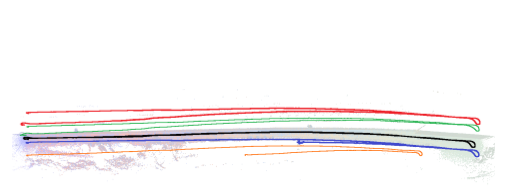

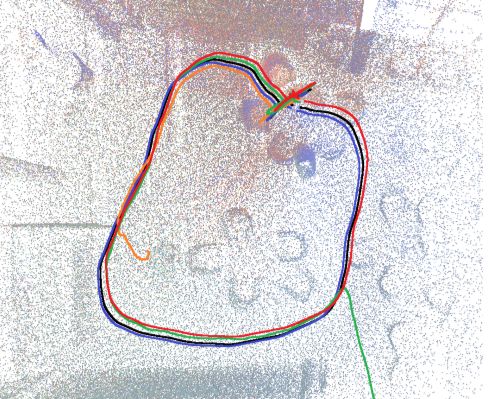

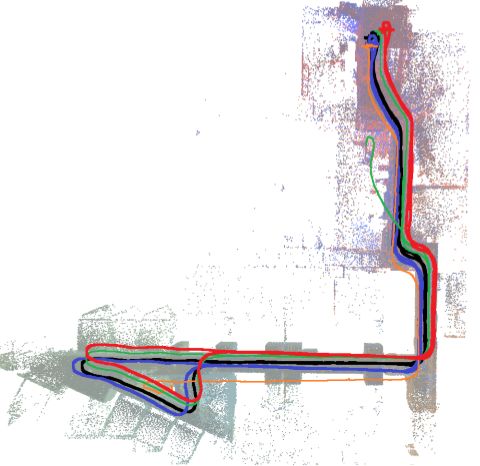

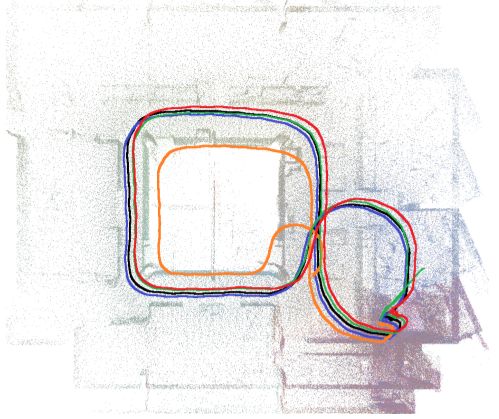

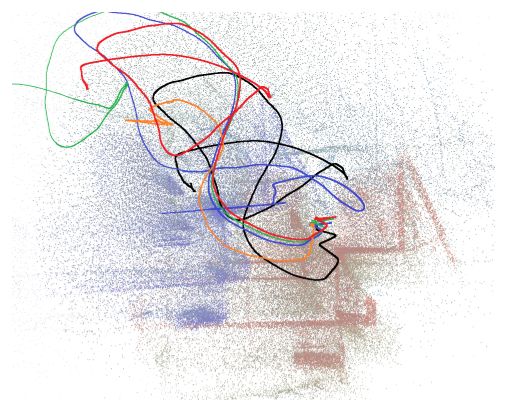

图3为不同方法在不同环境下表现的定性对比结果。其中蓝色线条表示LI-SLAM、橙色线条表示ORB-SLAM、绿色线条表示ORB-LI-SLAM、红色线条表示VLI-SLAM。

图3(a) 平坦的户外,雷达信息弱,视觉特征丰富

图3(b) 长自行车道,雷达信息弱,视觉特征丰富

图3(c) 室内白色墙面餐厅,雷达信息丰富,视觉信息弱

图3(d) 办公室,雷达信息丰富,局部视觉信息弱

图3(e) 办公室内步行,雷达信息丰富,视觉信息丰富

图3(f) 办公室内快速运动,雷达信息弱,视觉信息弱

本文算法在两个传感器处于完全不一样的状态下表现最好,此时二者特征密度不是正相关。 视觉和激光雷达在这一方面是较好的选择,但是增加额外的传感器,例如雷达或者超声波,能在该领域进一步提高。

Abstract

We present a novel method for mapping general 3D environments, where sufficient geometric or visual information is not everywhere guaranteed and where the device motion is unconstrained as with handheld systems. The continuous-time SLAM algorithm integrates a lidar, camera and inertial measurement unit in a complementary fashion where by all sensors contribute constraints to the optimization.The proposed algorithm is designed to expand the domain of mappable environments and therefore increase the reliability and utility of general purpose mobile mapping. A key component of the proposed algorithm is the incorporation of depth uncertainty into visual features, which is effective for noisy surfaces and allows features with and without depth estimates to be modeled in a unified manner. Results demonstrate a wider mappable domain on challenging environments compared to state-of-the-art lidar or vision based localization and mapping algorithms.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com