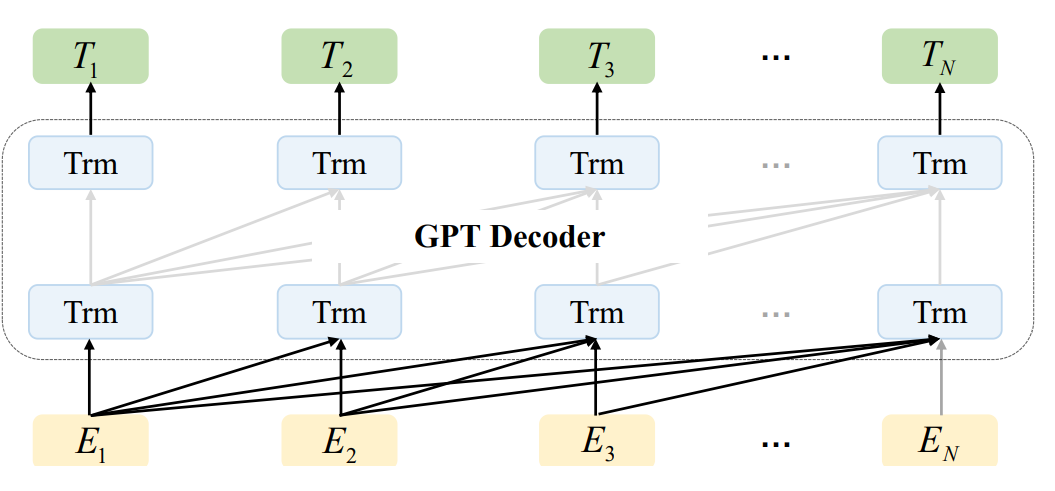

预训练基础模型(PFMs)被视为具有不同数据模态的各种下游任务的基础。预训练的基础模型,如BERT、GPT-3、MAE、DALLE-E和ChatGPT,在大规模数据上进行训练,为广泛的下游应用提供了合理的参数初始化。**PFMs背后的预训练思想在大型模型的应用中起着重要的作用。**作为一种迁移学习范式,预训练通过冻结和微调技术应用于计算机视觉,显示出良好的性能。词向量在自然语言处理中也可以看作是修饰词的一种,但它存在多义词等问题。与之前应用卷积和循环模块进行特征提取的方法不同,生成预训练(GPT)方法应用Transformer作为特征提取器,并以自回归范式在大型数据集上进行训练。类似地,BERT应用transformer在大型数据集上作为上下文语言模型进行训练。最近,ChatGPT在大型语言模型上显示出可喜的成功,它应用了零样本或很少提示的自回归语言模型。随着PFMs的非凡成功,人工智能在过去几年中在各种领域掀起了浪潮。文献中提出了相当多的方法,数据集和评估指标,需要更新的综述。

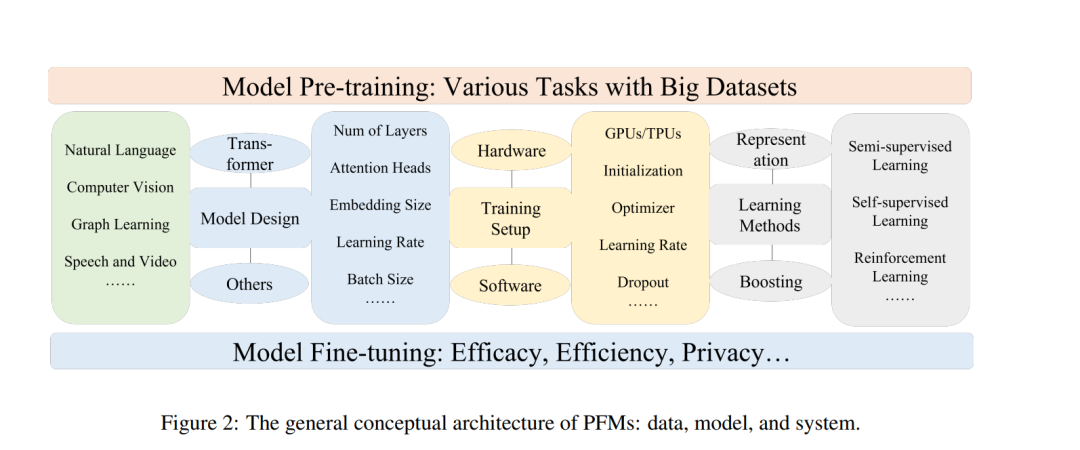

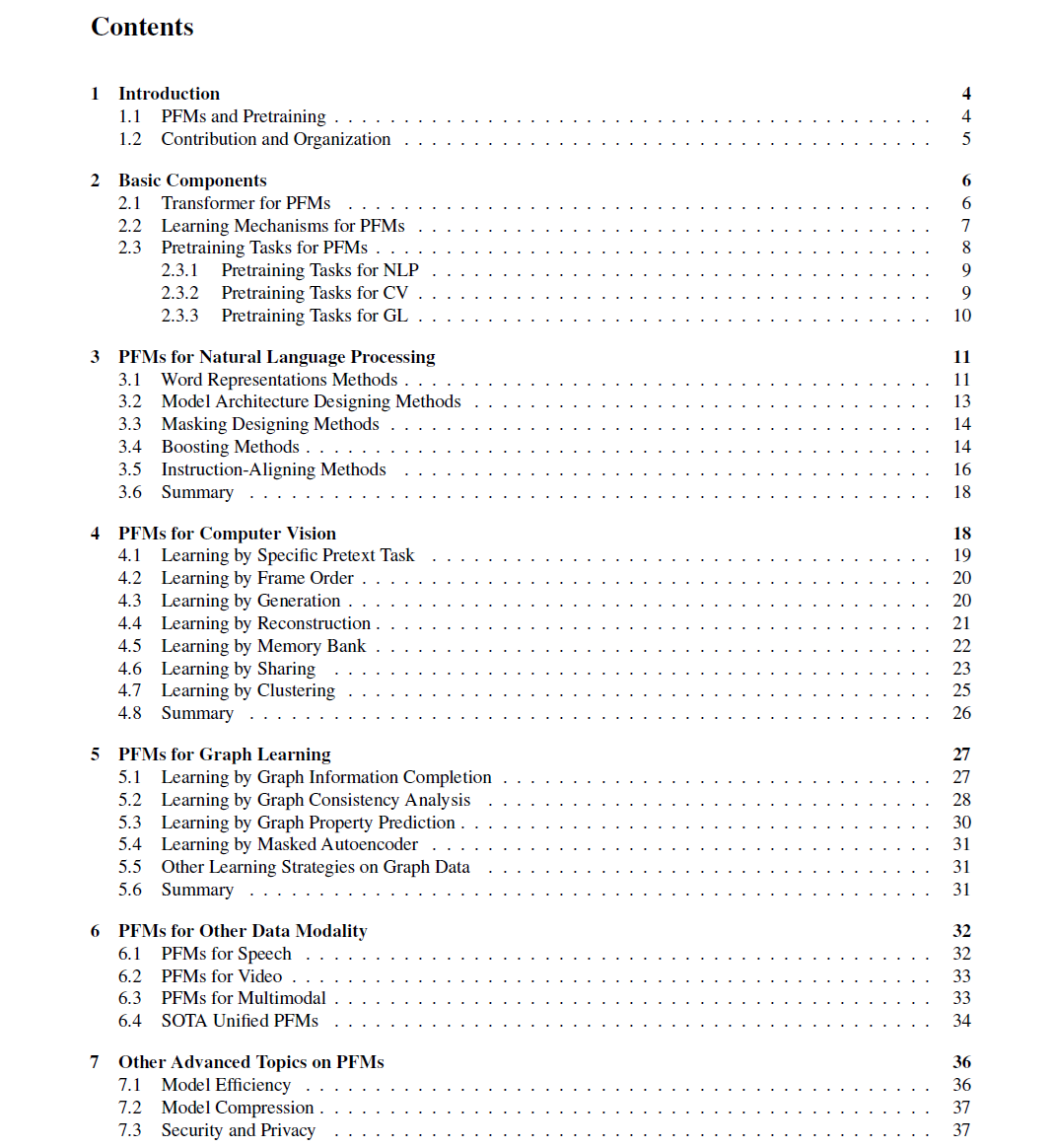

**本研究全面回顾了文本、图像、图以及其他数据模态中PFMs的最新研究进展、当前和未来挑战和机遇。**首先回顾了自然语言处理、计算机视觉和图学习中的基本组成部分和现有的预训练。然后讨论针对其他数据模态的其他高级PFMs,以及考虑数据质量和数量的统一PFMs。此外,还讨论了PFM的相关研究,包括模型效率与压缩、安全与隐私。最后,总结了关键意义、未来研究方向、挑战和开放问题。希望对PFMs在可扩展性、推理能力、跨域能力、用户友好交互能力、安全与隐私保护能力等方面的研究有所启发。

https://www.zhuanzhi.ai/paper/9345ff120bd8f1b703c1c9324c321dd9

1. 引言

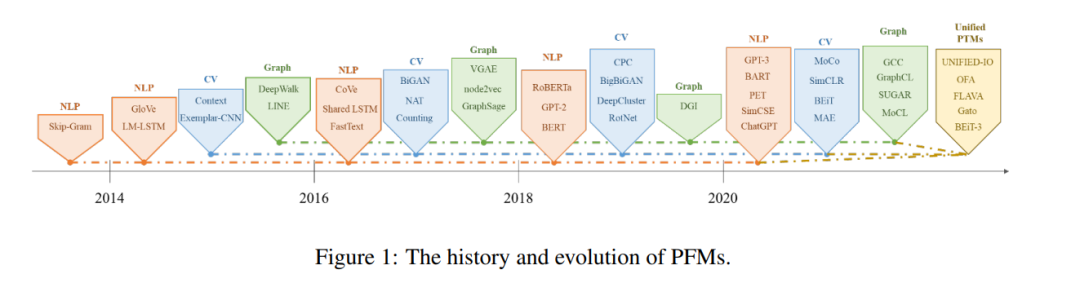

预训练基础模型(PFMs)是大数据时代人工智能(AI)必不可少的重要组成部分。基础模型首先在[1]中命名,这意味着更广泛的模型类及其功能。在人工智能的三大领域(自然语言处理(NLP)[2]、计算机视觉(CV)[3]和图学习(GL)[4])中,PFM被广泛研究。**PFM是强大的通用模型,在各种领域或跨领域都是有效的。它们在各种学习任务中表现出了学习特征表示的巨大潜力,如文本分类[5]、文本生成[6]、图像分类[7]、目标检测[8]和图分类[9]。**PFMs在使用大规模语料库对多个任务进行训练,并将其微调到类似的小规模任务方面表现出优越的性能,使启动快速数据处理成为可能。**PFMs基于预训练技术,该技术旨在使用大量数据和任务训练一个通用模型,这些数据和任务可以在不同的下游应用程序中轻松地进行微调。**预训练的思想源于CV任务中的迁移学习[10]。认识到预训练在CV领域的有效性,人们开始在其他领域使用预训练技术来提高模型性能。当预训练技术应用于NLP领域时,训练有素的语言模型(lm)可以捕获对下游任务有益的丰富知识,如长期依赖关系、层次关系等。此外,在NLP领域进行预训练的显著优势在于,训练数据可以来自任何未标记的文本语料库,即预训练过程中有无限数量的训练数据。早期的预训练是一种静态技术,如NNLM[11]和Word2vec[12],但静态方法难以适应不同的语义环境。因此,提出了动态预训练技术,如BERT[13]、XLNet[14]等。图1描述了NLP、CV和GL领域PFMs的历史和演变。基于预训练技术的PFMs利用大规模语料库学习通用语义表示。随着这些开创性工作的引入,各种PFMs已经出现并应用于下游任务和应用。

**ChatGPT是PFM应用的一个很好的例子。ChatGPT是对生成式预训练transformer GPT-3.5进行微调的,它是在文本和代码的混合上进行训练的[15,16]。**ChatGPT应用了来自人类反馈的强化学习(RLHF)[17,18],这已经成为将大型语言模型与人类意图[19]相结合的一种有希望的方法。ChatGPT令人惊讶的优越性能可能会导致每种类型PFM训练范式的转变——应用指令对齐技术,如强化学习(RL)、提示调整[20,21,22]和思维链[23,24],向人工通用智能发展。重点介绍了文本、图像和图形的PFMs,这是一个比较成熟的研究分类。对于文本,它是一个多用途的语言模型,用于预测序列中的下一个单词或字符。例如,PFMs可用于机器翻译、问答系统、主题建模、情感分析等。对于图像,它类似于文本上的PFMs,使用巨大的数据集来训练一个适用于许多CV任务的大模型。对于图,类似的预训练思想也被应用于获得pfm,用于许多下游任务。除了特定数据域的PFMs,还回顾和介绍了其他一些先进的PFMs,如语音、视频和跨领域数据的PFMs,以及多模态PFMs。此外,还出现了一种处理多模态的PFMs大收敛,即所谓的统一PFMs。首先定义了统一PFMs的概念,然后回顾了近年来SOTA统一PFMs的最新研究进展(如OFA[25]、UNIFIED-IO [26]、FLAVA[27]、BEiT-3[28]等)。

**根据现有PFMs在这三个领域的特点,我们得出PFMs具有以下两个主要优势。**首先,需要轻微的微调来增强模型在下游任务上的性能。第二,PFMs已经在质量方面进行了综述。我们可以将PFMs应用于与任务相关的数据集,而不是从头开始构建模型来解决类似的问题。PFMs的巨大前景激发了大量相关工作,以关注模型效率、[29]、安全性[30,31,32]和压缩[33,34]等。

有一些综述研究[35,8,5,6,7,1]回顾了一些特定领域的预训练模型,如文本生成[6],视觉transformer[7],目标检测[8]。Bommasani出版社。[1]总结了基础模型的机会和风险。然而,现有工作没有在预训练任务、效率、功效和隐私等不同方面对不同领域(如CV、NLP、GL、语音、视频)的PFMs进行全面的回顾。在本次调查中,我们专门跟踪了NLP领域的PFMs的演变,以及预训练是如何转移到CV和GL并被采用的。与其他调查相比,我们没有对这三个领域现有的PFMs进行全面介绍和分析。与以往预训练模型的综述不同,本文总结了现有的模型,从传统模型到pfm,以及这三个领域的最新工作。传统模型强调静态特征学习。动态PFMs介绍了结构,这是目前的主流研究。进一步介绍了一些针对PFMs的其他研究,包括其他先进和统一的PFMs、模型效率和压缩、安全性和隐私。最后,总结了不同领域未来的研究挑战和开放问题。全面介绍了附录F和附录g中的相关评价指标和数据集。总结而言,本文的主要贡献如下:

本文对PFM在NLP、CV和GL中的发展进行了扎实和最新的综述。在这篇综述中,讨论和提供了关于三个主要应用领域中的通用PFM设计和预训练方法的见解。

我们总结了PFMs在其他多媒体领域(如语音和视频)的发展。此外,还讨论了PFMs的前沿问题,包括统一PFMs、模型效率与压缩、安全与隐私等。

通过对不同任务的不同模态的PFMs的回顾,讨论了大数据时代超大模型未来研究的主要挑战和机遇,这指导了基于PFMs的新一代协作和交互智能。