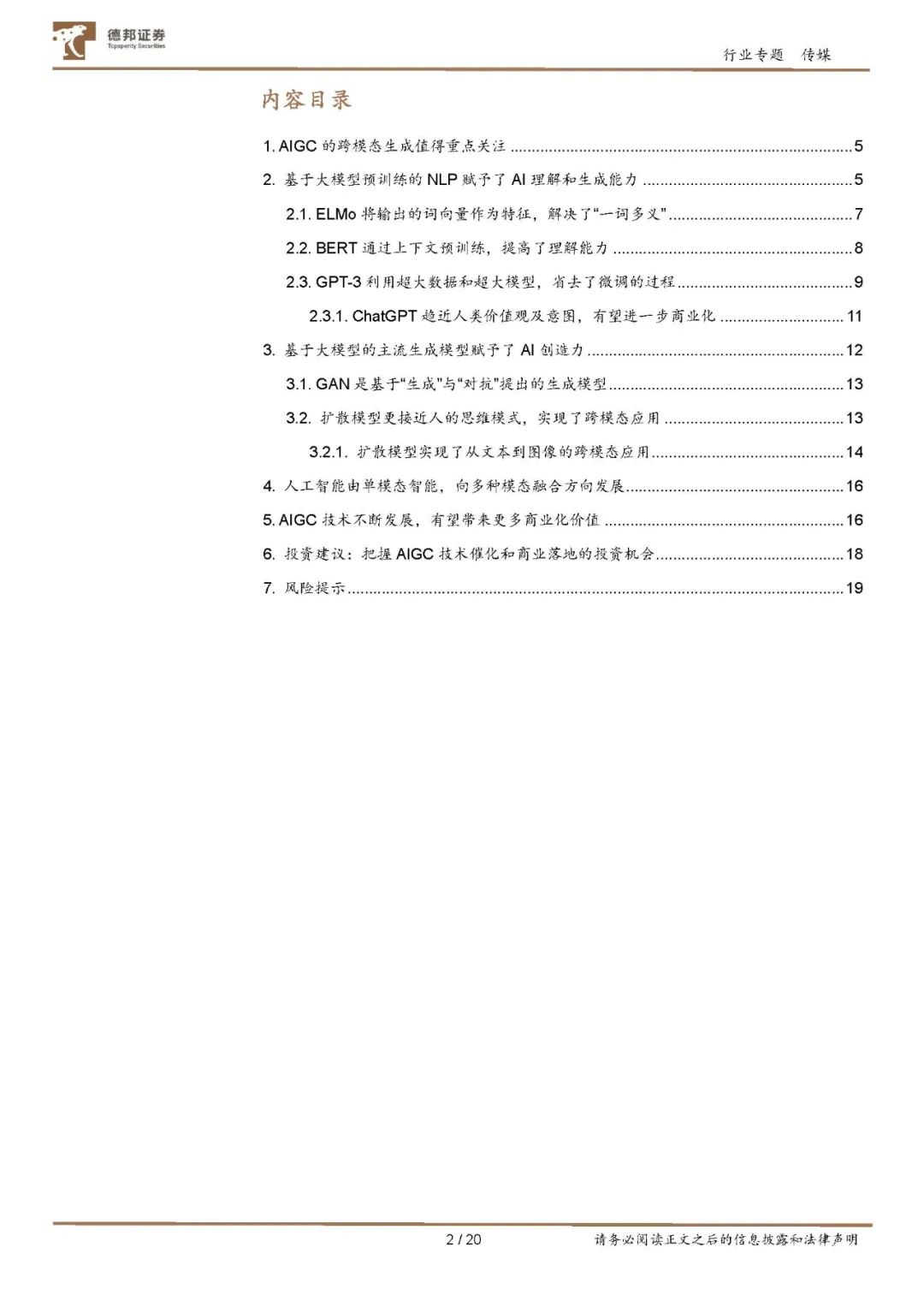

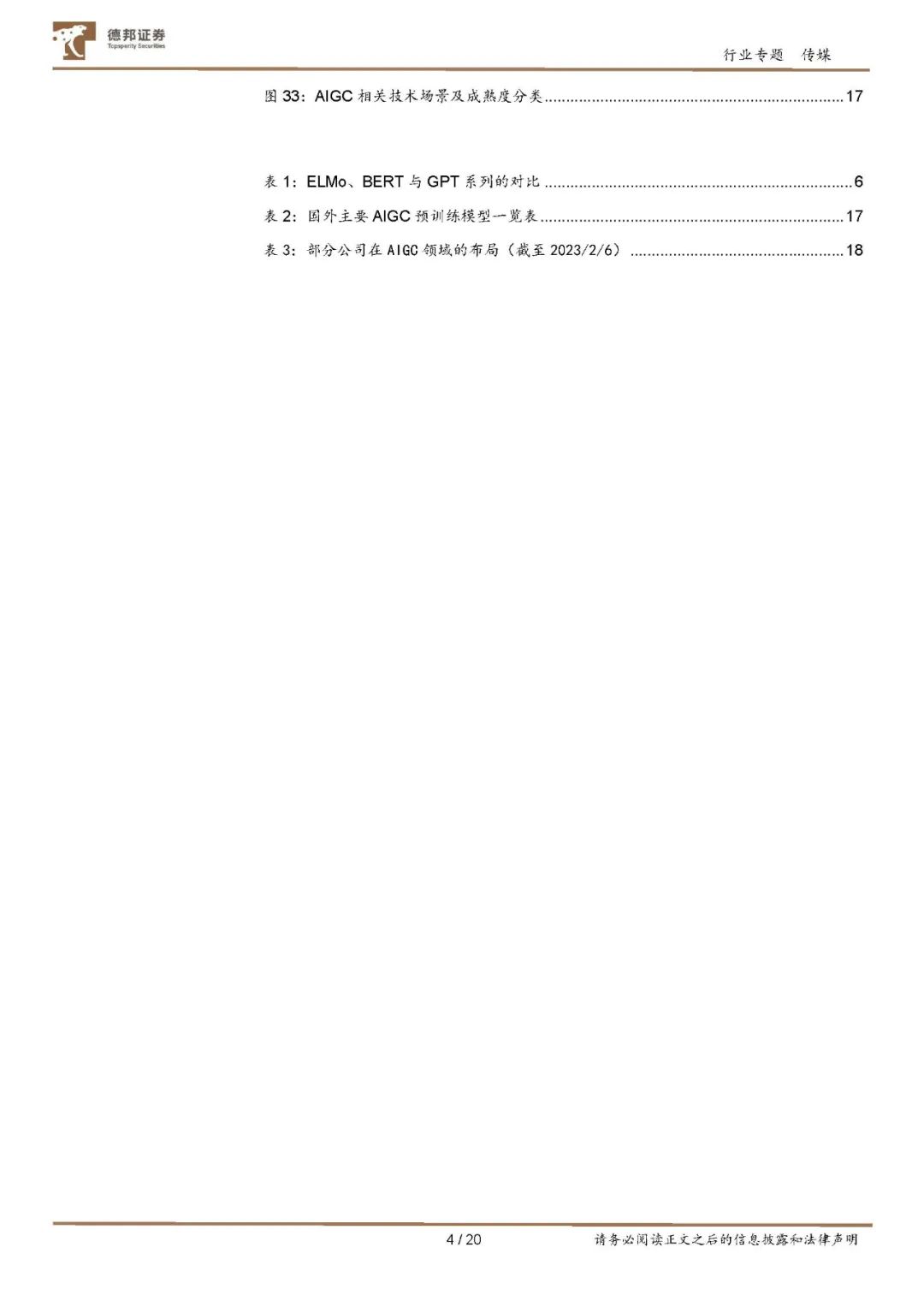

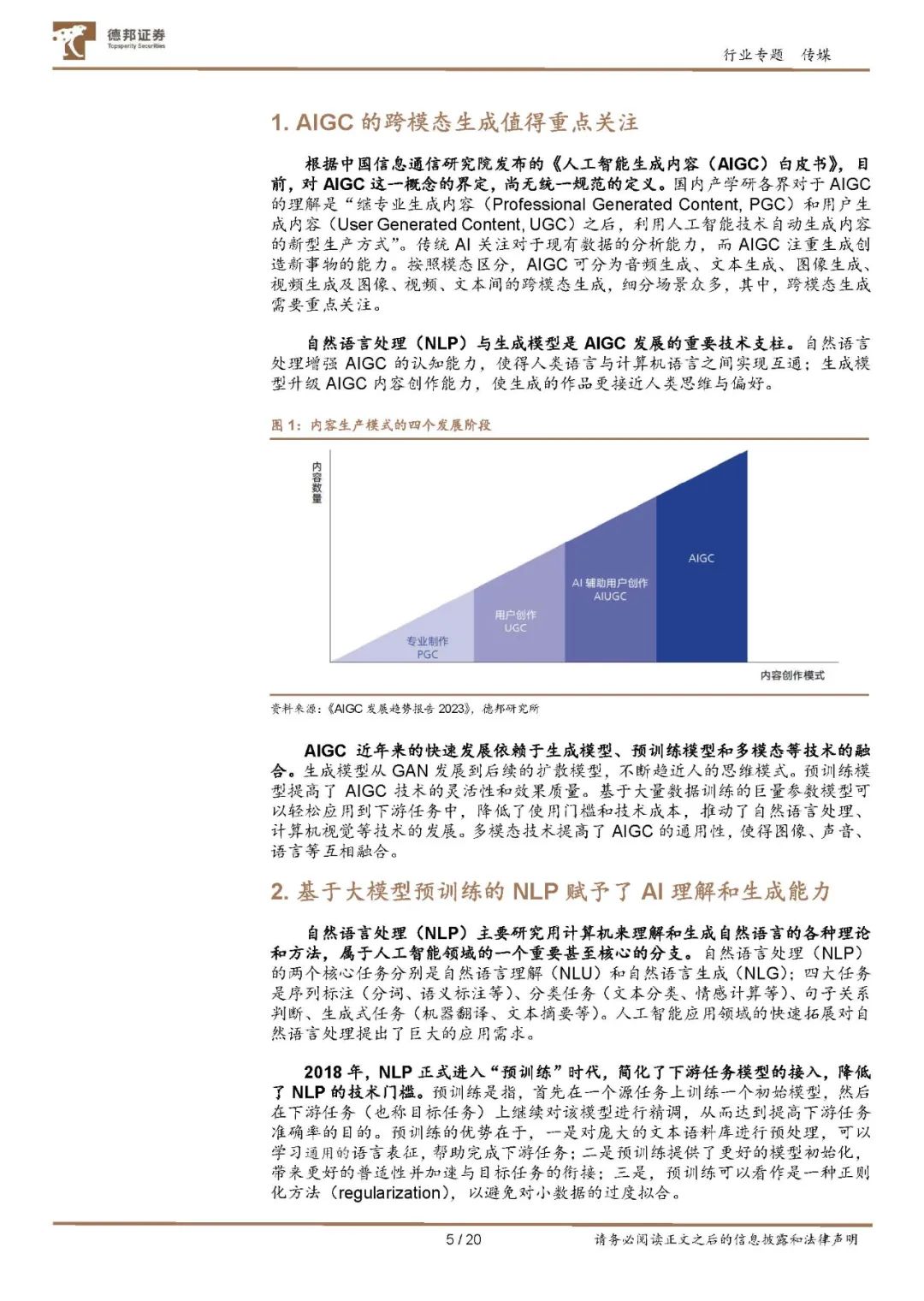

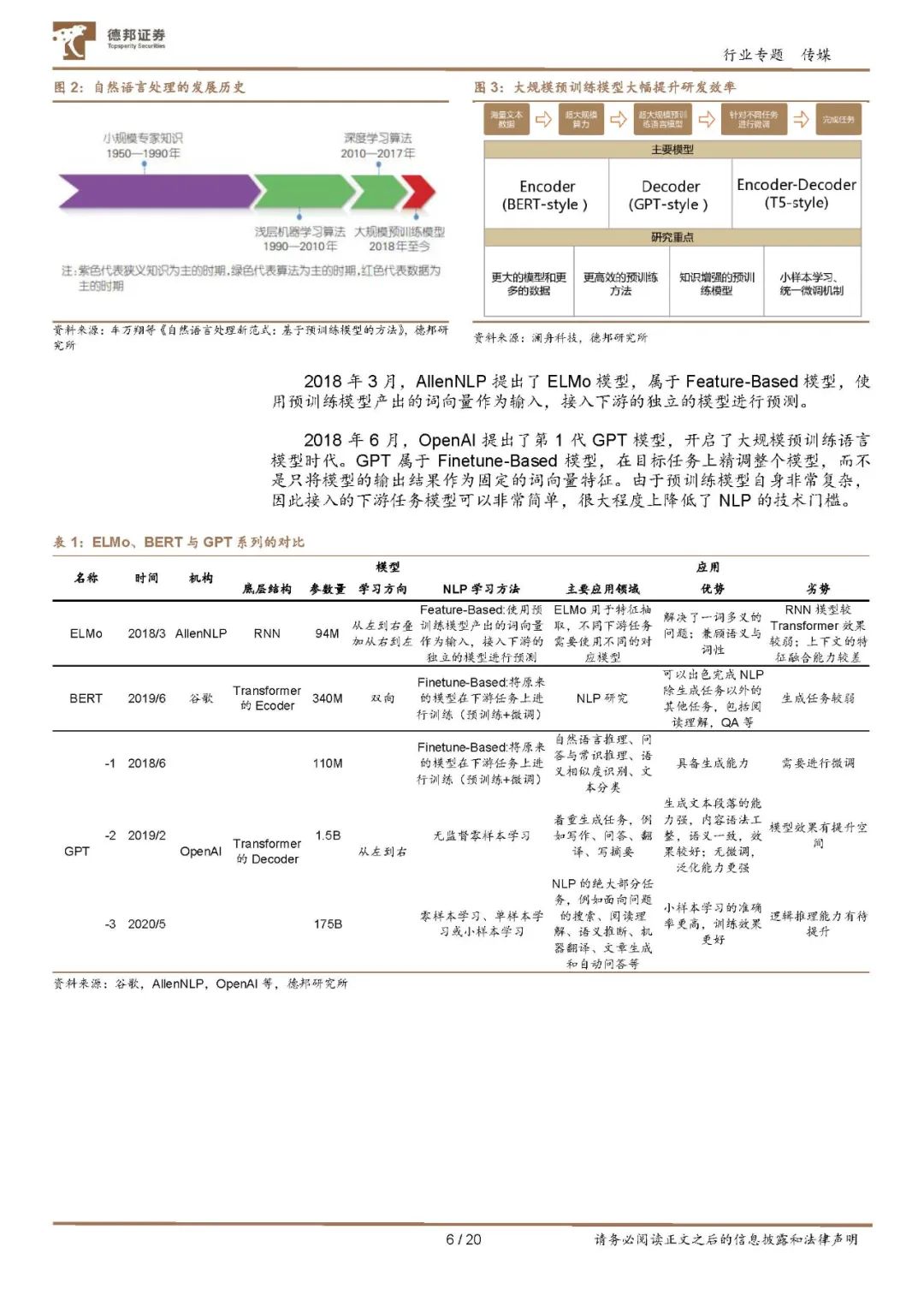

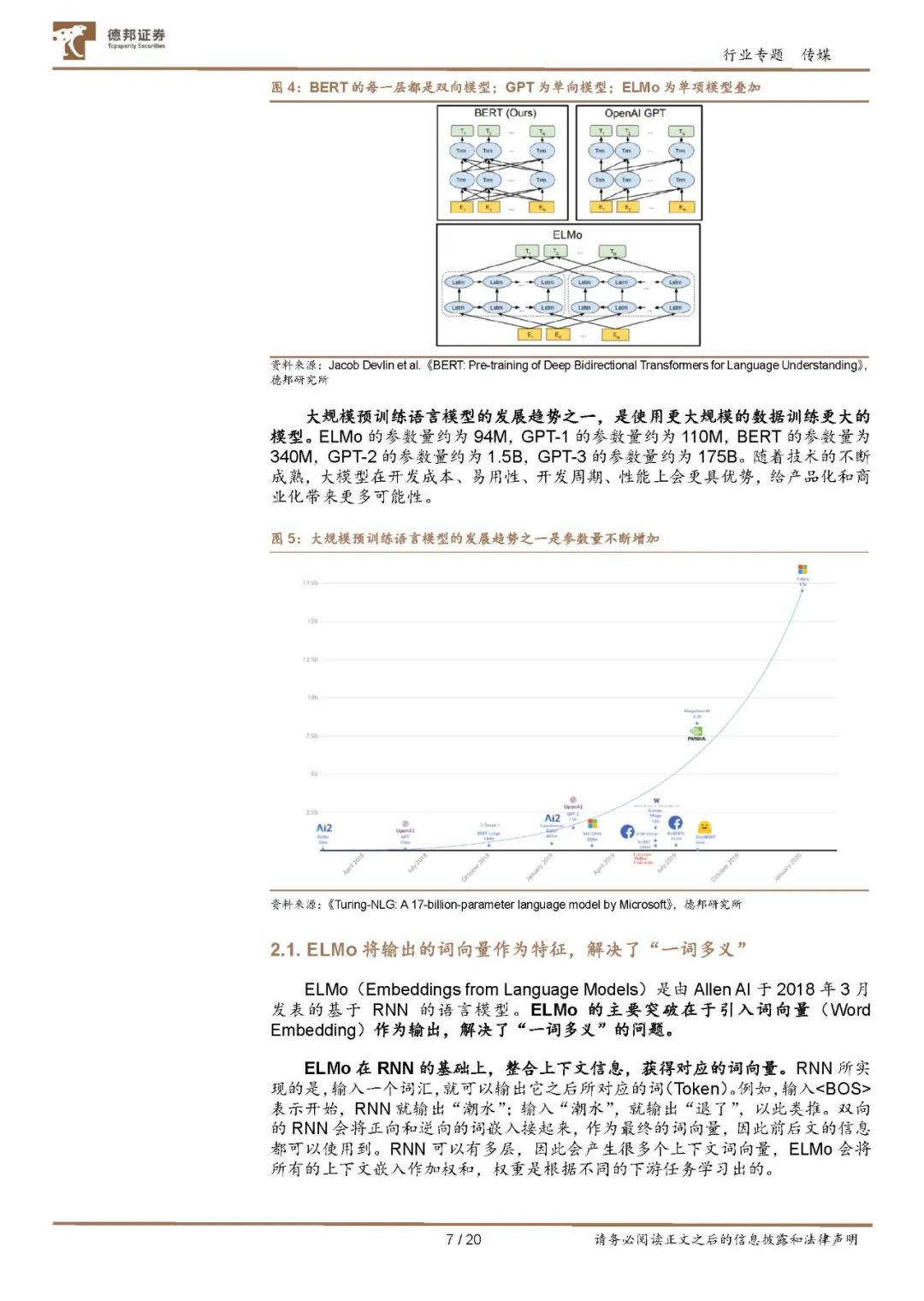

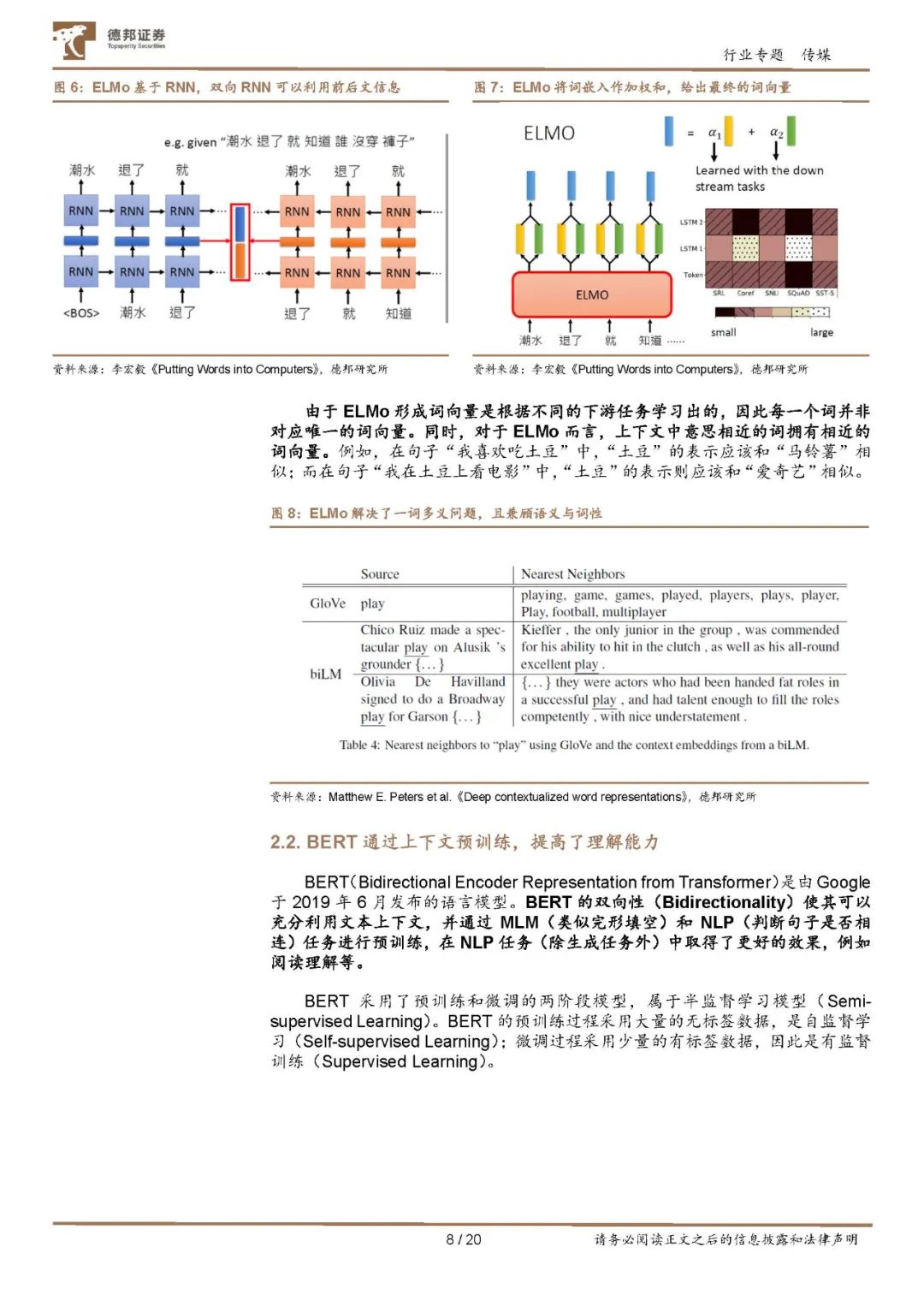

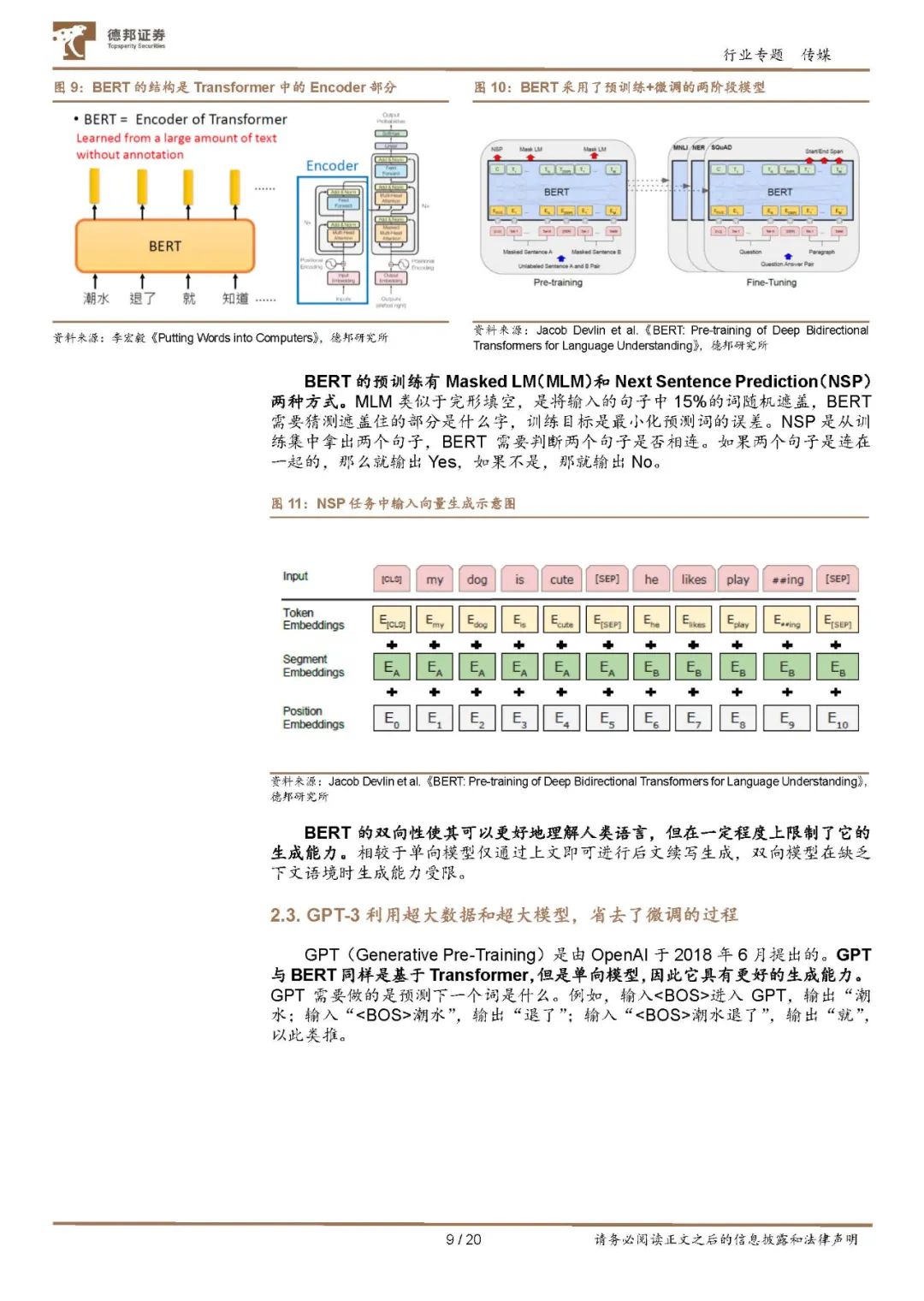

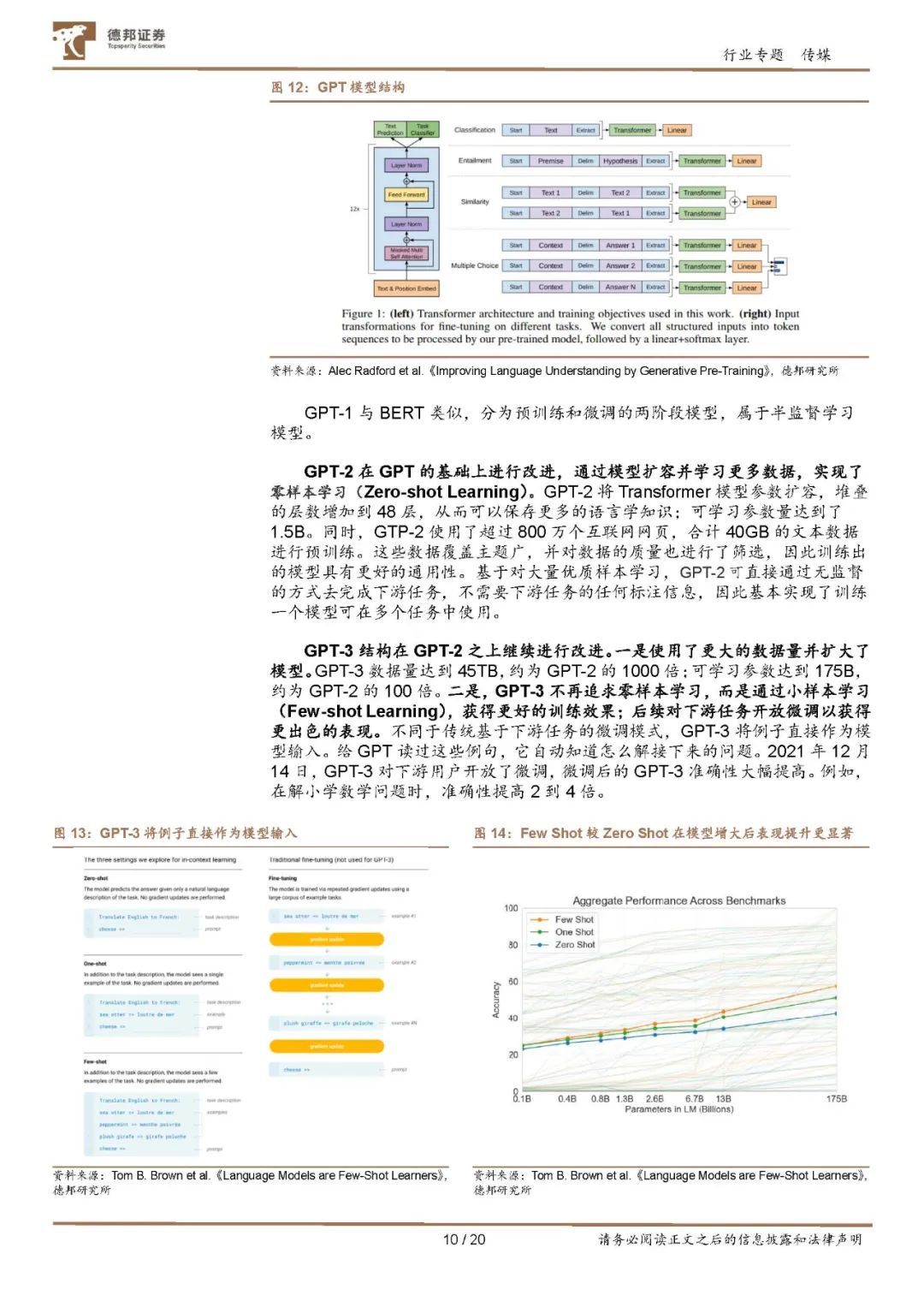

AIGC成为新的内容生产方式,跨模态生成值得重点关注。区别于PGC与UGC,AIGC是利用人工智能技术自动生成内容的新型生产方式。按照模态区分,AIGC可分为音频生成、文本生成、图像生成、视频生成及图像、视频、文本间的跨模态生成,细分场景众多,其中,跨模态生成需要重点关注。 自然语言处理(NLP)赋予了AI理解和生成能力,大规模预训练模型是NLP的发展趋势。NLP的两个核心任务分别是自然语言理解(NLU)和自然语言生成(NLG)。以ELMo、BERT、GPT为代表的预训练模型,降低了NLP的技术门槛。ELMo解决了“一词多义”的问题;BERT通过MLM(类似于完形填空)和NLP(判断句子是否相连)进行预训练,增强了上下文的理解能力。GPT通过预测下一个词,获得了生成能力;GPT-3在此基础上使用了更大的数据和更大模型,无需针对下游任务进行传统的微调,并且采用了小样本学习提升生成效果。 ChatGPT是NLP发展中具有里程碑式意义的模型之一。ChatGPT是OpenAI从GPT-3.5系列中的模型进行微调产生的聊天机器人模型。它能够通过学习和理解人类的语言来进行对话,还能根据聊天的上下文进行互动,真正像人类一样来聊天交流,甚至能完成撰写邮件、视频脚本、文案、翻译、代码等任务。 生成模型赋予了AI创造力,扩散模型是最前沿的技术之一。AIGC的快速发展归功于生成算法领域的技术积累。GAN的核心思想是“生成”与“对抗”,相比传统的深度神经网络,GAN能产生更好的生成样本,但是仍需解决应用中的问题。扩散模型较GAN更接近人的思维模式,是基于马尔科夫链,通过学习噪声来生成数据。扩散模型实现了跨模态应用,包括OpenAI的GLIDE和DALL·E2、谷歌的Imagen、StabilityAI的StableDiffusion等。 人工智能由单模态智能,向多种模态融合方向发展。建立统一的、跨场景、多任务的多模态基础模型或将成为人工智能发展的主流趋势之一。CLIP模型将语言信息和图像信息联合训练,能够链接文本和图片,成为跨模态生成应用的一个重要节点,“CLIP+其他模型”在跨模态生成领域成为一种较为通用的做法。2022年,微软提出的BEiT-3多模态基础模型,在视觉-语言任务处理上具备出色表现,包括视觉问答、图片描述生成和跨模态检索等。多模态提高了基础模型的灵活性,使其在其他模态的应用中发挥新的潜质。 未来,值得关注的技术要素包括:长文本生成、开放式文本生成、NeRF模型、扩散模型、跨模态大型预训练模型(支持的模态数据类型、模态对齐架构设计、支持的下游应用)、小样本学习及自监督算法、强化学习及环境学习等。