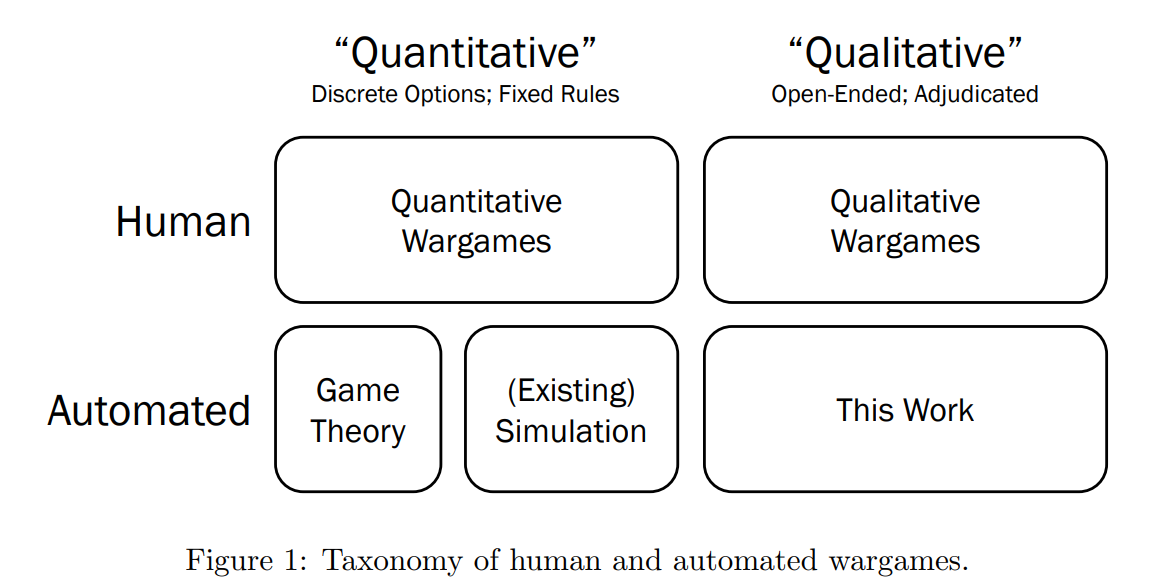

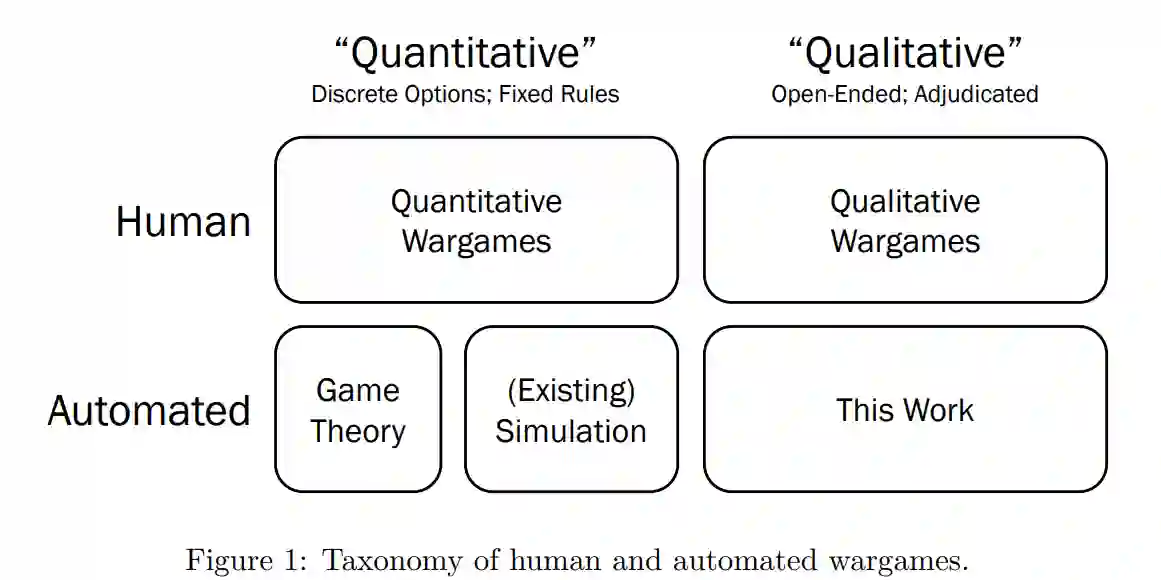

兵棋推演是了解和演练现实世界决策的有力工具。利用人工智能(AI)自动进行兵棋推演,可以实现人类游戏无法实现的可能性,例如反复多次进行游戏,以观察一系列可能的结果。兵棋推演分为两类:定量游戏和定性游戏,前者具有离散的棋步类型,后者则围绕开放式反应展开。从历史上看,自动化工作主要集中在定量游戏上,但大型语言模型(LLM)使定性兵棋推演的自动化成为可能。本文介绍了 "Snow Globe"(雪球),这是一个由 LLM 驱动的多智能体系统,可用于定性兵棋推演。有了 "雪球",基于文本的定性兵棋推演从场景准备到赛后分析的每个阶段都可以选择由人工智能、人类或它们的组合来完成。从概念上描述了它的软件架构,并在本出版物中发布了开源实现。作为案例研究,模拟了一次人工智能事件响应桌面演练和一次地缘政治危机政治兵棋推演。讨论了该方法的潜在应用以及它如何融入更广泛的兵棋推演生态系统。

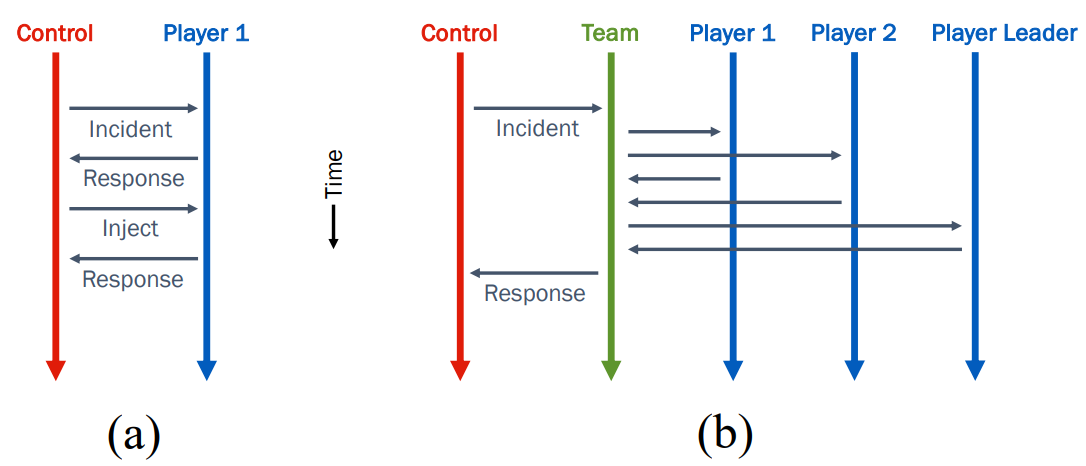

图 2:Snow Globe 多智能体系统的软件架构示例。垂直箭头代表智能体,水平箭头代表 (a) 简单桌面演练和 (b) 团队制定集体应对措施的信息流。

软件架构

Snow Globe 是一个多智能体系统,旨在自动执行各种定性兵棋推演。在 Snow Globe 中,有三种智能体:控制体、玩家体和团队体。其中,控制体和玩家是由 LLM 驱动的智能体,在兵棋推演中扮演传统的人类角色。控制是游戏的主持人。它的工作包括纯粹的后勤任务,如呼叫团队/玩家以获得他们的回应,以及复杂的人工智能驱动任务,如通过 LLM 裁决对抗游戏的每一轮。玩家智能体模拟人类在游戏中的反应,每个玩家都可以被赋予一个 "角色",即影响其反应的对其观点的书面描述。最后,团队智能体模拟的是一个必须共同制定对策的团体。一个模拟通常只有一个控制,但可以有任意数量的参与者和团队。团队/球员的任何非循环排列都是允许的,包括一个团队的团队、一个球员在多个团队中,等等。如图 2 所示。

概念方法

在 Snow Globe 中,兵棋推演中迄今为止发生的事情都记录在 "历史 "对象中。历史对象是一个有序的文本条目列表,每个条目都与一个智能体相关联。对于不存在信息不对称的游戏,控制会维护一个共同的历史记录。信息不对称可以通过让每个玩家/团队拥有自己可能不完整的历史对象来实现。历史对象中包含的游戏记录为玩家做出反应提供了背景。从形式上看,历史对象构成了多智能体系统的环境。

再仔细观察一下不同类型的智能体,玩家的主要任务是说明他们将如何应对呈现给他们的每种情况。为此向玩家的底层 LLM 发送的提示包括上述历史记录、玩家角色的书面描述以及询问:"你会采取什么或哪些行动来应对?" (玩家的角色会影响他们在回答时所强调的内容。例如,我们开发了一个信息技术桌面模拟演练,其中包括 "数据科学家 "和 "律师 "两种角色。前者比后者更有可能提出培训数据方面的问题,而后者则更有可能提到法律合规性。

从控制的角度来看,一个团队看起来只是一个玩家--它接收当前的历史数据,然后发回响应。然而,团队本身并没有生成能力。在幕后,团队会询问每个成员的回复,然后要求指定的团队领导者将这些回复合并成一个联合回复,并代表团队发回。图 2(b) 展示了这一示意图。

控制组作为游戏的主持人,有很多任务。其中一项控制任务是裁决对抗性兵棋推演。为此,控制程序会呼叫每个玩家,了解他们针对当前局势提出了哪些行动建议。然后,控制员对结果进行合理的叙述,描述在执行玩家所述计划时可能会发生的合理情况。下一段将进一步讨论裁决问题。控制软件还可以根据简短的提示生成情境,确定情境中的关键角色(可为其创建智能体),并生成相关的 "注入"(用于推动游戏的预写情节发展),从而帮助创建兵棋推演。最后,在游戏进行过程中或结束后,控制软件还提供了分析游戏的工具。该控件可以回答有关游戏的预设问题,用户也可以通过聊天机器人对话框与它交谈。无论哪种情况,该控件都会利用游戏的历史记录来回答问题。问题的范围可以很具体(例如 "是否在任何时候咨询过律师?"),也可以很笼统(例如 "我们能从这个场景中学到什么教训?")。

裁决可能是法律硕士实施定性兵棋推演时最具挑战性的任务。它要求 LLM 创建一个具有因果逻辑感的叙事,当玩家的行动相互矛盾时,可能需要制定一个合理的解决方案。我们使用的查询语是:"将这些计划编入下个月发生的事情的连贯叙述中",并适当修改时间步长。在现实游戏中,并不是所有重要事件的发生都是玩家设定的结果。例如,在政治军事兵棋推演中,当地可能会出现一些快速发展的事态,虽然没有领导人下令,但却对结果至关重要(内乱、恐怖主义等)。为了发挥作用,人工智能裁决必须能够生成 "自然",即这些在上下文中合理的外部事态发展[17]。这项艰巨的任务在 LLMs 中变得出奇地容易。只需修改提示语,添加三个字的句子:"包括意想不到的后果": "包括意想不到的后果"。

当裁决确实给出了低质量的结果时,最常见的问题包括从一步棋到另一步棋的重复输出,以及偏离棋手既定计划的输出(通常是通过幻觉将新的棋手计划作为输出的一部分)。然而,假想的无幻觉 LLM 带来的问题会比它解决的问题更多。幻觉在其他应用中往往是有害的,但它却是使开放式 LLM 兵棋推演发挥作用的关键。生成计划并裁定其结果所需的有根有据的创造力是幻觉的另一个名称。

软件实现

开发了上述概念架构的 Python 实现。Snow Globe 软件已在 Apache 2.0 许可下开源。

导入 Python 模块后,用户可以创建控制、团队和玩家智能体,以及历史和 LLM 对象。推荐的方法是创建模块控制类的子类,作为用户特定模拟的控制。该子类的构造函数和调用方法可以用代码重载,以分别创建其他智能体和运行模拟。

软件支持本地运行 LLM,格式为 llama.cpp [36] 或 Hugging Face transformers 库 [37]。它还支持 OpenAI API 调用[38]。LangChain 框架 [39] 处理与 LLM 的交互。在小型开源 LLM 中,我们发现 Mistral-7BOpenOrca-GGUF 模型的效果最好。来自 Mistral AI 的 70 亿参数基础模型[40]利用 OpenOrca 数据集[41]作为聊天机器人进行了微调,然后由其他开源贡献者转换为计算资源高效的格式[42]。这种 LLM 非常轻便,可以在普通的 "游戏 "笔记本电脑上运行。在本地运行模型的能力对于信息无法对外共享的使用案例至关重要。由于模型没有针对任何特定游戏进行微调(也没有在运行时给出输出示例),因此这是一个零射击学习案例。

软件的配置使 LLM 的输出是随机的,因此没有两次模拟兵棋推演的结果是完全相同的。因为任何复杂的真实情况的结果都取决于许多微小的细节,而并非所有细节都能在模拟中得到描述和说明,因此期望模拟产生单一的 "正确 "答案是不合理的。(这是定性兵棋推演的一般特点,我们的系统实施也模仿了这一特点)。相反,使用随机 LLM 输出对同一模拟进行反复迭代,会显示出一系列可能的结果。下文第 3.2 节将举例说明。随机性还意味着,没有任何智能体知道另一个智能体在特定情况下会做什么。

人机交互

Snow Globe 可以让任何玩家智能体由真人而非 LLM 操作。人类玩家使用一台连接到模拟运行所在网络的计算机,基于网页的用户界面通过显示本来会发送给 LLM 的提示信息来告诉玩家游戏的状态。网页接收人类对每个提示的书面回复,并将其发送回服务器。

该系统支持人工智能和人类玩家的任意组合,从而允许进行一系列兵棋推演。例如,人类玩家可以面对人工智能对手。或者,一个人类玩家可以有一群人工智能助手,每个助手都会就他们认为人类应该做的事情提供意见。(后一种情况可以通过一个团队代理来实现,团队代理包括一个人工智能团队成员和一个人类团队领导。助手们可以有不同的角色,甚至使用不同的 LLM)。也可以通过将控制代理设置为使用基于网络的用户界面,让人类担任主持人。

当多个参与者必须对同一情况做出反应时(每个参与者都不知道其他人的反应),就会出现一个时间问题。人工智能玩家应按顺序做出反应,以避免硬件负担过重。而人类玩家则应该能够并行处理他们的答案,以避免不必要的等待。简而言之,人工智能受计算约束,而人类受输入/输出约束。我们使用异步编程对两者进行优化,无需重构代码即可在人工智能和人类玩家之间切换。

在我们Snow Globe Python 实现中,发送给人类的提示和从人类那里收到的回复都存储为文本文件,并通过带有 FastAPI 框架和 Uvicorn 网络服务器的 API 在网络上提供。这样,界面就很容易扩展,从而保证了界面的未来性。人们可以设计一个新的网页来与现有的应用程序接口进行通信,或者放弃应用程序接口,设计新的软件来直接与文件进行交互。

兵棋推演有四项基本任务:准备游戏、进行游戏、裁决游戏和解释游戏。对于使用 Snow Globe 的基于文本的定性兵棋推演,这些任务中的每一项都可以选择由人工智能、人类或它们的组合来完成。