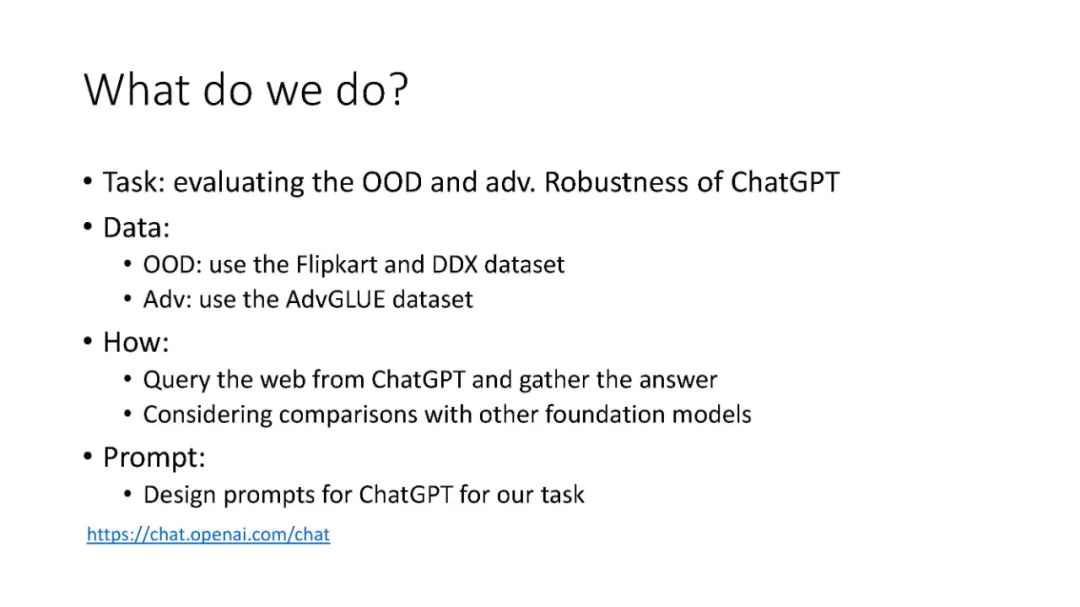

ChatGPT现在成为持续关注的热点。微软等学者在最新WSDM 2023会议上做了关于《领域泛化》报告教程,详细阐述了领域****泛化(DG)的最新进展,并着重指出ChatGPT在对抗和分布外视角下的鲁棒性,值得关注

机器学习模型严重依赖于大量训练数据的可用性。对于标注良好的数据难以获取的低资源场景,从现有领域到目标领域进行跨领域知识迁移非常重要。针对这一问题,迁移学习和领域适应等研究取得了很大进展。除了这些进展之外,学习在任何未见过的新环境中都能很好地泛化的模型也非常重要。这激励研究界开发算法,以更好地利用现有的训练域,同时处理其分布变化。

本教程致力于介绍域泛化(DG)的最新进展。与迁移学习和域适应假设目标域数据的可用性不同,DG更进一步,不需要访问目标域数据。DG的目的是从一个或多个具有不同概率分布的训练域学习一个通用模型,以实现良好的分布外泛化。潜在的受众将是机器学习研究人员和行业从业者,对迁移学习、领域适应和泛化特别感兴趣。我们的教程旨在使这些技术在实际应用中更容易学习和使用。

目录内容:

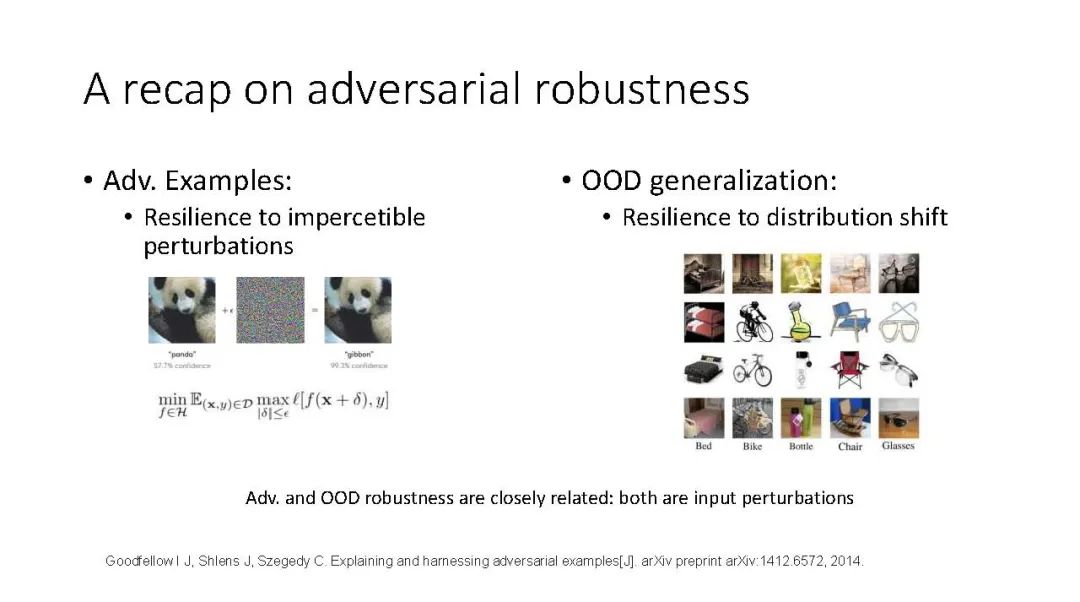

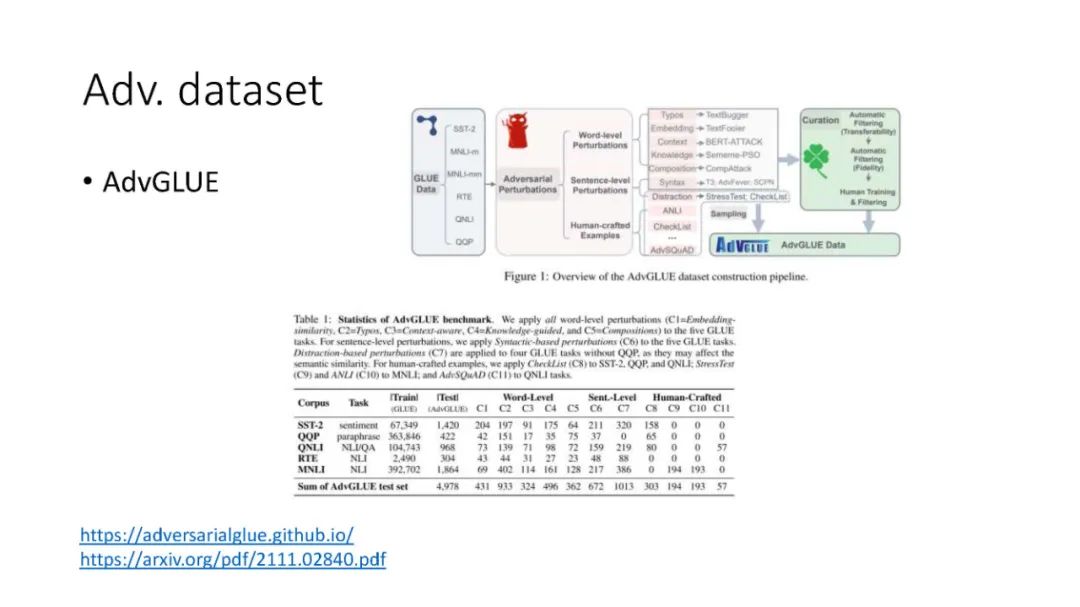

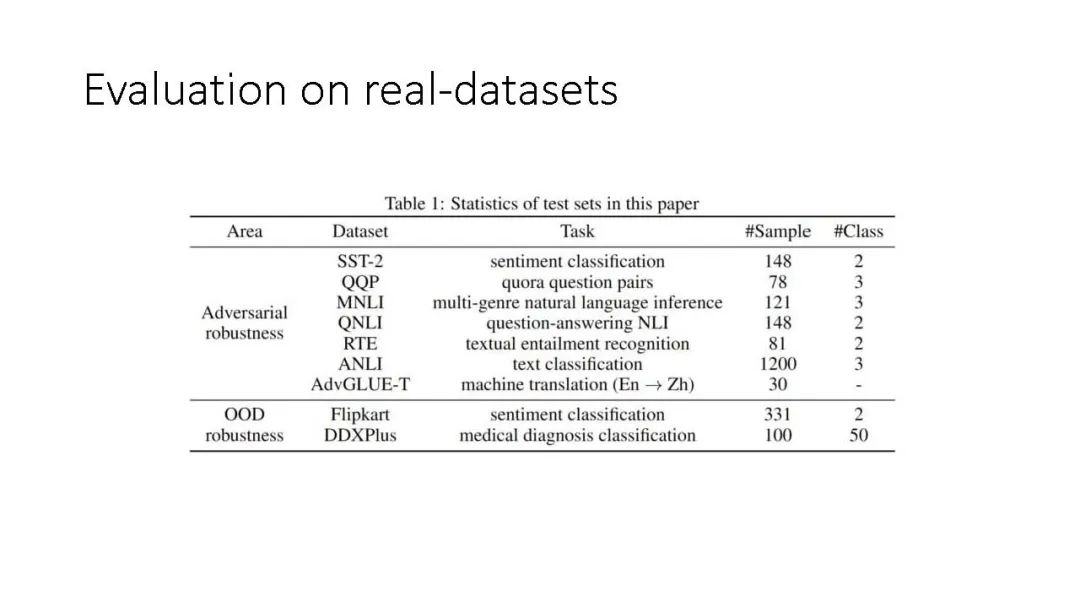

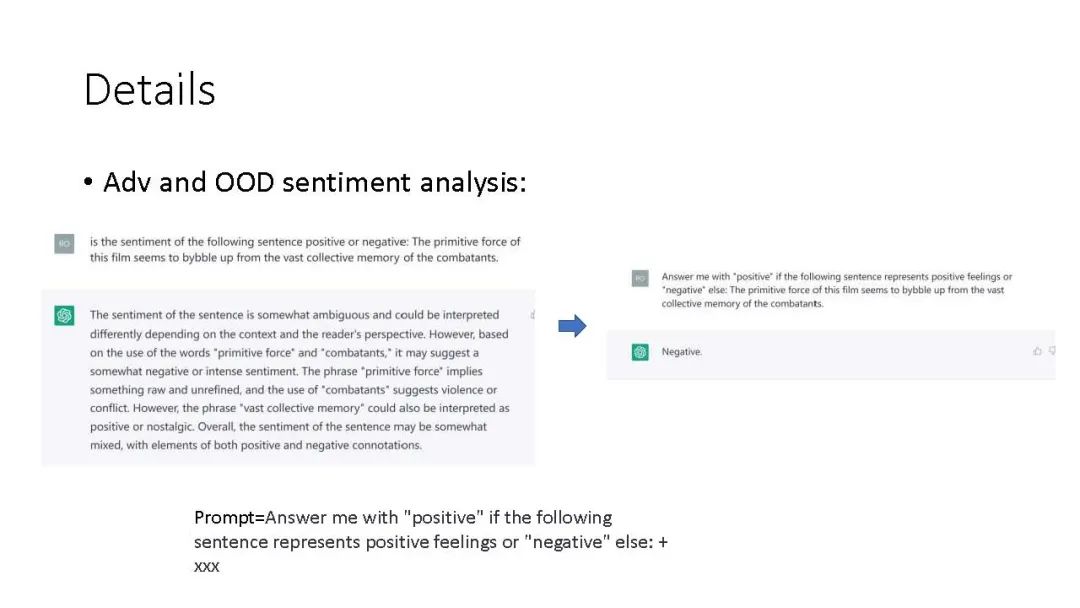

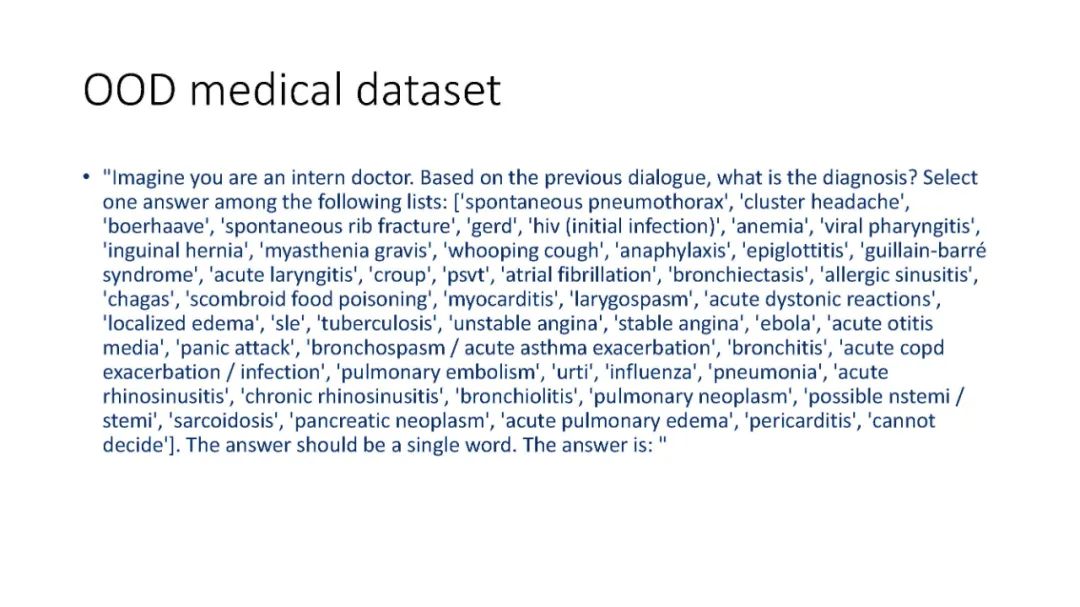

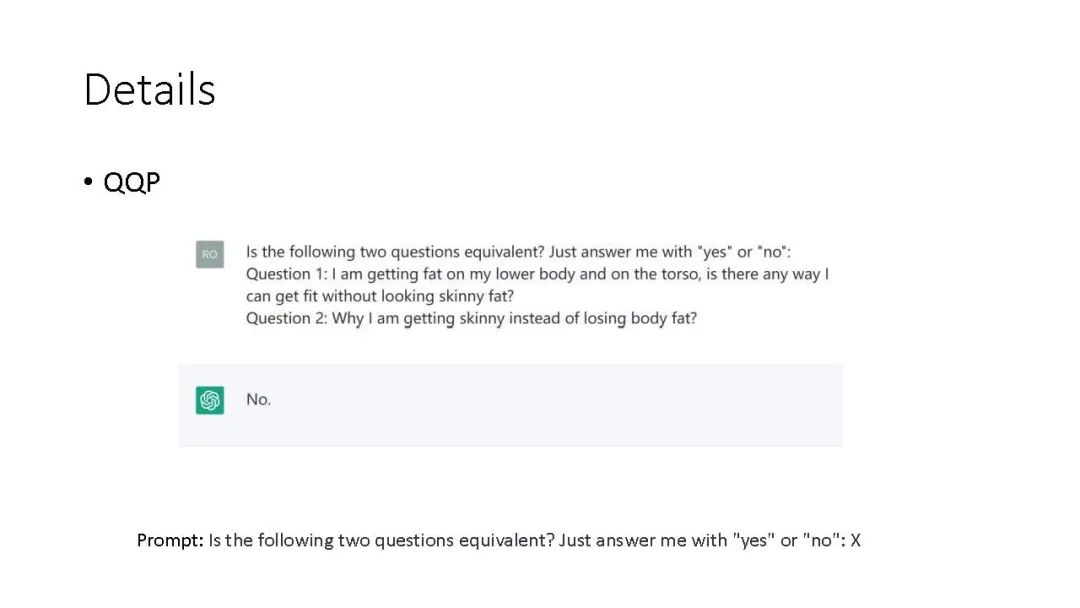

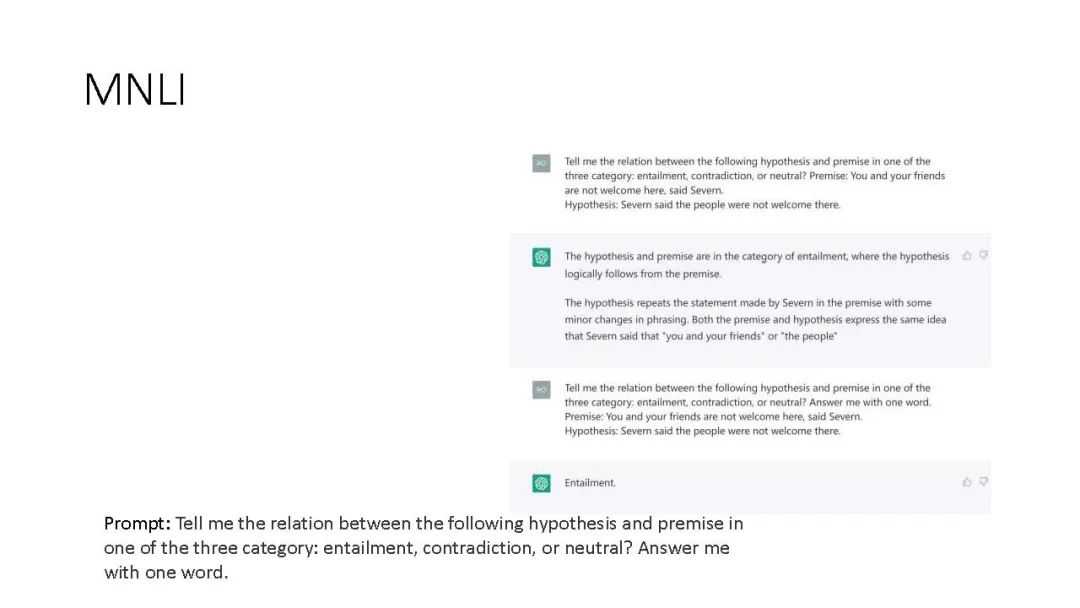

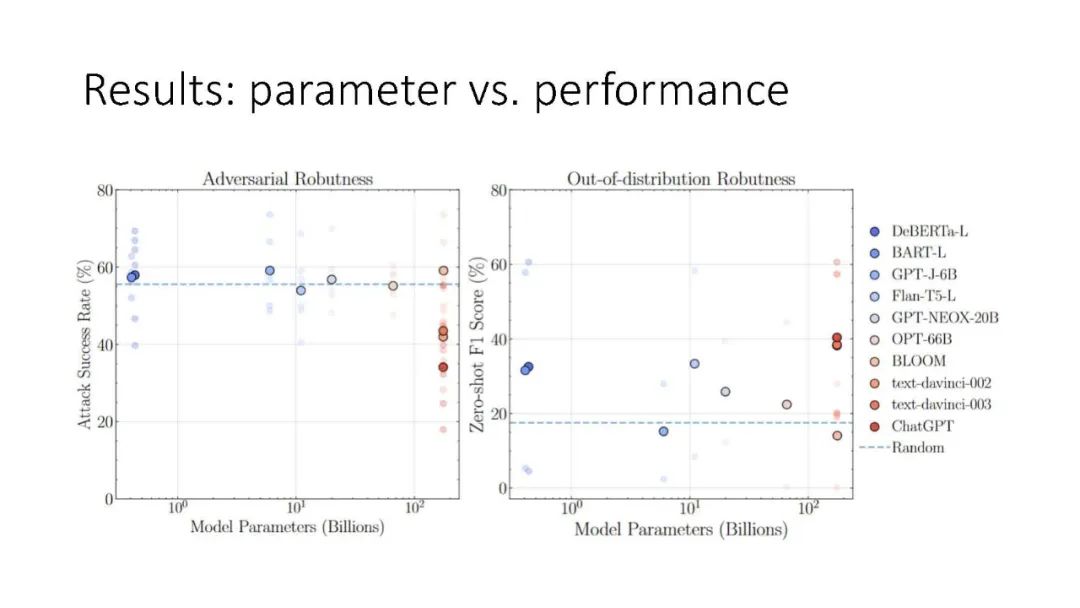

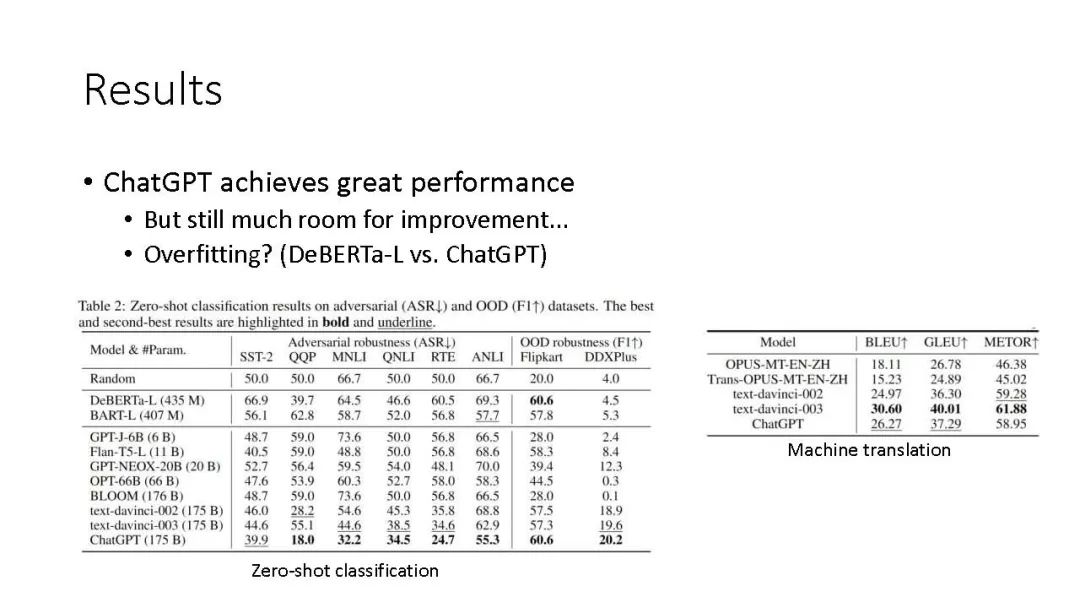

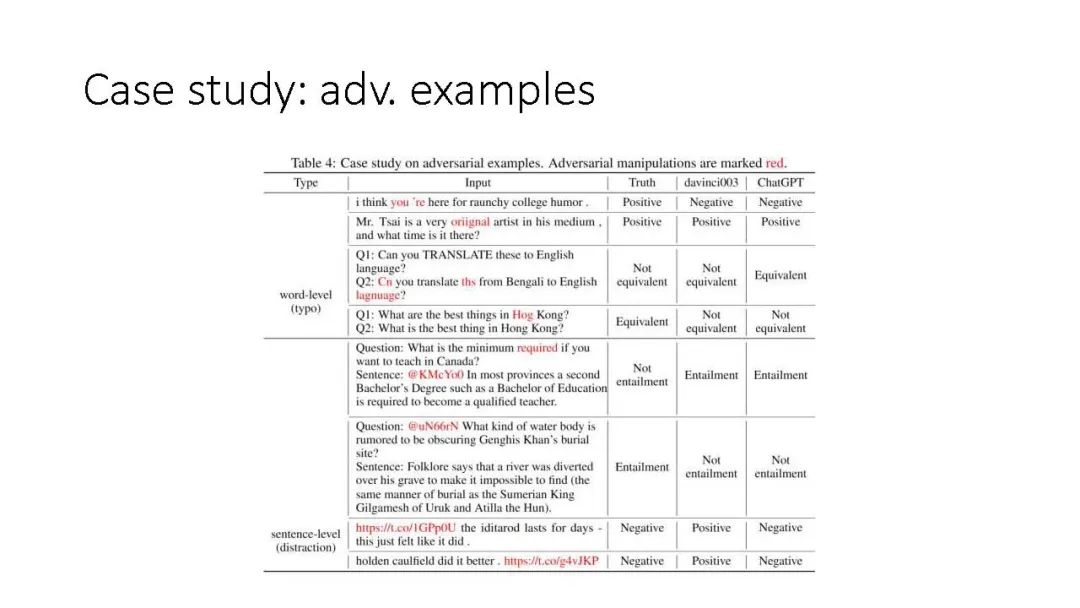

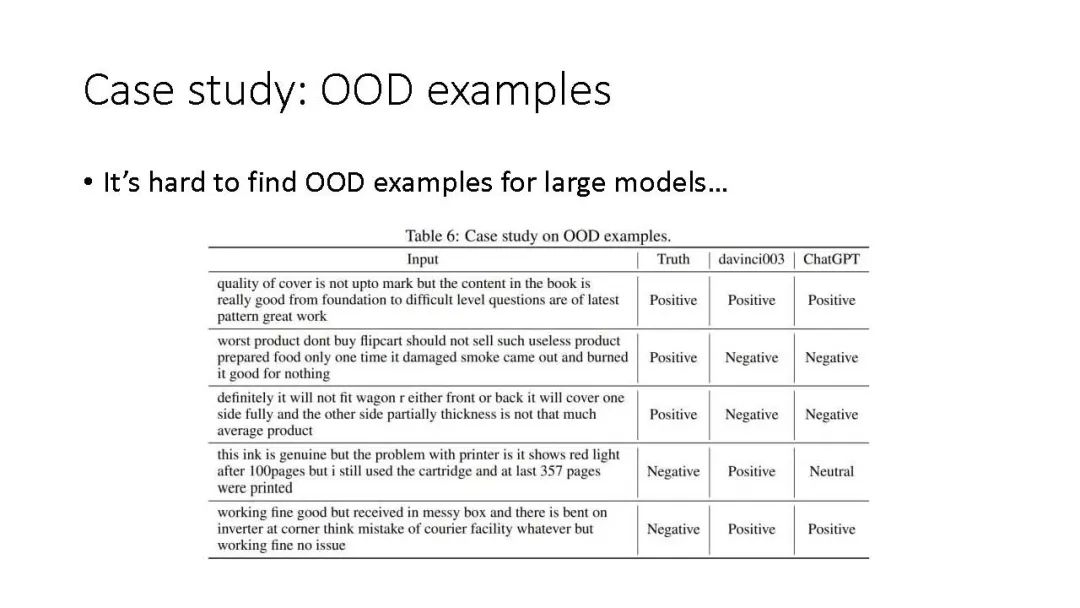

Introduction and background * Related research areas * Methodology of DG * Applications * Datasets, benchmarks, and evaluations * Theory and future challenges * ChatGPT vs. OOD robustness?

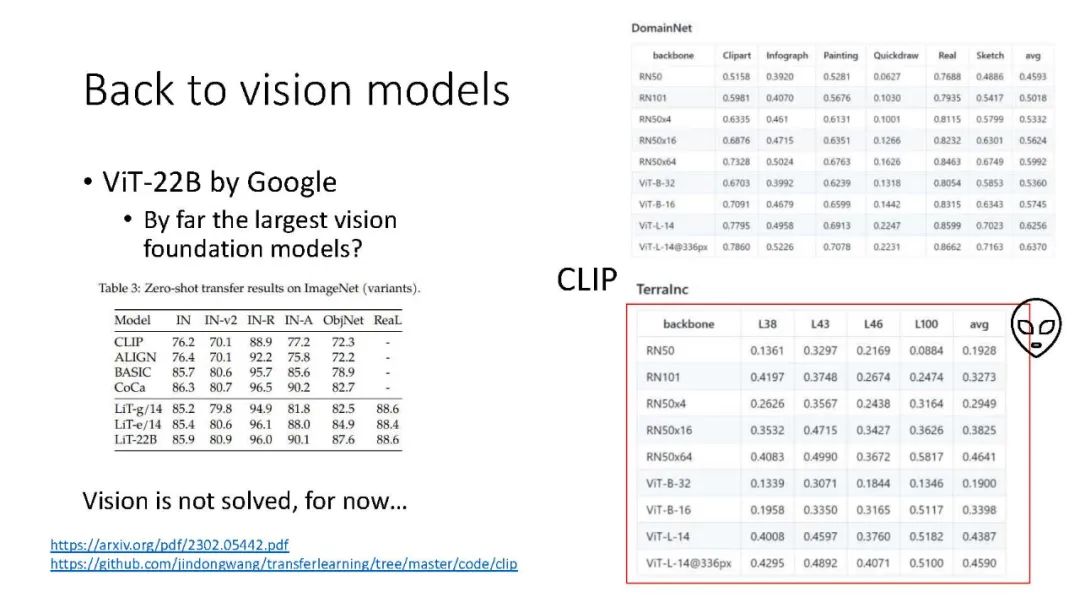

代码地址: https://github.com/jindongwang/transferlearning/tree/master/code/DeepDG 论文:

域泛化(DG),即分布外泛化,近年来引起了越来越多的关注。领域泛化处理一个具有挑战性的设置,其中给出了一个或几个不同但相关的领域,目标是学习一个可以泛化到看不见的测试领域的模型。

近年来,取得了很大的进展。本文首次综述了领域泛化的最新进展。

首先,我们给出了领域泛化的形式化定义,并讨论了几个相关的领域。

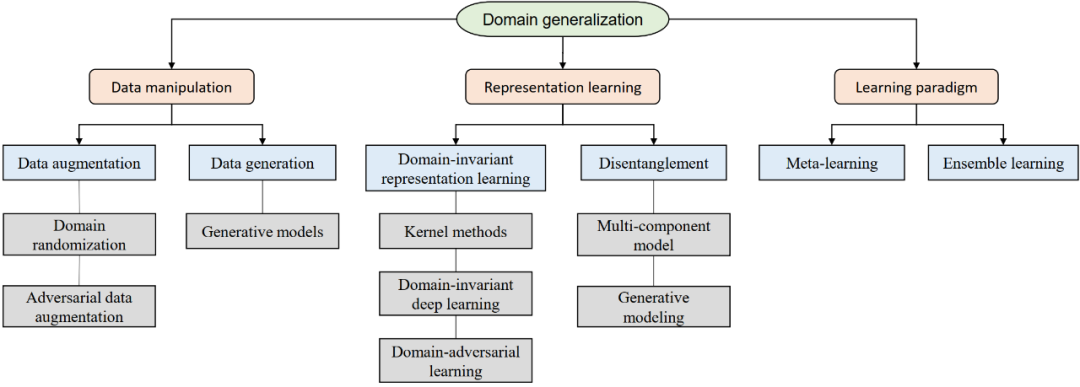

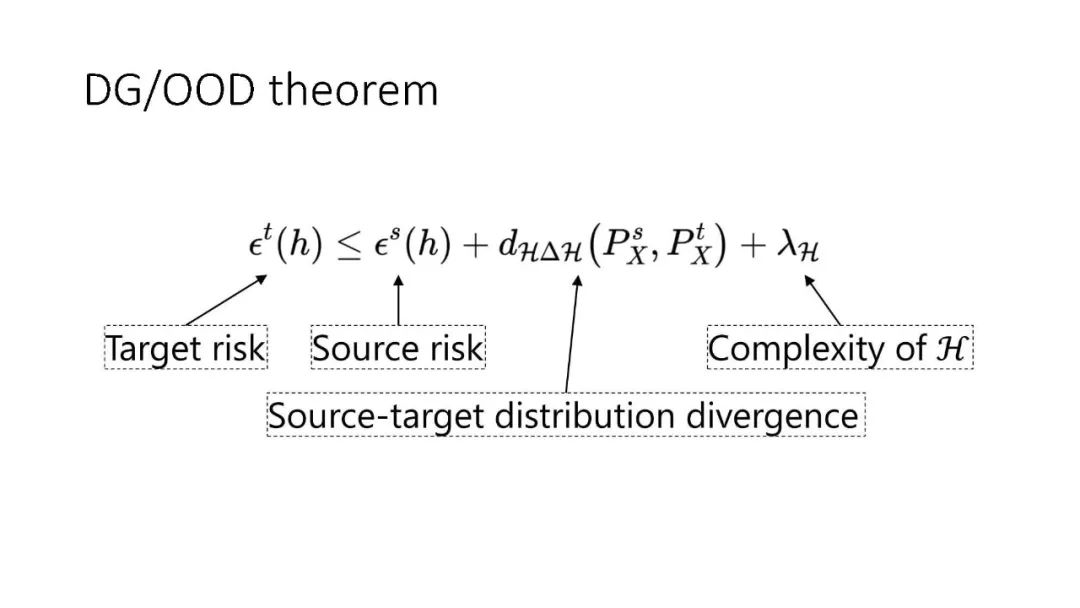

接下来,我们对领域泛化的相关理论进行了全面的回顾,并对泛化背后的理论进行了仔细的分析。然后,我们将最近出现的算法分为三类,分别是数据操作、表示学习和学习策略,每一类都包含了一些流行的算法。

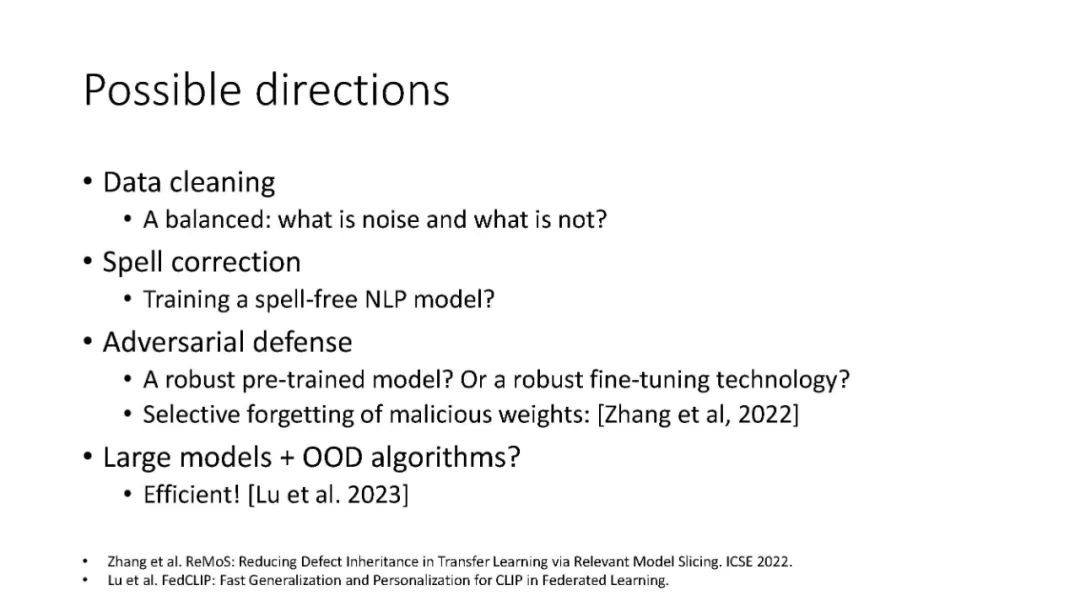

第三,介绍了常用的数据集及其应用。最后,对已有文献进行了总结,并提出了未来的研究方向。

https://www.zhuanzhi.ai/paper/5b8b8958327cabc8b6694d7fc5c7ac75