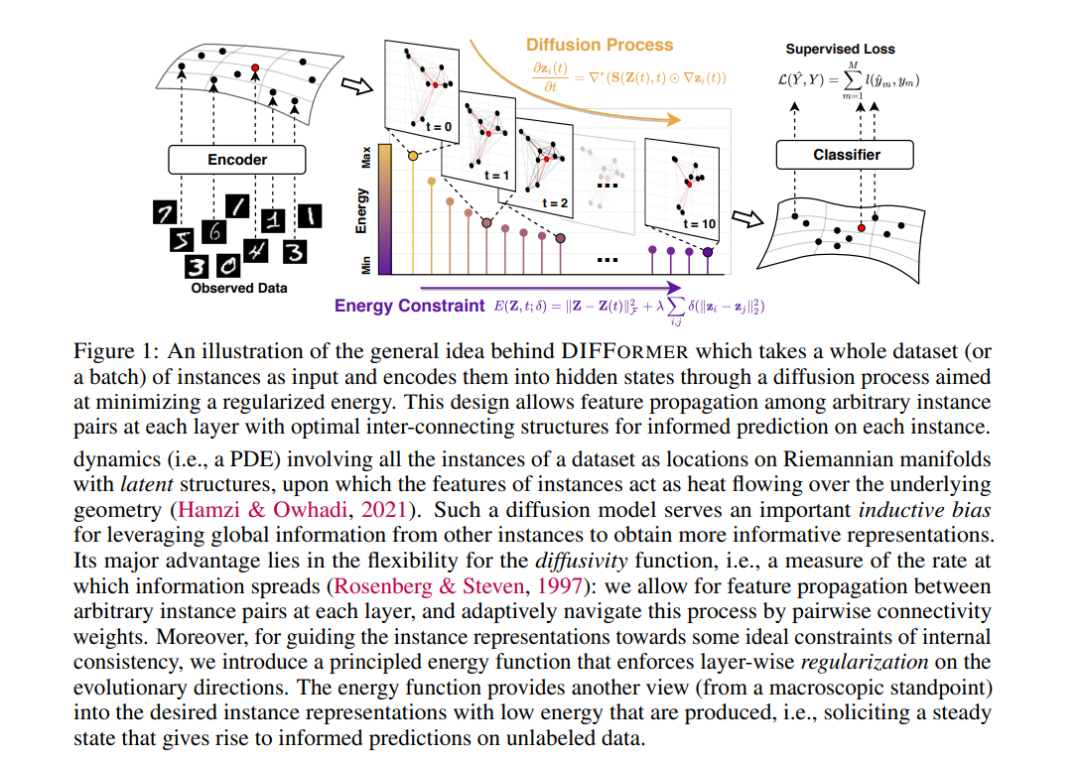

现实世界的数据生成往往涉及实例之间复杂的相互依赖关系,违反了标准学习范式的IID-data假设,为揭示学习所需实例表示的几何结构带来了挑战。本文提出一种能量约束扩散模型,将数据集中的一批实例编码为进化状态,通过它们的相互作用逐步纳入其他实例的信息。扩散过程受下降准则w.r.t的约束。w.r.t是一个原则性的能量函数,刻画了潜结构上实例表示的全局一致性。本文提供了严格的理论,意味着对任意实例对之间的成对扩散强度的闭合形式最优估计,这产生了一类新的神经编码器,称为DIFFormer(基于扩散的transformer),有两个实例:一个简单版本,对实例数量具有线性复杂性,另一个高级版本,用于学习复杂结构。实验强调了所提出模型作为通用编码器骨干的广泛适用性,在各种任务中具有优越的性能,如大图上的节点分类、半监督图像/文本分类和时空动态预测。 https://www.zhuanzhi.ai/paper/1c4b9cf426b3d20898582742919b4151

成为VIP会员查看完整内容