Calibrating Graph Neural Networks from a Data-centric Perspective

作者:Cheng Yang, Chengdong Yang, Chuan Shi, Yawen Li, Zhiqiang Zhang, JUN ZHOU 论文链接:http://shichuan.org/doc/170.pdf

摘要

图神经网络(GNNs)在各种复杂网络的建模中得到了广泛的应用。尽管GNN在准确性上表现突出,但GNN的置信度没有被校准,这说明模型的预测可能是不可靠的。现有的校准方法主要侧重于改进GNN模型,例如在训练过程中加入正则化项或在训练后使用基于温度缩放的方法。在本文中,我们认为GNN的校准误差可能源于图数据,可以通过修改图的拓扑结构来缓解这一问题。为了验证这一想法,我们通过检查决定性边和同质边对校准性能的影响来进行观察实验,其中决定性边指在GNN预测中起关键作用的边,而同质边指连接同类节点的边。通过给邻接矩阵中的这些边分配更大的权重,我们观察到在不牺牲分类精度的情况下,GNN的校准性能得到了改善。这表明以数据为中心的校准GNN方法的潜力。根据我们的观察结果,我们提出了以数据为中心的图校准(DCGC),它使用两个边加权模块来调整输入图以进行GNN校准。第一个模块通过参数化邻接矩阵并使预测损失反向传播到边权重来学习决定性边的权重。第二个模块根据模型预测的标签分布计算同质边的权重,为同质性强的边分配更大的权重。这些两个边加权模块都是在数据层面上进行操作的,可以很容易地与基于温度缩放的方法集成,以便更好地校准。在8个基准数据集上的实验结果表明,DCGC达到了最先进的校准性能,同时保持甚至提高了分类准确率。消融实验和超参数分析进一步验证了该方法的有效性和鲁棒性。

一、介绍

随着复杂网络在各个领域的广泛应用,节点分类任务在过去十年中引起了人们的广泛关注。作为学习图结构数据的强大框架,图神经网络(GNN)在节点分类的各种基准上表现出了良好的准确性。 除了预测精度之外,对于可信的 GNN 来说,还需要对预测结果的不确定性进行评估。例如,在安全关键场景中,GNN 应该知道它们的预测何时可能不正确,并向人类用户发出警报。最近的进展表明,GNN 在节点分类任务中通常缺乏自信,即它们的预测精度高于其正确的置信度。为了校准 GNN 的置信度,现有方法可以分为两类。处理中的方法通过结合正则化方法或贝叶斯建模来联合训练和校准GNN。事后方法针对训练好的GNN进行校准,通过使用温度调整归一化层(softmax)的输出进行校准,称为温度缩放(TS)。最近的工作表明,与处理中的方法相比,事后方法可以在精度和校准之间实现更好的权衡。因此,我们在本文中遵循事后方法的设置,旨在校准训练好的GNN。

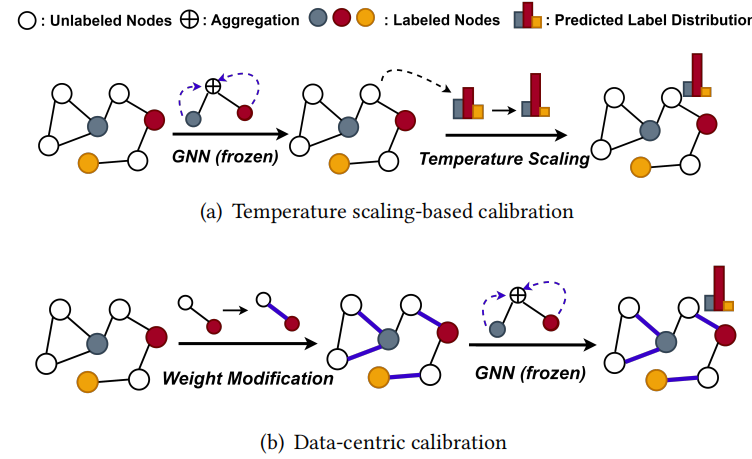

图1.(a) 基于温度缩放的校准方法 和 (b) 我们提出的以数据为中心的校准方法之间的比较。之前的工作重点是调整softmax函数中的温度,而这项工作重点是修改输入图。 然而,现有的校准方法侧重于改进 GNN 模型,而我们认为 GNN 的错误校准可能来自图数据。例如,我们使用五个不同的 GNN(包括 GCN、GraphSAGE、GAT、SGC 和 TAGCN)在 Cora 和 Photo 数据集上评估预期校准误差(ECE)。我们发现 Cora 上的 ECE (10.25%-18.02%) 总是大于 Photo 上的 ECE (4.38%-8.27%),这表明在这种情况下校准性能更多地取决于数据集而不是 GNN 模型。受这种现象的启发,如图1所示,我们创新性地提出从以数据为中心的角度来校准GNN:我们可以冻结训练好的GNN并修改图数据来达到更好的校准性能而不损失精度吗? 为了支持以上动机,我们通过分析决定性边和同质边对校准性能的影响来进行观察实验。具体来说,决定性边是指对 GNN 的预测至关重要的边;同质边是指端点属于同一类的边。通过简单地为邻接矩阵中的决定性边或同质边分配较大的权重,我们发现可以在不显著降低分类精度的情况下提高校准性能,这显示出以数据为中心的校准的潜力。但请注意,上述观察实验中决定性边和同质边的定义都涉及图数据集中无标签节点的真实标签,因此不能直接在实践中使用。 受观察实验的结果启发,我们提出了以数据为中心的图校准(DCGC),它具有两个边加权模块来调整输入图。这两个模块分别受到决定性边和同质边上观察实验的启发,并依次对输入图进行调整:(1)对于决定性边的权重学习,我们参数化邻接矩阵并使GNN的预测损失能够反向传播到边权重。这样,边权重可以自动适应标签预测任务的需要,并且关键的边将被分配更高的权重。(2)对于同质边的权重计算,我们通过GNN预测的标签分布来量化每条边的同质性,并自适应地为同质性强的边分配更大的权重。此外,上述边权重的修改是在数据层面上进行的,并且可以很容易地与各种基于温度缩放的校准方法集成以达到更好的校准效果。在8个基准数据集上的实验表明,我们所提出的 DCGC 可以实现最先进的 (SOTA) 校准性能,ECE平均相对降低36.4%,我们的方法甚至可以稍微提高分类精度。消融实验和超参数分析进一步证明了我们方法的有效性和健壮性。 总而言之,我们的贡献有三方面:

- 我们创新性地提出从以数据为中心的角度来校准GNN,旨在修改图数据以获得更好的校准性能而不损失准确性。

- 我们提出了一种名为 DCGC 的新颖校准方法,通过为决定性边和同质边分配更大的权重。DCGC 在数据层面上运行,并且可以轻松地与之前基于温度缩放的校准方法集成。

- 实验表明,DCGC 可以在8个基准数据集上有效校准不同的GNN,并实现 SOTA 的校准性能,ECE平均相对降低36.4%。

二、预备知识

我们考虑为节点分类任务校准GNN的问题:给定一个图 ,训练数据由全部节点特征 ()和部分真实标签组成,目标是预测剩余节点 的标签。 图神经网络通过生成节点概率预测 () 来解决这个问题。预测对应的标签和置信度分别为 、。当GNN被完美校准时,有: 我们通常使用期望校准误差(Expected Calibration Error,ECE)来评估模型在分类问题中的预测置信度与实际准确性之间的差距。具体而言,它将预测分为不同的置信度区间,并计算每个置信度区间中的平均预测概率与实际准确性之间的差距。这个差距越小,表示模型的预测结果与真实情况越一致,模型的校准性能越好。以下是ECE损失的公式化定义: 使用M个等间隔置信区间对预测进行重新分组,即,其中,,那么,ECE损失可以定义为:

三、观察实验

在本节中,我们的目标是研究影响 GNN 校准的因素,并在最后给出两个关键的观察结果。具体来说,我们分别探讨了决定边和同质边对校准性能的影响。

3.1 观察实验设置

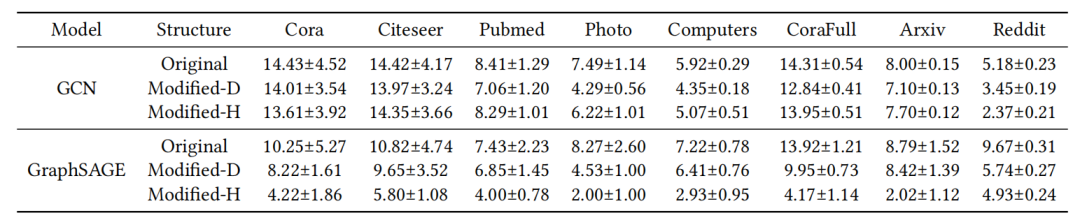

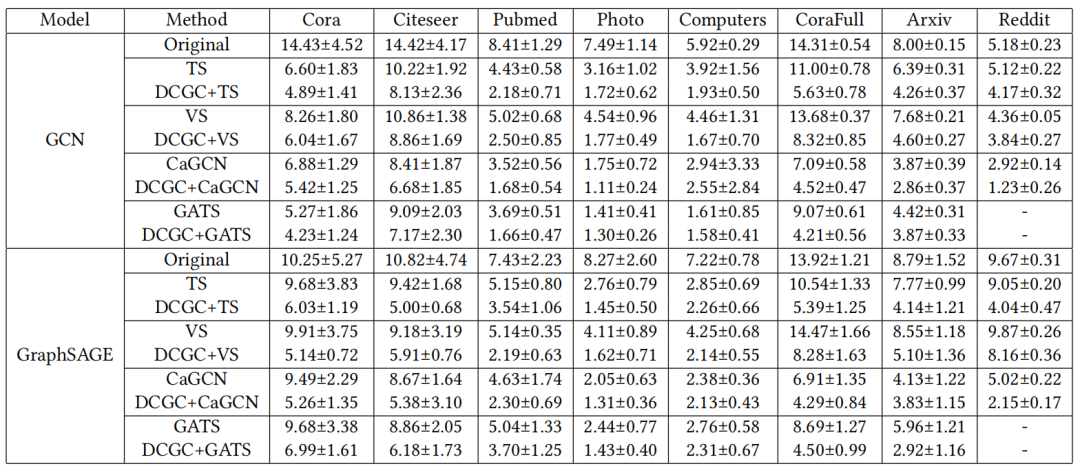

我们使用GCN和GraphSAGE在8个数据集上进行观察实验。对于每个数据集,我们首先在标准的半监督设置中训练GNN,并通过 ECE 评估校准性能。然后我们通过增强一些关键的边来调整邻接矩阵,并在不更新 GNN 参数的情况下重新评估校准性能。最后,我们观察当邻接矩阵A变为A'时ECE如何变化,即,比较和。 表1:8个数据集上GNN在原始/修改图形的校准性能。这里Modified-D和Modified-H分别表示基于决定性边和同质边的修改图。决定性边/同质边比不重要边/异质边分配更大的权重。ECE 分数 (%) 越低越好。

3.2 决定性边的影响

在 GNN 的训练过程中,对于最终的预测结果,某些边比其他边更重要。例如,在引文网络中,某些引文关系可能为 GNN 提供有用的上下文信息来决定未标记论文的类别。在本小节中,我们的目的是研究是否可以通过增大此类决定性边的权重来提高校准性能。为了量化每条边的重要性,我们可以计算当每条边从图中移除时 GNN 模型的测试节点的损失的变化。然而,这种计算的计算成本可能很高。因此,作为一种替代方法,我们计算测试集损失相对于邻接矩阵A的梯度,并取绝对值作为边缘重要性: 这些梯度代表了模型分类结果对边的敏感程度。梯度越大表明相应的边对预测的影响越大,可以被认为更具决定性。 接下来,我们将通过为决定性边分配更大的权重来修改邻接矩阵。由于梯度值可能变化很大,我们取梯度的对数,并除以其中位数,以标准化权重分布。形式上,边权重矩阵计算如下: 其中, 是一个略大于 1 的常数。然后我们将邻接矩阵修改为并重新评估校准性能:,其中是逐元素乘积。 表1 显示了 10 次实验中 GCN 和 GraphSAGE在 8 个数据集上的原始图/修改图的校准性能。结果表明,增大决定性边的权重对 GCN 和 GraphSAGE 在所有 8 个数据集上的校准性能都有积极影响。

3.3 同质边的影响

请注意,上述决定性边是模型特定的。对于节点分类任务,端点属于同一类别的边对于消息传递也至关重要,并且与 GNN 模型无关。在本小节中,我们的目的是研究是否可以通过增大此类同质边的权重来提高校准性能。 在此观察实验中,我们使用真实标签来定义同质边并启发式的设置边权重。具体来说,同质边的权重是异质边的权重的两倍。与上一小节类似,我们在训练好GNN之后修改邻接矩阵并重新评估校准性能。 表1 显示了 10 次实验中GCN 和 GraphSAGE在 8 个数据集上的原始图/修改图形的校准性能。我们可以看到,增大同质边的权重也给校准性能带来了显着的提升。

3.4 讨论

值得注意的是,决定性边和同质边是彼此相对独立的。例如,给定一个随机同质边和一个随机异质边,同质边具有较大重要性得分(根据公式(3)定义)的概率约为 0.55(如果它们完全独立,则为 0.5 )。因此,上述两个观察结果并不重叠。 更重要的是,上述邻接矩阵的修改在提高校准性能的同时并不会带来分类准确率的明显下降。因此,这些观察结果表明,我们可以通过修改边权重而不改变 GNN参数来校准训练好的GNN。 然而,决定性边和同质边的权重计算都涉及无标签节点的真实标签,因此不能直接在实践中使用。因此,在下一节中,我们将提出我们的方法,该方法可以识别这两种边并增大它们的权重,而无需使用真实标签。

四、方法

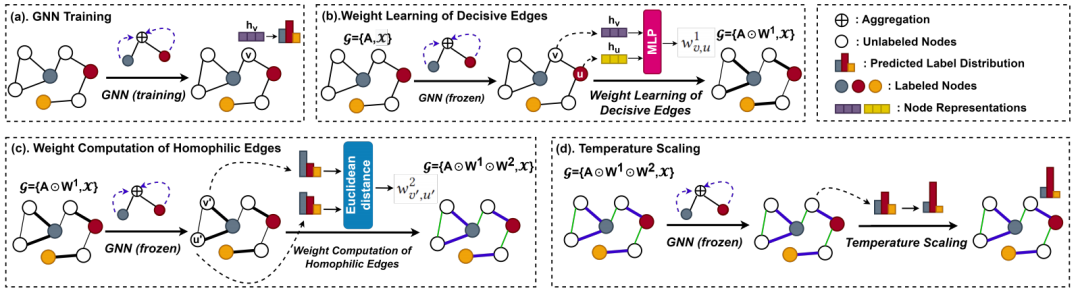

在本节中,我们提出了一种以数据为中心的 GNN 校准方法,称为以数据为中心的图校准(DCGC)。DCGC 可以应用于任何训练好的 GNN,并且也与之前基于温度缩放的方法兼容。 图2.我们提出的以数据为中心的图校准(DCGC)的概述。使用DCGC校准GNN的整个流程如下:(a)以半监督的方式训练需要校准的 GNN;(b)学习决定性边的权重并相应地修改邻接矩阵;(c)为同质边分配较大的权重并相应地修改邻接矩阵;(d) 将DCGC与任意基于温度缩放的校准方法集成。

4.1 方法概述

我们的方法概述如图2所示。给定一个训练好的 GNN,我们设计了两个模块来调整输入图的边权重。这两个模块分别受到决定性边和同质边的观察实验的启发,并依次对输入图进行处理。之后,可以集成基于温度缩放的方法来进一步调整标签预测的置信度。请注意,GNN 的参数在整个过程中被冻结。

4.2 决定性边的权重学习

受到第一个观察实验的启发,我们建议参数化邻接矩阵,并使预测损失能够反向传播到边权重。这样,可以自动调整边权重以满足标签预测的需要,并为关键的边分配更大的权重。 具体来说,我们首先设计一个可训练的模块,根据其端点的节点表示来估计边的权重。形式上来说,对于每条边,我们首先通过训练好的GNN得到节点和的嵌入:和,然后引入一个 2层MLP用于权重计算: 其中表示MLP中的参数,是连接操作。我们计算所有边的权重并将权重矩阵表示为,这是一个与邻接矩阵形状相同的稀疏矩阵。然后我们通过修改后的邻接矩阵重新计算 GNN 的预测 为了训练这个边加权模块,我们只需通过梯度下降最小化验证集上的交叉熵损失(之前的GNN校准方法也使用验证集进行参数学习): 其中是验证集,是矩阵中的对应元素 与3.2中的决定性边的观察实验相比,我们使用验证集上的预测损失来得到边权重,并通过训练来动态调整边权重。通过最小化公式(6),该模块为对分类任务至关重要的边分配更大的权重,以提高校准性能。

4.3 同质边的权重计算

受第二个观察实验的启发,我们提出通过GNN预测的标签分布来量化每个边的同质性,并为同质性较强的边缘分配更大的权重。该模块不需要训练,而且是启发式设计的。 具体来说,我们首先通过标签预测和之间的欧几里得距离来衡量边缘(v,u)的同质性,然后将边权重定义为: 其中,是具有温度缩放功能的softmax函数: 这里温度控制预测标签分布的锐度:较小的会让预测更接近one-hot向量。除了之外,另一个超参数可以确保当预测分布彼此太接近时,边权重不会过大。 然后我们收集所有边的权重并将权重矩阵表示为,这也是类似的一个稀疏矩阵。标签预测可以计算为: 与3.3中对同质边的观察实验相比,我们使用GNN预测的标签分布来定义同质边,并设计一个平滑函数,如公式(7)所示,计算边权重。该模块启发式地为具有相似标签分布的边分配更大的权重,有助于提高校准性能。

4.4 与温度缩放集成

上述边权重的修改是在数据层面上进行的,并且可以很容易地与之前基于温度缩放的方法集成以获得更好的校准性能。 具体来说,给定权重矩阵,我们将节点由编码的表示记为。然后,我们修改预测的计算,将节点的预测定义为,其中是温度。实际上,温度可以是全局的、类特定的或节点特定的。我们将在实验中评估DCGC与不同温度缩放方法的集成效果。 最后,我们将作为算法输出并计算 来对GNN进行校准性能评估。请注意,我们仅对现有边的边权重进行建模,因此具有线性计算复杂性。

五、实验

5.1 准确率和校准性能

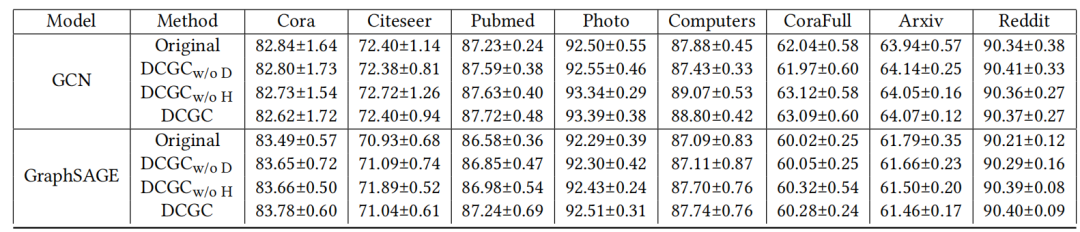

表2:未校准的GNN及其基于 DCGC 的校准版本的分类准确率(以百分比表示)。准确度越高越好。

表3:不同的校准方法在八个数据集上的校准结果。ECE分数(%)越低越好。

准确率和校准效果的结果分别显示在表2和表3中,根据表中的结果我们有以下结论: (1)在总结我们方法的校准性能之前,我们首先说明我们以数据为中心的方法不会损害分类精度。如表2所示,与未校准的GCN和GraphSAGE相比,DCGC及其变体具有相当的甚至更好的预测精度。DCGC 相对于GCN/GraphSAGE在准确率上的平均相对提升分别为 0.51%/0.32%。因此,我们提出的 DCGC 不会牺牲准确率来达到校准的目的,而是可以带来准确率提升这一副产物。 (2) 通过与基于温度缩放的方法集成,DCGC可以在所有数据集和GNN上实现SOTA的校准性能。在ECE方面,DCGC对于TS、VS、CaGCN和GATS的平均相对改进分别为39.8%、38.6%、34.4%和33.0%。事实上,即使对于TS,DCGC+TS 也已经比 SOTA GNN 校准方法,即,CaGCN和GATS更好。这一结果验证了我们提出的以数据为中心的校准的有效性和兼容性。 对于一些数据集,例如 Pubmed,专用于GNN的校准方法(CaGCN 和 GATS)与图无关的方法(TS和VS)相比并没有表现出显著的优势。因此,仅利用图形信息对特定节点的温度进行建模可能无法充分利用结构数据。相比之下,我们的 DCGC通过修改输入图来校准 GNN 预测,因此对校准性能有更大的影响。

5.2 消融实验

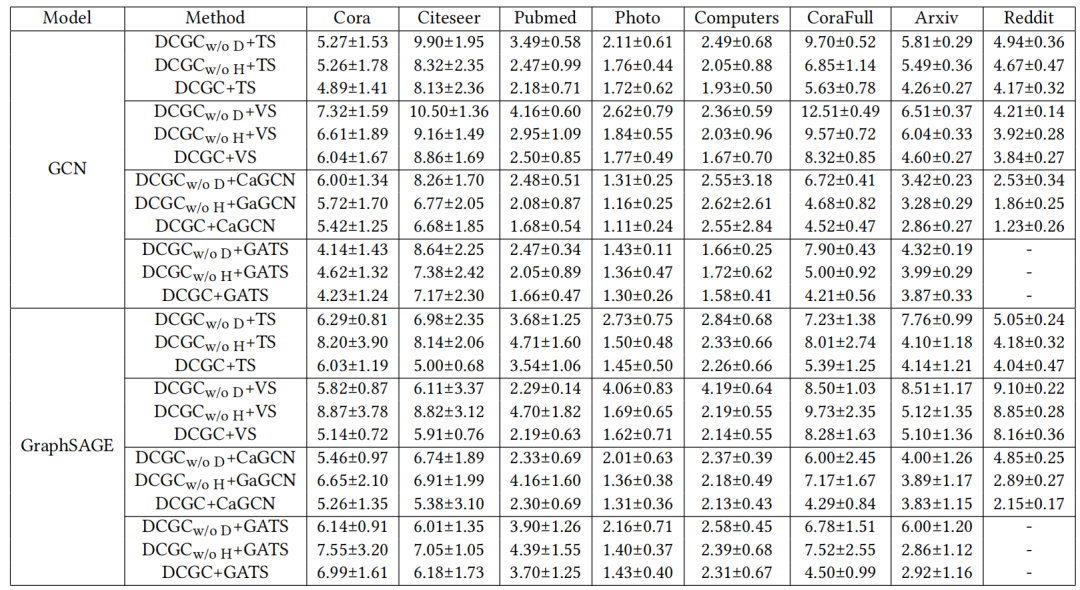

在本小节中,我们将进行消融研究来讨论 DCGC 中两个加权模块的影响。两个消融变体,即和,分别删除了决定性边和同质边。消融模型的准确率和校准性能如表2和表4所示。从结果中我们可以看出: (1) 完整模型 DCGC 比两个消融变体具有更好的校准性能,ECE平均相对降低 22.03% 和 15.29%。因此,决定性边和同质边的加权模块都有助于提升DCGC的校准性能,这验证了我们设计的有效性。 (2) 与未校准的 GNN 相比,和都具有相当的甚至更好的分类准确率。这两种消融变体还可以提高温度缩放方法的校准性能。因此,两个加权模块可以单独使用来校准 GNN,而不会牺牲预测精度。 (3)决定性边加权模块比同质边加权模块更重要。与相比,在精度和校准性能方面相对提高了0.44%和7.36%。一个可能的原因是,决定性边加权模块是通过优化学习的,而不是启发式设计的。我们将在未来的工作中探索更强大的同质边加权方法。 表4:不同消融变体在八个数据集上的校准效果。ECE分数越低越好。

六、结论

在本文中,我们提出了一种新的以数据为中心的图神经网络校准视角,其目的是在不牺牲预测准确率的情况下修改图结构以获得更好的校准性能。通过分析决定性边和同质边对校准的影响,我们设计了具有两个相应边加权模块的DCGC,它们可以自适应地为关键的边分配更大的权重。我们所提出的 DCGC 还与现有的基于温度缩放的校准方法高度兼容。在八个数据集上的实验结果证明了 DCGC 的有效性和高效性。 在未来的工作中,我们将探索 DCGC 在图级任务以及其他值得信赖的图学习场景上的潜力。还可以用更强大的算法代替同质边加权模块的启发式设计。