报告主题:Function Norms for Neural Networks

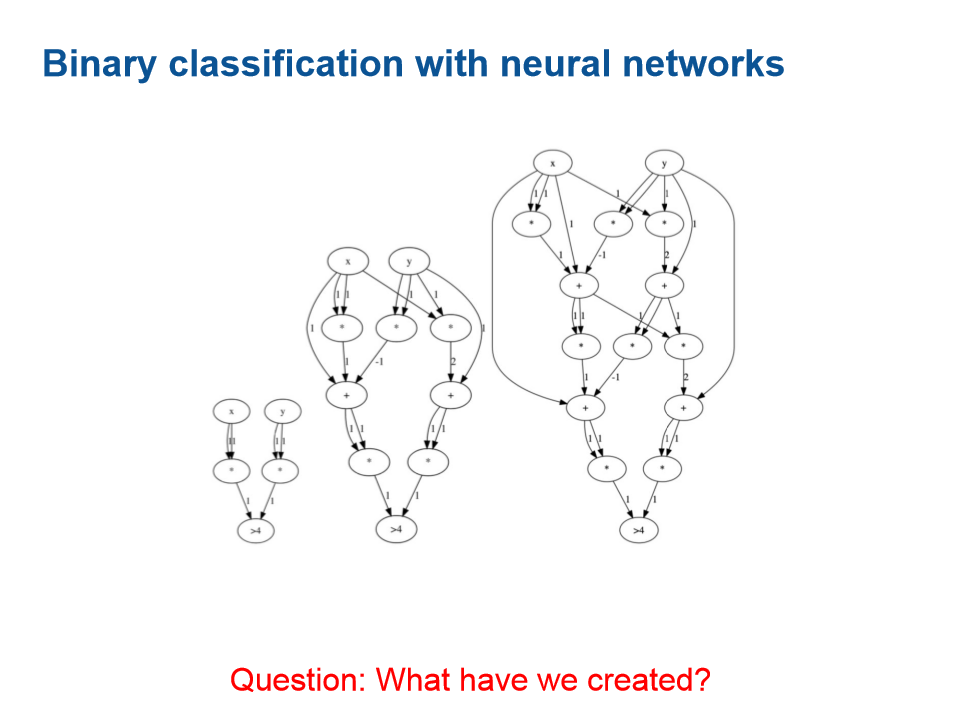

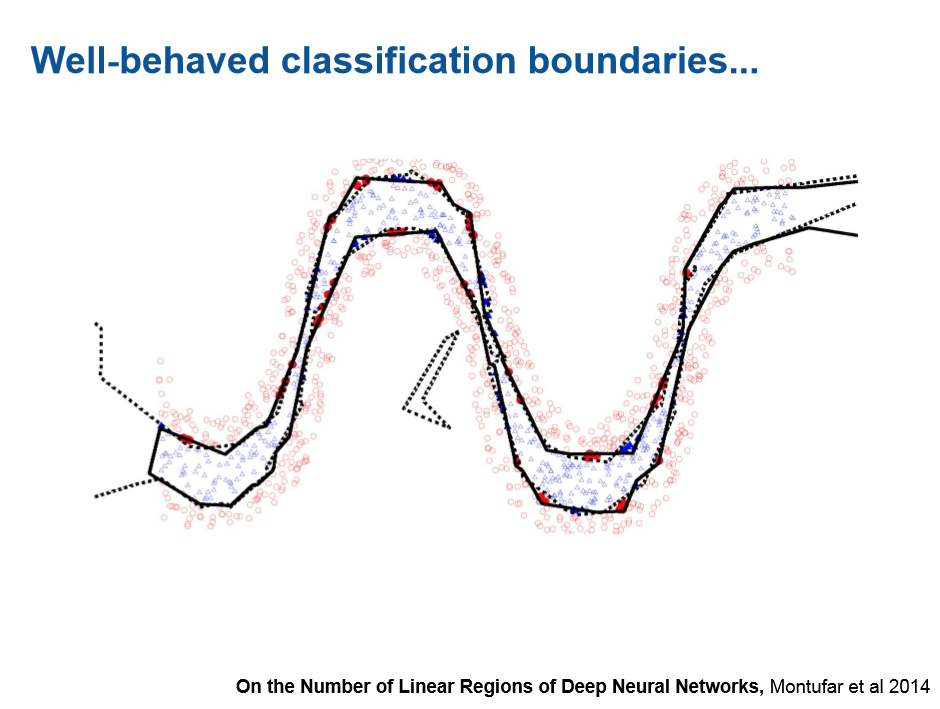

报告摘要:深度神经网络(DNN)由于在各种问题上的出色经验性能而变得越来越重要。 但是,正规化通常是通过间接方式实现的,这主要是由于网络定义的功能复杂集和衡量功能复杂性的原因。 正如统计学习理论中传统考虑的那样,文献中没有基于函数范数进行加法正则化的方法。 在这项工作中,作者研究了具有ReLU激活的深度神经网络的功能规范的可扩展性。 据了解,作者提供了有关3层或更多层DNN的计算函数范数的NP硬度的文献中的第一个证明。 还强调浅层和深层网络之间的根本区别。 根据这些结果,提出了一种基于近似函数范数的新正则化策略,并展示了其在具有DNN的分割任务中的效率。

邀请嘉宾:Amal Rannen Trik,鲁汶大学

成为VIP会员查看完整内容

相关内容

专知会员服务

54+阅读 · 2020年3月5日

专知会员服务

32+阅读 · 2020年2月26日

专知会员服务

148+阅读 · 2019年12月28日

专知会员服务

8+阅读 · 2019年12月3日

专知会员服务

36+阅读 · 2019年10月9日

Arxiv

7+阅读 · 2018年5月21日

Arxiv

5+阅读 · 2018年4月13日

Arxiv

10+阅读 · 2018年1月4日