本文考虑图遗忘学习问题,将图神经网络模型训练到指定的准确度,然后部署图神经网络模型,同时一系列请求到达,从模型中删除图元素(节点、边)。随着GNN模型在现实世界中的应用,解决这个问题变得越来越重要——例如,当用户试图隐藏他们在社交图中与其他人的联系时,或者当知识图谱中的关系变得不相关或不再真实时。

要从经过训练的GNN中删除信息,必须从模型中删除其对GNN模型权重以及对图中邻居表示的影响。然而,现有的通过再训练和权重修改的方法要么降低了所有节点共享的模型权重,要么由于删除的边对局部图邻域的强依赖性而失效。认识到这些陷阱,本文以删除边一致性和邻域影响的形式形式化了图遗忘学习所需的属性,并开发了GNNDelete,一种与模型无关的逐层算子,为遗忘学习任务优化这两个属性。 GNNDelete更新潜在表示,从模型中删除节点和边,同时保持学到的其余知识的完整性。在6个真实世界和2个知识图谱上的实验表明,与现有的图忘记模型相比,GNNDelete在链路预测任务上的AUC最高可达36.9%,在区分删除边和未删除边的AUC最高可达22.5%。GNNDelete高效——例如,与在大型知识图谱上从头开始训练相比,它需要的时间减少12.3倍,空间减少9.3倍。

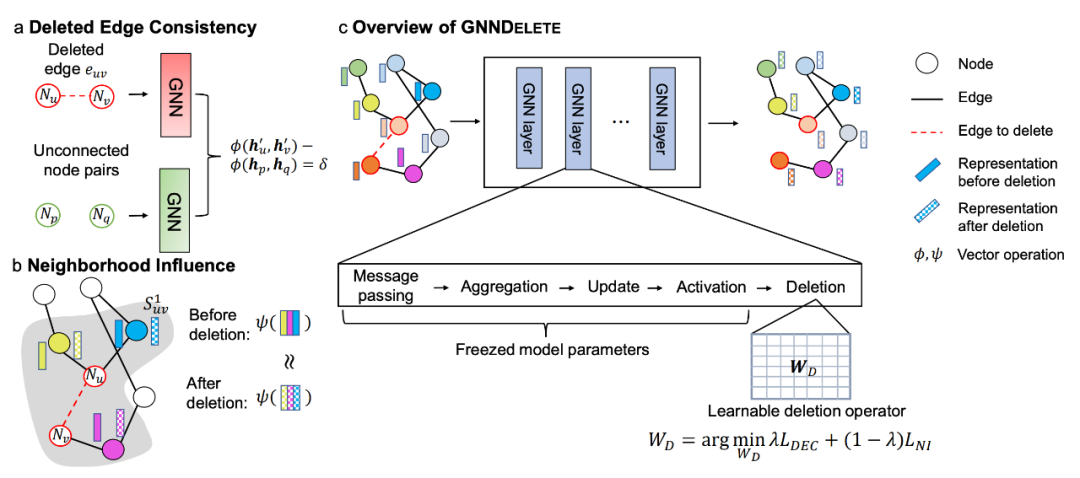

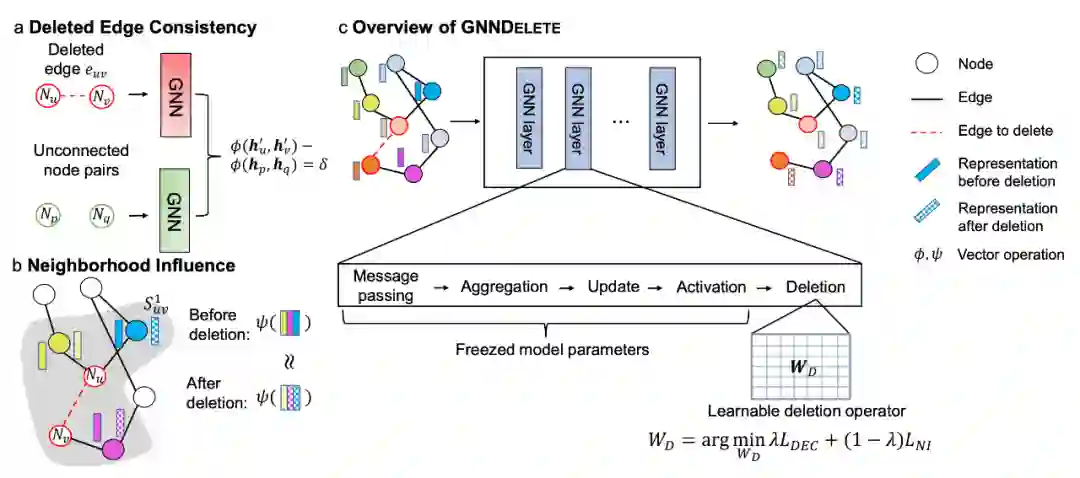

图神经网络(GNN)在现实世界中的应用越来越多,在大多数部署的GNN中,底层图会随着时间的推移而变化。传统的机器学习方法通常是离线工作的,其中模型使用完整的训练数据集进行一次训练,然后锁定用于推理,对模型进行少量更新。相比之下,在线训练可以在新的训练数据点可用时使用它们更新模型。然而,离线和在线学习都无法处理数据删除——即在不牺牲模型性能的情况下从模型中删除数据点的所有痕迹的任务。当需要从模型中删除数据时,模型必须进行相应的更新。例如,GNN必须实施保护个人隐私的隐私条款(如加州消费者隐私法(CCPA)和通用数据保护条例(GDPR)),这意味着赋予GNN数据删除能力是重要的,但在文献中研究较少。 然而,设计图遗忘学习方法是具有挑战性的。仅删除数据不足以满足最近对增加数据隐私的要求,因为在原始数据上训练的模型可能仍然包含有关其模式和特征的信息。一种简单的方法是删除数据并从头开始重新训练模型。然而,这可能非常昂贵,特别是在大型数据集上。 本文提出GNNDelete,一种用于图遗忘的通用方法。我们形式化了两个关键的GNN删除属性: * 删除边的一致性:未学习模型删除边的预测概率应该与不存在边的预测概率相似。该属性强制GNNDelete删除被删除的边伪装成未连接的节点等信息。 * 邻域影响:在图的删除和Granger因果关系之间建立联系,以确保删除后的局部子图不受影响,从而保持原始的预测依赖关系。然而,现有的图删除方法没有考虑这一本质属性,即没有考虑局部连通性的影响,导致次优删除。

利用这两个属性,我们开发了GNNDelete,一个逐层删除操作符来更新节点表示。当接收删除请求时,GNNDelete冻结模型并学习在所有节点中共享的额外的小门控权重矩阵。与现有方法不同,现有方法试图从头开始重新训练几个小型模型或直接更新模型权重,这可能是低效和次优的,GNNDelete使用小型可学习矩阵进行推理,而不改变GNN模型权重,实现了效率和可扩展性。为了优化GNNDelete,指定了一个新的目标函数,满足删除边的一致性和邻域影响,产生强的整体删除。