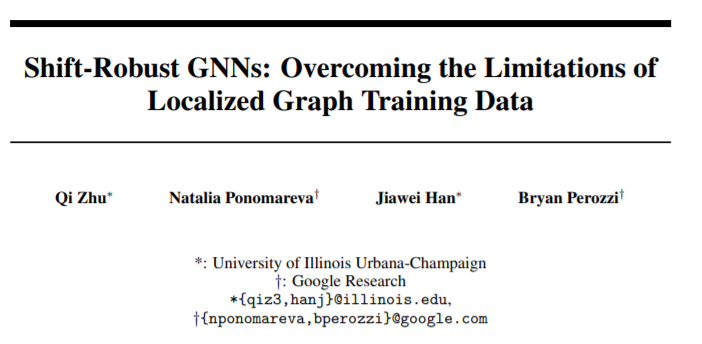

让图网络更稳健!谷歌提出SR-GNN,无惧数据标记偏差和领域转移

新智元报道

新智元报道

编辑:David

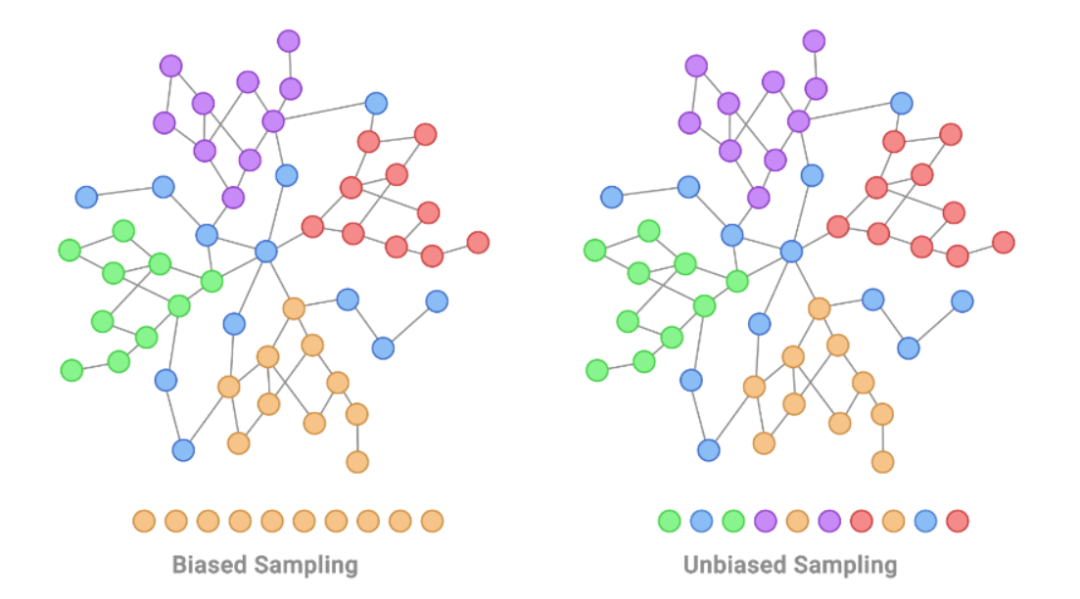

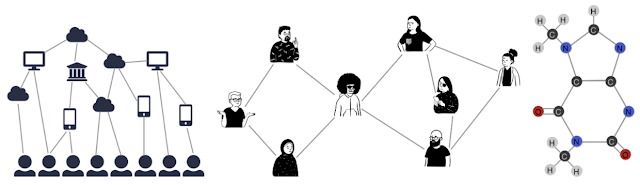

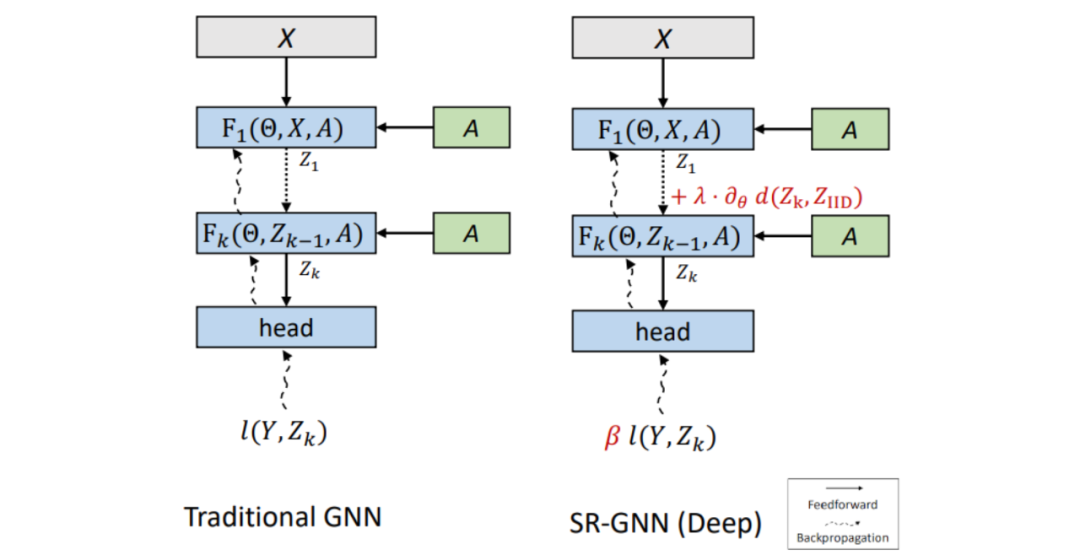

【新智元导读】图神经网络(GNN)是机器学习的强大工具之一,但在训练数据上往往依赖于特定领域,为了解决由领域转移和数据标记偏差造成的性能下降,谷歌提出了一种新方法。

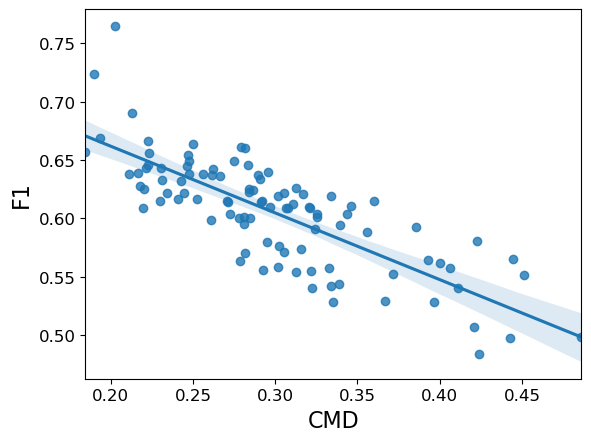

数据分布偏移对GNN性能的影响

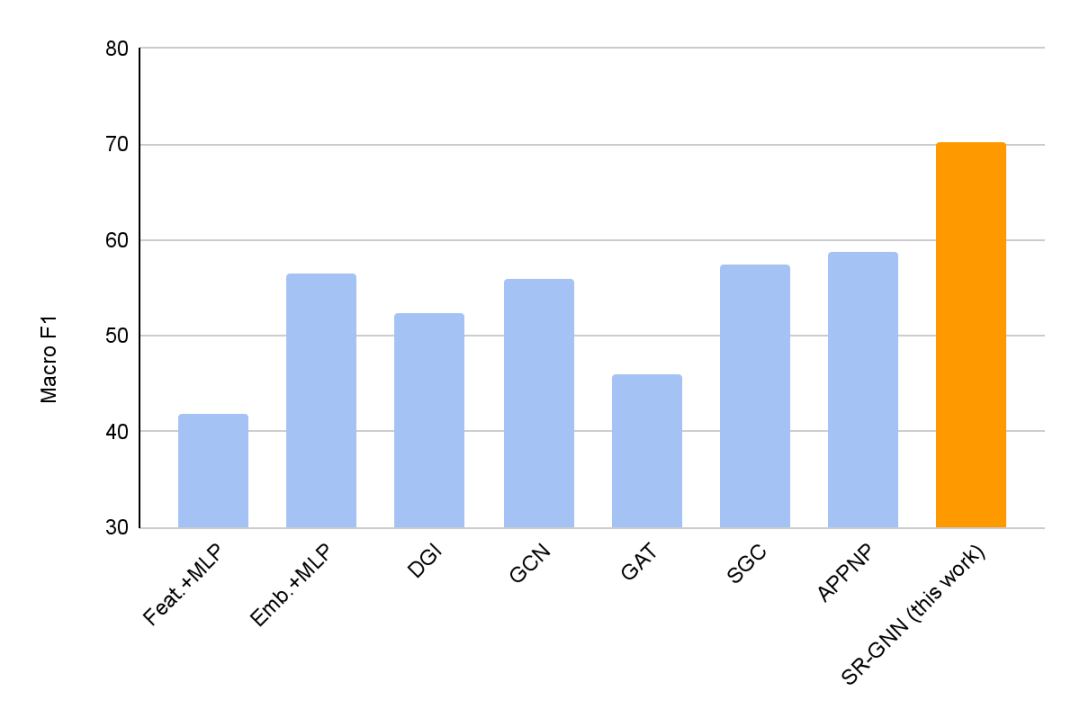

结论

登录查看更多