近期必读的五篇顶会 ACL 2020【图神经网络 (GNN) 】相关论文

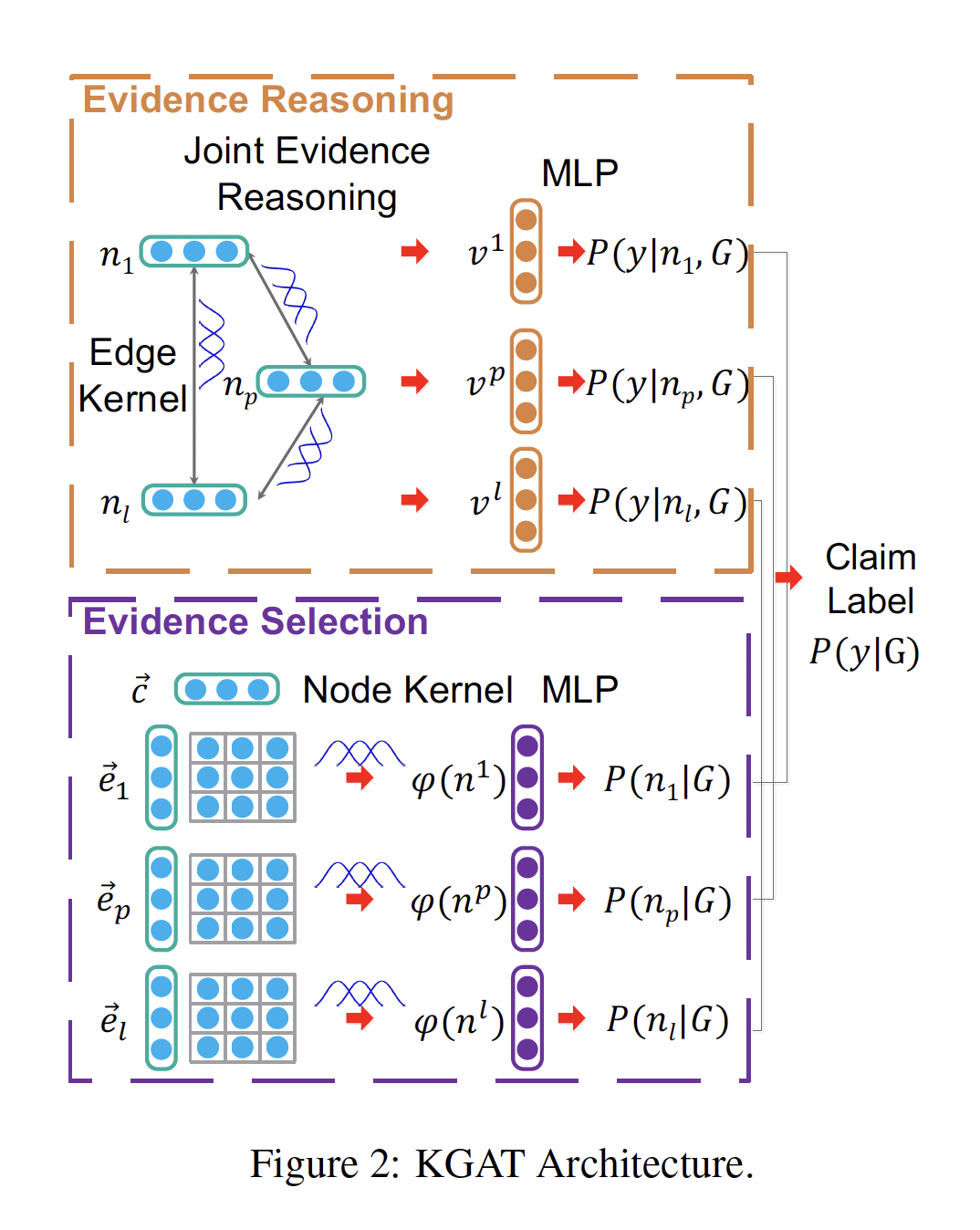

1. Fine-grained Fact Verification with Kernel Graph Attention Network

作者:Zhenghao Liu, Chenyan Xiong, Maosong Sun, Zhiyuan Liu

摘要:事实验证(Fact V erification)需要细粒度的自然语言推理能力来找到微妙的线索去识别句法和语义上正确但没有强有力支持的声明(well-supported claims)。本文提出了基于核方法的图注意力网络(KGAT),该网络使用基于核的注意力进行更细粒度的事实验证。给定一个声明和一组形成证据图潜在证据的句子,KGAT在图注意力网络中引入了可以更好地衡量证据节点重要性的节点核,以及可以在图中进行细粒度证据传播的边缘核,以实现更准确的事实验证。KGAT达到了70.38%的FEVER得分,在FEVER上大大超过了现有的事实验证模型(FEVER是事实验证的大规模基准)。我们的分析表明,与点积注意力相比,基于核的注意力更多地集中在证据图中的相关证据句子和有意义的线索上,这是KGAT有效性的主要来源。

网址:

https://arxiv.org/pdf/1910.09796.pdf

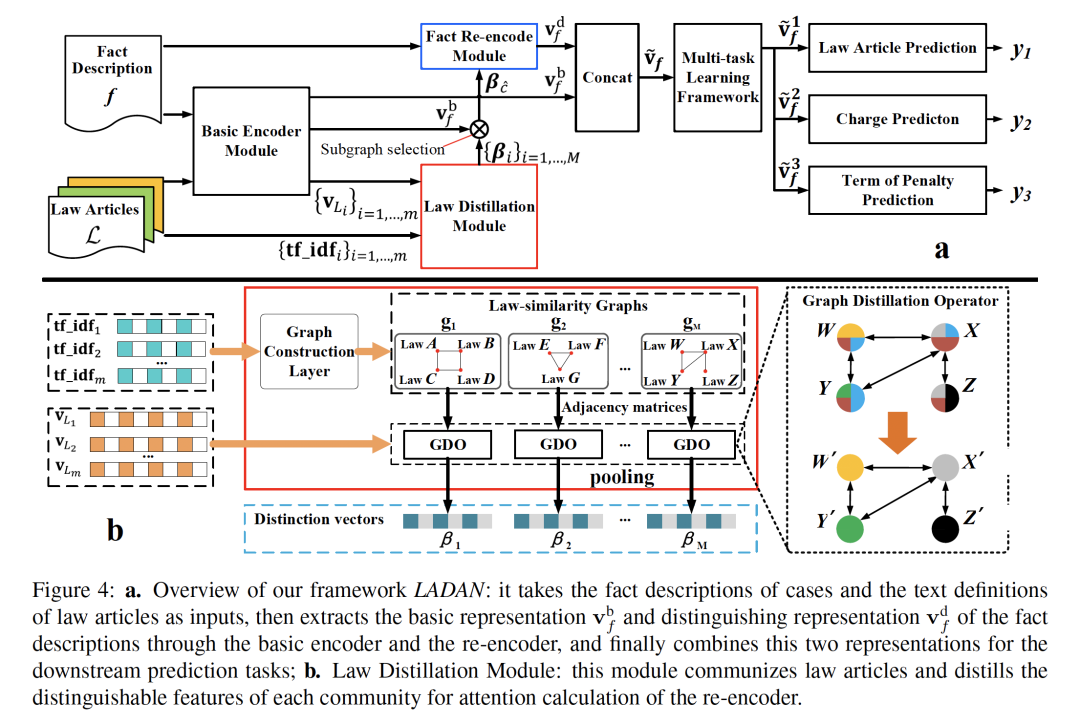

2. Distinguish Confusing Law Articles for Legal Judgment Prediction

作者:Nuo Xu, Pinghui Wang, Long Chen, Li Pan, Xiaoyan Wang, Junzhou Zhao

摘要:法律审判预测(LJP)是在给出案件事实描述文本的情况下,自动预测案件判决结果的任务,其在司法协助系统中具有良好的应用前景,为公众提供方便的服务。实际上,由于适用于类似法律条款的法律案件很容易被误判,经常会产生混淆的指控。在本文中,我们提出了一个端到端的模型--LADAN来解决LJP的任务。为了解决这一问题,现有的方法严重依赖领域专家,这阻碍了它在不同法律制度中的应用。为了区分混淆的指控,我们提出了一种新的图神经网络来自动学习混淆法律文章之间的细微差别,并设计了一种新的注意力机制,该机制充分利用学习到的差别从事实描述中提取令人信服的鉴别特征。在真实数据集上进行的实验证明了我们的LADAN算法的优越性。

网址:

https://arxiv.org/pdf/2004.02557.pdf

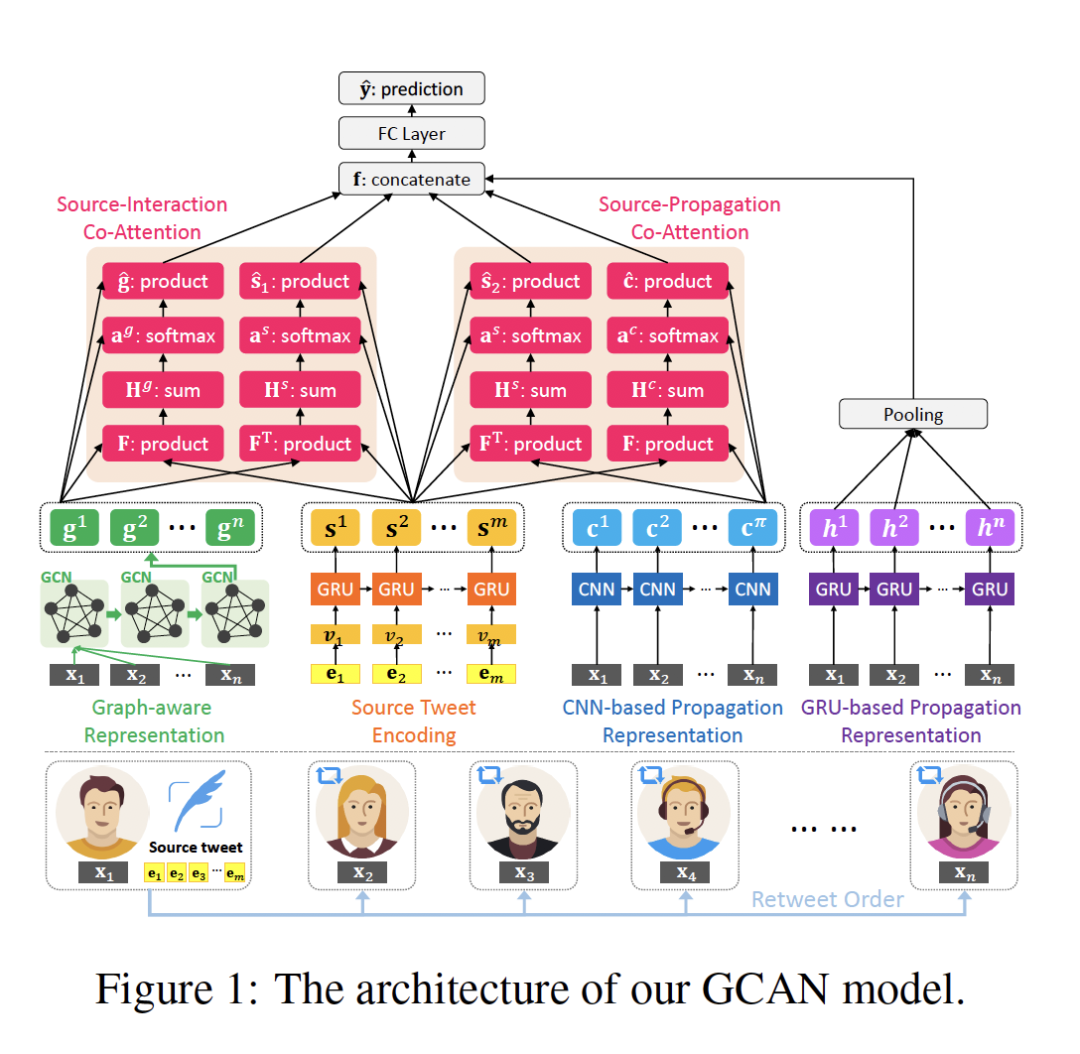

3. GCAN: Graph-aware Co-Attention Networks for Explainable Fake News Detection on Social Media

作者:Yi-Ju Lu, Cheng-Te Li

摘要:本文解决了在更现实的社交媒体场景下的假新闻检测问题。给定源短文本推文和相应的没有文本评论的转发用户序列,我们的目的是预测源推文是否是假的,并通过突出可疑转发者的证据和他们关注的词语来产生解释。为了实现这一目标,我们提出了一种新的基于神经网络的模型--图感知协同注意网络(GCAN)。在真实推文数据集上进行的广泛实验表明,GCAN的平均准确率比最先进的方法高出16%。此外,案例研究还表明,GCAN可以给出合理的解释。

网址:

https://arxiv.org/pdf/2004.11648.pdf

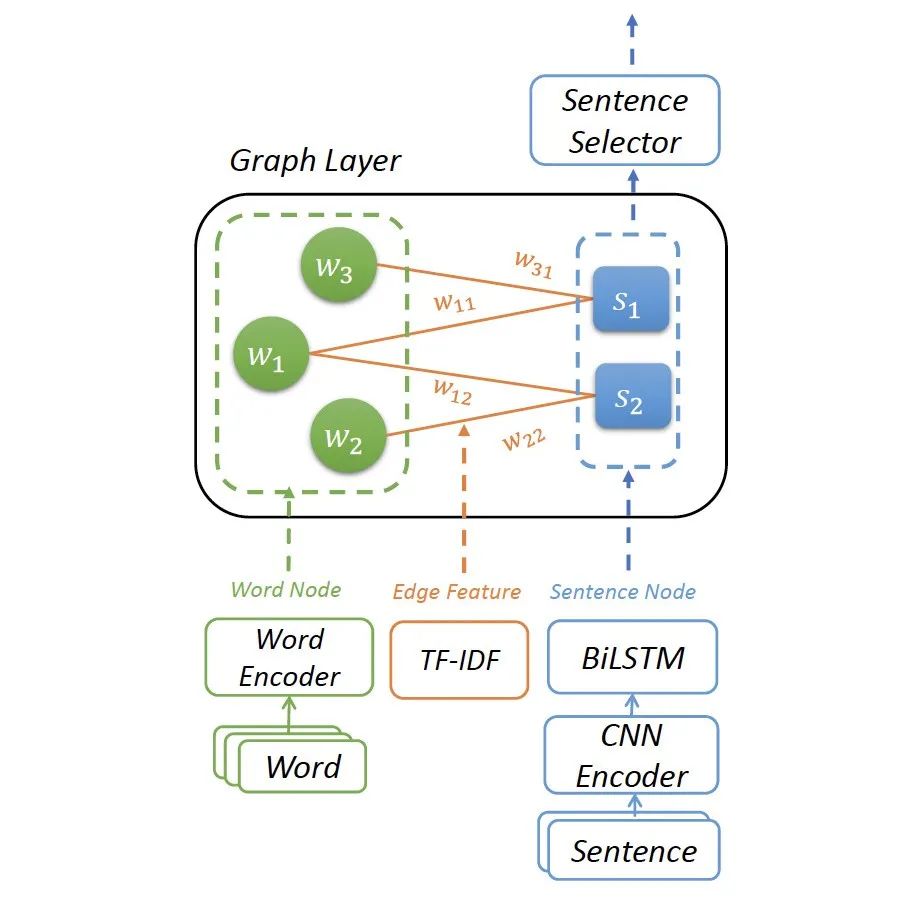

4. Heterogeneous Graph Neural Networks for Extractive Document Summarization

作者:Danqing Wang, Pengfei Liu, Yining Zheng, Xipeng Qiu, Xuanjing Huang

摘要:作为提取文档摘要的关键步骤,跨句关系学习已经有了大量的研究方法。一种直观的方法是将它们放入基于图的神经网络中,该网络具有更复杂的结构来捕获句间关系。本文提出了一种基于图的异构神经网络抽取摘要算法(HeterSUMGraph),该算法除句子外,还包含不同粒度的语义节点。这些额外的结点起到句子之间的中介作用,丰富了句子之间的关系。此外,通过引入文档节点,我们的图结构可以灵活地从单文档设置自然扩展到多文档设置。据我们所知,我们是第一个将不同类型的节点引入到基于图的神经网络中进行提取文档摘要的,我们还进行了全面的定性分析,以考察它们的好处。

网址:

https://arxiv.org/pdf/2004.12393.pdf

代码链接:

https://github.com/brxx122/HeterSUMGraph

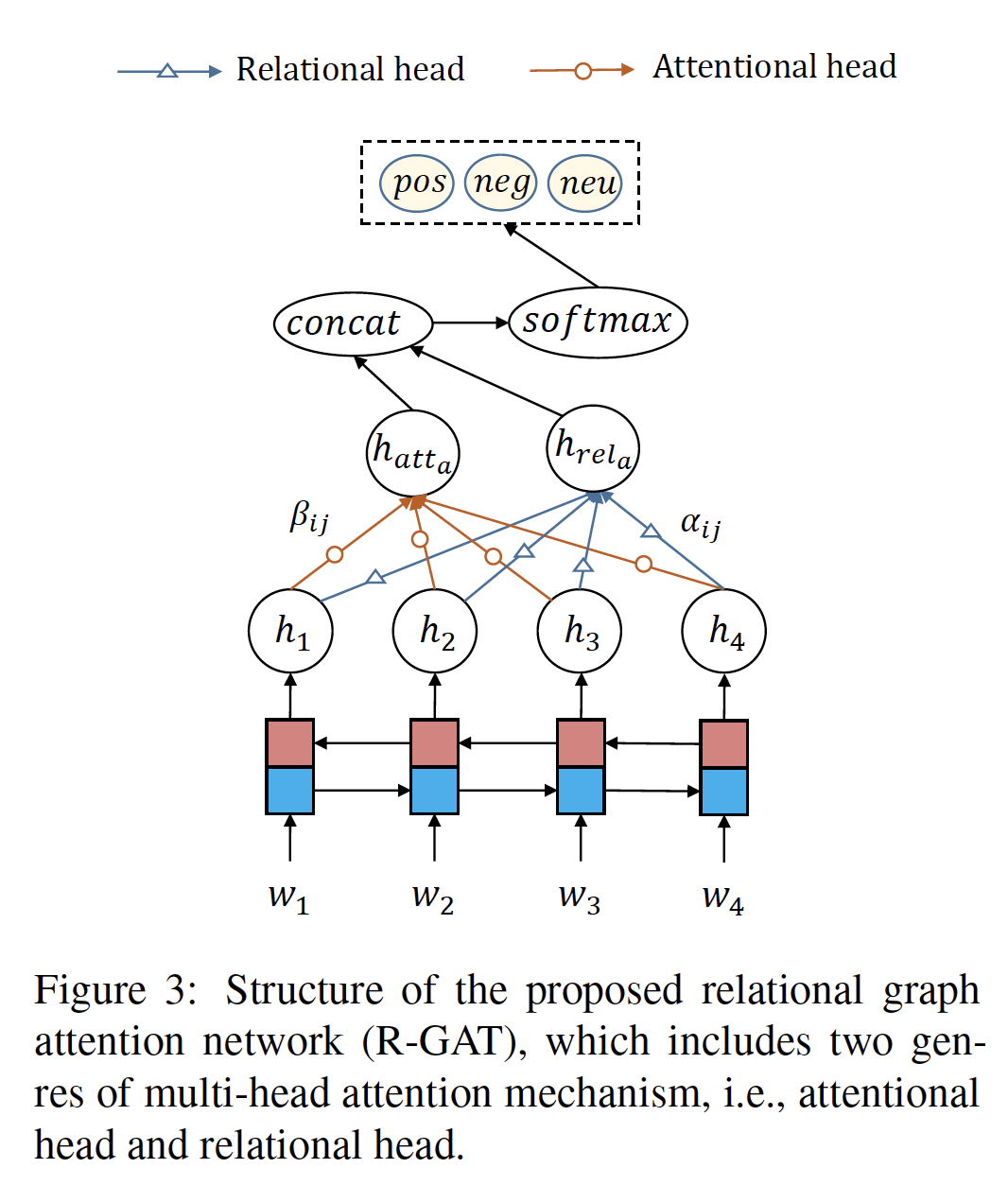

5. Relational Graph Attention Network for Aspect-based Sentiment Analysis

作者:Kai Wang, Weizhou Shen, Yunyi Yang, Xiaojun Quan, Rui Wang

摘要:Aspect级的情感分析旨在确定在线评论中对某一特定方面的情感极性。最近的大多数努力采用了基于注意力的神经网络模型来隐式地将aspect与观点词联系起来。然而,由于语言的复杂性和单句中多个aspect的存在,这些模型往往混淆了它们之间的联系。在本文中,我们通过对语法信息进行有效的编码来解决这个问题。首先,我们通过重塑和修剪常规依赖关系树,定义了一个以目标方面为根的统一的面向aspect的依赖树结构。然后,我们提出了一种关系图注意力网络(R-GAT)来编码新的树结构用于情感预测。我们在SemEval 2014和Twitter数据集上进行了广泛的实验,实验结果证实,该方法可以更好地建立aspect和观点词之间的联系,从而显著提高了图注意网络(GAT)的性能。

网址:

https://arxiv.org/pdf/2004.12362.pdf

请关注专知公众号(点击上方蓝色专知关注)

后台回复“ACL2020GNN” 就可以获取《5篇顶会ACL 2020【图神经网络(GNN)】相关论文》的pdf下载链接~