【导读】ICML(International Conference on Machine Learning),即国际机器学习大会, 是机器学习领域全球最具影响力的学术会议之一,因此在该会议上发表论文的研究者也会备受关注。因疫情的影响, 今年第37届ICML大会已于2020年7月13日至18日在线上举行。据官方统计,ICML 2020共提交4990篇论文,接收论文1088篇,接收率为21.8%。与往年相比,接收率逐年走低。小编发现基于对比学习(Contrastive Learning)相关的paper也不少,对比学习、自监督学习等等都是今年比较火的topic,受到了很多人的关注。

为此,这期小编继续为大家奉上ICML 2020必读的六篇对比学习(Contrastive Learning)相关论文——SimCLR、对比多视角图学习、对比强化学习、CPC、分解GAN、

ICML 2020 Accepted Paper: https://proceedings.icml.cc/book/2020

ICML2020CI、ICML2020GNN_Part2、ICML2020GNN_Part1

1、A Simple Framework for Contrastive Learning of Visual Representations

作者:Ting Chen、Simon Kornblith、Mohammad Norouzi、Geoffrey Hinton

摘要:本文提出了SimCLR:一种简单的视觉表示的对比学习(contrastive learning)框架。我们简化了最近提出的对比自监督学习算法,并且不需要专门的体系结构或存储库。为了理解什么使对比预测任务能够学习有用的表示,我们系统地研究了我们框架的主要组成部分。我们表明:(1)数据增强部分在定义有效的预测任务中起着关键作用;(2)在表示和对比损失之间引入可学习的非线性变换大大提高了学习表示的质量;(3)与监督学习相比,对比学习受益于更大的batch和更多的训练。结合这些发现,我们能够在ImageNet上显著优于以往的自监督和半监督学习方法。在通过SimCLR学习得到的自监督表示上训练的线性分类器达到了76.5%的TOP-1准确率,比以前的技术相对提高了7%,与监督ResNet-50的性能相当。当只对1%的标签进行微调时,我们达到了85.8%的TOP-5准确率,在标签减少100倍的情况下表现优于AlexNet。

代码: https://github.com/google-research/simclr

网址: https://proceedings.icml.cc/paper/2020/hash/36452e720502e4da486d2f9f6b48a7bb

2、Contrastive Multi-View Representation Learning on Graphs

作者:Kaveh Hassani、Amir Hosein Khasahmadi

摘要:我们介绍了一种通过对比图的结构视图来学习节点级和图级表示的自监督方法。我们表明,与视觉表示学习不同的是,将视图数增加到两个以上或对比多尺度编码并不能提高性能,并且通过对比来自一阶邻居的编码和图扩散( graph diffusion)可以获得最佳性能。在线性评估协议下,我们的模型在8个节点和图分类基准上有8个取得了最新结果。例如,在CORA(节点)和Reddit-Binary(图)分类基准上,我们达到了86.8%和84.5%的准确率,比以前的技术水平分别提高了5.5%和2.4%。与监督基线相比,我们的方法在8个基准中有4个表现优于它们。

网址: https://proceedings.icml.cc/paper/2020/hash/de73998802680548b916f1947ffbad76

3、CURL: Contrastive Unsupervised Representations for Reinforcement Learning

作者:Michael Laskin、Aravind Srinivas、Pieter Abbeel

摘要:我们提出了CURL—用于强化学习的对比无监督表示法。CURL使用对比学习从原始像素中提取高层特征,并在提取的特征之上执行非策略控制。在DeepMind Control Suite和Atari Games的复杂任务上,无论是基于模型的方法还是非模型的方法,CURL的表现都优于之前基于像素的方法,在100K环境和交互步骤基准下分别显示1.9倍和1.2倍的性能提升。在DeepMind Control Suite上,CURL是第一个几乎与使用基于状态特征的方法的采样效率相当的基于图像的算法。

代码: https://www.github.com/MishaLaskin/curl

网址: https://proceedings.icml.cc/paper/2020/hash/800b03685c22049f049801f6841861a2

4、Data-Efficient Image Recognition with Contrastive Predictive Coding

作者:Olivier J. Hénaff、Aravind Srinivas、Jeffrey De Fauw、Ali Razavi、Carl Doersch、S. M. Ali Eslami、Aaron van den Oord

摘要:人类观察者从少数几个例子中可以学会识别新的图像类别,但使用人造图像做到这一点仍然是一个挑战。我们假设通过表示使数据有效识别成为可能,这些表示使自然信号的可变性更加可预测。因此,我们重新改进了对比预测编码,这是学习这种表示的一个无监督目标。此新实现产生的特征可以支持ImageNet数据集上的最新线性分类准确性。当使用深度神经网络作为非线性分类的输入时,这种表示允许我们使用比直接在图像像素上训练的分类器少2-5倍的标签。最后,这种无监督表示大大改善了对Pascal VOC数据集上的目标检测的迁移学习,超过了全监督预训练的ImageNet分类器。

网址: https://proceedings.icml.cc/paper/2020/hash/4b26dc4663ccf960c8538d595d0a1d3a

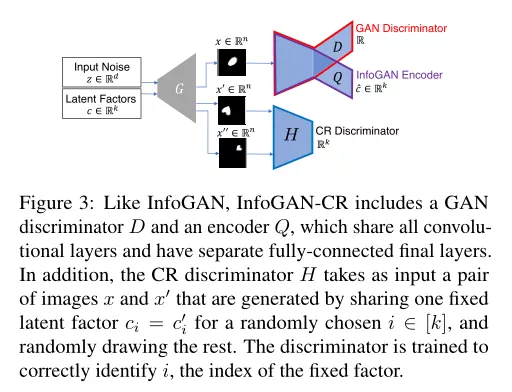

5、InfoGAN-CR and ModelCentrality: Self-supervised Model Training and Selection for Disentangling GANs

作者:Zinan Lin、Kiran K. Thekumparampil、Giulia Fanti1Sewoong Oh

摘要:分解(disentangled)的生成模型将潜在向量映射到目标空间,同时强制学习的潜在子集是可解释的,并且与目标分布的不同属性相关联。最近的进展主要是基于变分自编码器(VAE)的方法,而训练分离的生成式对抗网络(GANS)仍然是具有挑战性的。在这项工作中,我们证明了分离的GAN面临的主要挑战可以通过使用自监督来缓解。我们的主要贡献有两个:第一,我们设计了一种新的具有自监督功能的分离GANs训练方法。我们提出了对比正则化(contrastive regularizer)算法,它的灵感来自于一个自然的分解概念:latent traversal。这比最先进的基于VAE和GAN的方法获得了更高的分离分数。其次,我们提出了一种称为ModelCentrality的无监督模型选择方案,它使用生成的合成样本来计算模型集合的medoid(多维中值推广)。令人惊讶的是,这种无监督的ModelCentrality能够选择比使用现有的监督超参数选择技术训练的模型性能更好的模型。将对比正则化和ModelCentrality相结合,在不需要有监督超参数选择的情况下,大幅度地获得了最先进的分离分数。

网址: https://proceedings.icml.cc/paper/2020/hash/ea96efc03b9a050d895110db8c4af057

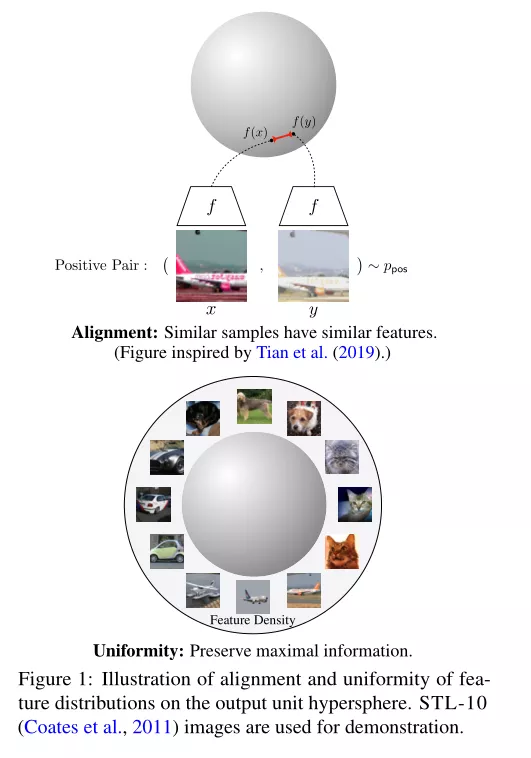

6、Understanding Contrastive Representation Learning through Alignment and Uniformity on the Hypersphere

作者:Tongzhou Wang、Phillip Isola

摘要:对比表示学习在实践中取得了显著的成功。在这项工作中,我们确定了与对比损失相关的两个关键性质:(1)正对特征的对齐方式(紧密度)和(2)超球面上(归一化)特征诱导分布的均匀性。我们证明,渐近地,对比损失优化了这些属性,并分析了它们对下游任务的积极影响。根据经验,我们引入了一个可优化的指标来量化每个属性。在标准视觉和语言数据集上的大量实验证实了指标与下游任务性能之间的强烈一致性。直接针对这两个指标进行优化可以使下游任务的表现比对比学习更好或更高。

代码: https://github.com/SsnL/align_uniform

网址:

https://proceedings.icml.cc/paper/2020/hash/4b85256c4881edb6c0776df5d81f6236