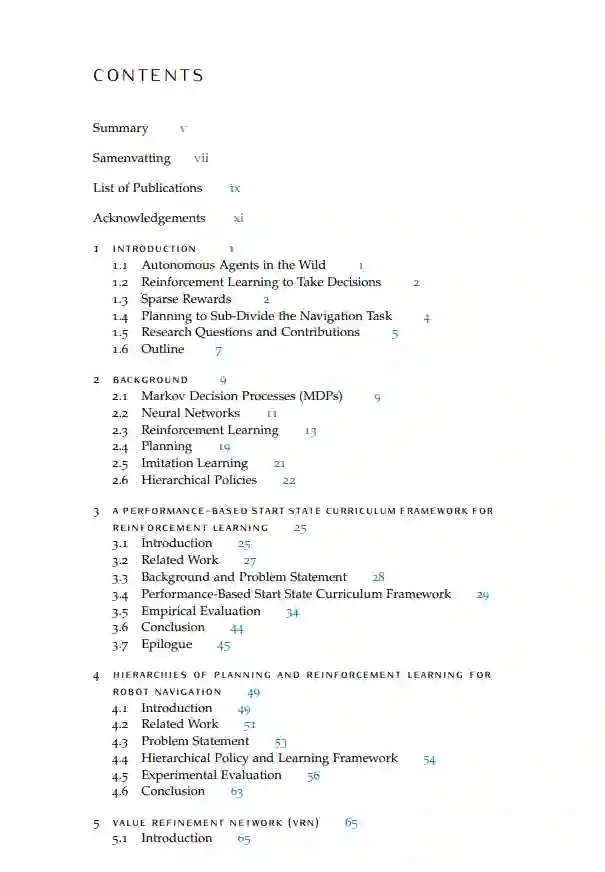

导航我们的周围环境是一项重要技能,它使我们人类能够自由地与环境互动。因此,导航技能对于在我们的世界中操作的真正自主的技术系统也是基础。在这篇论文中,我们研究了自主智能体如何学习到达其环境中指定的目标位置,这需要执行一个精心选择的动作序列。

强化学习(RL)是一种机器学习范式,用于通过与环境的互动来学习决策策略,该策略通常由神经网络表示。如果智能体执行环境中的动作所接收的奖励是稀疏的,那么改进策略变得困难且低效。因此,在这篇论文中,我们专注于在这种稀疏奖励设置下,提高自主智能体的策略学习;特别是探讨了结合RL和规划的优势。 首先,我们研究了自动生成一个将最初无技能的智能体置于逐渐增加难度的起始状态的课程。我们提出了一个基于性能的起始状态课程框架,以及一个选择在智能体能力的空间边界开始的新颖空间梯度(SG)策略。 之后,我们通过假设有一张粗略的地图并且额外地目标是跨环境泛化,稍微调整了设置。我们提出了一个层次化策略架构,VI-RL,它将在问题抽象中以较低的时间分辨率规划子目标与学习达到这些子目标的策略相结合。这通过将决策问题划分为更短的子任务来简化决策问题。我们展示了从可用的轮次数据中学习适合规划的转移模型的能力,该模型捕捉了智能体的能力并实现了泛化。

在这项工作的后续中,我们通过学习基于详细的局部状态信息来局部细化简单最短路径计划,提高了子目标规划的效率和性能。对于后者,我们提出了RL训练的价值细化网络(VRN)。它还使得在没有重复全局重新规划的情况下导航动态环境成为可能。

最后,我们通过提出HORIBLe-VRN算法来处理离线学习设置,以从预先收集的数据中学习上述基于层次规划的策略。它结合了层次模仿学习,包括潜在子目标的推断,以及随后对VRN的离线RL细化。我们的实证评估显示出良好的性能、泛化能力以及对次优演示的一定鲁棒性。 总结来说,我们提出了基于RL和规划技术的算法,这些算法使得在稀疏奖励智能体导航任务中的学习和数据效率得到了提高。