利用深度神经网络进行机器学习的最新进展,在从大型数据集学习方面取得了重大成功。然而,这些成功主要集中在计算机视觉和自然语言处理方面,而在序列决策问题方面的进展仍然有限。强化学习(RL)方法就是为了解决这些问题而设计的,但相比之下,它们很难扩展到许多现实世界的应用中,因为它们依赖于成本高昂且可能不安全的在线试错,而且需要从头开始逐个学习每个技能的低效过程。本文将介绍设计RL智能体的工作,这些智能体直接从离线数据中训练,能够掌握多种技能,以解决上述挑战。

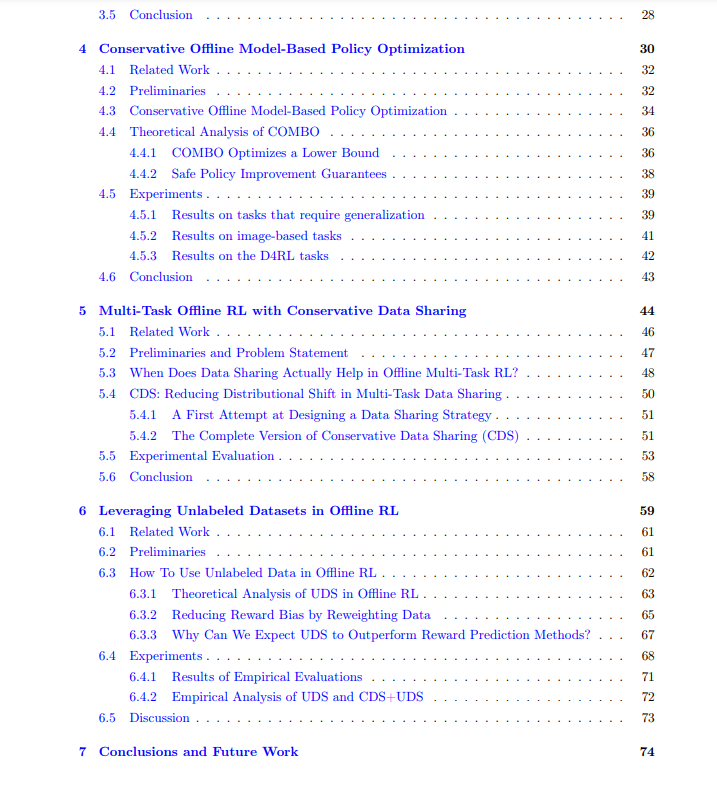

在本文的第一部分中,我们首先介绍了一种算法,从离线数据集中学习高性能策略,并通过使用学习到的动力学模型生成的推出来扩展离线数据,提高离线强化学习智能体的泛化能力。然后,我们将该方法扩展到高维观测空间,如图像,并表明该方法使现实世界的机器人系统能够执行操作任务。在论文的第二部分,为了避免在之前的强化学习工作中从头开始学习每个任务的问题,同时保持离线学习的好处,讨论了如何使强化学习智能体通过跨任务共享数据从不同的离线数据中学习各种任务。此外,我们表明,共享数据需要标记来自其他任务的数据的奖励,这依赖于繁重的奖励工程,也是劳动密集型的。为了解决这些问题,我们描述了如何有效地利用离线RL中的各种未标记数据,绕过奖励标记的挑战。最后,我们列出了未来的研究方向,如利用异构无标签离线数据集的有效预训练方案、离线预训练后的在线微调以及离线RL的离线超参数选择。

成为VIP会员查看完整内容

相关内容

斯坦福大学(StanfordUniversity)位于加利福尼亚州,临近旧金山,占地35平方公里,是美国面积第二大的大学。它被公认为世界上最杰出的大学之一,相比美国东部的常春藤盟校,特别是哈佛大学、耶鲁大学,斯坦福大学虽然历史较短,但无论是学术水准还是其他方面都能与常春藤名校相抗衡。斯坦福大学企业管理研究所和法学院在美国是数一数二的,美国最高法院的9个大法官,有6个是从斯坦福大学的法学院毕业的。

Independent Learning in Mean-Field Games: Satisficing Paths and Convergence to Subjective Equilibria

Arxiv

0+阅读 · 2022年10月21日

Arxiv

0+阅读 · 2022年10月21日

Arxiv

0+阅读 · 2022年10月21日

Arxiv

0+阅读 · 2022年10月21日