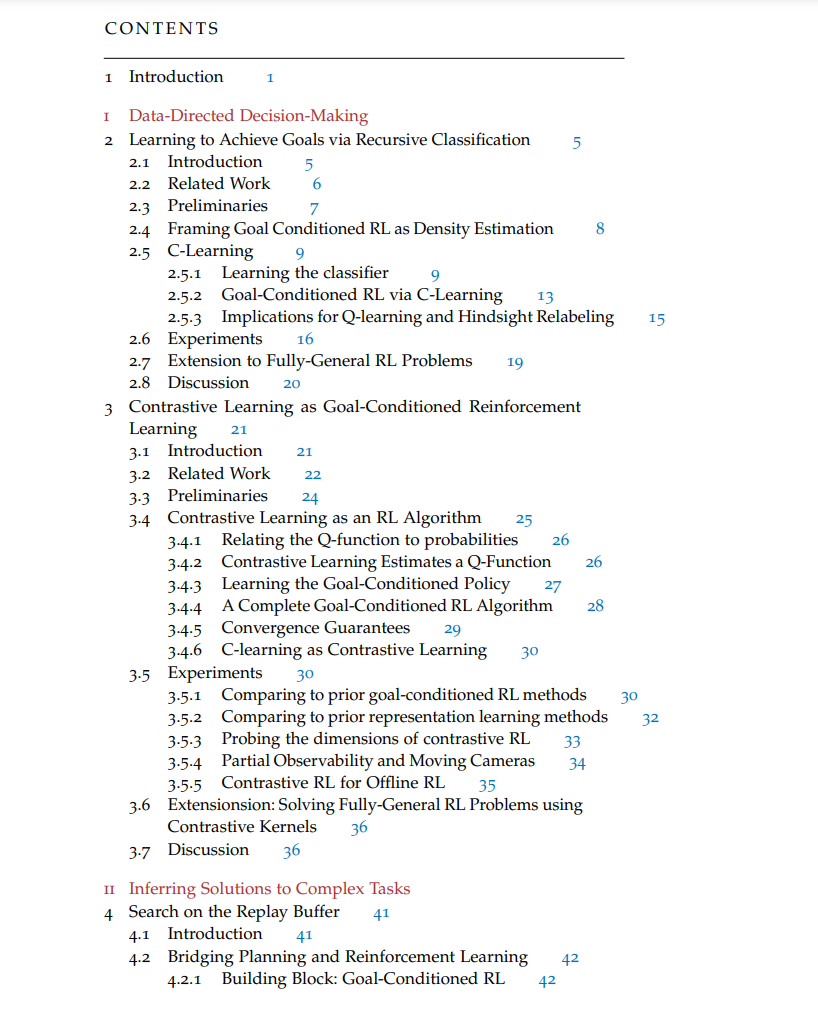

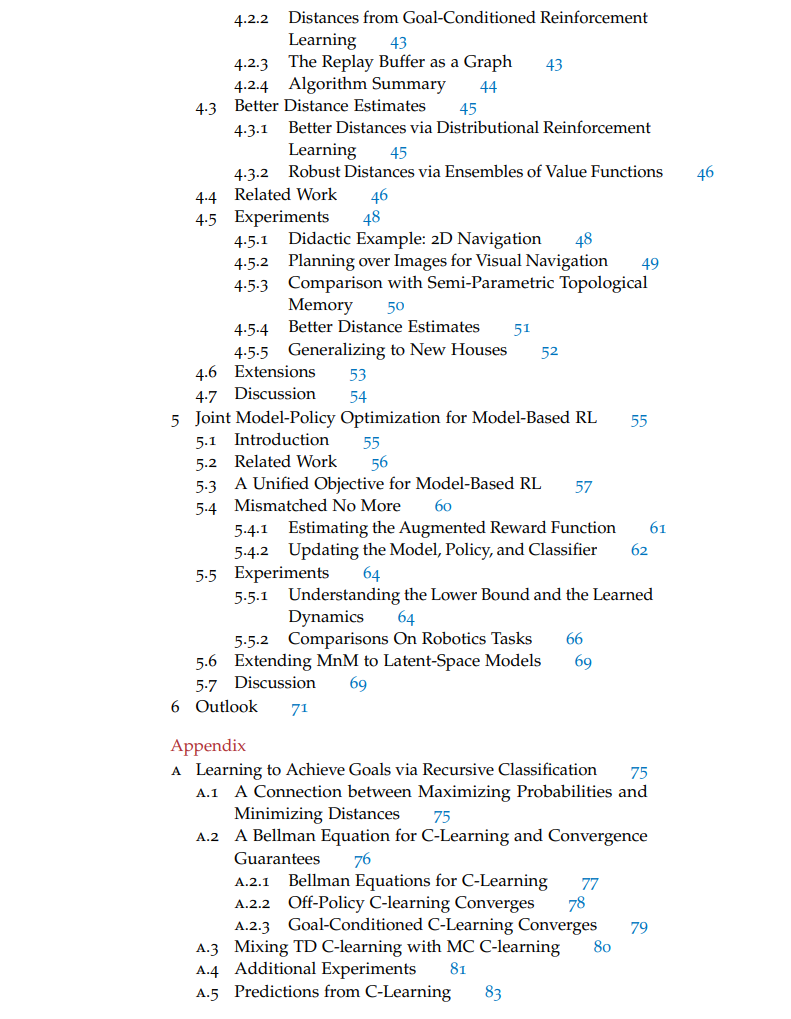

这篇论文研究了通过试错学习教导自主智能体完成任务的算法。通常,这个问题被描述为一个强化学习(RL)问题,其中智能体试图最大化用户提供的奖励函数。这里研究的算法采取了不同的方法,大部分避免使用奖励函数,而是直接从数据中学习实现期望的结果。这种方法允许用户使用来自监督学习和非监督学习的算法工具,同时也为非专家用户提供了一个教导智能体新任务的界面。这些方法的设计中的主要挑战是预测期望结果的概率,尤其是当这些结果在未来的数百步中才发生,特别是在使用离策略数据时。为此,这篇论文的第一部分基于递归分类开发了一种算法,该算法通过时间差分更新估计未来状态的概率(第2章)。这种方法直接适用于具有连续状态和动作的环境,不需要任何手工制作的距离度量,并导致了一个比之前的方法更高效的面向目标的RL算法。然后,我们将这个想法推广到可以通过多种方式解决的任务,允许更灵活的任务规范,并提供更广泛的泛化能力。

将控制问题以期望的结果来描述提供了一个简单的机制来指定任务是什么,但它没有为如何解决任务留下任何余地,这引发了一个问题:这些方法是否仅限于简单任务。为了解决这个限制,我们考虑推断复杂任务解决方案的结构。由于第一部分介绍的算法在本质上是概率性的,所以很容易将这种结构作为一个未观察到的潜在变量纳入其中。这些新算法推断这种任务结构;在这样做的过程中,它们将控制问题分解为一系列更容易的问题,从而加速学习。

我们首先讨论以目标为条件的设置,这种推断观点导致了一个简单且理论上有正当理由的方法,将面向目标的RL集成到传统的规划流程中(第4章)。RL被用来估计距离并学习一个局部策略,而观察(如,图像)上的图搜索确定了通往目标的高级路径。这种方法显著优于标准的目标条件RL算法。接着,我们考虑一种不同的方式来构造任务解决方案:作为一个学习过的动态模型和策略的组合(第5章)。结果是一个基于模型的RL算法,其中模型和策略使用相同的目标联合优化,这是预期回报的下界。

这篇论文基于初步论文提案中提出的工作在两个主要方向上进行了深入。首先,我们探讨了递归分类的几何解释(第2章),在表示学习和强化学习之间建立了紧密的联系(第3章)。这种联系使我们能够将递归分类扩展到通过有限数量的奖励标记状态后设定的任务,并使我们能够将这些方法应用到基于真实世界图像的机器人操作任务上。其次,我们扩展了RL的潜在变量观点(第4章和第5章)以在学习的表示上执行推断(第5.6节)。这种扩展使我们的方法能够扩展到更高维度的任务,并提供了大量的计算加速。