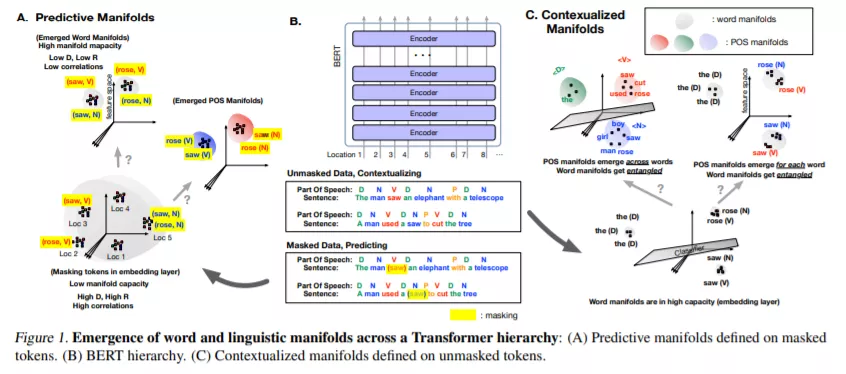

人工神经网络(ANNS)在解决各种认知模式下的感知任务方面显示出很大的经验成功。虽然它们只是受到生物大脑的松散启发,但最近的研究报告称,从任务优化的神经网络中提取的表征与大脑中的神经种群之间存在相当多的相似性。神经网络后来成为一个流行的模型类,用来推断复杂认知功能下的计算原理,反过来,它们也成为一个自然的实验平台,用来应用最初开发的方法来探测神经群体中的信息。在这项工作中,我们利用平均场理论流形分析,从计算神经科学的最新技术,从大规模语境嵌入模型分析语言表示的高维几何。我们从不同的模型族(BERT, RoBERTa, GPT-2等)中探索表征,并找到跨层深度的语言流形出现的证据(例如词性流形和组合范畴语法标签)。我们进一步观察到,不同的编码方案用于获取表示,导致这些语言流形出现在网络的早期或后期层的差异。此外,我们发现这些流形中线性可分性的出现是由流形半径、维数和流形间相关性的联合减少所驱动的。

成为VIP会员查看完整内容

相关内容

专知会员服务

36+阅读 · 2020年4月14日