多伦多大学“神经网络与机器学习导论(2018年春季)

http://www.cs.toronto.edu/~rgrosse/

来源 | 专知(公众号ID:Quan_Zhuanzhi)

【导读】多伦多大学计算机系助理教授 Roger Grosse 开设的《神经网络与机器学习导论》课程涵盖了从机器学习基础知识到深度学习、强化学习等高阶内容,是AI从业者最佳的学习上手材料之一。

▌概述

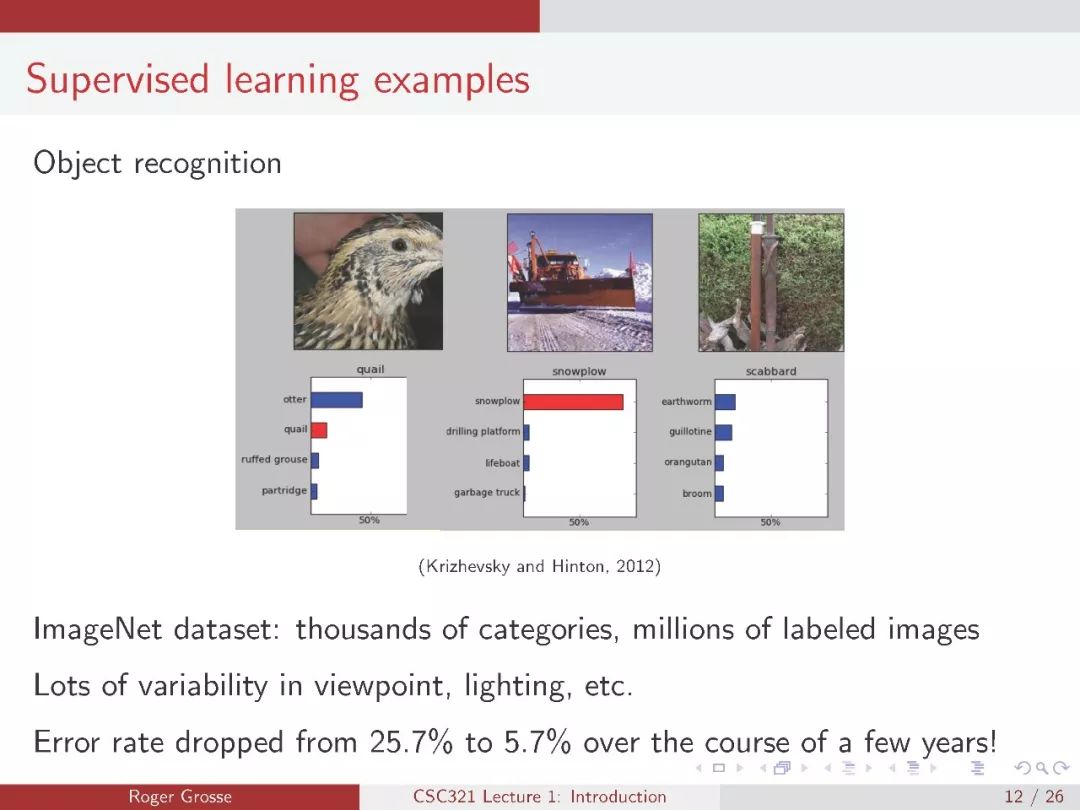

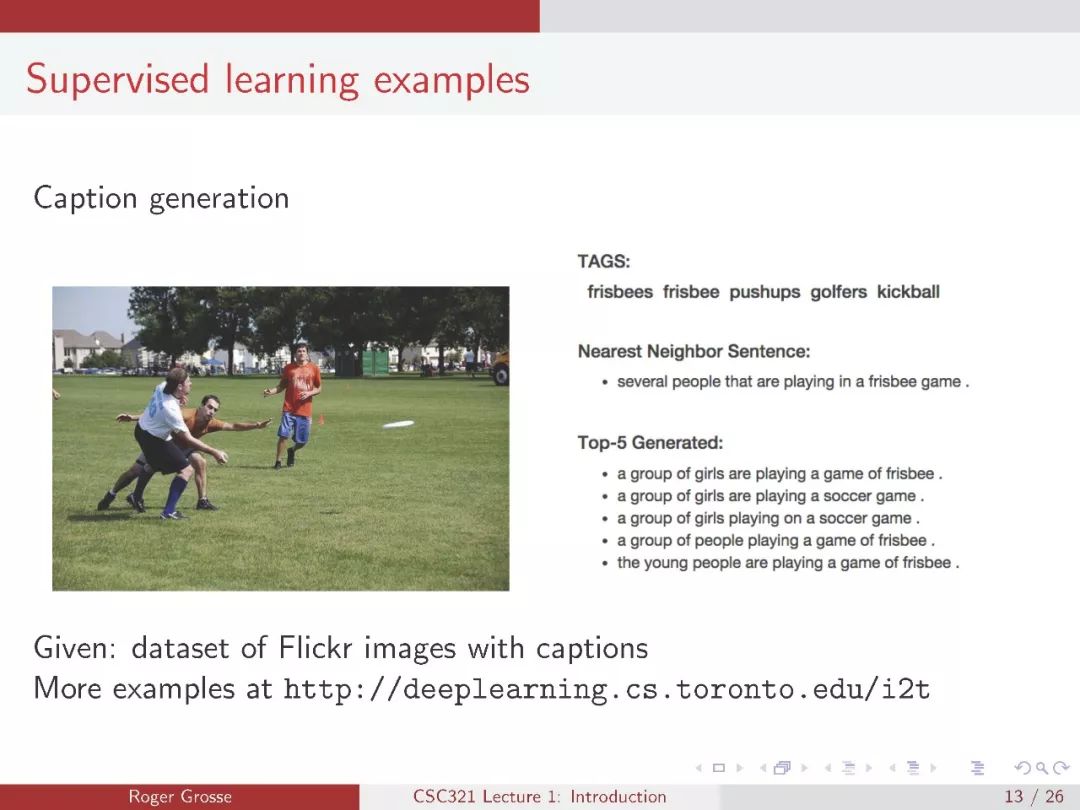

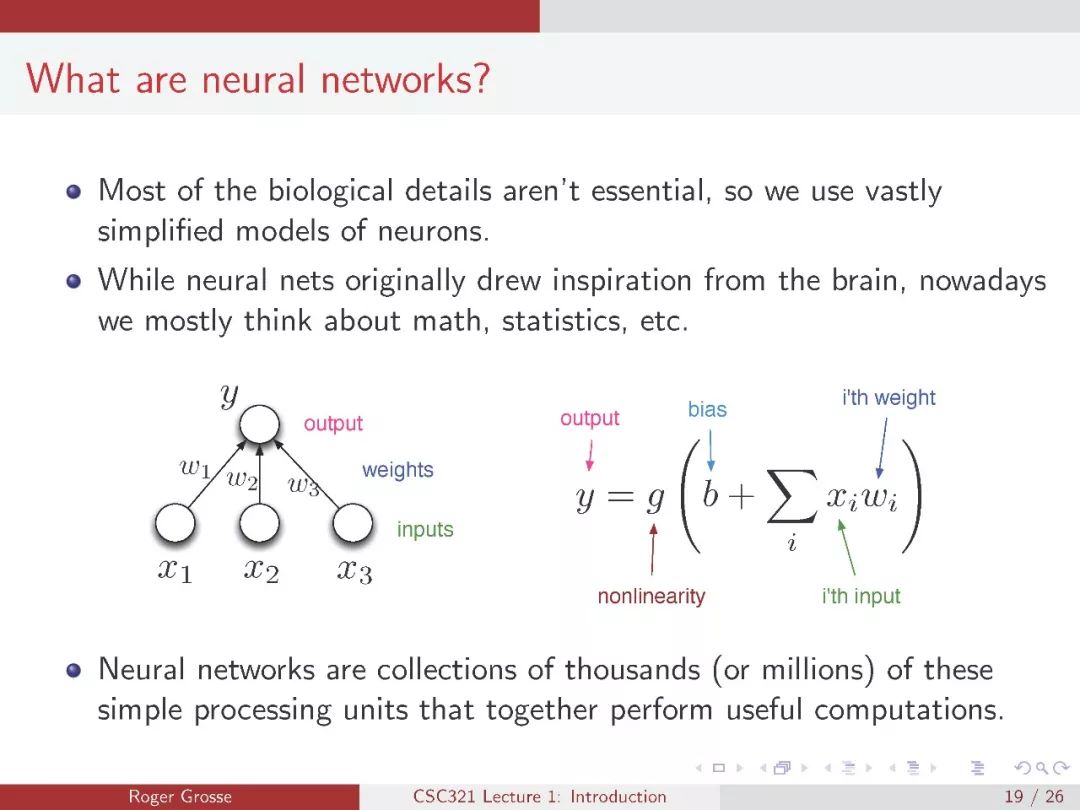

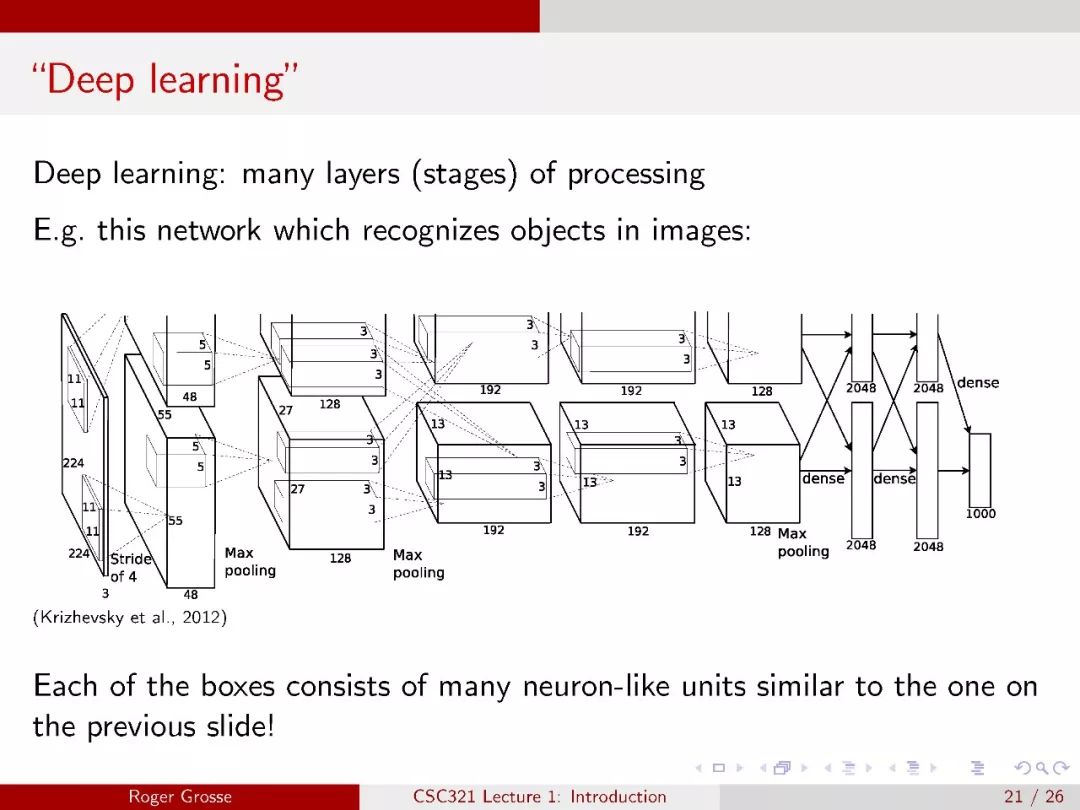

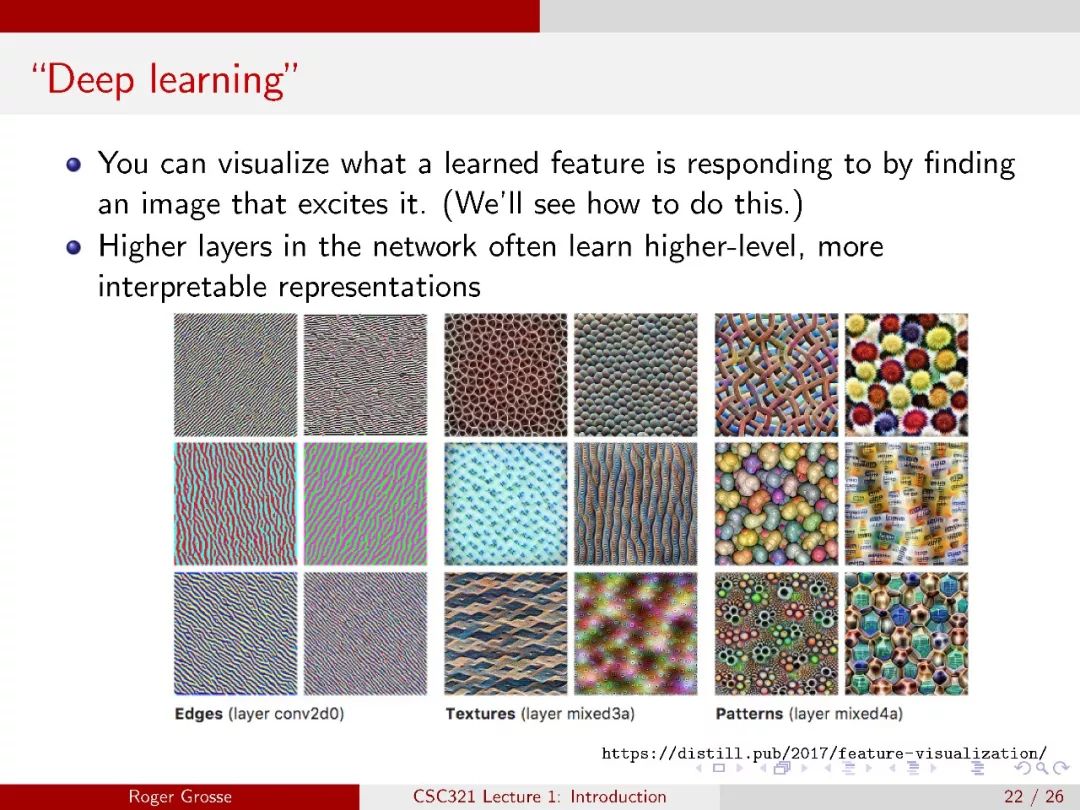

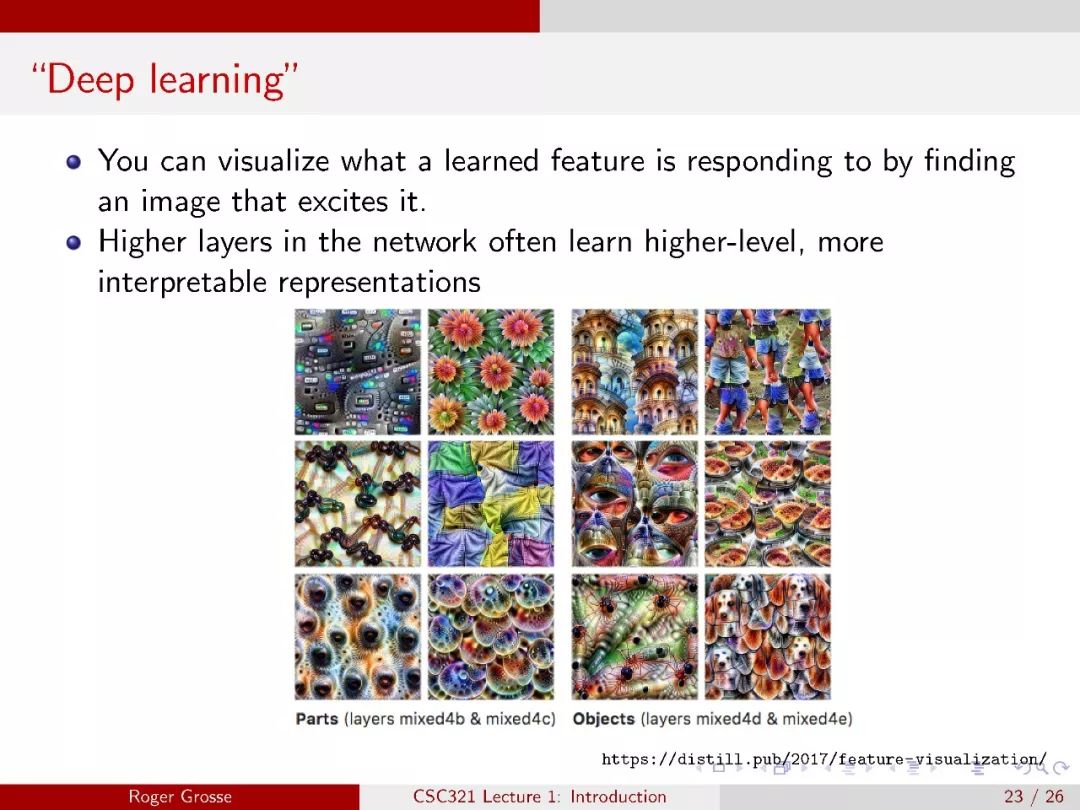

机器学习是一套强大的技术,它允许计算机从数据中学习,而不是让人类专家手工编程行为。神经网络是一类最初受大脑启发的机器学习算法,但最近在实际应用中取得了很多成功。它们是谷歌( Google )和 Facebook 等公司生产系统的核心,用于人脸识别、语音到文本以及语言理解。

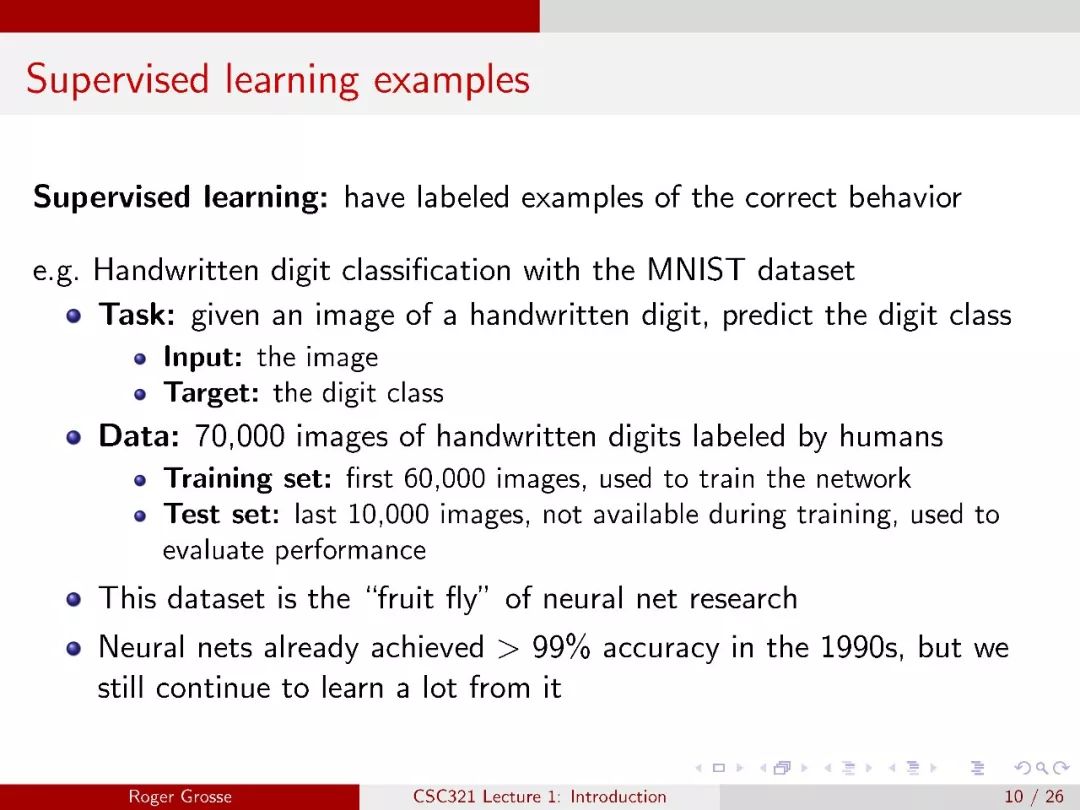

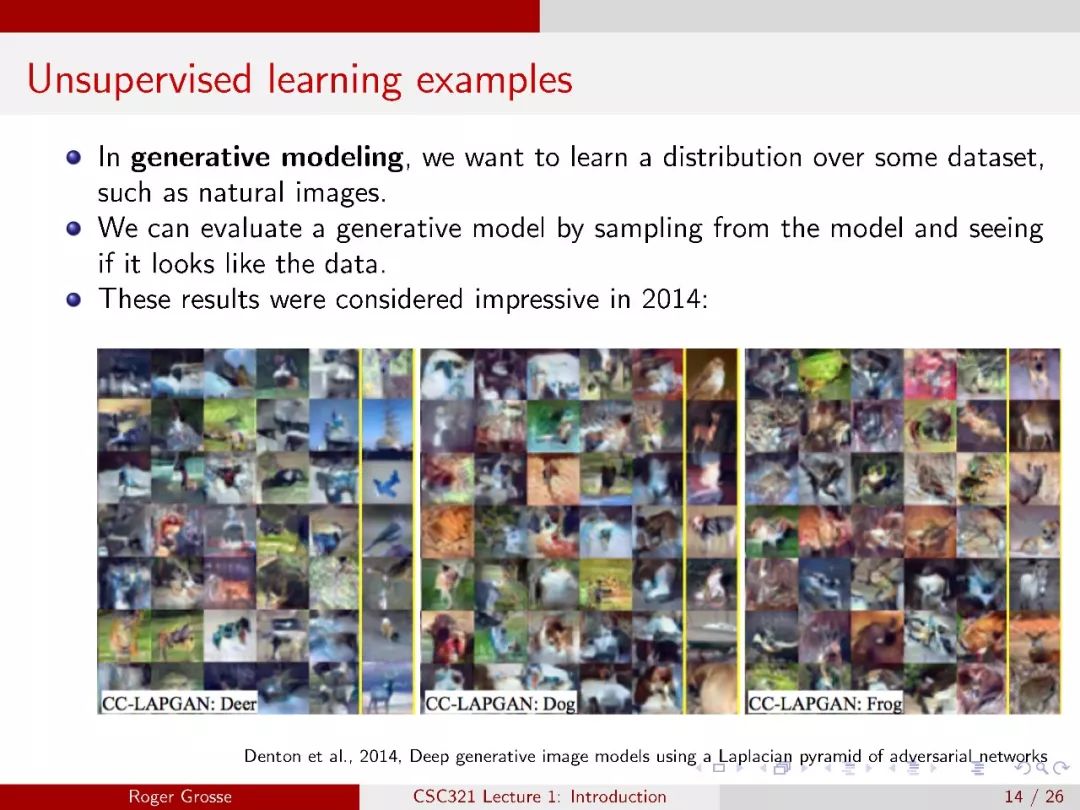

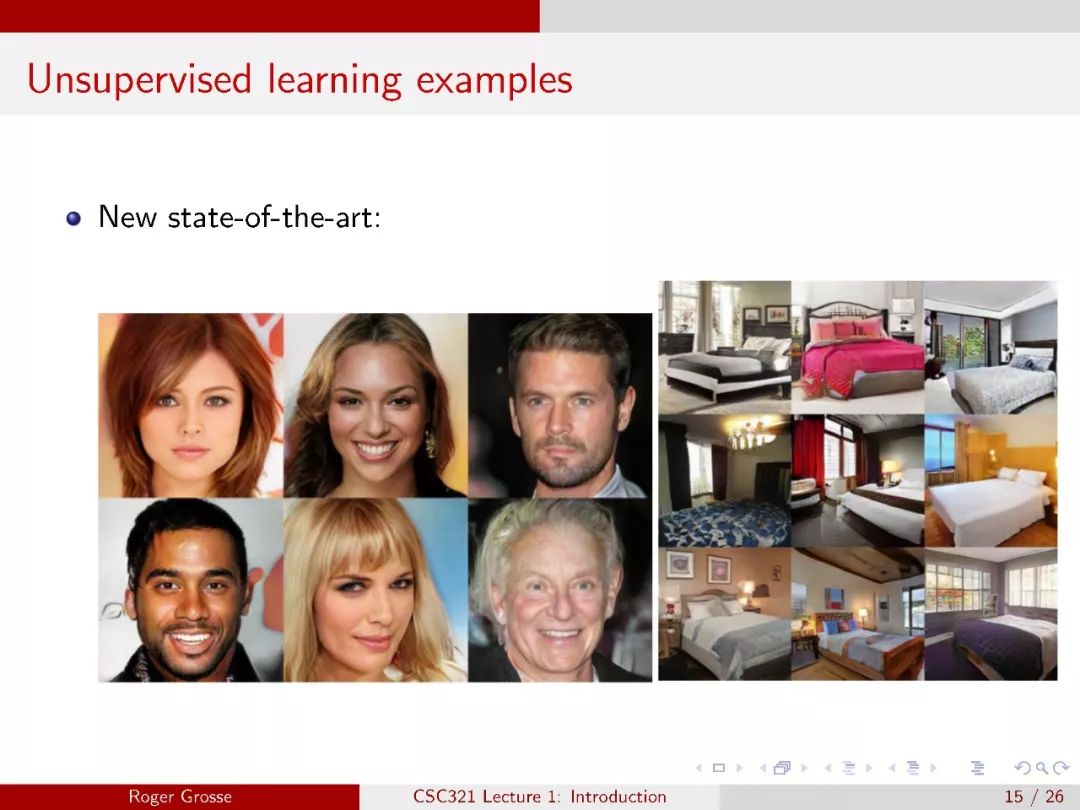

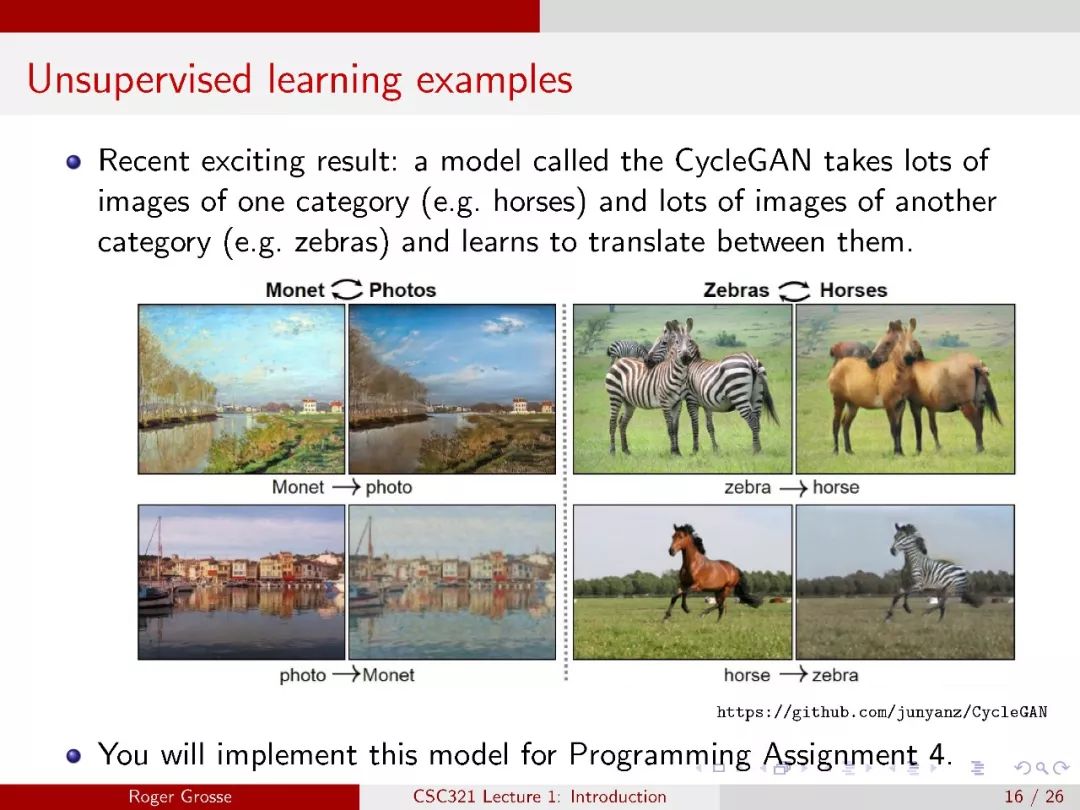

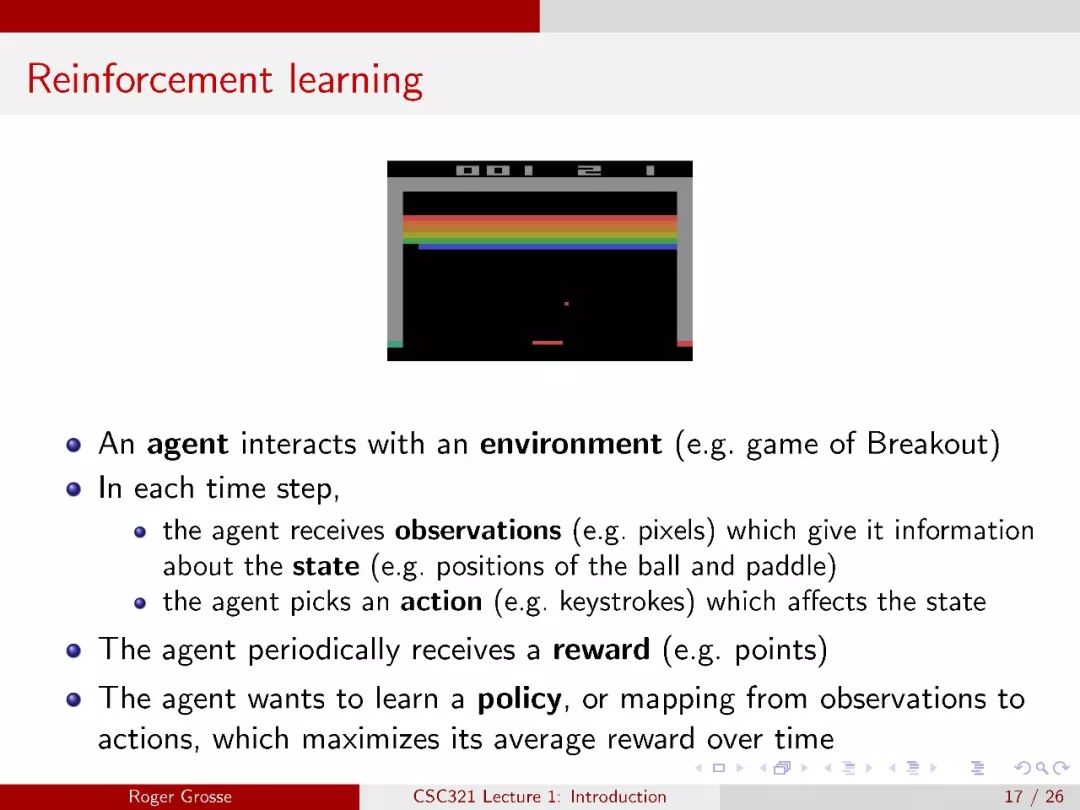

本课程概述了神经网络算法的基本思想和最新进展。本课程的前 2/3 大致集中在有监督的学习上,即训练网络在有大量标记的行为示例时产生特定的行为。最后 1/3 集中于无监督学习和强化学习。

课程地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/

课程内容目录

第 1 讲:导言

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec01.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L01%20Introduction.pdf

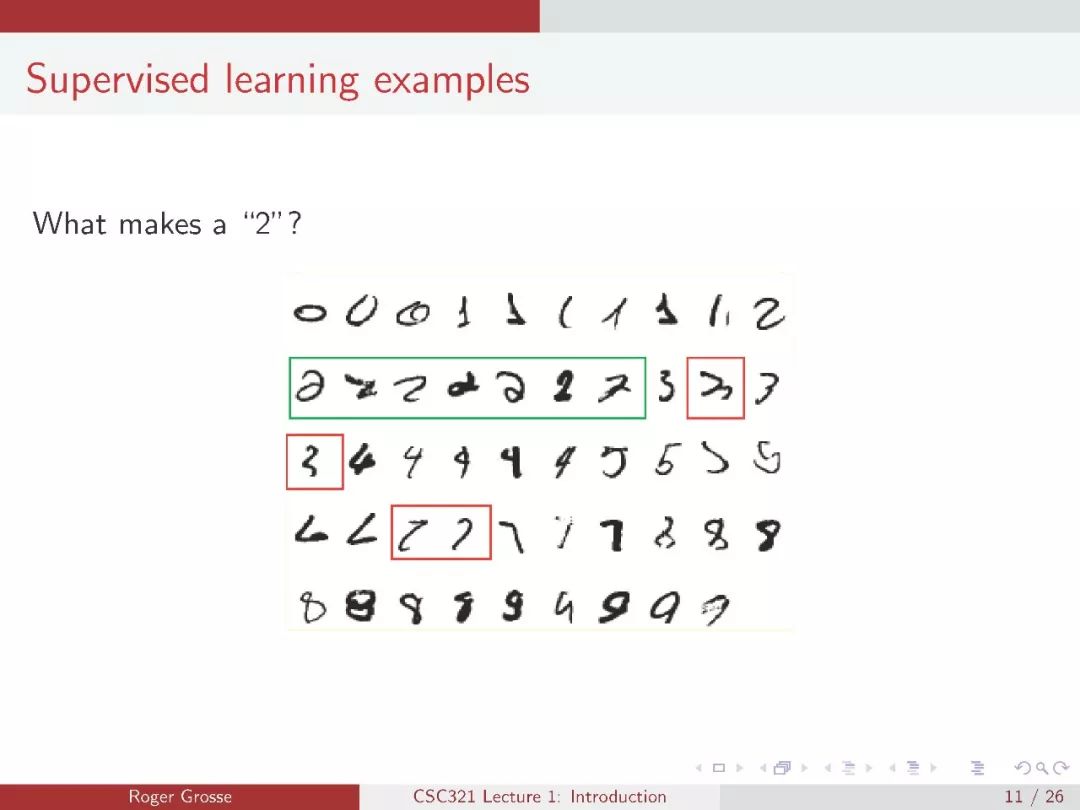

介绍什么是机器学习和神经网络,你会用它们做什么?监督、无监督和强化学习。本课程的组织方式。

第 2 讲:线性回归

课件地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec02.pdf

讲义地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L02%20Linear%20Regression.pdf

线性回归,一种有监督的学习任务,您需要在其中预测标量值目标。将该问题转化为优化问题,直接求解或梯度下降求解。矢量化。特征映射和多项式回归。泛化:过拟合、欠拟合和验证。

第 3 讲:线性分类

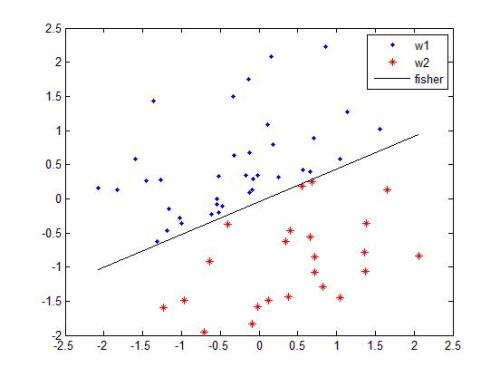

二元线性分类。可视化线性分类器。感知器算法。线性分类器的极限。

课件地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec03.pdf

讲义地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L03%20Linear%20Classifiers.pdf

第 4 讲:学习分类器

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec04.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L04%20Training%20a%20Classifier.pdf

二进制分类中损失函数的比较。交叉熵损失、logistic 激活函数和 logistic 回归。铰链损失。多向分类。凸损失函数。梯度检查。(注:这实际上是一次半的讲座,会遇到第五次讲座的安排。)

第 5 讲:多层感知器

多层感知器。激活函数的比较。将深层神经网络视为函数组合和特征学习。线性网络的局限性和非线性网络的普适性。

课件地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec05.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L05%20Multilayer%20Perceptrons.pdf

建议阅读:深度学习书第 6.1 - 6.4 节

第 6 讲:反向传播

课件地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec06.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L06%20Backpropagation.pdf

反向传播算法,一种计算梯度的方法,我们在整个过程中使用。

第 7 讲:分布式表示

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec07.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L07%20Distributed%20Representations.pdf

语言建模、n - gram 模型(局部化表示)、神经语言模型(分布式表示)和跳跃图(另一分布式表示)。

第 8 讲:优化

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec08.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L08%20Optimization.pdf

如何使用通过反向投影计算的梯度。优化景观特点:局部优化、鞍点优化、高原优化、沟壑优化。随机梯度下降和动量。

建议阅读:深度学习书,第 8 章

第 9 讲:泛化

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec09.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L09%20Generalization.pdf

偏差/方差分解、数据增加、限制容量、提前停止、权重衰减、系综、随机正则化、超参数调整。

建议阅读:深度学习书,第 7 章

第 10 讲:自动微分

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec10.pdf

如何实现自动微分系统。基于自学者的教学实施签名。

第 11 讲:卷积网络

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec11.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L11%20Convolutional%20Networks.pdf

卷积运算。卷积层和池层。等方差和不变性。conv 网络的反向传播规则。

第 12 讲:图像分类

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec12.pdf

conv 网络体系结构在手写体数字和对象分类中的应用。测量坐标网的尺寸。

第 13 讲:追赶

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec13.pdf

没有第 13 课,因为我们迷信。此外,我们已经落后了一个完整的演讲时间表,所以这将使时间表与实际涵盖的内容同步。

第 14 课:优化输入

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec14.pdf

第 15 讲:递归神经网络

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec15.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L12%20Object%20Recognition.pdf

递归神经网络。时光倒流。将 RNNs 应用于语言建模和机器翻译。

第 16 讲:学习长期依赖关系

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec16.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L16%20Learning%20Long%20Term%20Dependencies.pdf

为什么 RNN 梯度爆炸和消失,无论是从背面机械的角度,还是从 RNN 计算的函数的概念。处理方法:渐变裁剪、输入反转、LSTM。

第 17 讲:学习和注意

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec17.pdf

深层残差网络。机器翻译和字幕生成的注意模型。

第 18 讲:学习概率模型

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec18.pdf

讲义地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/readings/L18%20Learning%20Probabilistic%20Models.pdf

极大似然估计。贝叶斯参数估计和最大后验估计的基础。

第 19 讲:生成对抗网络

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec19.pdf

专题待定

第 20 讲:自回归和可逆模型

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec20.pdf

专题待定

第 21 讲:政策梯度

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec21.pdf

下午:下午3时27分,下午1时至2时;晚上:下午3 : 27,7 - 8点

专题待定

第22讲:问答式学习

课件地址:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/slides/lec22.pdf

下午:下午3时29分,下午1时至2时;晚上:下午4 : 3,6 - 7点

专题待定

第 23 课:玩游戏

下午:下午4时3分,下午1时至2时;晚上: 4 / 3,晚上7 - 8点

专题待定

▌教程

请注意,下午部分的第一堂课之后没有教程,夜间部分的最后一堂课之后也没有教程。

教程 1:线性回归

课程地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/tutorials/tut1.pdf

教程 2:分类 [ [·伊普森笔记本]

地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/tutorials/tut2.pdf

教程 3:反向传播 [·伊普森笔记本] [推导( PDF ) ]

地址:http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/tutorials/tut3.pdf

教程 4:签名

教程 5:PyTorch

教程 6:Conv 网络

教程 7:中期审查

教程 8:注意和最大似然

教程 9:GANs

教程 10:策略梯度

▌课件介绍

参考链接:

http://www.cs.toronto.edu/~rgrosse/courses/csc321_2018/

扫描二维码,关注「人工智能头条」

回复“技术路线图”获取 AI 技术人才成长路线图

☟☟☟点击 | 阅读原文 | 查看更多精彩内容