题目: TinyMBERT: Multi-Stage Distillation Framework for Massive Multi-lingual NER

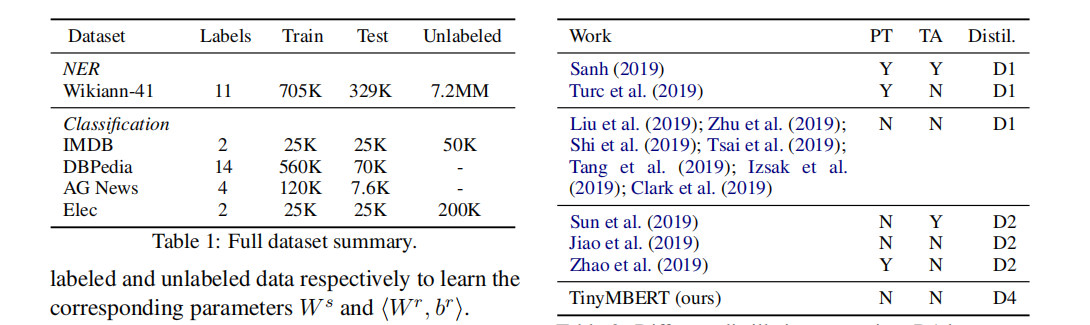

简介: 深度和大型预训练语言模型是各种自然语言处理任务的最新技术。但是,这些模型的巨大规模可能会阻碍在实践中使用它们。一些近期和并行的工作使用知识蒸馏将这些巨大的模型压缩为浅层模型。在这项工作中,我们重点研究多语言命名实体识别(NER)的知识提炼。特别是,我们研究了几种蒸馏策略,并提出了一个阶段性的优化方案,该方案利用了与教师架构无关的教师内部表示形式,并表明它优于先前工作中采用的策略。此外,我们调查了几个因素的作用,例如未标记数据的数量,注释资源,模型架构和推理延迟仅举几例。我们证明了我们的方法可以对MBERT类教师模型进行大规模压缩,在参数推断方面最多可压缩35倍,在延迟方面则可压缩51倍,同时为41种语言的NER有95%的F1分数。

成为VIP会员查看完整内容

相关内容

专知会员服务

99+阅读 · 2020年7月3日

专知会员服务

27+阅读 · 2020年4月5日

专知会员服务

33+阅读 · 2020年2月29日

专知会员服务

12+阅读 · 2020年1月7日

专知会员服务

11+阅读 · 2019年12月28日

UniViLM: A Unified Video and Language Pre-Training Model for Multimodal Understanding and Generation

Arxiv

19+阅读 · 2020年2月15日

Arxiv

5+阅读 · 2018年4月5日