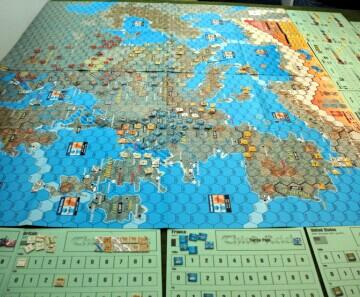

图:美国海军研究生院的学生参加他们设计的分析性兵棋推演,为美国防部一些最紧迫的国家安全问题探索解决方案。图片来源:Javier Chagoya,公共领域,维基共享资源

11 月初,世界各国领导人齐聚英国布莱切利公园(Bletchley Park),参加首届全球人工智能(AI)安全峰会。此次峰会旨在了解前沿人工智能(可执行各种任务的高能力通用模型)的风险,尤其是被 "坏人 "使用时的风险,并激励国际社会采取行动。

峰会议程中缺少了国家行为者将人工智能用于国家安全应用的内容,而这可能很快会改变地缘政治和战争。杀手机器人不一定是最大的风险。相反,人工智能系统可以通过数据筛选来识别竞争优势,生成新的对手战略,并评估战争胜负的条件。这可以通过人工智能与兵棋推演的融合来实现。北约将兵棋推演定义为 "在安全无虞的环境中表现冲突或竞争,人们在其中做出决策并对这些决策的后果做出反应"。兵棋推演是一门拥有数百年历史的艺术,现在才成为一门科学和学科。

人工智能融入兵棋推演会潜移默化地影响领导层对战争与和平的决策,并可能导致生存风险。当前,以人为中心的兵棋推演与人工智能算法相结合,面临着一个显著的 "黑箱 "挑战,即某些结果背后的原因仍不清楚。这种模糊性以及人工智能训练数据和兵棋推演设计中的潜在偏差,凸显了在这一不断发展的领域中对伦理治理和问责制的迫切需求。探讨这些问题可以阐明,在人工智能与兵棋推演的融合过程中,必须进行负责任的监督,因为这种融合可能会决定未来的冲突。

没有监督的影响。兵棋推演大受欢迎: 北约成员国、智库和大学都在使用这些工具来研究从核危机到大国竞争等一系列安全问题。一些兵棋推演旨在教育参与者,另一些则收集数据进行分析,为学术理论或政府政策提供依据。

这种复兴始于2015年,当时五角大楼呼吁开展更多兵棋推演,以超越俄罗斯等主要竞争对手。现在,北约正在发展一种 "大胆 "的兵棋推演能力--一种文化转变,鼓励在军事战略和规划中进行批判性思考、实验和思想交流,以获得战略优势。伦敦国王学院和斯坦福大学等知名院校也在这一领域建立了新的研究中心。

作为复兴的结果,兵棋推演对西方领导人的影响越来越大。正如英国国防大臣本-华莱士在 2023 年 7 月强调的那样,"兵棋推演的产出已成为(英国防部)决策的核心"。例如,美国国务卿的 "网络评估与挑战办公室"(Office of Net Assessment and Challenge)一直在进行广泛的兵棋推演,并参考国防情报和独立专家的意见,以确保当前和新出现的战略在实施前得到彻底检验。

在美国,兵棋推演更是盛行,五角大楼习惯性地使用此类模拟来 "为实战做准备"。例如,兰德公司开发的《对冲》(Hedgemony)就是一款战略兵棋推演游戏,在五角大楼 2018 年《国防战略》的制定过程中发挥了关键作用。该游戏模拟了资源和部队管理方面的权衡,指导美国国防专业人员在动态的全球安全环境中根据不断变化的国家战略和目标调整军事能力。兰德公司是联邦政府资助的研发中心,自 20 世纪 40 年代末以来一直致力于兵棋推演。

然而,监督并没有跟上步伐。在 2023 年伦敦国王学院调查中,对来自 19 个国家的 140 多名兵棋推演设计者进行了调查。结果令人担忧:80%的分析兵棋推演跳过了伦理审查,无视涉及人类参与者的研究的标准流程。英国国防部的数据也反映了这一趋势: 根据《信息自由法》申请获得的信息,2018 年至 2023 年间,只有一项研究提交研究伦理委员会审查。

兵棋推演为何缺乏伦理监督?首先,有影响力的指南,如北约今年发布的兵棋推演手册,未能概述伦理要求,尽管这些游戏为现实世界的决策提供了参考。政府赞助商也很少要求正式遵守研究伦理标准。此外,获得伦理批准可能既艰巨又耗时,与紧迫的政策时间表相冲突。

下一个前沿领域: 融合人工智能和兵棋推演。随着兵棋推演拥抱人工智能,伦理方面的挑战也成倍增加。美国国防部高级研究计划局(DARPA)和英国国防科学与技术实验室等公司和政府机构正在率先开展人工智能与兵棋推演融合的实验项目。值得注意的是,兰德公司(RAND Corporation)早在上世纪 80 年代就开始尝试这种融合。

前景令人信服。英国顶级人工智能中心艾伦-图灵研究所 2023 年的一项研究发现,这种合并可以提高速度和效率,改进分析。人工智能可以从海量数据中迅速发现洞察力。通过人工智能生成的场景和对抗策略,玩家可以体验到更加身临其境的游戏。预期结果如何?在前瞻性和战略优势方面实现变革性飞跃。

然而,兵棋推演和人工智能模型都面临两个挑战--缺乏可解释性(难以理解知识是如何产生的)和偏见,这引起了伦理方面的担忧。根据北约和英国国防部的兵棋推演指南,兵棋推演 "不可复制"。当与黑盒深度学习模型--决策过程不透明且不易解读的系统--相结合时,对结果的信任度会进一步降低。有限的数据或有缺陷的设计可能会造成两者的偏差,从而可能导致错误的结论。此外,兵棋推演的方法和见解往往是分类的。利用人工智能对其进行增压可能会传播错误,在不受公众监督的情况下对现实世界造成重大影响。

损害伦理原则。兵棋推演可能会带来风险,如果没有道德准则的保护,可能会损害玩家和社会。

在逼真的游戏中,参与者可能会承受很大的压力,有时会导致类似竞技体育中的攻击行为。此外,如果玩家的身份可以与他们在游戏中的行为和讨论联系起来,这可能会损害他们的职业声誉,甚至危及他们的安全。道德游戏与适当的研究一样,通过谨慎的协议(如知情同意和数据匿名化)来避免这些隐患。

更广泛地说,战略兵棋推演可以对现实世界的决策产生间接和直接的影响。正在或将要成为现实世界决策者的玩家可能会受到他们游戏经历的影响,从而可能以微妙的方式影响未来的决策。这就好比让一个对药物有不良反应的医学试验参与者来决定药物的批准。

为了说明潜在的问题,请看英国《卫报》最近报道的一场以大学为基地的兵棋推演,北约工作人员和军警参与其中,探讨俄罗斯入侵芬兰的问题。如果这个游戏是由北约这样的实体赞助的,那么它的结果可能会指导直接的政策或军事选择。例如,如果由于游戏设计或场景中隐藏的偏见而无意中将俄罗斯领导层描绘得过于咄咄逼人,这可能会导致国防资源的错误分配或冲突的无意升级。

当然,这种后果性决定不太可能根据一次性游戏的结果做出,但许多玩家人数众多的游戏可能会加剧风险。规模很重要。

现在考虑一下大规模部署的数字人工智能驱动版分析游戏。人工智能有可能通过产生大量扭曲的数据来放大现有的偏见,从而错误地验证假设。人工智能还可以编造极具说服力但却具有欺骗性的叙述,进一步模糊模拟与现实之间的界限。具有讽刺意味的是,在决策者眼中,这些数据驱动的洞察力可能会为原本有问题的结果增加不应有的可信度。

如果兵棋推演继续在国防决策中占据举足轻重的地位,正如英国前国防大臣华莱士所言,那么领导人可能会认为战争比现实中更有必要,也更容易打赢。有偏见或无法解释的人工智能游戏可能会夸大胜利的机会或歪曲对手的意图,使决策者认为在仍有外交选择的情况下战争是必不可少的。这可能会损害正义战争理论的道德原则,如正当理由和最后手段。

负责任地管理人工智能兵棋推演。将人工智能的分析能力与兵棋推演中人类的创造力结合起来,有望为威慑或赢得未来战争带来战略优势。但要获得这些优势,需要道德标准、问责制和监督。

首先,专家们必须为传统兵棋推演和高科技兵棋推演制定道德准则,调整研究标准,以考虑到兵棋推演特有的风险。这些标准必须成为政府指导方针的基石。北约等组织可以提供分享最佳实践的论坛,避免重复劳动。

其次,必须通过投资基础研究来应对人工智能可解释性和固有偏见的挑战。虽然人工智能可解释性的研究势头良好,但很少有学者致力于兵棋推演方法论和认识论的研究。我们需要多学科合作。计算机科学家应与兵棋推演学者和实践者合作,共同推进理论研究。

第三,开展和赞助游戏的机构必须提供监督。这需要高层领导的支持。如果游戏在不受公众监督的情况下对国防决策产生微妙影响,则可能需要额外的制衡机制,如立法机构的审查。

正如机器在布莱切利公园破解敌方密码赢得战争一样,人工智能也将很快解开复杂的战略以确保和平。人工智能安全峰会等集会可以促进对话和改革,将伦理治理纳入兵棋推演的数字化未来。

参考来源:原子科学家公报,By Ivanka Barzashka