ECCV2018教程146页《对抗机器学习》PPT教程(附PPT下载)

导读:全球计算机视觉三大顶会之一 ECCV 2018(European Conference on Computer Vision)于9月8日到14 日在德国举行。本文介绍该会议中146页的对抗机器学习PPT教程。

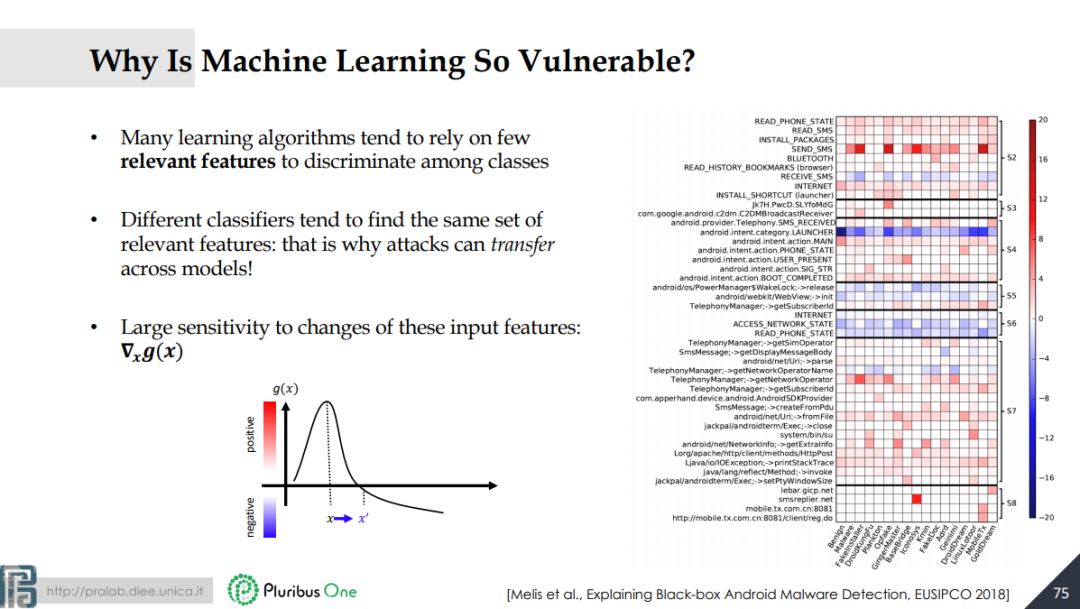

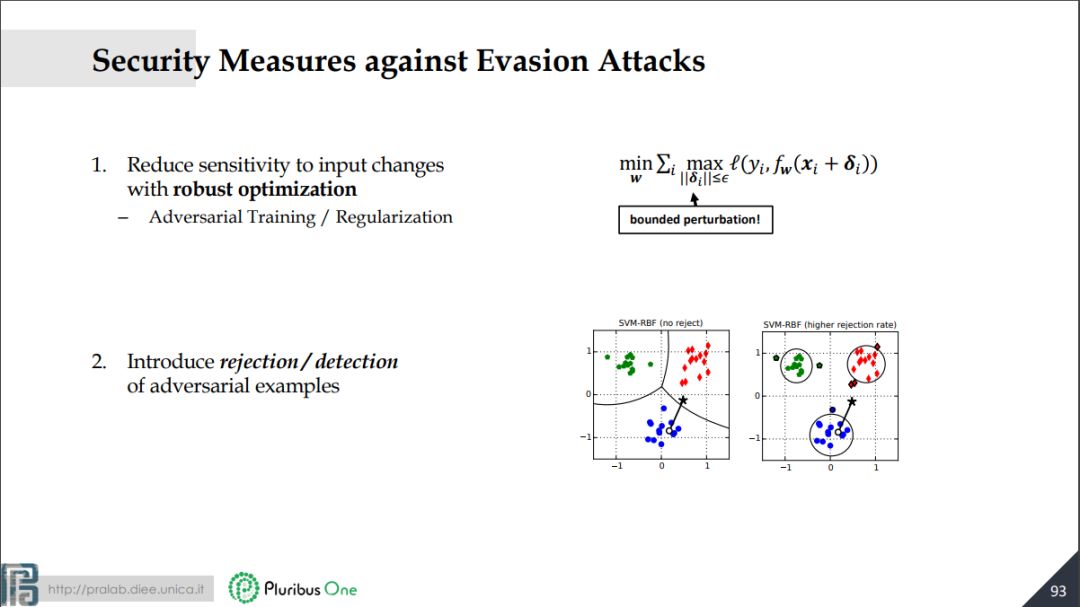

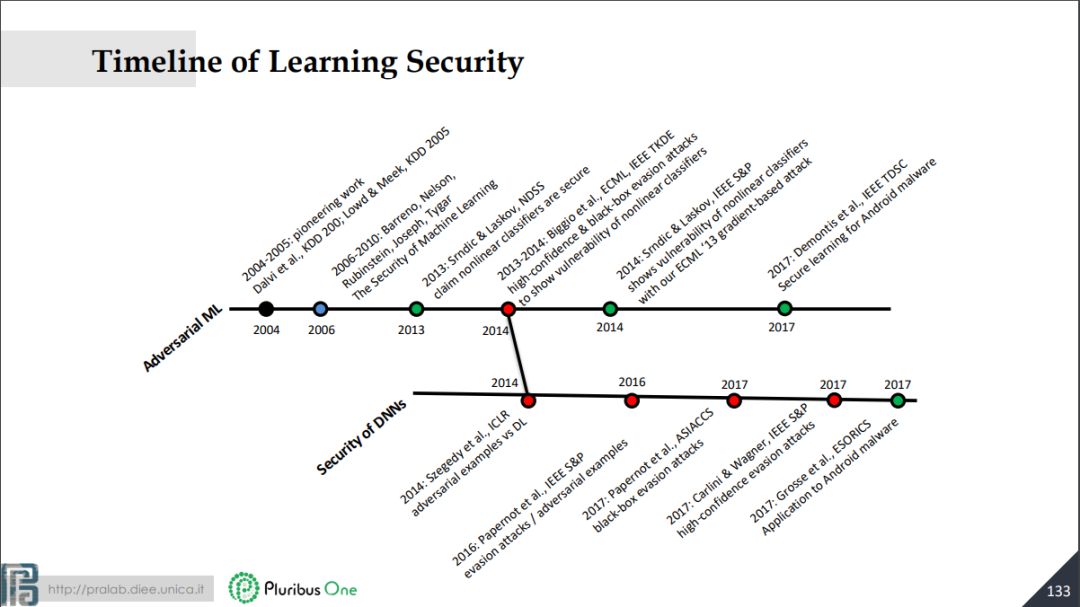

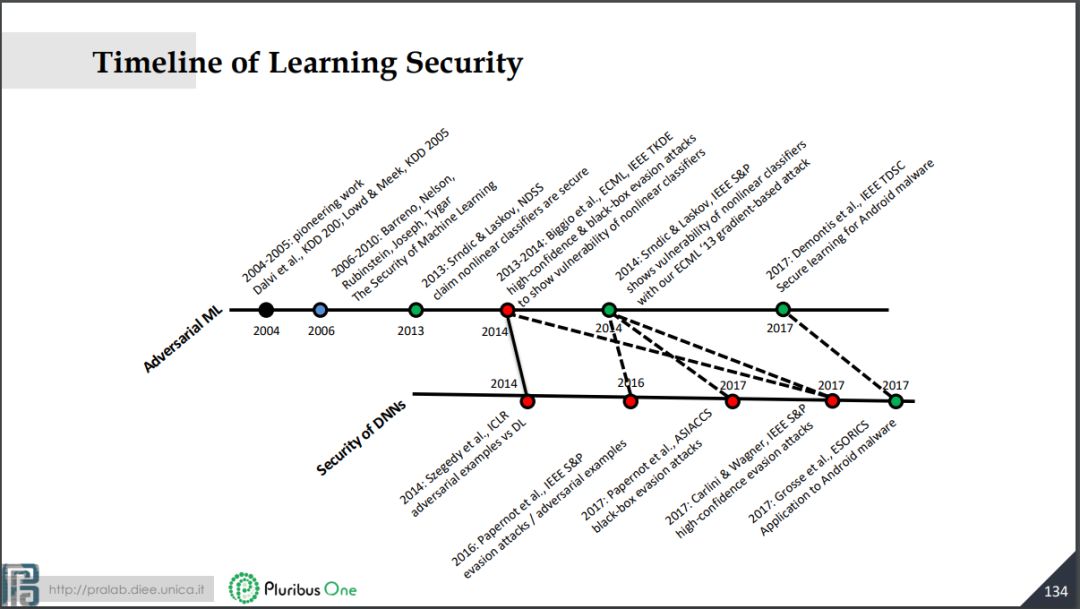

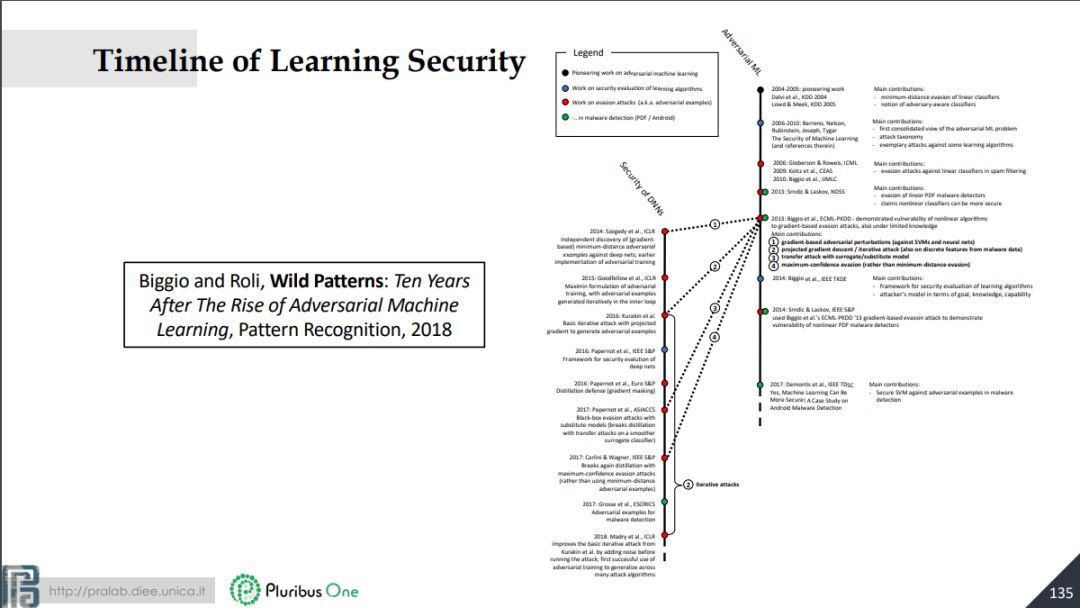

深度学习为人们带来了便利,同时也带来了安全隐患。深度学习模型在干扰下(尤其是精心设计的干扰)可能会产生错误的结果,带来严重的安全问题。对抗机器学习研究这种攻击以及抗攻击的机制。

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知),

后台回复“AML” 就可以获取论文下载链接~

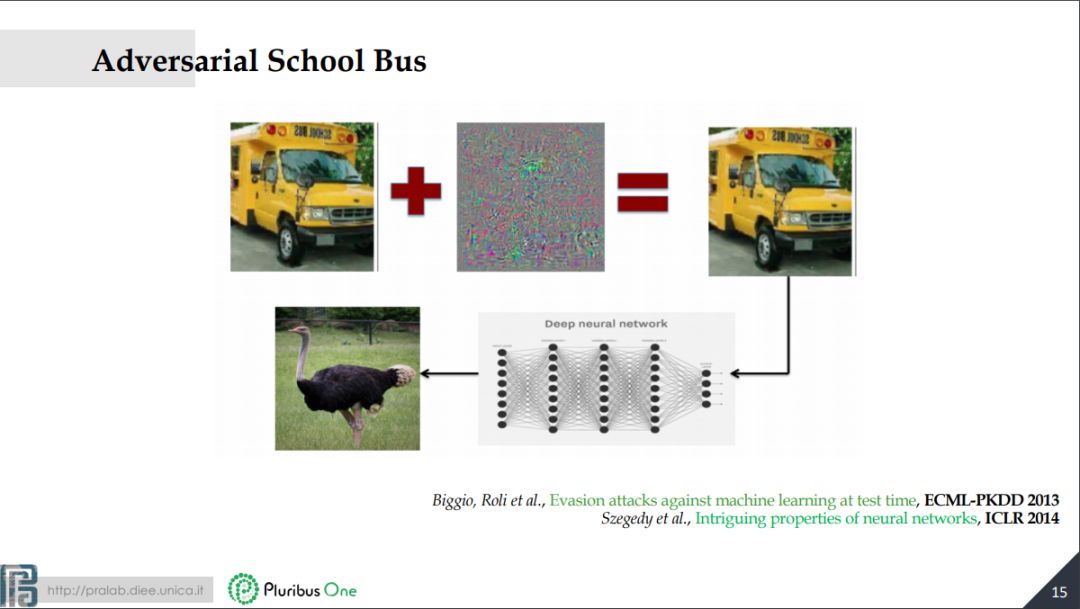

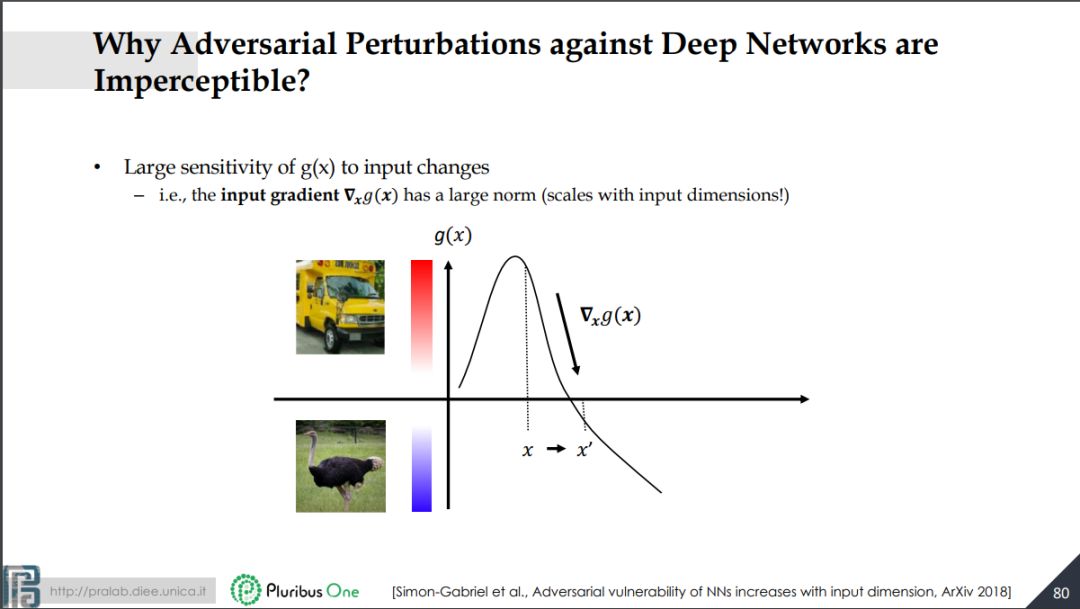

教程中用一个很好的例子来解释了什么是对抗学习,给一个汽车图像加上一个随机的噪音,虽然从肉眼看来,噪音的加入并没有对图像产生什么变化,但是对深度模型却把这量车识别成了鸵鸟:

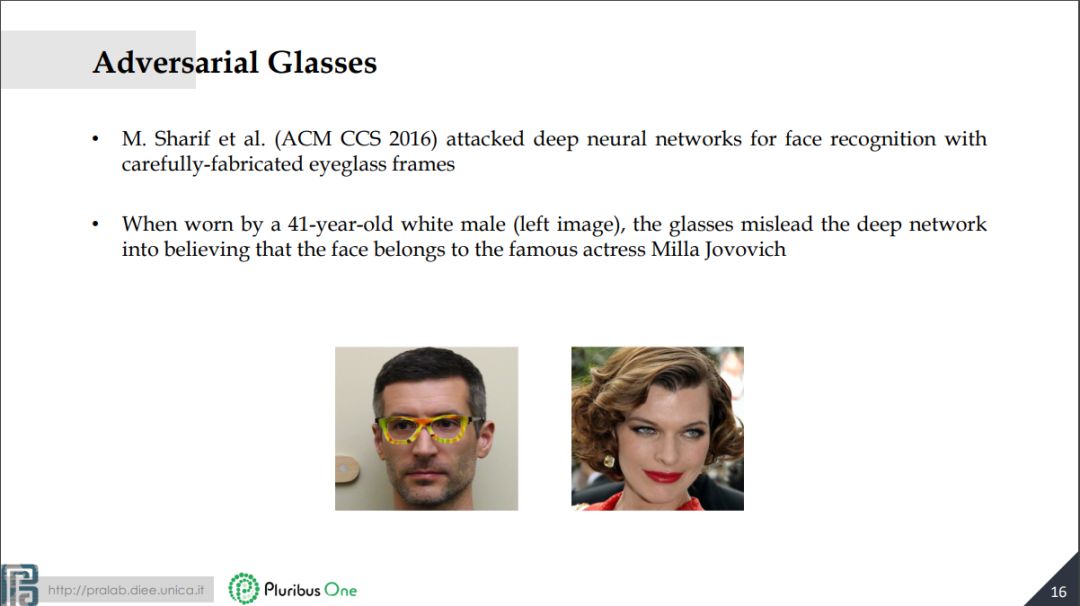

再例如,戴上下面这个精心设计的眼睛,左边的大叔会被深度网络识别为右边的女演员。

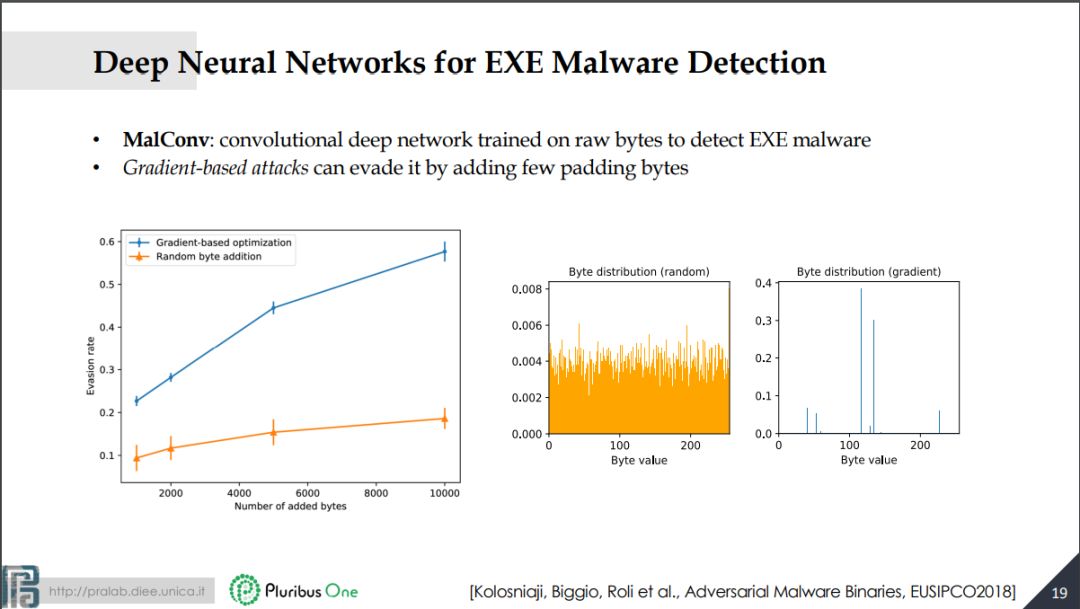

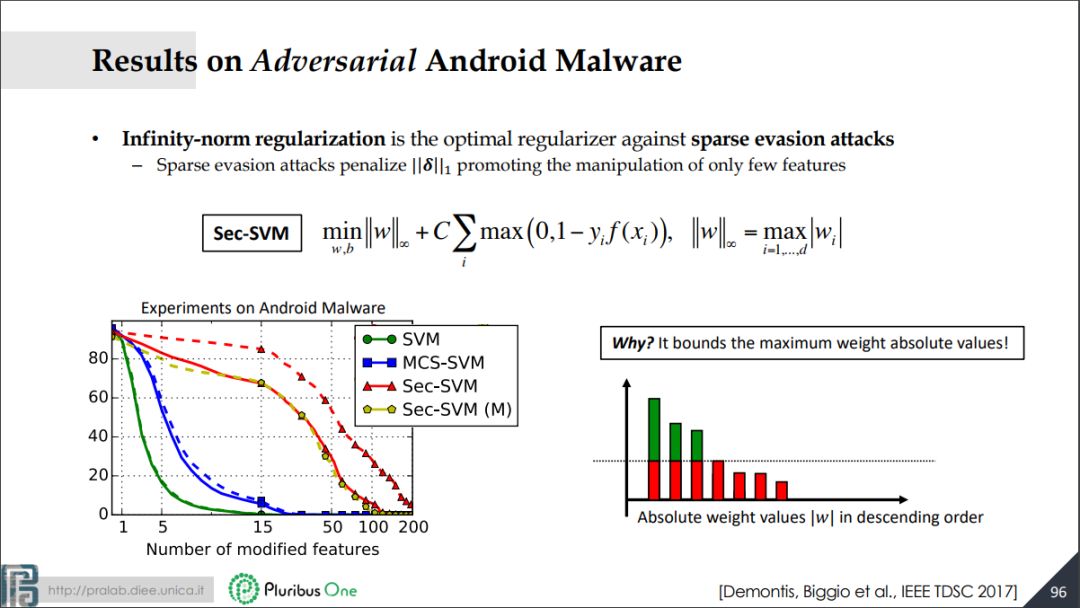

不仅是图像,其他领域的深度网络可以被对抗学习攻击。MalConv可以通过卷及网络基于软件的字节来识别恶意软件,Gradient-based attacks可以通过填补字节的方法来规避攻击。深度学习在给人们带来便利的同时,也带来了安全上的隐患。

参考文献:

https://www.pluribus-one.it/sec-ml/wild-patterns

-END-

专 · 知

人工智能领域26个主题知识资料全集获取与加入专知人工智能服务群: 欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知