理解大规模语言模型(LLMs)中的知识机制对于迈向可信的通用人工智能(AGI)至关重要。本文从一个新的分类法角度回顾了知识机制的分析,包括知识利用和进化。知识利用探讨了记忆、理解与应用及创造的机制。知识进化则关注个体和群体LLMs中知识的动态发展。此外,我们讨论了LLMs所学到的知识、参数化知识脆弱的原因以及潜在的黑暗知识(假设)所带来的挑战。我们希望这项工作能帮助理解LLMs中的知识,并为未来的研究提供见解。

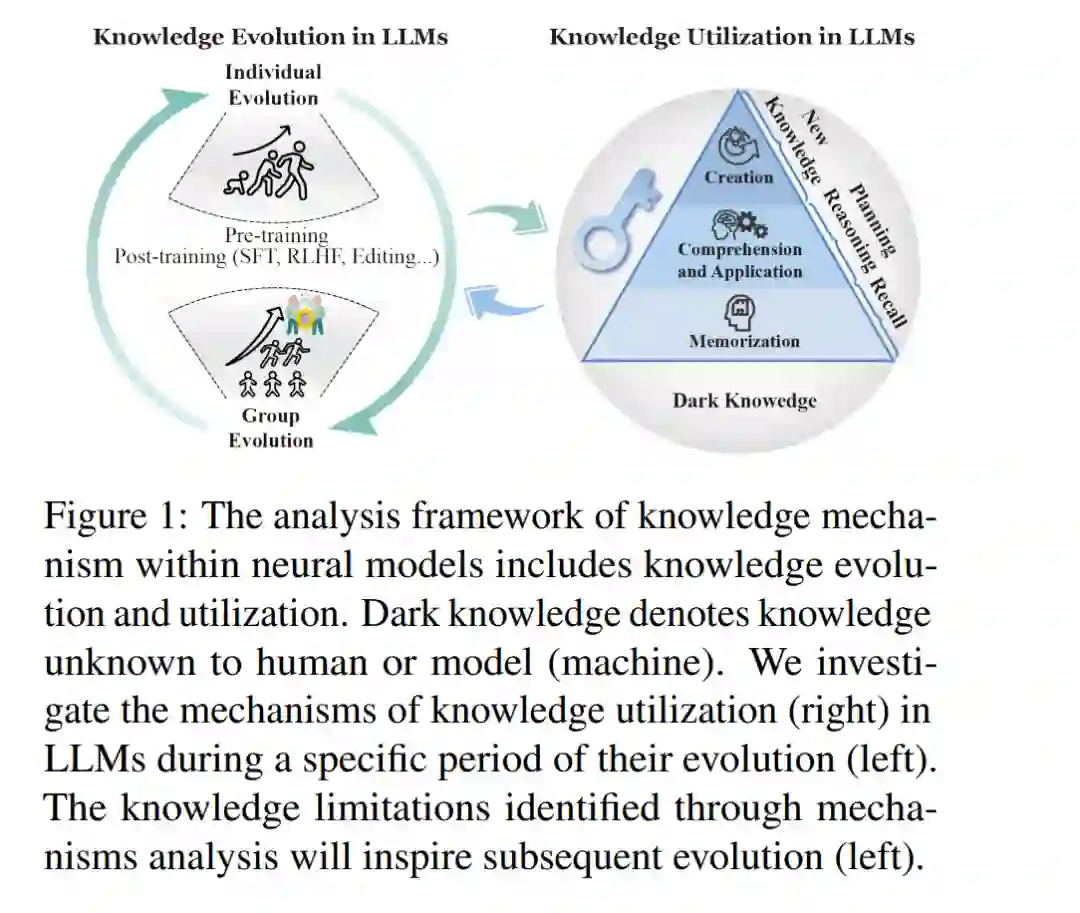

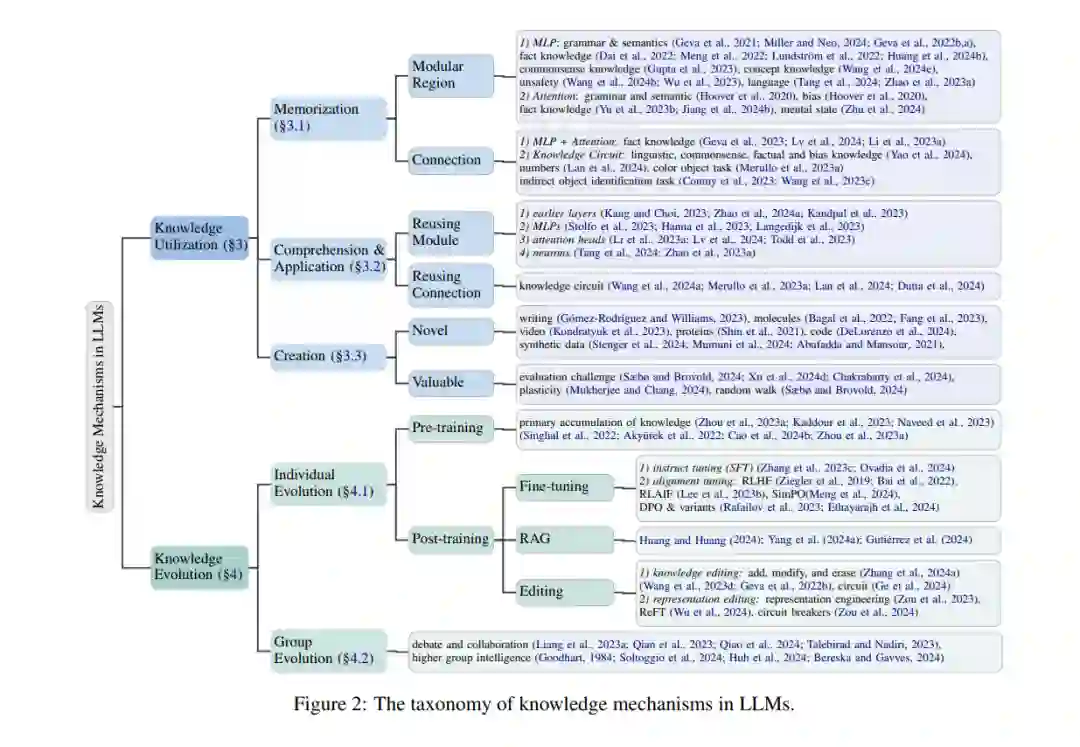

知识是智慧的基石和文明延续的基础,为我们提供了导航复杂问题和应对新兴挑战的基本原则和指导(Davis et al., 1993; Choi, 2022)。在漫长的进化历史中,我们致力于利用已获得的知识和探索未知知识的前沿,以培养更高级的智慧(McGraw and Harbison-Briggs, 1990; Han et al., 2021)。 众所周知,大规模语言模型(LLMs)也因其涵盖了广泛的参数化知识而闻名(Roberts et al., 2020; Sung et al., 2021; Cao et al., 2021; Zhong et al., 2021; Kandpal et al., 2023; Heinzerling and Inui, 2020; Petroni et al., 2019; Qiao et al., 2023; Kritharoula et al., 2023; He et al., 2024a),在应用上取得了前所未有的进展。然而,LLMs在学习、存储、利用和进化方面的知识机制仍然是一个谜(Gould et al., 2023a)。大量研究试图通过知识神经元(Dai et al., 2022; Chen et al., 2024a)和电路(Elhage et al., 2021; Yao et al., 2024; Zou et al., 2024)来揭示LLMs中各种类型的知识,但这些努力分散在各个任务中,尚待全面的回顾和分析。 如图1所示,本文开创性地回顾了整个知识生命周期中的机制。我们还提出了一种新的LLMs知识机制分类法,如图2所示,涵盖了特定时间的知识利用和整个LLMs期间的知识进化。具体来说,我们首先介绍了该领域的基本知识(§2)并从新的角度回顾了知识利用机制(§3)。然后,我们深入探讨了知识进化的基本原则(§4),讨论了知识利用的挑战,并提出了一些有前景的假设来探索开发强大且可信模型的潜在途径(§5)。最后,我们还提供了一些未来方向(§6)和知识机制分析工具(§C)。我们的贡献如下: * 据我们所知,我们是首个回顾LLMs中知识机制并提供整个生命周期内的新分类法的。 * 我们提出了一种新的视角,从记忆、理解与应用及创造三个层次分析知识利用机制。 * 我们讨论了个体和群体LLMs中的知识进化,并分析了这一过程中固有的冲突和整合。 * 我们怀疑普遍的Transformer架构可能阻碍创造力,数据分布和数量可能导致参数化知识的脆弱性,引发幻觉和知识冲突。此外,黑暗知识将长期存在。

与现有综述的比较以往的可解释性综述通常旨在从全局和局部分类法角度研究解释LLMs中不同组件作用的各种方法(Ferrando et al., 2024; Zhao et al., 2024a; Luo and Specia, 2024; Murdoch et al., 2019; Bereska and Gavves, 2024; Vilas et al., 2024; Singh et al., 2024)。相比之下,本文侧重于LLMs中的知识。因此,我们的分类法以LLMs中的目标知识为导向,回顾了知识的获取、存储、利用及后续进化。此外,以前的分类法大多探讨推理阶段(一个特定时期)的可解释性,而忽略了预训练阶段的知识获取和后训练阶段的进化(Räuker et al., 2023; Luo et al., 2024b; Apidianaki, 2023; Jiao et al., 2023; Räuker et al., 2023; Rai et al., 2024)。我们的分类法旨在探索从幼稚到成熟的各个阶段的动态进化,无论是个体还是群体LLMs。 与最相似的综述(Cao et al., 2024a)引入的知识生命周期相比,我们的工作重点是每个阶段的底层机制。总体而言,本文可能有助于我们探索和操作LLMs中的高级知识,通过知识进化的历史检查当前的局限性,并为未来模型的更高效和可信的架构和学习策略提供灵感。请注意,本文中的大多数假设源自基于Transformer的LLMs。我们还验证了这些假设在其他架构模型中的普适性,然后在§B中提出普遍智能。