随着大型语言模型(LLM)发展的日益普及,吸引了大量关注,各种应用领域的模型不断涌现。然而,将大型语言模型与语义技术相结合以进行推理和推断仍然是一项具有挑战性的任务。本文分析了当前在基础LLM方面的进展,如ChatGPT,如何与专用预训练模型,如REBEL,进行比较,以实现实体和关系的联合提取。为了评估这种方法,我们使用与可持续性相关的文本作为案例,进行了多个实验。我们创建了从原始文本自动生成知识图谱的流程,并发现使用先进的LLM模型可以提高从非结构化文本创建这些图谱的过程的准确性。此外,我们还探讨了使用基础LLM模型进行自动本体创建的潜力,从而生成更相关且准确的知识图谱。本节描述了本研究中使用的方法,包括数据收集过程以及用于分析收集到的数据的实体-关系提取算法。

**A. 数据收集过程 **为了对实体-关系提取的两种方法进行实验性比较,我们从网络上收集了有关可持续性主题的新闻数据。为此,我们使用了News API [21]系统。News API是一个HTTP REST API,用于从网络上搜索和检索实时文章。它提供了通过指定以下选项在网络上发布的文章中进行搜索的功能:关键词或短语、发布日期、来源域名和语言。通过使用News API,我们收集了2023-02-15至2023-03-19关于可持续性主题的94篇新闻文章。收集到的文本包含各种字数,从50个到超过4200个不等。由于输入到语言模型中的令牌数量受到限制,因此需要进行额外的预处理步骤来处理包含大量单词的文本。

**B. 关系提取方法 **关系提取是自然语言处理(NLP)中的一项基本任务,旨在识别句子或文档中实体之间的语义关系。这项任务具有挑战性,因为它需要理解实体出现的上下文以及它们之间存在的关系类型。在本小节中,我们将介绍如何利用REBEL和ChatGPT进行关系提取任务。1) REBEL:我们首先尝试使用REBEL从非结构化新闻文章中提取关系。为了让REBEL能够使用提供的文本,需要使用相应的分词器功能对其进行分词。分词是将原始文本分割成称为令牌的较小单位的过程。令牌可以是单词、字符或子词。模型对令牌的限制为512个令牌,这意味着在将较长的收集到的文章发送到模型进行三元组提取之前,需要对其进行预处理。为了解决这个限制,我们将原始文本进行分词,并将令牌划分为256个令牌的批次。这些批次分别由REBEL模型处理,然后合并结果以提取较长文本的关系。还向提取的关系添加元数据,引用生成关系的令牌批次。采用这种方法,由于令牌批次可能在句子的中间开始或结束,某些关系可能无法准确提取。然而,这种情况发生的次数微乎其微。因此,我们将其处理留给未来的工作。实体-关系提取过程完成后,提取的信息存储在三元组结构中。为了进一步规范提取的实体,我们执行实体链接[22]。实体链接是指将原始文本中提到的实体与知识库中相应实体进行识别和关联的过程。实体链接过程不属于REBEL模型的一部分,它是用于优化提取关系的额外后处理步骤。在本研究中,我们使用DBpedia作为知识库,并认为如果两个实体具有相同的DBpedia URL,则它们是相同的。这方法不适用于DBpedia上不存在的实体。

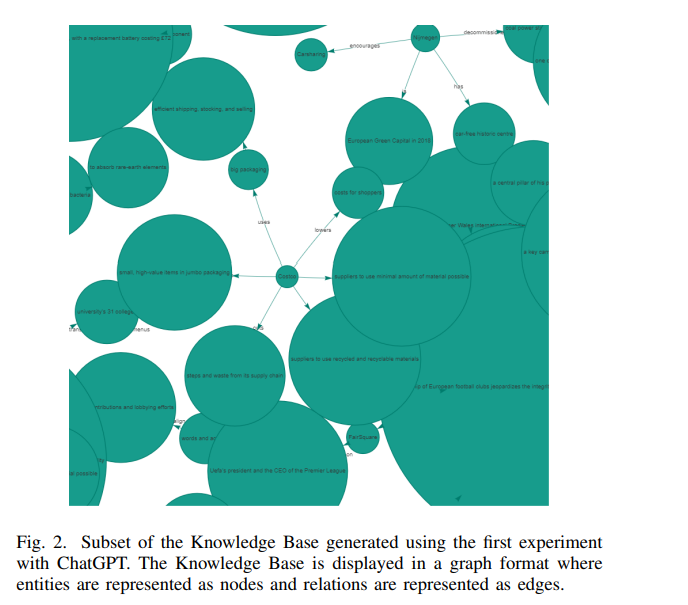

- ChatGPT:本文采用的第二种方法使用了OpenAI的ChatGPT [12]。我们使用ChatGPT创建了两个实验。第一个实验提示ChatGPT从收集到的新闻文章中提取关系。在提取关系之后,我们遵循与REBEL模型相同的步骤,以创建一个全面的知识库。第二个实验侧重于创建一个直接生成整个知识库并编写描述文本中识别到的概念的本体的提示。这种方法的目标是减少为了获得最终知识图谱而需要执行的手动步骤的数量。对于这两个实验,我们将参数“温度”的值设为0,以获得更具确定性的输出,因为OpenAI模型本质上是非确定性的。