这篇综述论文深入探讨了大型语言模型(LLM)的可解释性领域,这是自然语言处理中的一个关键且充满挑战的方面。随着LLM在各种应用中扮演着关键角色,它们的“黑盒”特性引发了关于透明度和道德使用的担忧。本文强调增强LLM可解释性的必要性,旨在解决公众对这些模型的信任问题以及技术社区对深入理解这些模型的需求。我们专注于预训练的基于Transformer的LLM,例如LLaMA(Touvron et al., 2023),它们由于规模和复杂性,呈现出独特的解释挑战。我们的综述归类了现有的解释性方法,并讨论了它们在提高模型透明度和可靠性方面的应用。我们还讨论了代表性的评估方法,强调它们的优势和局限性。这篇综述的目标是在理论理解和实际应用之间架起一座桥梁,为未来LLM可解释性领域的研究和发展提供洞见。

**1 引言 **

在迅速发展的自然语言处理领域,大型语言模型(LLM)已成为一个基石,展现出在各种任务中的卓越能力。尽管它们效果显著,LLM通常被视为“黑盒”系统,这在解释性和透明度方面提出了重大挑战。这种不透明性可能导致意想不到的后果,例如生成有害或误导性内容(Gehman et al., 2020),以及模型幻觉的出现(Weidinger et al., 2021)。这些问题凸显了增强解释性的紧迫性,不仅是为了理解,更是为了负责任和伦理的应用。 在LLM中,解释性具有两个关键功能。对于终端用户,它通过以非技术方式阐明模型的推理过程,增强了对其能力和潜在缺陷的理解,从而培养信任(Zhao et al., 2023)。对于开发者和研究人员,它提供了对意外偏见和改进领域的洞察,作为提升模型在下游任务上性能的工具(Bastings et al., 2022; Meng et al., 2023a; Li et al., 2023b)。然而,LLM的规模为解释性带来了独特的挑战。更大的模型、更多的参数和广泛的训练数据使得解释变得更加困难。传统的解释方法,如SHAP值(Lundberg and Lee, 2017),对于这些大规模模型变得不太实用(Zhao et al., 2023)。此外,全面理解LLM特有现象,包括在上下文中的学习(Halawi et al., 2023; Hendel et al., 2023; Todd et al., 2023; Wang et al., 2023),以及解决模型幻觉(Ji et al., 2023; Chuang et al., 2023)和固有偏见(dev, 2023; An and Rudinger, 2023; Schick et al., 2021)等问题,对于模型设计的持续改进至关重要。 在这篇文献综述中,我们关注预训练的基于Transformer的LLM的解释性方法,这些模型通常被称为基础模型。这些模型通常在训练数据上进行扩展,并拥有数十亿个参数,例如GPT-2(Radford et al., 2019)、GPT-J(Chen et al., 2021)、GPT-3(Brown et al., 2020)、OPT(Yordanov et al., 2022)和LLaMA系列(Touvron et al., 2023)。在第2节中,我们根据文献综述对研究问题进行分类。基于这种分类,在第3节中,我们回顾了解释性方法,随后在第4节中讨论了如何利用这些洞察。我们进一步在第5节中讨论评估方法和指标。我们的目标是综合并批判性地评估当代研究,旨在弥合理论理解与从复杂语言模型中提取的洞见的实际应用之间的差距。

2 概述

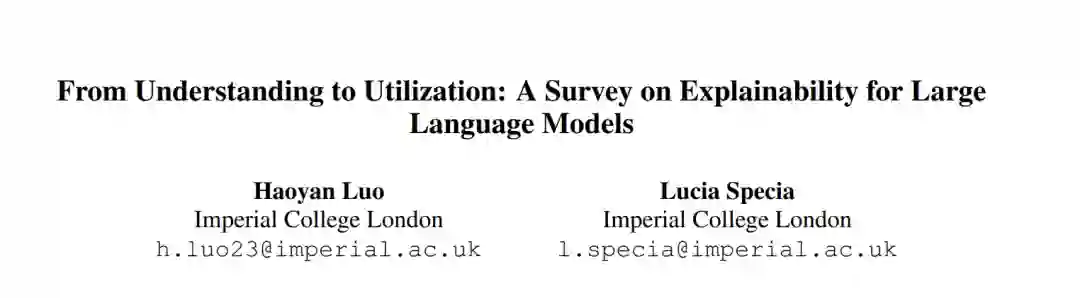

大型语言模型(LLM)领域正在迅速发展,使得解释性不仅成为理解这些复杂系统的工具,而且对它们的改进至关重要。本节对当前的解释性方法进行分类,强调在伦理和可控生成方面的挑战,并提出未来探索的研究问题。 方法分类 我们在图1中呈现了对解释性方法及其应用的结构化分类。图1展示了对预训练语言模型(LM)解释性方法的结构化分类。我们将这些方法分为两大领域:局部分析和全局分析。局部分析涵盖了特征归因和Transformer块分析,深入探讨模型的详细操作。另一方面,全局分析包括基于探针的方法和机制性解释性,提供对模型行为和能力的全面理解。除了理解之外,我们还探索这些洞察在增强LLM能力方面的应用,重点关注模型编辑、能力增强和受控生成。

3 大型语言模型的解释性

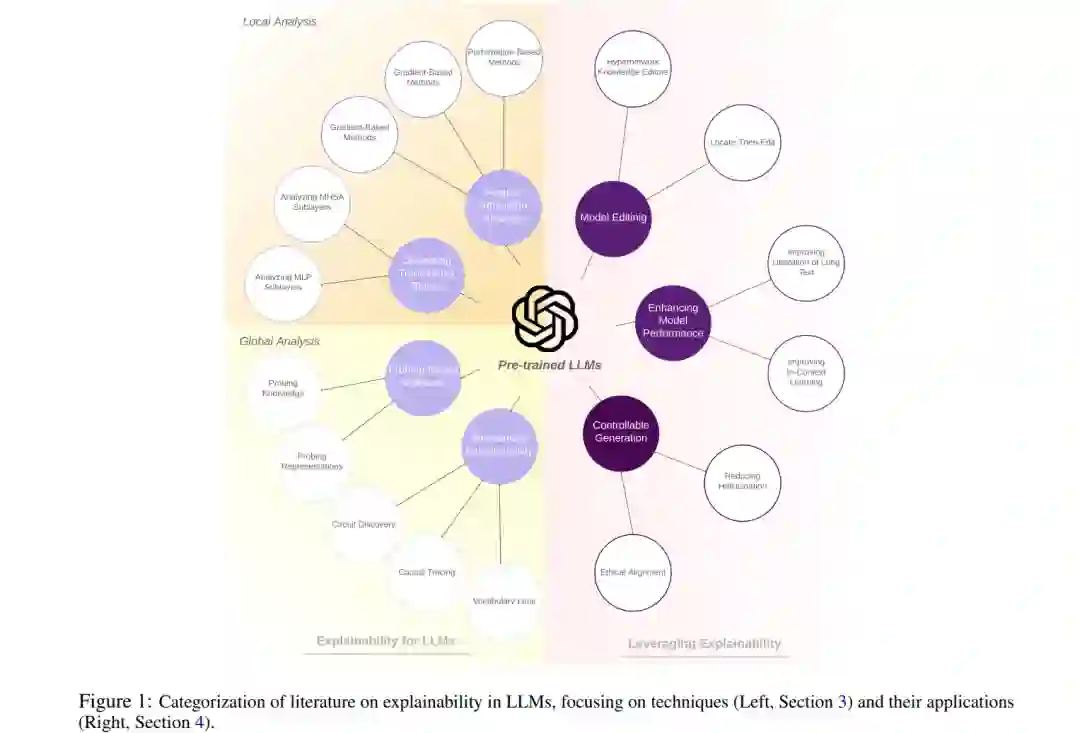

3.1 局部分析 LLM中的局部解释旨在阐明模型如何为特定输入生成特定预测,例如情感分类或令牌预测。本节将局部解释方法分为两类:特征归因分析和对单个Transformer(Vaswani et al., 2017)组件的分析。

3.2 全局分析 与侧重于阐明单个模型预测的局部分析不同,全局分析旨在理解和解释模型隐藏状态激活中编码的知识或语言属性。本节探讨全局分析的两种主要方法:审视模型表示的探针方法和机制性解释性(Transformer Circuits, 2022),这是一种新兴的观点,旨在逆向工程深度神经网络的内部工作机制。

4 利用解释性

在本节中,我们讨论如何将解释性作为一个工具来调试和改进模型。虽然各种方法旨在通过微调或重新训练来提高模型的能力,但我们专注于那些特别基于模型解释性的强大基础设计的方法。

4.1 模型编辑

尽管我们能够训练出熟练的大型语言模型(LLM),但确保它们的相关性和纠正错误的方法仍然难以捉摸。近年来,编辑LLM的技术出现了激增。其目标是在不对其他输入的性能产生负面影响的情况下,高效地修改LLM在特定领域内的知识或行为(Yao et al., 2023)。

4.2 增强模型能力

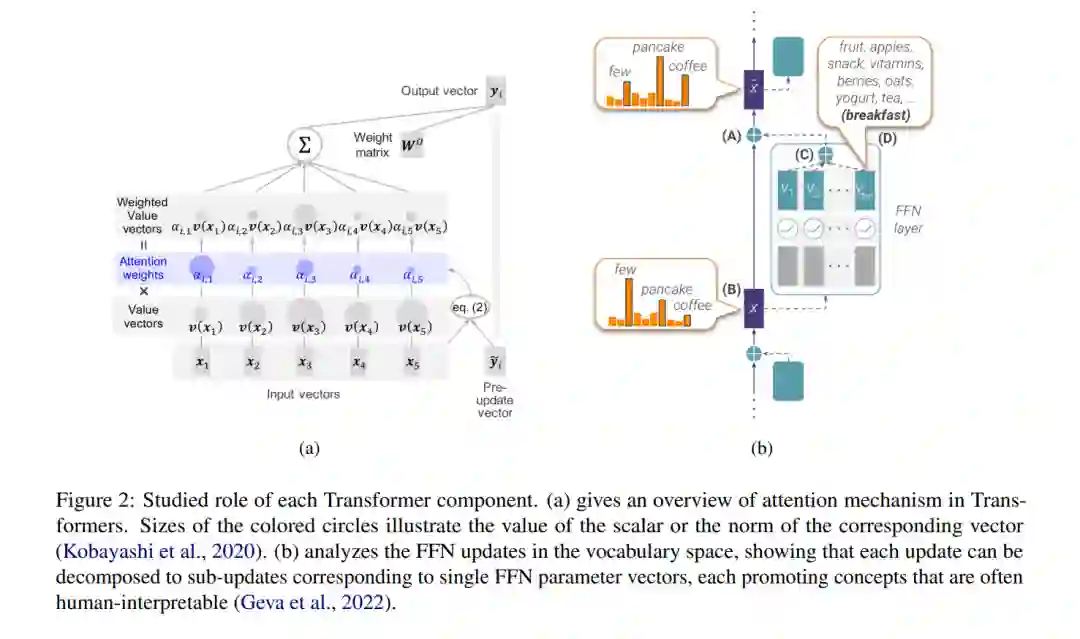

虽然大型语言模型(LLM)在各种自然语言处理任务中表现出多样性,但来自解释性的洞察可以显著增强这些能力。本节重点介绍了解释性在最近的工作中显示出显著影响的两个关键任务:改进长文本的利用(Xiao et al., 2023; Liu et al., 2023; Pope et al., 2022)和增强上下文中学习(In-Context Learning, ICL)的性能(Hendel et al., 2023; Halawi et al., 2023; Wang et al., 2023)。

4.3 可控生成

尽管大型语言模型在文本生成方面取得了卓越的表现,但有时它们在生成事实内容方面表现不佳。利用解释性为构建推理时快速技术提供了机会,这些技术旨在提高生成模型的事实性、校准性和可控性,使其更符合人类偏好。

5 评估

近期,像GPT-4(OpenAI, 2023)这样的大型语言模型展现了生成其预测的自然语言解释的令人印象深刻的能力。然而,这些解释是否真正帮助人类理解模型的推理过程,目前尚不明确(Zhao et al., 2023)。为了更好地评估解释性方法(如归因)的性能,需要专门设计的评估方法。此外,还需要校准的数据集和指标来评估解释性在下游任务中的应用,例如真实性评估。 5.1 评估解释的合理性 评估归因解释合理性的一种常见技术是移除K%估计重要性最高或最低的令牌,以观察其对模型输出的影响(Chen et al., 2020; Modarressi et al., 2023)。另一种评估解释合理性的方法涉及间接方法,例如衡量模型编辑的性能,尤其是对于严重依赖解释准确性的“定位-然后编辑”编辑方法。近期研究(Yao et al., 2023; Zhao et al., 2023)表明,拥有评估数据集对于评估LLM中的事实编辑至关重要。此目的常用的两个数据集是ZsRE(Levy et al., 2017),一个通过反向翻译生成问题改写的问答(QA)数据集,以及CounterFact(Meng et al., 2023a),一个更具挑战性的数据集,包含了与正确事实相比起始得分较低的反事实。 5.2 评估真实性 模型真实性是衡量生成模型可信度的重要指标。我们期望模型输出既有信息量又事实正确且忠实。理想情况下,人类评注员会根据标准答案标记模型答案为真或假,但这通常成本较高。(Lin et al., 2022)提出使用两个微调过的GPT-3-13B模型(GPT-judge)对每个答案进行真实或假的及有信息量或无信息量的分类。使用GPT-judge进行评估是TruthfulQA基准测试的标准做法,这是一个广泛使用的数据集,对抗性构建以衡量语言模型在生成答案时的真实性(Askell et al., 2021; Li et al., 2023b; Chuang et al., 2023)。TruthfulQA的主要指标是真实*信息量,真实和信息量得分的乘积。这个指标不仅捕捉了有多少问题被真实地回答,还通过评估每个答案的信息量,防止模型无差别地回复“我无可奉告”。

6 结论

在本文中,我们提供了关于LLM的可解释性及其应用的全面概述。我们总结了基于解释目标的局部和全局分析方法。此外,我们讨论了利用解释来增强模型和评估这些方法的使用。理解LLM的主要未来研究方向包括开发针对不同语言模型的解释方法,以及通过利用解释性知识使LLM更值得信赖且与人类价值观更一致。随着LLM的不断进步,可解释性将变得极其重要,以确保这些模型是透明的、公平的和有益的。我们希望这篇文献综述为这一新兴研究领域提供了有用的概述,并突出了未来研究的开放问题和方向。