得益于大型语言模型的突破性进展,一种新型软件智能体——人工智能(AI)智能体——已进入市场。OpenAI、谷歌、微软、Salesforce等科技巨头宣称,其AI智能体将突破被动文本生成功能,转向任务执行领域。AI智能体不再局限于生成旅行计划,而是直接完成行程预订全流程;不再仅创作社交媒体文案或图像,而是自主完成跨平台内容发布。AI智能体的潜在威力引发法学界担忧:这类技术可能催生非法商业行为、人类操控、诽谤泛滥与知识产权侵害。学者们疾呼在AI智能体引发社会混乱前建立监管框架。

本文直面AI智能体引发的核心关切。研究揭示,软件间交互的核心机制天然具备约束AI智能体行为的特性,其防范异常操作的有效性可能超越传统人类智能体监管规则。同时,本文提出通过计算机科学领域的"价值观对齐"方法论,增强用户预防与修正AI智能体操作的能力。该路径不仅能优化用户与AI智能体的交互规范契合度,更助力实现预期经济收益并降低风险感知。本文同时论证,无论AI智能体如何拟人化,都不应且不能被赋予法律主体资格。简言之,人类始终是AI智能体行为的责任主体,本文为此提供了构建可信赖AI智能体的实施指南。

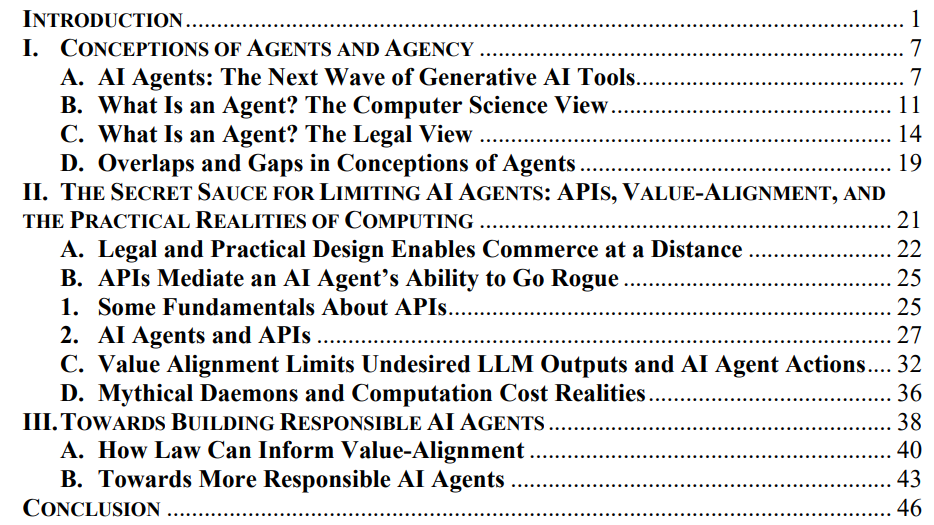

文章结构概述

第一部分阐述AI智能体的核心定义、行动范畴及新兴市场格局。通过比较法学与计算机科学领域对"智能体"概念的异同,本文为AI与法律交叉研究贡献新视角。研究表明,尽管两学科共享术语体系与理论关切,但其本质差异意味着传统代理法无法直接套用于AI智能体治理。

第二部分揭示当前对智能体异常商业行为的担忧存在认知盲区。现有电子商务体系已建立远程交易验证机制与机器人行为管控方案,支撑着美国万亿美元规模的在线零售市场——这些机制同样适用于规范AI智能体在该领域的应用。

第三部分整合法学与计算机科学的研究成果,提出构建"负责任AI智能体"的实现路径。文章最终形成系统性结论,为智能体技术的合规发展提供理论框架与实践指引。